简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

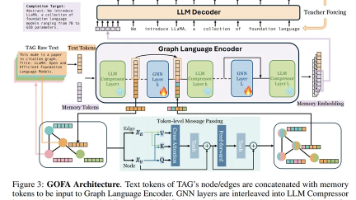

回顾这些图学习与大模型结合的多种探索,LLM-BP 代表了Enhancer 范式的简洁追求,证明了只要特征足够好,经典的启发依然能打败复杂的微调。GOFA 则代表了Predictor 范式的宏大理想,它用“三明治架构”将 GNN 与 LLM 深度融合,实现了“One-For-All”的零样本推理。而 CROSS 则提醒我们时间维度的重要性,在动态图中,只有捕捉到“语义漂移”,才能避免刻舟求剑。将这

作者发现Agent利用复杂推理策略(如Tree of Thought(ToT), Fleet of Agent(FoA))进行推理时,会产生大量冗余Prompt,且目前的缓存策略(如KV Cache)多在底层优化,难以支持在线API,且而现有的客户端缓存往往缺乏统计完整性和复现性,无法处理需要多个独立响应的随机采样场景。TiME的核心思路是利用MiniLMv2的蒸馏框架,将大型、强大的教师模型(X

本次分享讨论了大模型多智能体系统的故障归因工作,介绍了故障模式与故障定位方法。对这类任务,笔者具有如下改进思路:在数据集层面,可以尝试向更复杂的步骤(例如生成大段代码)以及更困难、专业的场景(如医学、数据库领域)方向进行数据收集与构建,以研究多智能体系统在更具挑战性任务上的错误模式。同时,可以在具身 VLA 等场景(开放的动作空间、更困难的步骤监督)开展研究。在方法层面,需要研究归因模型的鲁棒性与

大型语言模型(LLM)如GPT系列,凭借其在文本理解、问答系统和内容生成等广泛任务中的卓越表现,令自然语言处理社区为之惊叹。尽管成效显著,但这类模型常因处理知识密集型任务能力有限而备受诟病,特别是在面对需要领域专业知识的问题时。将LLM应用于专业领域仍面临三大根本挑战:知识局限性、推理复杂度和上下文敏感性。为了让LLM适应特定或私有领域,早期策略主要通过使用专业数据集对模型进行微调。这种方法通过在

时至今日,随着突飞猛进的人工智能相关技术在智能助手、自然科学研究和音视频生成等领域得到应用,我们正见证着一次人工智能技术的浪潮。作为数据库领域的研究者,我们不禁要思考,AI应用给数据系统提出了什么样的要求?数据系统的设计和开发者应该作出哪些改变来适应这些要求?本文从AI应用的数据管理需求和数据系统可能的发展方向出发,总结近期论文中提出的观点,尝试回答上述两个问题。

这篇文章通过提出了一种注意力机制对齐的方法,为预训练语言模型在 fine-tuning阶段引入了多源分词信息外部知识,从而提升了预训练语言模型在各个子任务上的效果。本文收录于 2020 年 ACL。问题背景BERT 出现后,预训练语言模型统治了大多数的NLP应用任务,预训练-微调这一2-stage 模式成为了主流。随着预训练语言模型的不断发展,预训练任务和模型结构被不断改进,以让模型适配更大量的数

本次分享讨论了奖励模型的偏好收集思路,并分别介绍了来自人类的偏好收集与来自AI/规则的偏好收集。最后,本节将对以下的开放性问题进行简单讨论:(1)AI 偏好能取代人类偏好吗?随着AI模型能力不断提升,AI 偏好数据的比例会逐渐变大,可以补充与增强人类偏好,但难以完全取代人类偏好。AI 模型难以涵盖伦理、情感等维度,并且在多样性方面不如人类偏好,只能提供通用而普遍的判断。此外,采用 AI 偏好数据迭

北京大学 葛钤编者按:原文《Realtime Top-k Personalized Pagerank over Large Graphs on GPUs》介绍了一篇在GPU对大规模图上进行个性化pagerank计算的论文。本篇论文的主要结构是先介绍了问题定义和已有的基于CPU的算法,并在此基础上完成了在GPU上的优化和改进。主要包括:提出了在GPU上更适合的数据存储结构。进行了适应性的前向随机游走

我们首先介绍图的同构问题。给定两个图GVGEGHVHEHGVGEGHVHEH,如果存在一个映射πVG→VHπVG→VHst∈EG⟺πsπt∈EHst∈EG⟺πsπt))∈EH那么GHG,HGH就是同构的,记作G≃HG\simeq HG≃H,且称π\piπ是图GGG和HHH的一个同构。

图的最大独立集问题(MIS problem)是图论研究中的一个重要问题,具有广泛的应用。本文介绍了最大独立集求解相关的三篇工作,包括一篇启发式方法和两篇基于学习的方法,希望能让大家对这个问题有所了解。问题定义一个图G(V, E)的顶点集子集I称为图G的一个独立集(independent set)是指:I中任意两点没有边相连。图G中大小最大的独立集(拥有顶点数目最多)称为图G的最大独立集(maxim