简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

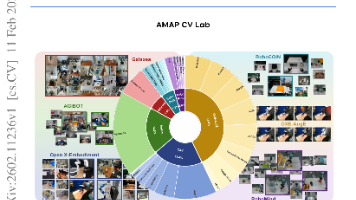

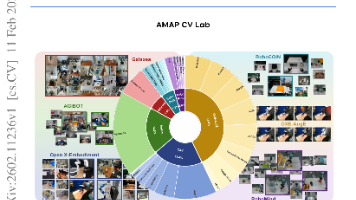

如何在不依赖私有数据和定制硬件的前提下,构建能跨多种机器人形态与任务泛化的能力统一的具身智能基础模型?论文提出ABot-M0框架,通过系统性数据整合(UniACT-dataset)、动作流形学习(AML)与双流感知架构,首次实现开源数据驱动的高性能、硬件无关具身操作模型。

如何在不依赖私有数据和定制硬件的前提下,构建能跨多种机器人形态与任务泛化的能力统一的具身智能基础模型?论文提出ABot-M0框架,通过系统性数据整合(UniACT-dataset)、动作流形学习(AML)与双流感知架构,首次实现开源数据驱动的高性能、硬件无关具身操作模型。

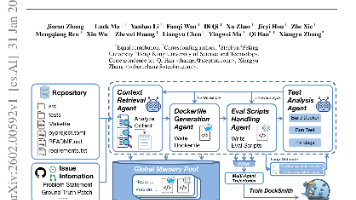

如何突破Docker环境构建这一长期制约软件工程智能体规模化训练与评估的可靠性瓶颈?论文提出DOCKSMITH——首个将环境构建显式建模为长程、可验证、执行驱动型智能体任务的专用模型,证明其不仅是预处理步骤,更是具备强迁移能力的核心智能体能力。

如何统一解决文本密集型(如文档)和视觉密集型(如图表、网页、公式)两类OCR任务,而非依赖割裂的专用模型?论文提出OCRVerse,首个在端到端视觉语言模型框架下实现文本中心与视觉中心OCR能力统一的一体化OCR方法。

如何在不混淆检索与推理能力的前提下,准确评估大模型对全新科学知识的证据驱动推理能力?论文提出DeR2基准,首次通过四阶段受控输入实现检索与推理能力的可解释性解耦,并配套双阶段验证与冻结文档库保障可控性与可复现性。

如何通过开放、可复现的数据中心化方法缩小开源多模态大模型在复杂视觉推理能力上与闭源模型的差距?论文提出MMFineReason——首个基于强教师模型蒸馏、覆盖STEM/谜题/图表等难域、含1.8M样本与5.1B推理token的高质量开源多模态推理数据集,并验证其可显著提升小参数模型的推理性能与泛化能力。

如何让语音大模型不仅准确识别情绪,还能像人类一样基于声学线索进行可解释的因果推理?论文将语音情感识别重构为深度推理任务,提出EmotionThinker框架,通过音律增强、链式思考数据集和新型信任感知强化学习(GRPO-PTR),同步提升情绪识别准确率与解释质量。

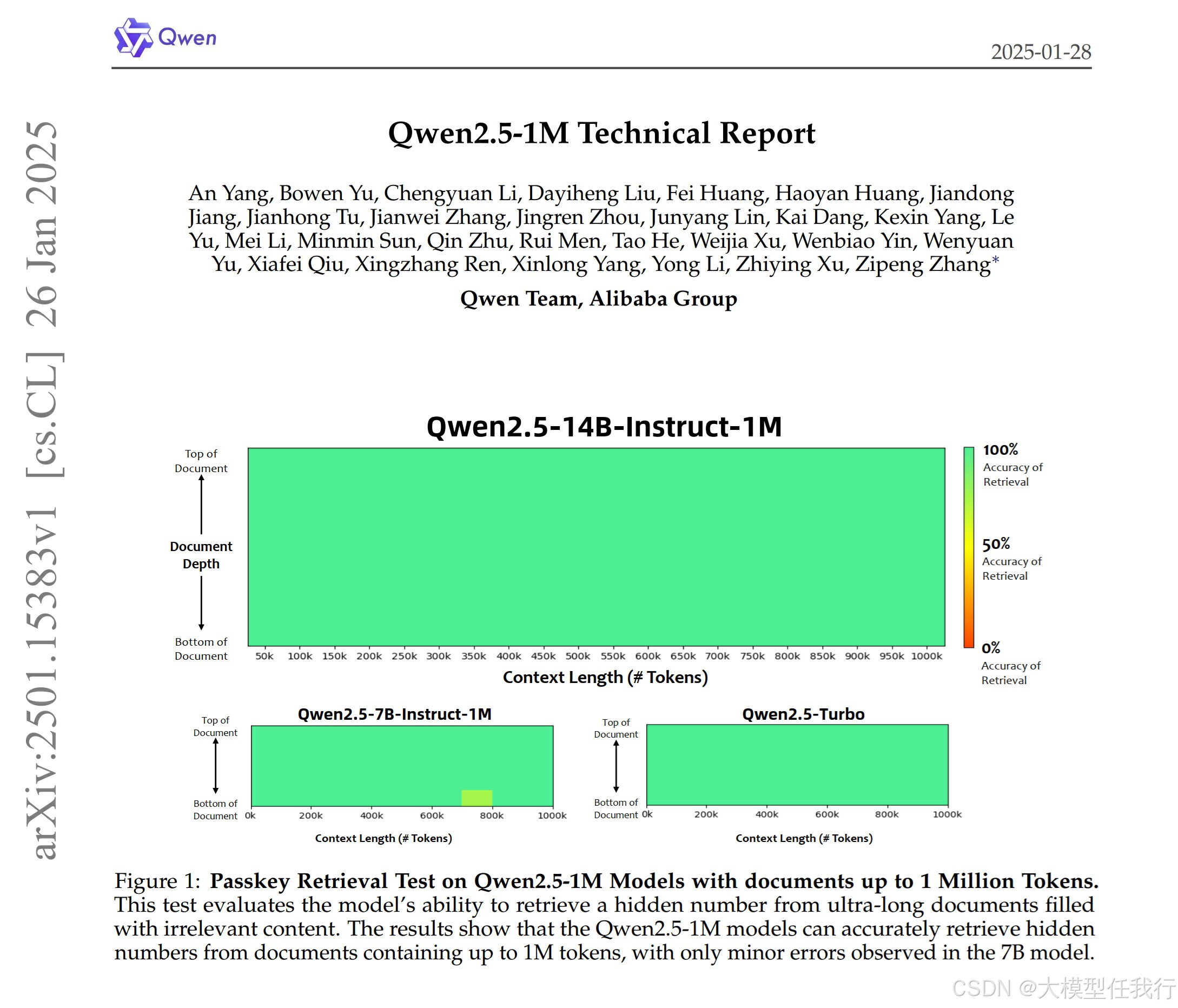

大语言模型(LLM)在处理长上下文任务时的能力受限,无法有效执行需要大量信息处理的复杂任务。论文提出了一种新型的长上下文处理模型Qwen2.5-1M,并通过优化训练策略和推理方法,显著提高了模型在长上下文任务中的表现。

如何在不牺牲下游任务性能的情况下,有效恢复经过监督微调后大语言模型(LLM)失去的诚实性?论文提出了一种目标明确、参数高效的框架(Honesty-Critical Neurons Restoration,HCNR),该框架通过恢复关键信号的神经元来恢复LLMs的诚实性,同时保持其在下游任务中的表现。

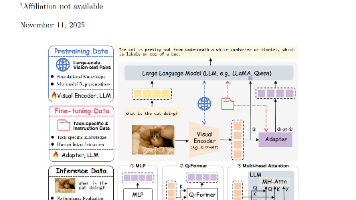

如何确保大型视觉-语言模型(LVLM)中使用的数据满足高质量标准,以提升其性能和可靠性?论文提出了一个名为“arc框架”的系统性分类法,帮助识别和解决LVLM数据质量问题,并概述了管理数据质量的多种技术和未来研究方向。