简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

对于动态场景来说,从一组不同曝光的图像中生成高动态范围(HDR)图像是一个具有挑战性的过程。这个问题可以分为两个阶段:1)对齐输入的LDR图像,2)合并对齐的图像到HDR图像。方法主要分为两类:一种直接基于LDR对齐融合,一种是先通过相机响应函数线性化这些输入图像(一般就是一个单调的非线性函数),将LDR图像转为HDR域,然后在HDR域进行融合得到HDR图像。另外一种是直接基于LDR(...

1. 介绍本文介绍一个大规模的人脸识别数据集:WebFace260M,由 4M identities(身份)和 260M 人脸组成,为百万级深度人脸清洗和识别提供了很好的资源,如图1和Tab.1所示。又通过提纯,即所设计的可扩展高效的自训练 pipeline 对 WebFace260M 进行自动提纯,获得最大的训练集 WebFace42M,它在具有挑战性的 IJB-C 上得到新的SOTA,在 NI

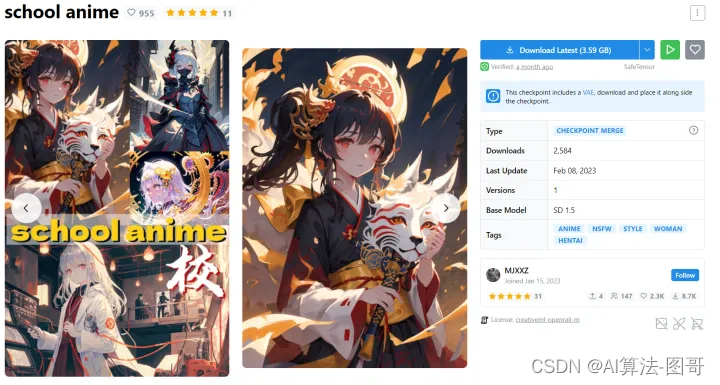

stable diffusion lora模型训练

本文从五个需要进行标注的计算机视觉任务(物体检测、线/边缘检测、分割、姿态预测、图像分类)给大家介绍图像标注的种类,应用场景,以及各种标注的优缺点。1. 介绍每个数据科学任务都需要数据。具体地说,是输入系统的干净易懂的数据。说到图像,计算机需要看到人类眼睛看到的东西。例如,人类有识别和分类物体的能力。同样,我们可以使用计算机视觉来解释它接收到的视觉数据。这就是图像标注的作用。图像标注在计算机视觉中

1. 安装NVIDIA GPU显卡驱动如果需要安装cuda版本的PyTorch,电脑也有独立显卡的时候,一般需要更新一下Ubuntu独立显卡驱动。否则即使安装了cuda版本的PyTorch也没办法使用GPU。因为我的笔记本电脑显卡是NVIDIA的,所以首先去官网:NVIDIA显卡驱动下载,查看适合自己显卡的驱动,下载runfile文件:NVIDIA-Linux-x86_64-384.98.r...

1. 概述使用pytorch建立的模型,有时想把pytorch建立好的模型装换为keras,本人使用TensorFlow作为keras的backend2. 依赖依赖的标准库:pytorchkerastensorflowpytorch2keras3. 安装方式conda install tensorflow-gpukerasconda install pytorch t...

写论文的时候需要画神经网络的结构图,用PPT和VISIO之类的工具画效率会比较低。本文将介绍2种基于网页的神经网络画图工具,让结构图更加酷炫。1. NN-SVG这个工具可以非常方便的画出各种类型的图,是一位来自于麻省理工学院弗兰克尔生物工程实验室的人开发的, 该实验室开发可视化和机器学习工具用于分析生物数据。github地址:https://github.com/zfrenchee画图...

1. 摘要老照片修复中面临着许多的图像处理问题,比如填孔洞、去划痕、上色、去噪等,也就是说包含了多种图像退化问题。而使用深度学习进行训练时往往需要制造样本对,但是真实的低质量数据包含多种退化问题,想要通过正常图像模拟出完全符合数据分布的低质量图像几乎是不可能的。(同样的问题在Deblur、SR、Denoise等Low level问题中也有遇到)为了回避样本制造的问题,本文将老照片修复模拟成三域转换

参考:Data Augmentation | How to use Deep Learning when you have Limited Data—Part 2文章目录1. 数据增广(Data Augmentation)2. 数据增广方法2.1 镜像(Flip)2.2 旋转(Rotation)2.3 缩放(Scale)2.4 裁剪(Crop)2.5 平移(Translation)2.6 高斯..