简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

说明:本文已经在 OpenShift 4.18 + OpenShift AI 2.19 的环境中验证。

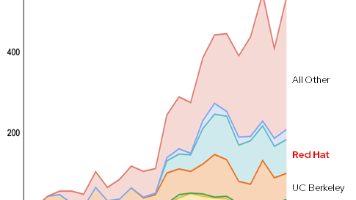

vLLM (Virtual Large Language Model)是一款专为大语言模型推理加速而设计的框架。它是由加州大学伯克利分校 (UC Berkeley) 的研究团队于 2023 年开源的项目,目前 UC Berkeley 和 RedHat 分别是 vLLM 开源社区的两大主要代码贡献方。

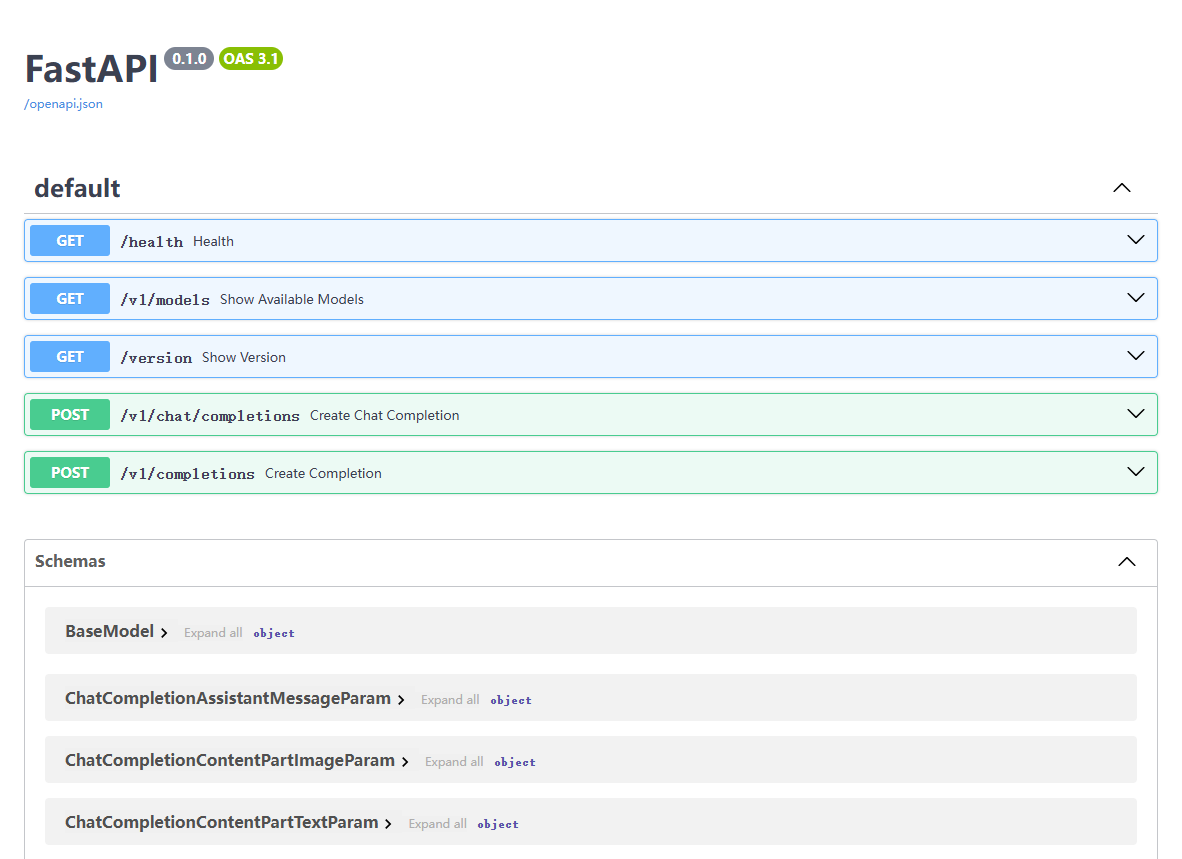

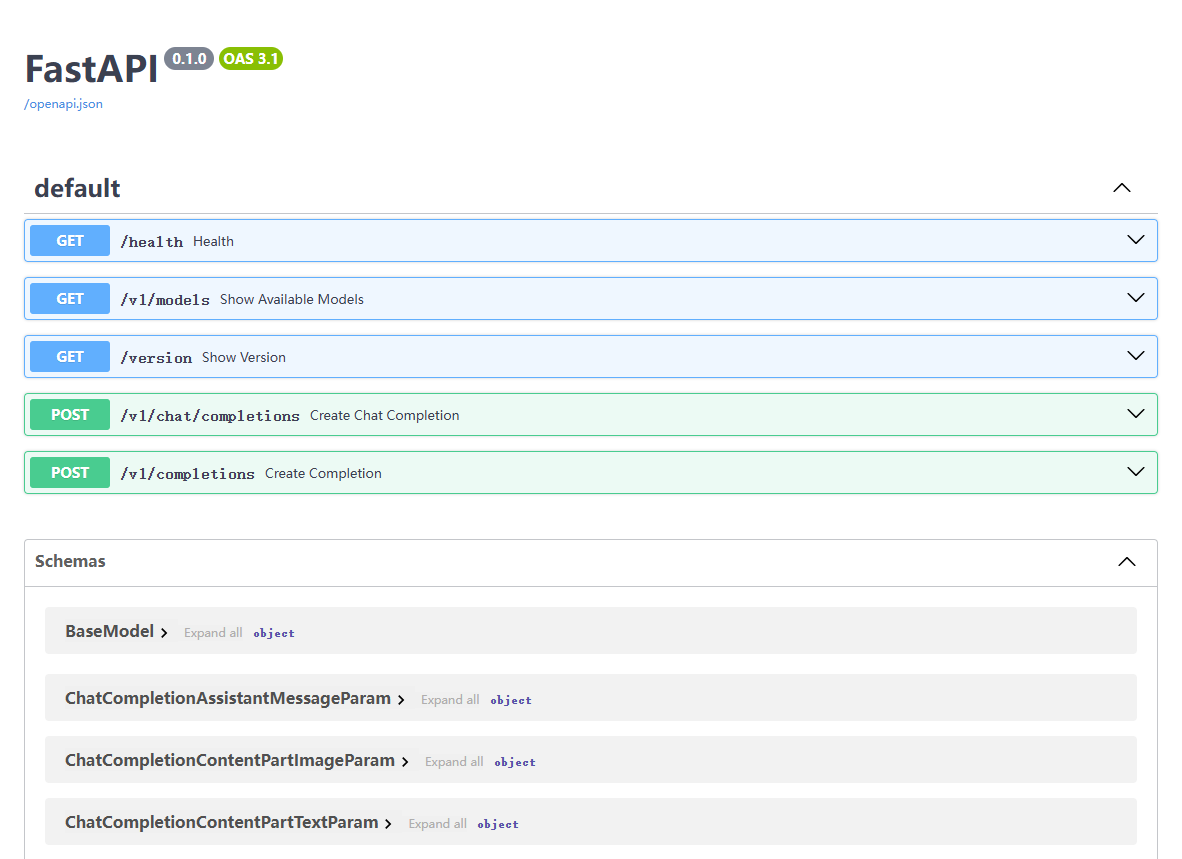

【代码】红帽 AI 推理服务(vLLM)- 运行本地的模型。

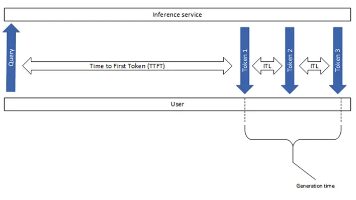

本文介绍了评估LLM模型性能的关键指标和测试方法。主要指标包括每秒请求数(RPS)、请求延迟、首次令牌生成时间(TTFT)、令牌间延迟(ITL)和每秒输出令牌数(TPOT)。文章详细说明了如何使用vLLM工具进行性能测试,包括下载Git仓库、安装依赖库和运行基准测试脚本,并展示了测试结果示例,包含吞吐量、延迟等多个维度的性能数据。这些指标和方法对于评估LLM推理服务的实际表现具有重要意义。

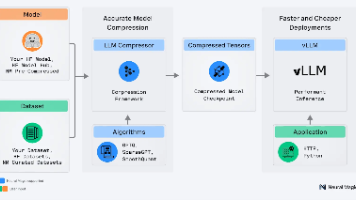

例如,提高模型的准确性通常需要更多的参数,这会导致模型变大,并可能使推理速度变慢。根据前面的测试结果可以看到模型优化前后准确性得分分别为 0.6687 和 0.6801,优化后准确性为原始模型的 101.7%。GSM8K 是一个包含超过 8000 个问题及答案的数据集,这些问题是来自小学数学范畴的题目,旨在测试模型解答需要多步推理的基本数学问题的能力。LLM Compressor 是 vLLM 项

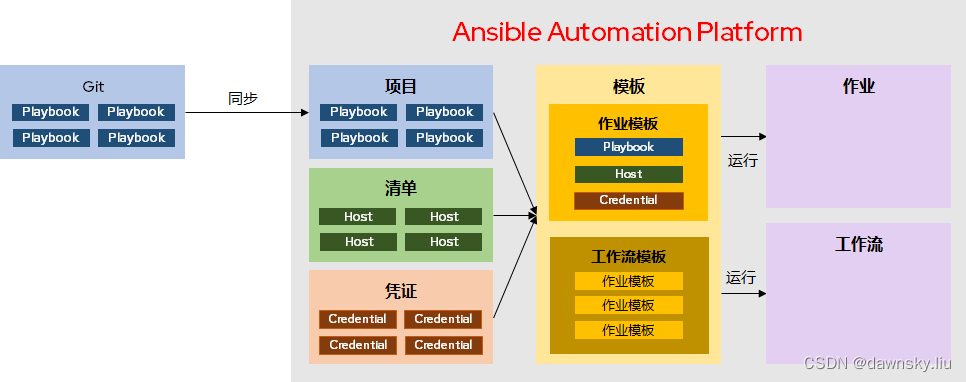

在前一篇 《[Ansible Automation Platform - 功能构成](https://blog.csdn.net/weixin_43902588/article/details/127829720)》一文中介绍了 Ansible Automation Controller (自动化控制台)就是以前的 Ansible Tower,它提供了集中的自动化运维管理和运行平台。

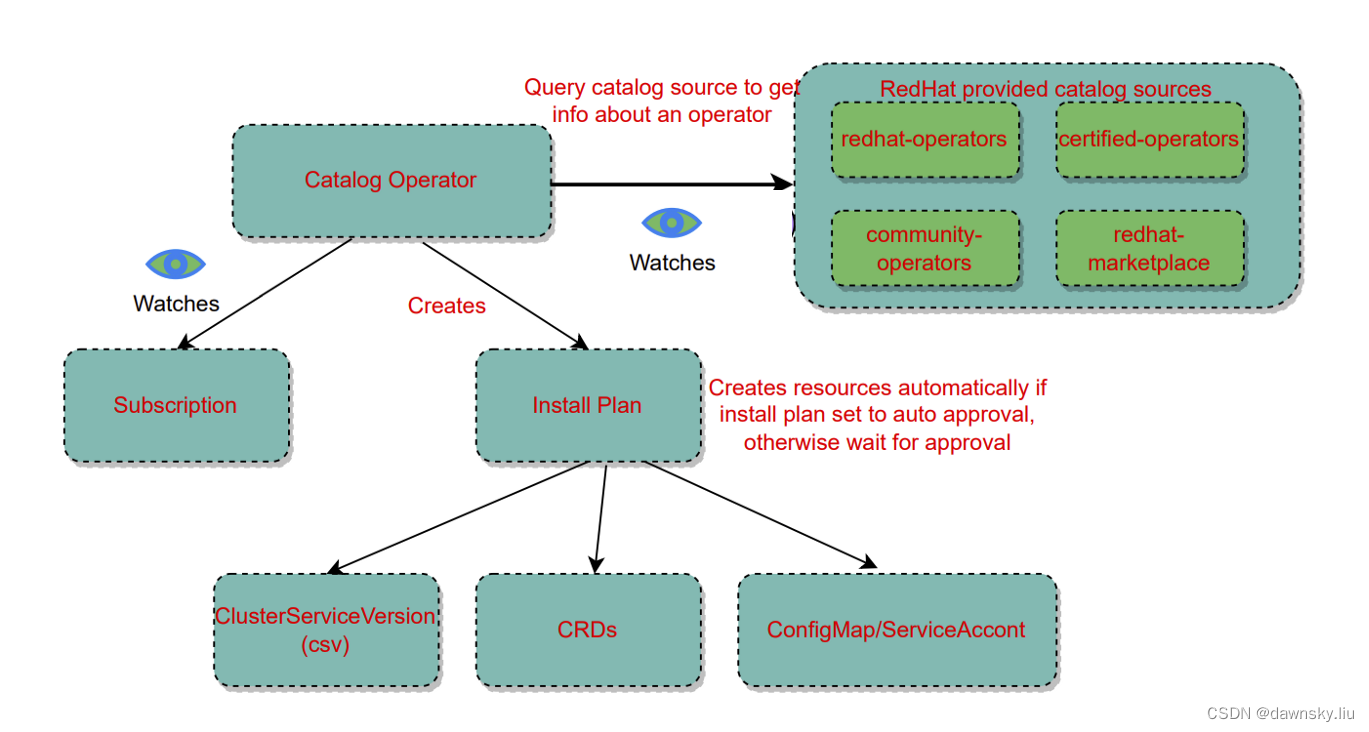

Operator 是 RedHat 收购的 CoreOS 公司最早发起的一项有助于 Kubernetes 运维的技术框架体系。它可以将一套复杂系统环境(例如:主备或 HA 数据库、包含多个微服务+数据库的应用环境)所涉及到的所有资源、配置、最佳实践整体打包,并基于 CRD 提供对相关资源提供针对性运维管理操作(创建、备份、恢复、自愈等),从而帮助 Kubernetes 运维管理员简化对这些系统的运

OpenShift Local 就是以前的红帽的 Codeready Container - CRC,它以 VM 的方式提供一个单机版的 OpenShift 运行环境。从 OpenShift 4.10 开始,CRC 名称正式改为 Red Hat OpenShift Local。

说明:本文已经在 OpenShift 4.18 + OpenShift AI 2.19 的环境中验证。

本文主要说明能够云原生备份容灾的开源项目 Velero 及其红帽扩展项目 OADP 的概念和架构篇。