简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

大模型生成PPT?其基本思路是?

以上内容仅仅是个人的简单见解,具有不对之处,可指出交流。

基于langchainsql和chatglm实现自然语言查询mysql数据库

import osimport jsonfrom flask import Flaskfrom flask import requestfrom transformers import AutoTokenizer, AutoModel# system paramsos.environ["CUDA_VISIBLE_DEVICES"] = "0"tokenizer = AutoTokenizer.fr

大模型生成PPT?其基本思路是?

以上内容仅仅是个人的简单见解,具有不对之处,可指出交流。

int8量化基本概念以及相关实现详解

随着大模型的出现,大家越来越意识到大模型的优势,相比传统的模型,缺点和不可用也显而易见,其中比较明显的就是算力的需求,这是很多公司可望而不可及的。为减少显存的占用,在训练阶段,主权重采用fp32,而推理时,fp16通常能提供与fp32相似的精度,这意味着,在使用大模型时,通过将模型转化为fp16,采用一半的显存就可以获取相同的效果,即使这样,显存的占用仍是巨大的,接着人们发现可以采用我们今天介绍的

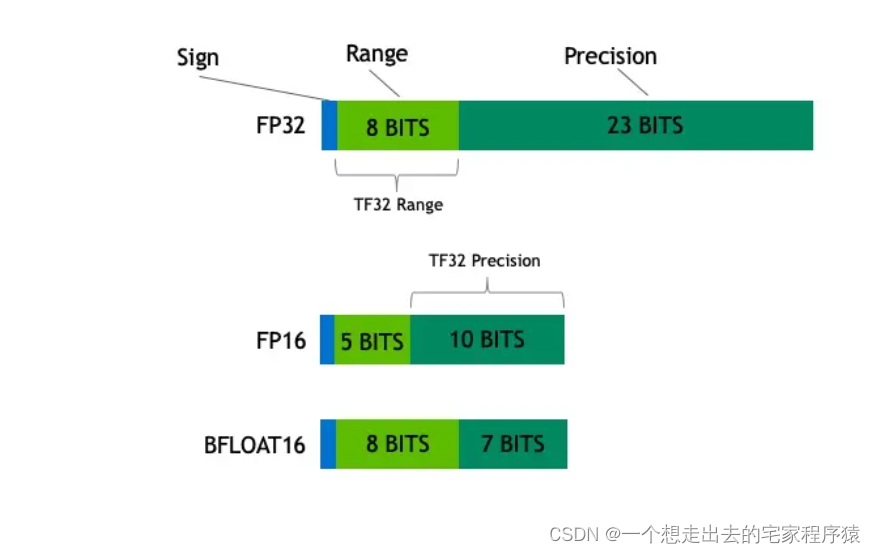

fp32、fp16、bf16介绍与使用

fp32、fp16、bf16分别称为单精度浮点数、半精度浮点数、半精度浮点数,其中fp16是intel提出的,bf16是nvidia提出的,fp16和bf16所占存储空间是fp32的一半。

大模型生成PPT?其基本思路是?

以上内容仅仅是个人的简单见解,具有不对之处,可指出交流。

到底了