简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

CAMEL是一个基于大语言模型的多智能体框架,主要用于智能体之间的协作和交互。

Dify 是一款开源的大语言模型(LLM)智能体开发平台,可以用于快速搭建个性化或具备商业价值的智能体。

可以通过通过ollama实例化Client或来创建自定义客户端。host: 要连接的 Ollama 主机timeout: 请求超时时间所有关键字参数参见httpx.Client。

配置时,通过创建自定义工具的方法,将BochaWebSearch设置为自定义工具,然后在工作流中接入BochaWebSearch 节点即可。基础URL 为ollama 服务,默认是 http://127.0.0.1:11434。创建自定义工具的方法为在dify的工具界面,点击创建自定义工具。进行登陆(本地配置可以登陆 http://127.0.0.1 或者http://localhost),进行D

GGUF (GPT-Generated Unified Format) 是一种文件格式,用于保存经过微调的语言模型,旨在帮助用于用于在不同的平台和环境之间共享和导入模型。支持多种量化格式,可以有效的减少模型文件的大小。

下载链接为:https://cdn.npmmirror.com/binaries/node/v18.19.0/node-v18.19.0-linux-x64.tar.xz。参考链接:https://github.com/n4ze3m/page-assist/issues/309。官网链接为: https://www.nodejs.com.cn/download.html。克隆 ollama-web

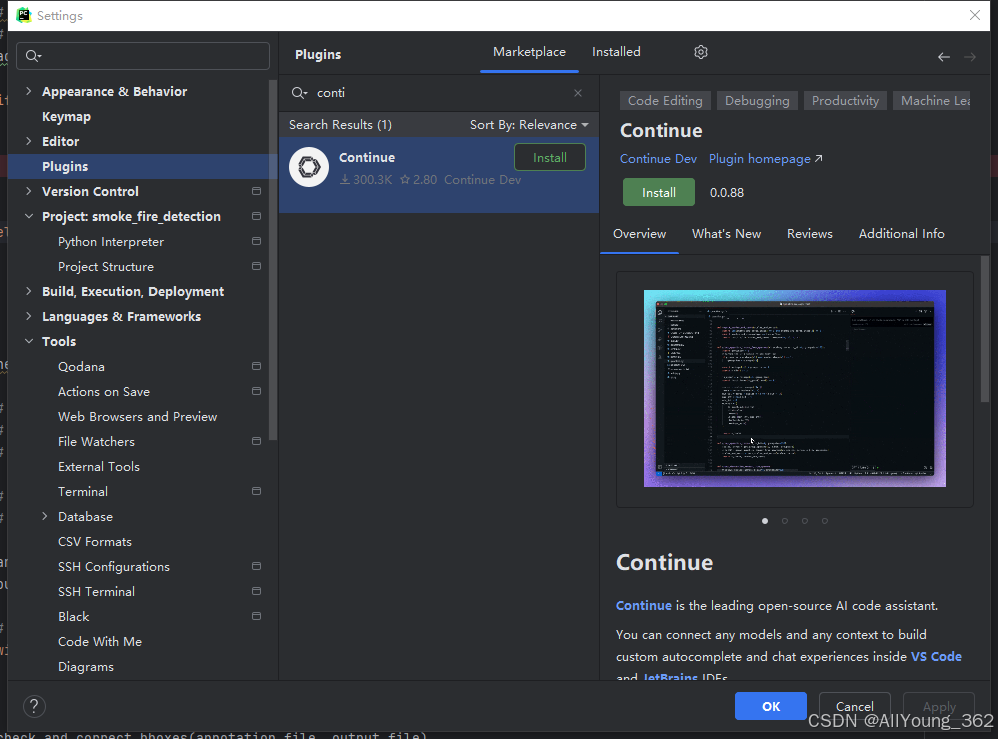

This file does not belong to the project“ 时,选择"This file",然后确定。配置信息写入更新后(仅替换默认config 文件中的"models"部分即可),重启pycharm即可。包含remote ollama 配置和硅基流动配置的config 文件如下。结构化后的硅基流动 config 配置文件如下。3.Continue 插件配置信息修改。Con

LangChain 是一个基于语言模型的框架,用于构建聊天机器人、生成式问答(GQA)、摘要等功能。它的核心思想是将不同的组件“链”在一起,以创建更高级的语言模型应用。LangChain就像一个超级连接器,可以轻松和各种外部工具(比如API、搜索引擎)对接。比如,想让聊天机器人能查询天气,只需要把天气API和LangChain连接起来,它就能帮你搞定。这样,你的应用功能会更强大,而且不需要自己去写

可以通过通过ollama实例化Client或来创建自定义客户端。host: 要连接的 Ollama 主机timeout: 请求超时时间所有关键字参数参见httpx.Client。

GGUF (GPT-Generated Unified Format) 是一种文件格式,用于保存经过微调的语言模型,旨在帮助用于用于在不同的平台和环境之间共享和导入模型。支持多种量化格式,可以有效的减少模型文件的大小。