简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

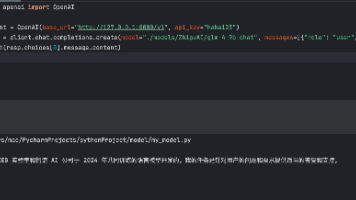

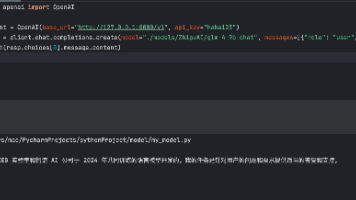

加载预训练模型。

加载预训练模型。

预训练是指在一个大型、通用数据集上,以自监督或无监督的方式,训练一个模型,使其学习到数据中内在的、可迁移的表示(Representations)。模型通过完成一些“前置任务(Pretext Tasks)”来学习,这些任务的设计目的是让模型在尝试解决它们的过程中,自然而然地掌握数据的有用特征,而不需要昂贵的人工标注微调是指在预训练模型的基础上,使用特定任务的小规模标注数据,对模型的全部或部分参数进行

预训练是指在一个大型、通用数据集上,以自监督或无监督的方式,训练一个模型,使其学习到数据中内在的、可迁移的表示(Representations)。模型通过完成一些“前置任务(Pretext Tasks)”来学习,这些任务的设计目的是让模型在尝试解决它们的过程中,自然而然地掌握数据的有用特征,而不需要昂贵的人工标注微调是指在预训练模型的基础上,使用特定任务的小规模标注数据,对模型的全部或部分参数进行

Graphical Processing Units (GPUs) 图形处理单元(GPU)是一种功能强大的电子芯片,用于在沉浸式视频游戏、电影和其他视觉媒体中呈现丰富的 2D/3D 图形和动画 因其超越 CPU 的并行矩阵运算性能,所以也被广泛应用于人工智能相关的各种系统,包括机器视觉、NLP、语音识别、自动驾驶等 GPU通过大量简单的处理单元(CUDA核心、Tensor核心等)并行工作,能够在短

Graphical Processing Units (GPUs) 图形处理单元(GPU)是一种功能强大的电子芯片,用于在沉浸式视频游戏、电影和其他视觉媒体中呈现丰富的 2D/3D 图形和动画 因其超越 CPU 的并行矩阵运算性能,所以也被广泛应用于人工智能相关的各种系统,包括机器视觉、NLP、语音识别、自动驾驶等 GPU通过大量简单的处理单元(CUDA核心、Tensor核心等)并行工作,能够在短

如果说Ollama的优势在于其简洁性,那么Vllm则是一个另辟蹊径、优先考虑性能和可扩展性的大模型部署框架,其核心的优化点在高效内存管理、持续批处理功能和张量并行性,从而在生产环境中的高吞吐量场景中表现极佳,同时这也是为什么Vllm框架是目前最适用于企业真实生产环境部署的根本原因。首先需要重点说明的是:Vllm框架仅支持Linux操作系统,官方并没有提供Windows的兼容版本。同时除了有操作的限

Ollama是在Github上的一个开源项目,其项目定位是:一个本地运行大模型的集成框架,目前主要针对主流的LLaMA架构的开源大模型设计,通过将模型权重、配置文件和必要数据封装进由Modelfile定义的包中,从而实现大模型的下载、启动和本地运行的自动化部署及推理流程。

文本切块是将长篇文档分解成更小、更易于管理的片段的过程。这在RAG系统中至关重要,因为它直接影响到检索到的信息的质量和相关性,从而最终影响大模型生成答案的准确性。

Document 类是 LangChain 中的核心组件,它定义了文档对象的基本结构,主要包含两个关键属性:page_content:存储文档的实际内容metadata:存储文档的元数据,如来源、创建时间等这个简单而强大的数据结构在整个 RAG 流程中扮演着关键角色,是文档加载器、分割器、向量数据库和检索器之间传递数据的标准格式。LangChain 提供了丰富的文档加载器,支持从多种数据源加载文档