简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

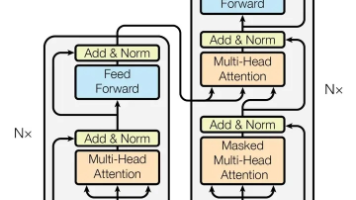

Transformer架构自2017年提出以来,推动了NLP领域的技术革命。研究显示,大模型发展经历了从Encoder-Decoder架构(如BERT)向Decoder-Only架构(如GPT系列)的转变。这种转变源于Decoder架构在多方面的优势:更符合语言生成规律、更适合大规模扩展、训练效率更高,并能展现"涌现"能力。当前主流大模型普遍采用Decoder-Only架构,其

Google推出的Agent2Agent(A2A)协议为智能体间协作提供了标准化框架,具有安全协作、任务管理、体验协商和能力发现四大特性。通过AgentCard实现服务发现,Task实体管理任务生命周期,支持多种状态流转。协议包含Server/Client架构,支持Artifacts结果存储和智能路由(AIAgentRouter)。相比Anthropic的MCP协议(专注工具集成),A2A更擅长复

该理论由Yao团队在2022年发表的论文《ReAct: Synergizing Reasoning and Acting in Language Models》中首次提出,后经Lilian Weng的系统性阐释,成为Agent系统设计的标准范式。文章以通俗易懂的语言架起学术与工业的桥梁,促进了技术普及,对智能体系统的研究和应用产生了深远影响。通过上述的agent模式的演进过程,它清晰地指明了“如何

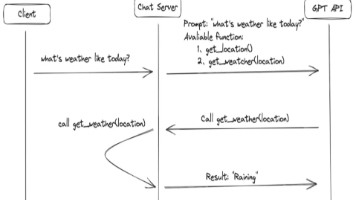

本篇文章主要介绍了FunctionCall功能,FunctionCall功能使大模型能够通过生成JSON对象来调用外部函数,解决了大模型在信息实时性、数据局限性和功能扩展性方面的问题。该功能通过定义函数描述,让模型智能判断何时调用外部工具,并返回所需参数。实现方式包括手动定义JSON Schema、使用@tool装饰器和Pydantic类三种方法,各具特点。

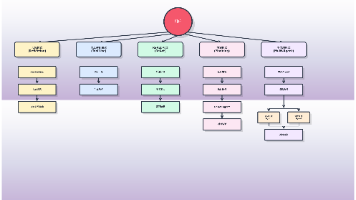

LangChain是由Harrison Chase于2022年10月创建的大语言模型(LLMs)开发框架,为各类LLMs提供统一接口,支持Python和Node.js。其主要包含六大组件:模型(LLMs、聊天模型、嵌入模型)、提示模板、记忆存储、索引(文档加载、文本分割、向量存储)、链式调用和代理工具。

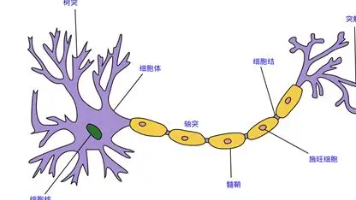

摘要:本文系统介绍了神经网络的基本原理和实现方法。首先阐述了人工神经网络的定义及其对生物神经网络的模拟机制,重点讲解了全连接网络的三层结构(输入层、隐藏层、输出层)。其次详细分析了常用激活函数(Sigmoid、Tanh、ReLU、Softmax)的特性、数学表达式及适用场景。接着探讨了多种参数初始化方法(均匀分布、正态分布、Kaiming、Xavier等)及其实现代码。最后通过PyTorch示例展