简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

基于华为Ascend710的凌华1U推理服务器,如何进行容器内推理

1. 安装依赖包sudo apt-get install libusb-1.0-0-dev2. 下载并编译uhubctlgit clone https://github.com/mvp/uhubctlcd uhubctlmakej将在uhubctl目录中产生一个uhubctl二进制执行文件。 你可以选择是否安装,如果要安装,则运行以下命令,程序将安装到/usr/sbin目录sudo make in

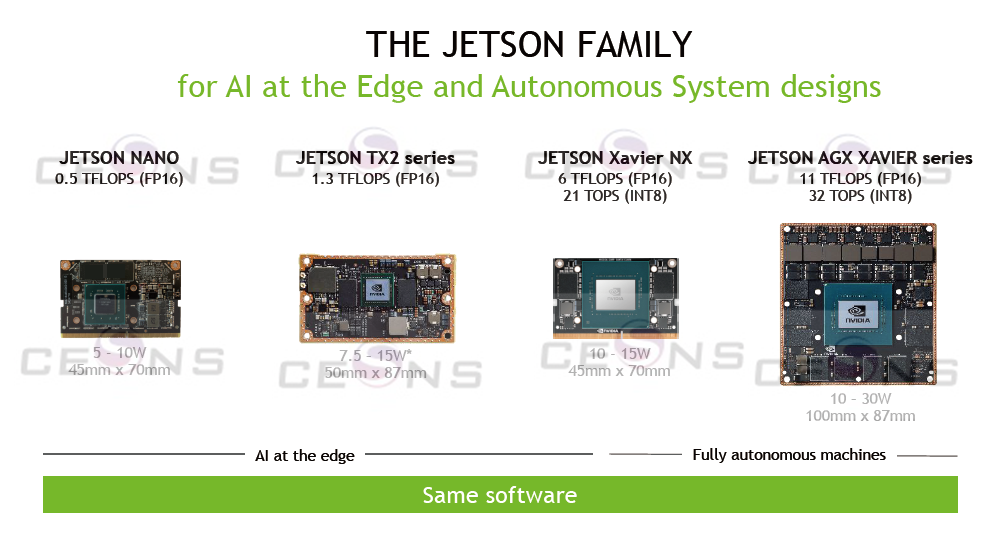

下图所示的Jetson 系列边缘计算模块将广泛流行的DNN 模型和ML 框架部署到具有高性能推断的边缘侧,用于实时分类和对象检测、姿势估计、语义分割和自然语言处理(NLP)等任务。下表显示了使用最新JetPack 版本的Jetson 系列的主流视觉深度神经网络DNN 的推理性能测评。通过从GitHub 运行。,GPU计算能力(Compute Capability)主要指GPU能够支持的计算类型的版

Jetson开发者现已突破百万,新加入的开发者可以直接从Orin系列上手。这个平台已经比多年前更加友好。Jetson Orin Nano开发套件官方定价为499美元,大家应该很快就能在市场上买到了。这个价格虽然比上一代Jetson Nano开发套件高了不少,但绝对物超所值。已有Jetson AGX Orin开发套件的用户可以在原硬件上模拟Jetson Nano的性能,而不用购买新套件。Orin系列

DLAP221开发环境部署1. 概述开发者基于DLAP221进行AI应用开发前,需要在制作SD卡时准备的Ubuntu服务器中部署开发环境,有以下三种场景:独立部署开发套件包,基于后台命令行的方式进行交叉开发。部署MindStudio,基于MindStudio开发工具进行AI应用开发,MindStudio安装时需要同时安装开发套件包(Cann Toolkit)。Cann Toolkit为开发者提供基

在部署深度学习模型时需要用到TensorRT,看了一遍文档后,我发现对于初学者来说,官方文档实在是太晦涩。文档里既没有接口的应用示例,也没有及时更新新接口的用法。在翻阅了部分博客和TensorRT仓库源码后,才有了本文。TensorRT是NVIDIA推出的用于深度学习推理的高性能引擎,旨在优化深度神经网络模型的推理速度和性能。TensorRT可以通过层融合、混合精度、量化等技术显著提高深度神经网络

当前,自动驾驶运算系统正在进入一场算力的竞赛中,特斯拉刚以自研的达到72TOPS算力、业内最强的FSD/HW3.0升级HW2.5不久,英伟达最新推出的芯片系统达到了2000TOPS的惊人算力。然而,自动驾驶首要确保的安全性和算力并没有直接关系,即便1000E(T的百万倍)OPS也达不到L4级别,这只是硬件厂家的数字游戏而已,内行人从不当真。这些所谓高算力实际针对乘积累加运算的高算力。乘积累加运算(

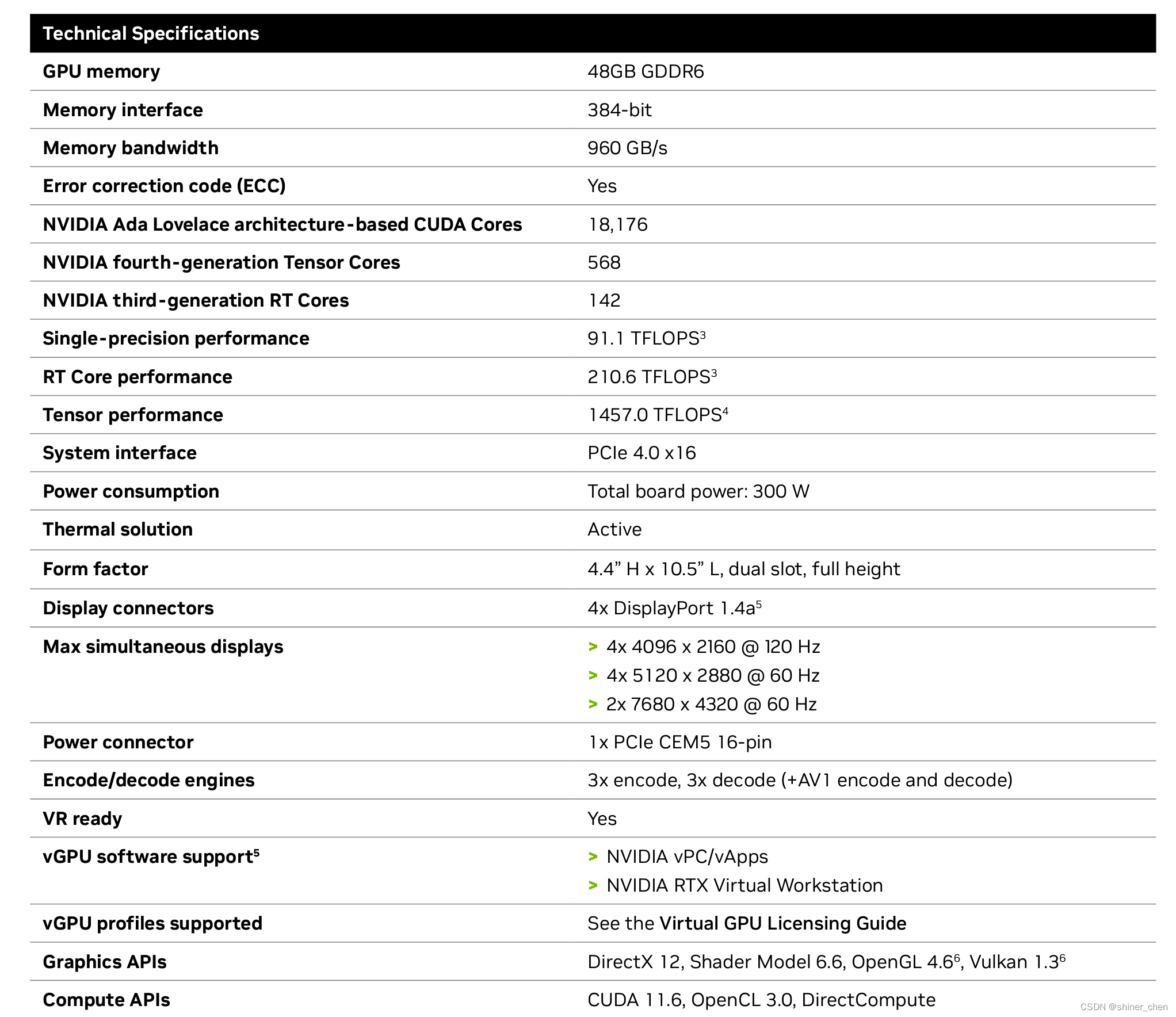

目前市面上GPU芯片众多,有时候对比各个GPU的性能非常麻烦,就连在nvidia官方,要比较两个GPU的性能都非常麻烦,而且有些指标还没有明确给出。都很难查到细节的参数。,下图中就没有GPU的主频说明,而这些在计算GPU性能对比时则尤为关键,,这里有各个厂家的GPU芯片参数的详细描述。特此记录一下,以免后面查找,找不到网址了!

在部署深度学习模型时需要用到TensorRT,看了一遍文档后,我发现对于初学者来说,官方文档实在是太晦涩。文档里既没有接口的应用示例,也没有及时更新新接口的用法。在翻阅了部分博客和TensorRT仓库源码后,才有了本文。TensorRT是NVIDIA推出的用于深度学习推理的高性能引擎,旨在优化深度神经网络模型的推理速度和性能。TensorRT可以通过层融合、混合精度、量化等技术显著提高深度神经网络