简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在别的地方看到了一篇有关总结模型评估的文章,感觉讲解还是挺有点内容的,转载过来 学习学习 分享下模型评估的方法一般情况来说,F1评分或者R平方(R-Squared value)等数值评分可以告诉我们训练的机器学习模型的好坏。也有其它许多度量方式来评估拟合模型。你应该猜出来,我将提出使用可视化的方法结合数值评分来更直观的评判机器学习模型。接下来的几个部分将分享

一、在适合用途上的比较。ItemCF是利用物品间的相似性来推荐的,所以假如用户的数量远远超过物品的数量,那么可以考虑使用ItemCF,比如购物网站,因其物品的数据相对稳定,因此计算物品的相似度时不但计算量较小,而且不必频繁更新;UserCF更适合做新闻、博客或者微内容的推荐系统,因为其内容更新频率非常高,特别是在社交网络中,UserCF是一个更好的选择,可以增加用户对推荐解释的信服程度。

P是“拒绝原假设时犯错误概率”又或者说是“如果你拒绝掉原假设实际上是在冤枉好人的概率”。不管怎么表达理解上都有点绕,所以你还是看例子吧。比如你做一个假设( null hypothesis):你的女性朋友平均身高2米,输入你统计的样本数据后,计算机给你返回的p值是0.03。这意味着如果你拒绝“女性朋友平均身高2米”这个结论,犯错的概率是0.03,小于0.05(人们一般认为拒绝一句话时犯错概率小于0.

Bad Rate:坏样本率,指的是将特征进行分箱之后,每个bin下的样本所统计得到的坏样本率bad rate 单调性与不同的特征场景:在评分卡模型中,对于比较严格的评分模型,会要求连续性变量和有序性的变量在经过分箱后需要保证bad rate的单调性。1. 连续性变量:在严格的评分卡模型中,对于连续型变量就需要满足分箱后 所有的bin的 bad ...

而无形资产摊销属于管理费用,无形资产是指企业拥有的没有实物形态的资产,比如专利、商标、版权等,这些资产的使用期限有限,需要按照一定的方法进行摊销,将其成本分摊到多个会计期间内,以反映其在企业经营活动中的消耗情况。或者医药研发或者科技公司,研发费用是主要的费用支出,但对未来信心足的,也不会担心计入费用后会影响利润,比如恒瑞医药。费用化顾名思义,就是正常的处理,计入研发费用进而计入到总费用,然后影响的

目前机器学习的一个比较热门的方向是统计机器学习(另外一个可能是图模型,按照Jordan的说法是统计机器学习属于频率主义,而图模型属于贝叶斯主义),对于每一个做统计机器学习的研究者来说,他们大致可以分为两类:一类做统计学习理论相关工作,如泛化界、约简或一致性;一类做优化算法,如支持向量机、Boosting等。作为一个纯统计机器学习的学者来说,我想这两块内容都得了解。优化算法的门槛低点,可能比较容易上

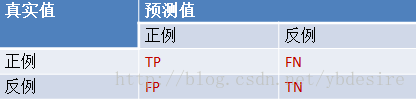

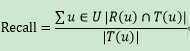

准确率,顾名思义,就是准确程度。通过正确数/总数得到。而正确数是什么,总数是什么呢?召回率,我们可以理解为找到的数目与总的需要我们找到的数目的比,那在推荐系统中,什么是找到的数目,什么是需要我们总的找到的数目呢?令R(u)表示在根据训练数据给用户做出的推荐列表,T(u)表示用户根据测试数据给用户做出的推荐列表,则召回率:准确率:精确率是针对我们预...

先验概率和后验概率教科书上的解释总是太绕了。其实举个例子大家就明白这两个东西了。假设我们出门堵车的可能因素有两个(就是假设而已,别当真):车辆太多和交通事故。堵车的概率就是先验概率。那么如果我们出门之前我们听到新闻说今天路上出了个交通事故,那么我们想算一下堵车的概率,这个就叫做条件概率。也就是P(堵车|交通事故)。这是有因求果。如果我们已经出了门,然后遇到了堵车,那么我们想

1.IV的用途IV的全称是InformationValue,中文意思是信息价值,或者信息量。我们在用逻辑回归、决策树等模型方法构建分类模型时,经常需要对自变量进行筛选。比如我们有200个候选自变量,通常情况下,不会直接把200个变量直接放到模型中去进行拟合训练,而是会用一些方法,从这200个自变量中挑选一些出来,放进模型,形成入模变量列表。那么我们怎么去挑选入

分类模型评估:指标描述Scikit-learn函数Precision精准度from sklearn.metrics import precision_scoreRecall召回率from sklearn.metrics import recall_scoreF1F1值