简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

大模型收到输入后并不是一次性生成最终结果,而是逐步地生成中间结果,最终结果由中间结果拼接而成。相比非流式输出,流式输出可以实时地将中间结果返回,您可以在模型进行输出的同时进行阅读,减少等待模型回复的时间;并且当输出内容较长时,有效降低请求超时的风险。本文给出了使用Python requests库调用大型语言模型(LLM)API的非流式输出与流式输出的简单介绍和代码实例。

多轮对话功能可以让大模型“拥有记忆”,满足如追问、信息采集等需要连续交流的场景。AI大模型API 不会记录您的对话历史记录。如果您需要让大模型参考历史对话信息,需要将历史对话信息与新的指令一同输入到AI大模型对应 API 中。实现多轮对话的关键在于维护一个 messages 列表,您可以将每一轮的对话历史以及新的指令以{“role”: “xxx”, “content”: “xxx”}的形式添加到

多轮对话功能可以让大模型“拥有记忆”,满足如追问、信息采集等需要连续交流的场景。AI大模型API 不会记录您的对话历史记录。如果您需要让大模型参考历史对话信息,需要将历史对话信息与新的指令一同输入到AI大模型对应 API 中。实现多轮对话的关键在于维护一个 messages 列表,您可以将每一轮的对话历史以及新的指令以{“role”: “xxx”, “content”: “xxx”}的形式添加到

大模型收到输入后并不是一次性生成最终结果,而是逐步地生成中间结果,最终结果由中间结果拼接而成。相比非流式输出,流式输出可以实时地将中间结果返回,您可以在模型进行输出的同时进行阅读,减少等待模型回复的时间;并且当输出内容较长时,有效降低请求超时的风险。本文给出了使用Python requests库调用大型语言模型(LLM)API的非流式输出与流式输出的简单介绍和代码实例。

多轮对话功能可以让大模型“拥有记忆”,满足如追问、信息采集等需要连续交流的场景。AI大模型API 不会记录您的对话历史记录。如果您需要让大模型参考历史对话信息,需要将历史对话信息与新的指令一同输入到AI大模型对应 API 中。实现多轮对话的关键在于维护一个 messages 列表,您可以将每一轮的对话历史以及新的指令以{“role”: “xxx”, “content”: “xxx”}的形式添加到

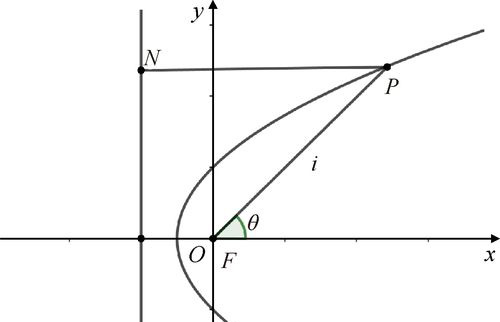

韦达定理说明了一元n次方程中根和系数之间的关系。法国数学家韦达(F. Vieta,1540—1603)最早发现代数方程的根与系数之间有这种关系,因此,人们把这个关系称为韦达定理。有趣的是,韦达在16世纪就得出这个定理,证明这个定理要依靠代数基本定理,而代数基本定理却是在1799年才由高斯作出第一个实质性的论证。韦达定理在方程论中有着广泛的应用。

大模型收到输入后并不是一次性生成最终结果,而是逐步地生成中间结果,最终结果由中间结果拼接而成。相比非流式输出,流式输出可以实时地将中间结果返回,您可以在模型进行输出的同时进行阅读,减少等待模型回复的时间;并且当输出内容较长时,有效降低请求超时的风险。本文给出了使用Python requests库调用大型语言模型(LLM)API的非流式输出与流式输出的简单介绍和代码实例。