简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

最大熵模型可以用于分类问题,是针对条件概率P(y|x)进行建模的判别式模型。其主要思想可以用一句话概括:在现有已知信息的约束以及没有更多已知信息的情况下,使条件概率P(Y|X)的分布更加均匀,这样获得的模型经验风险更小,鲁棒性更强。 使P(Y|X)分布更加均匀,从信息熵的角度来看,就是使条件熵H(Y|X)更大(最大熵),那么根据条件熵公式:H(P)=−∑x,yP(x,y)logP(y∣x)

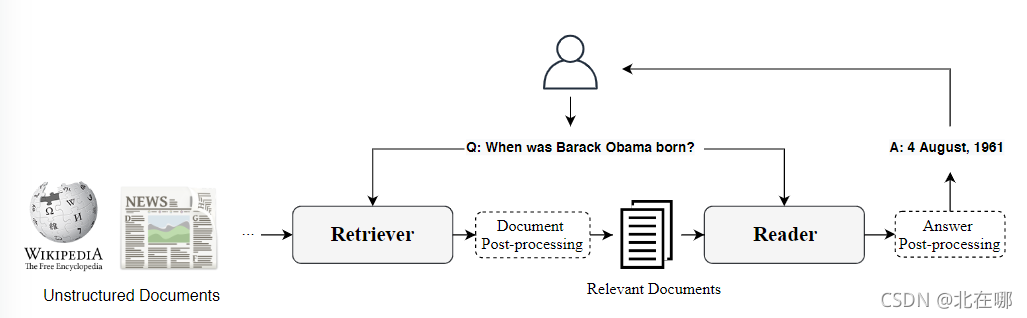

1. 概要本文提出Dense-Sparse Phrase Index (DENSPI),一个用于实时开放域 QA 的可索引的查询无关的短语表示模型。短语表示事先离线存储,推理时,输入问题被映射到相同的表示空间,并检索具有最大内积搜索的短语作为答案。短语表示结合了密集向量和稀疏向量。2. 短语和问题嵌入2.1 短语的密集嵌入向量使用表示第个文档中起始位置分别为的短语的密集向量,论文将该向量分解为三个

从广义上讲,目前的 Retriever 方法可以分为三类,即 Sparse Retriever、Dense Retriever 和 Iterative Retriever,下面将详细介绍。

SoftmaxSoftmax是指数标准化函数,又称为归一化指数函数,将多个神经元的输出,映射到 (0,1) 范围内,并且归一化保证和为1,从而使得多分类的概率之和也刚好为1。其公式如下:Softmax(zi)=exp(zi)∑jexp(zj)\operatorname{Softmax}\left(\boldsymbol{z}_{i}\right)=\frac{\exp \left(z_{i}

SoftmaxSoftmax是指数标准化函数,又称为归一化指数函数,将多个神经元的输出,映射到 (0,1) 范围内,并且归一化保证和为1,从而使得多分类的概率之和也刚好为1。其公式如下:Softmax(zi)=exp(zi)∑jexp(zj)\operatorname{Softmax}\left(\boldsymbol{z}_{i}\right)=\frac{\exp \left(z_{i}