简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

Agentic AI--06--liteLLM--实战02--准Agent搭建

实现一个Quasi-Agent(准Agent)通过以上内容,应当掌握:我们做的核心是控制LLM所看见的消息(API交互方式)我们精准控制 LLM 看到 生成的代码,而不是另外生成的一些文字性补充内容每一段发送给 LLM 的指令都有精准的含义上下文通过 message 记录进行 特定的构建(删去了部分内容)

Agentic AI--04--liteLLM--实战01

本文记录liteLLM如何安装,并以DeepSeek为例如何使用的基本教程提示:以下是本篇文章正文内容,下面案例可供参考。

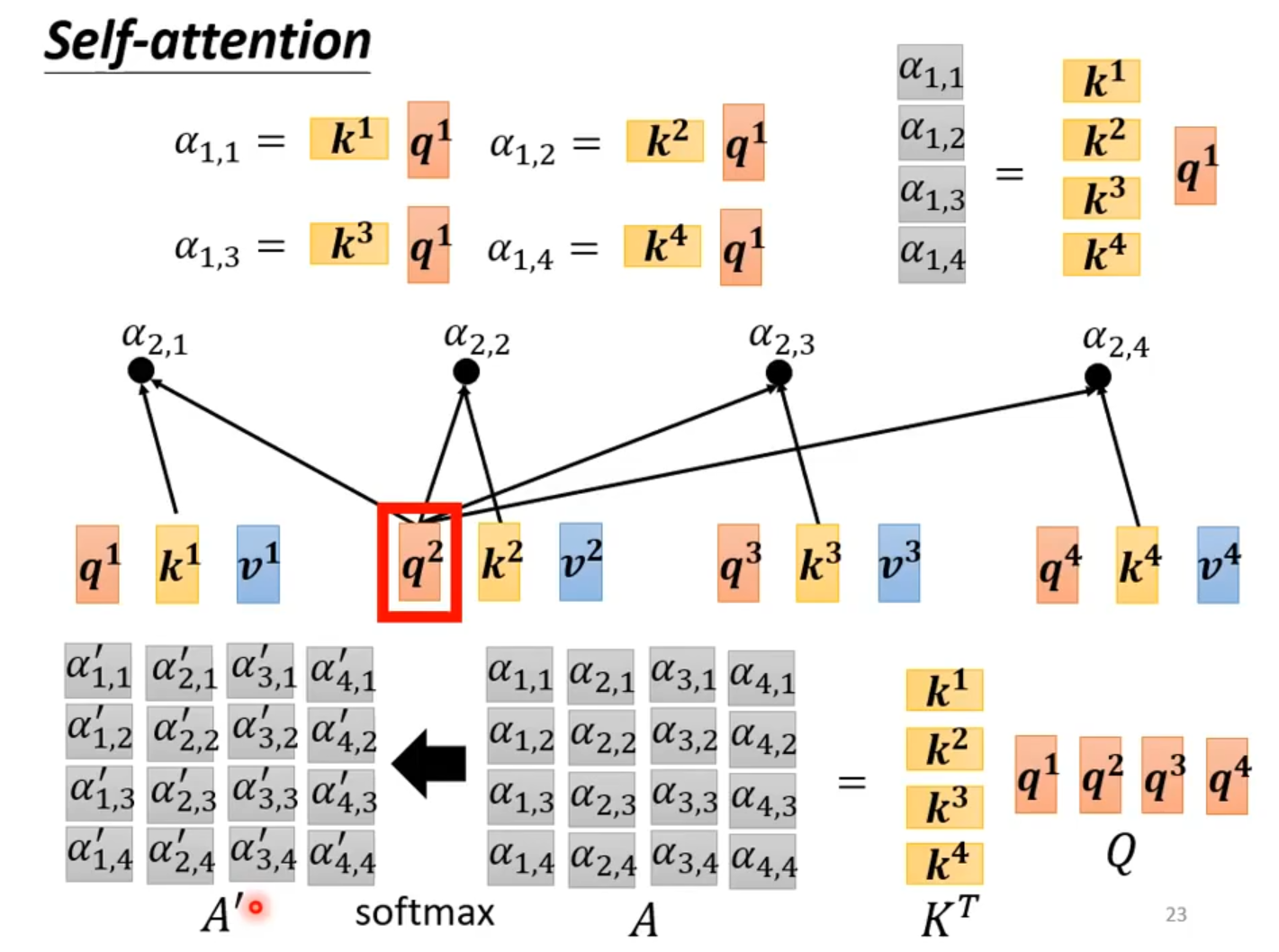

Self-Attention 学习笔记

Attention机制的本质attention机制的本质是从人类视觉注意力机制中获得灵感。大致是我们视觉在感知东西的时候,一般不会是一个场景从到头看到尾每次全部都看,而往往是根据需求观察注意特定的一部分。而且当我们发现一个场景经常在某部分出现自己想观察的东西时,我们就会进行学习在将来再出现类似场景时把注意力放到该部分上。从关注全部到关注重点Attention机智的优势参数少模型复杂度跟 CNN、R

到底了