简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

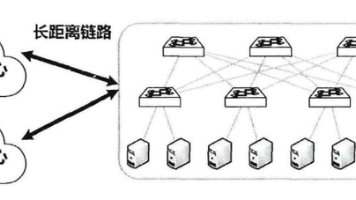

集群调度系统是大规模集群(尤其是多 GPU / 超算集群)的 “必备基础设施”,核心价值是 “统一管理资源、有序调度任务”,避免冲突、提升利用率、保障稳定性。若在科研机构 / 超算中心,主要做长时大规模计算(如大模型训练、科学模拟),Slurm 是首选 —— 稳定、适配 HPC 场景,是科研界的 “标准工具”;若在互联网公司 / 云厂商,主要做 AI 推理、快速迭代的训练任务,或需要容器化部署,K

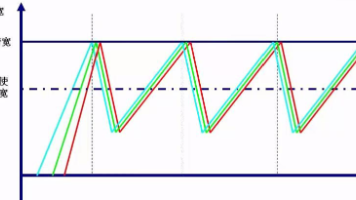

DCTCP 的工作原理可概括为“ECN 早感知 + 平滑窗口调整 + 低队列控制”通过 ECN 机制实现 “不丢包的拥塞预判”,解决传统 TCP 反应滞后的问题;以拥塞标记比例(F)为核心,实现窗口的平滑调整,平衡吞吐量与延迟;最终将网络队列长度控制在极低水平,完美适配智算中心 “长流高吞吐、短流低延迟” 的混合需求,成为数据中心 / 智算中心传输控制的基础优化方案。

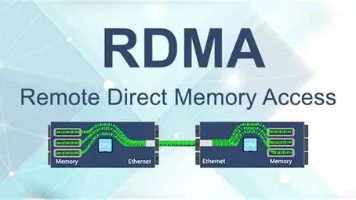

智算中心作为AI和数字经济的"超级大脑",通过分布式架构和高速网络整合算力资源,支撑深度学习等高性能计算需求。RDMA技术凭借零拷贝、低延迟特性成为核心传输方案,其中RoCEv2因兼容性和成本优势成为主流。国内外应用显示,该技术能显著提升GPU集群训练效率,但面临拥塞敏感等挑战。未来需优化传输控制技术,以支撑更大规模部署。智算中心建设正加速推进,为"东数西算"

CPU和GPU内部通道设计差异显著:CPU采用低延迟、灵活的多通道架构(指令/数据总线分离、缓存互联等),适合复杂逻辑调度,但带宽有限(1-2TB/s);GPU则通过高带宽并行通道(寄存器堆互联、SM互联网络等)实现10-20TB/s吞吐量,专为海量并行计算优化。CPU通道占比15-20%芯片面积,GPU仅占8-12%。这种差异决定CPU擅长系统调度等通用任务,GPU则胜任AI训练等并行计算。多卡

RDMA 的本质是 “用硬件成本换性能”,核心价值在于解决传统网络的 “延迟高、CPU 占用高、带宽瓶颈” 问题,是超大规模 AI 集群、高性能计算的 “刚需技术”—— 比如鹏城实验室的 GPU 集群用 InfiniBand RDMA,实现万卡 GPU 间的梯度同步延迟低至微秒级,让千亿参数大模型训练周期从数年压缩到数月。

内存(RAM)和显存(VRAM)是计算机中两种关键的临时存储硬件,但功能定位截然不同。内存作为CPU的"通用工作台",存储系统进程和运行软件数据,容量较大但带宽较低;显存则是GPU的"专属实验室",专用于存储AI模型参数、图形数据等,具有超高带宽(可达内存的10-50倍)但容量较小。两者无法互相替代——即使内存充足,GPU仍需将数据加载到显存才能计算。在科研

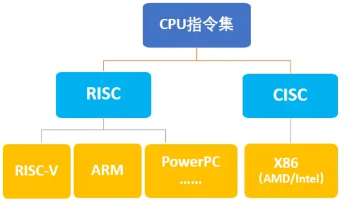

CPU与GPU指令集设计差异源于其核心定位:CPU指令集(如x86/ARM)侧重通用性,支持复杂逻辑判断、多任务调度和多样化计算,具备丰富指令类型和低延迟特性;GPU指令集(如CUDA/ROCm)专为并行计算优化,采用SIMD模式实现数万核心同步运算,聚焦算术运算和内存访问,吞吐量极高但延迟较高。在科研场景中,CPU负责任务调度与系统控制,GPU处理海量并行计算(如AI训练),二者协同工作。优化指

GPU 的核心是 “并行计算”,从最初的图形渲染工具,进化为 AI 时代的核心算力支撑 —— 对于计算机科学领域的科研 / 工作而言,GPU 是处理海量数据、训练复杂模型、加速科研进程的 “必备工具”。理解 GPU 的并行特性、选型逻辑和软件适配,能帮助更高效地开展研究(如大模型训练、科学计算、AI 应用开发)。

TailDrop是网络设备处理拥塞的最简单方式,当队列满时直接丢弃新数据包。它虽然实现简单,但会导致TCP全局同步和流量雪崩问题,引发网络性能波动。RED通过随机提前丢弃少量数据包避免集中丢包,ECN则采用标记拥塞通知的方式实现无损控制。相比TailDrop的被动丢弃,RED和ECN能主动预防拥塞,分别适用于普通TCP网络和对丢包敏感的高端场景(如RDMA、GPU集群)。在数据中心等要求高性能的网

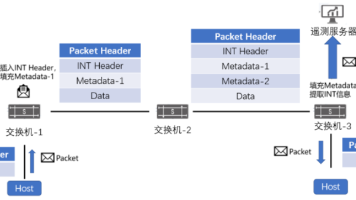

INT技术通过数据报文嵌入实时网络状态信息,实现精准细粒度的网络监测。其核心优势在于微秒级延迟感知、<1%带宽开销,并能精确定位拥塞节点。概率性INT(PINT)通过概率采样和分布式协作进一步降低开销,同时保持监控精度。该技术结合AI分析,可支撑智算中心从被动拥塞处理转向主动流量适配,解决多场景流量动态切换难题。