简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Grok-1是一个含有3140亿(314B)参数的专家混合模型(Mixture-of-Experts, MoE)。该模型由xAI公司自底向上进行训练,未采用任何特定应用的预训练数据集。同样的,由于该模型没有针对特定应用进行微调,因此它可能不适合直接用于对话或其他特定任务。在GitHub页面中,官方也指出,由于模型规模较大(314B参数),运行Grok需要配备充足GPU和内存的机器。文件大小接近30

Grok-1是一个含有3140亿(314B)参数的专家混合模型(Mixture-of-Experts, MoE)。该模型由xAI公司自底向上进行训练,未采用任何特定应用的预训练数据集。同样的,由于该模型没有针对特定应用进行微调,因此它可能不适合直接用于对话或其他特定任务。在GitHub页面中,官方也指出,由于模型规模较大(314B参数),运行Grok需要配备充足GPU和内存的机器。文件大小接近30

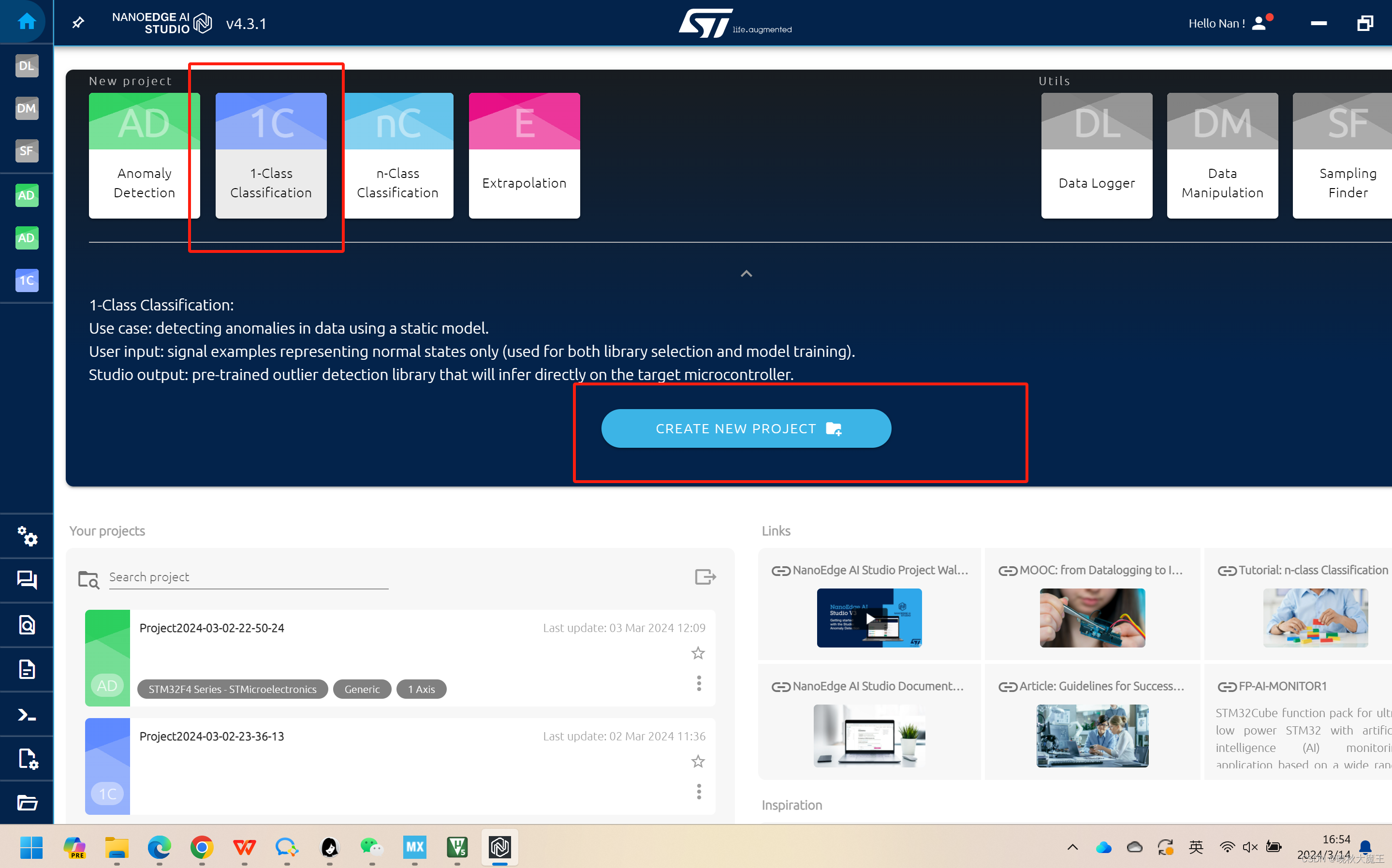

简要来说,单分类就是,你只需要将某一状态的数据给NEAI,经过训练后AI可以判断新数据与该状态的相似度。这里讲解的就非常简单了,很多内容都在第二章铺垫好了,大家可以去看下。出差在外,没有太多时间更新。让我们开始第三章--单分类。2.选择MCU和数据维度。数据要求和之前的一样。

Grok-1是一个含有3140亿(314B)参数的专家混合模型(Mixture-of-Experts, MoE)。该模型由xAI公司自底向上进行训练,未采用任何特定应用的预训练数据集。同样的,由于该模型没有针对特定应用进行微调,因此它可能不适合直接用于对话或其他特定任务。在GitHub页面中,官方也指出,由于模型规模较大(314B参数),运行Grok需要配备充足GPU和内存的机器。文件大小接近30

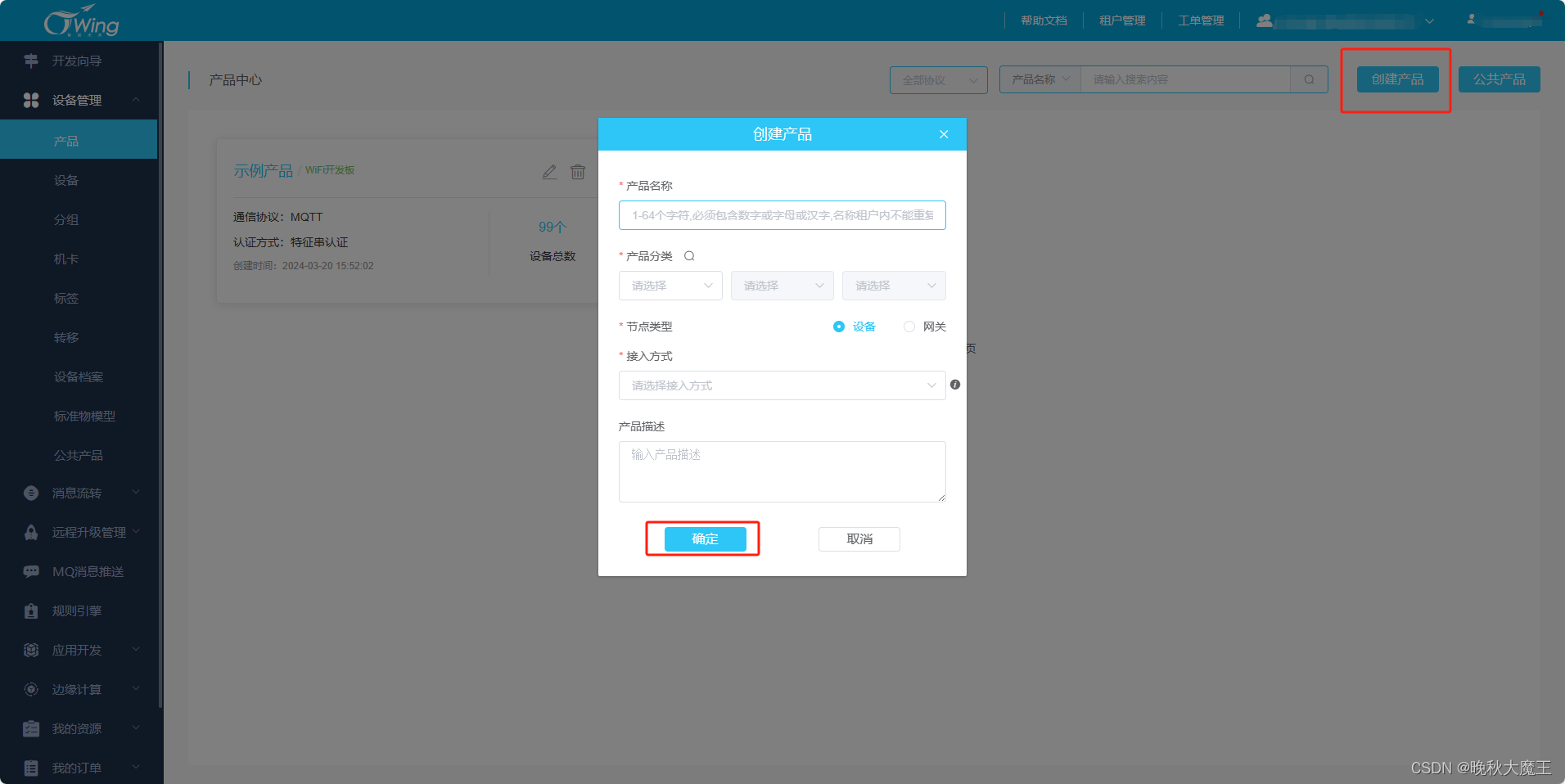

注意哈,这里如果你收不到,你可以尝试下断开mqttfx然后重新连接,重新订阅,再发布就可以了。填写参数,注意这里服务ID要大一点,因为aep给你预设了一些服务,你自己设定的不能和它冲突。1.Broker Address:从设备接入地址中取该部分。2.Broker Port:从设备接入地址中取该部分。3.Client ID:填写设备ID。8.打开mqttfx,输入主题与报文。打开aep平台,进行命令