简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

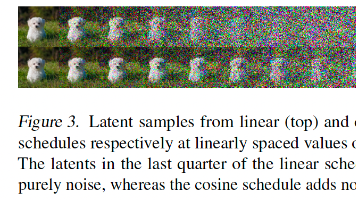

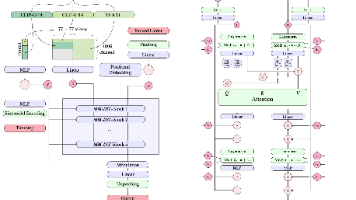

去噪扩散概率模型(DDPM)是生成式AI领域的重要突破,其核心思想模拟了一个"逐步加噪-逐步去噪"的过程。想象一下:将一张清晰图片逐步添加噪声,直到完全变成随机噪点,然后训练神经网络学习如何逆向这个过程,从噪声中重建原图。然而,原始DDPM存在三大痛点:架构基础与创新:本文在原始DDPM的UNet架构基础上进行了重要改进,构建了更强大的特征提取网络。核心创新包括:注意力机制增强:QKT)V条件

Stable Diffusion 3.0+(SD3.0+)作为Stability AI继SDXL后的新一代文生图标杆模型,其核心突破完全依托Meta团队《Scaling Rectified Flow Transformers for High-Resolution Image Synthesis》论文提出的整流流Transformer(Rectified Flow Transformers)技术体

预训练任务的设计是AI模型获取通用能力的关键。从NLP的MLM到CV的MIM,从单模态到多模态,任务设计日益精巧高效。这些任务不仅推动了技术进步,也深化了我们对智能本质的理解。随着任务设计的不断创新,AI模型将具备更全面、更深刻的世界理解能力,向通用人工智能的目标稳步迈进。

Pandas 是一个功能强大且灵活的数据分析库,适用于数据清洗、处理和分析。通过本文的示例,您可以看到 Pandas 提供了丰富的数据操作功能,包括数据选择、过滤、排序、分组、合并、清洗、导入导出等。掌握这些基本操作将有助于您在数据科学和数据分析中的工作。希望这篇博客能帮助您更好地理解和使用 Pandas!

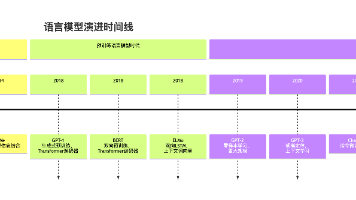

在人工智能的众多分支中,自然语言处理(NLP)一直是最具挑战性的领域之一。要让机器理解、生成人类语言,核心在于解决两个基本问题:核心思想:马尔可夫假设,一个词的出现只依赖于前面n−1n-1n−1个词。数学模型:P(w1w2…wm)≈∏P(wi)P(w_1 w_2 \ldots w_m) \approx \prod P(w_i)P(w1w2…wm)≈∏P(wi)P(w1w2…wm)≈P(w1

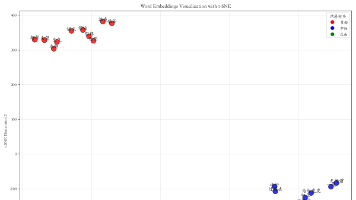

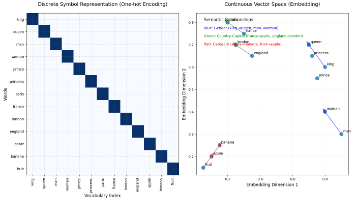

映射功能:将离散的整数索引(如词汇ID)转换为连续的向量表示表示学习:通过训练学习每个符号的分布式表示维度转换:从一维的索引空间到高维的连续向量空间。

是一种将转换为的技术。简单来说,它就像为每个概念(如单词、用户、产品)创建一个独特的"数字身份证",这个身份证不仅代表身份,还包含了该概念的特征和关系信息。

近年来,基于深度学习的语音增强方法在性能上已经远远超过了传统的基于谱减法和谱估计的方法。这些新技术大多直接在短时傅里叶变换(STFT)域中操作,导致计算复杂度很高。本文提出了一种名为PercepNet的高效方法,它基于人类对语音的感知,重点关注语音的频谱包络和周期性。我们展示了高质量的实时全频带(48 kHz)语音增强,其计算复杂度不到一个CPU核心的5%。

Vision Transformer不仅仅是一个新的图像分类模型,它更代表了一种思维范式的转变——用统一的Transformer架构来处理不同模态的数据。它模糊了NLP与CV之间的界限,推动了基础模型和多模态AI的研究热潮。虽然CNN因其高效和成熟,在诸多场景中仍不可替代,但ViT及其家族无疑为我们指明了一个充满潜力的方向:一个更加通用、统一、能够融会贯通地理解世界的AI架构。未来,也许我们不再需

在音频处理和机器学习领域,音频数据增强是一种常用的技术,旨在通过对原始音频信号进行各种变换和处理,生成更多样化的训练数据。这不仅可以提高模型的鲁棒性,还能改善其在真实世界应用中的表现。本文将介绍几种常用的音频数据增强技术,包括时间拉伸、音高变换、带通滤波、均衡器、冲激响应处理、归一化、填充、延迟处理和非线性模拟。