简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

一.模型解读今天是大名鼎鼎的detectron2,关于detectron2的解读数不胜数,在此我暂时就不推荐了!官方代码二.试跑效果测试环境:机器 : Dell T5820服务器GPU:Nvidia P4000cuda:10.1cudnn:7.5关键库:torch 1.3.0; torchvision 0.4.1;opencv-python 3.4.7pyco...

目录一.模型解读二.试跑效果一.模型解读作为一个由商汤视觉智能研究团队开发的视觉追踪的模型,该论文主要解决的问题是将深层基准网络ResNet、Inception等网络应用到基于孪生网络的跟踪网络中。在SiameseFC算法之后,尽管已经有很多的基于孪生网络的跟踪算法,但是大家可能会注意到一个问题是,这些网络都使用浅层的类AlexNet做为基准特征提取器。其实在这之前,也有学者们尝试着使用深层的..

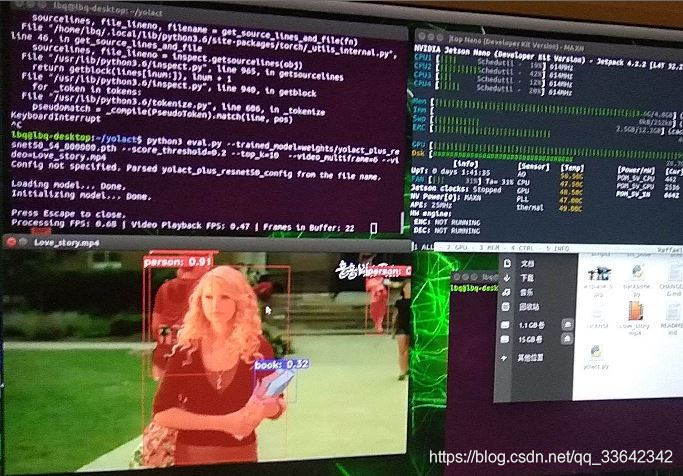

目录一.模型解读二.试跑效果yolactyolact++一.模型解读链接中的解读很通俗详细,在此不做赘述;而且YOLACT++在大前天也发布了,作为一个为数不多的在实时检测中可以用mask分割目标的方法,确实非常值得有兴趣的研究人员以及相关学者期待一下.详细解读官方代码YOLACT++解读二.试跑效果yolact测试环境:机器 : 华硕笔记本GPU:Nvidia GTX10...

目录一.模型解读二.试跑效果yolactyolact++一.模型解读链接中的解读很通俗详细,在此不做赘述;而且YOLACT++在大前天也发布了,作为一个为数不多的在实时检测中可以用mask分割目标的方法,确实非常值得有兴趣的研究人员以及相关学者期待一下.详细解读官方代码YOLACT++解读二.试跑效果yolact测试环境:机器 : 华硕笔记本GPU:Nvidia GTX10...

目录一.模型解读二.试跑效果yolactyolact++一.模型解读链接中的解读很通俗详细,在此不做赘述;而且YOLACT++在大前天也发布了,作为一个为数不多的在实时检测中可以用mask分割目标的方法,确实非常值得有兴趣的研究人员以及相关学者期待一下.详细解读官方代码YOLACT++解读二.试跑效果yolact测试环境:机器 : 华硕笔记本GPU:Nvidia GTX10...

目录一.模型解读二.试跑效果一.模型解读作为一个由商汤视觉智能研究团队开发的视觉追踪的模型,该论文主要解决的问题是将深层基准网络ResNet、Inception等网络应用到基于孪生网络的跟踪网络中。在SiameseFC算法之后,尽管已经有很多的基于孪生网络的跟踪算法,但是大家可能会注意到一个问题是,这些网络都使用浅层的类AlexNet做为基准特征提取器。其实在这之前,也有学者们尝试着使用深层的..

一.模型解读今天是大名鼎鼎的detectron2,关于detectron2的解读数不胜数,在此我暂时就不推荐了!官方代码二.试跑效果测试环境:机器 : Dell T5820服务器GPU:Nvidia P4000cuda:10.1cudnn:7.5关键库:torch 1.3.0; torchvision 0.4.1;opencv-python 3.4.7pyco...

先贴几张图代码要改的哦;模型暂时还没训练;GPU算了有需求;感觉一堆的坑.

Windows下编译yolo的cmakelist会报出上述警告,只需将cmake版本降低到3.17.1及以下就行,亲测可用。

卸载之前的安装pip uninstall ffmpeg-pythonpip uninstall ffmpeg然后再安装:conda install -c menpo ffmpegpip install ffmpeg-python