简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

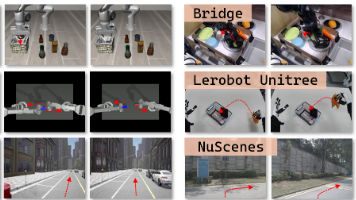

欢迎更多企业联系入驻~宇树科技-页面展示图片来源:【具身智能之心】开源知识库社区 截图。

Loco-Manipulation 作为具身智能从实验室走向真实场景的核心技术,已形成"模型驱动稳、学习驱动泛、基础模型通"的三足鼎立格局。7 篇代表性成果分别覆盖了工业级稳定协同、复杂环境适配、数据高效学习、开放世界通用等核心需求,展现了技术从专用到通用的演进路径。用基础模型解决"做什么、去哪做"的规划问题,用学习/模型混合方法解决"怎么协同做"的控制问题,用工程化设计解决 “怎么低成本落地”

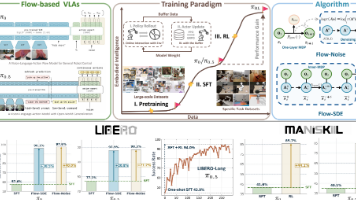

当前 VLA 模型训练陷入 “两难困境”:SFT 依赖大规模专家轨迹,成本高且泛化弱;方案类型代表思路核心缺陷传统 SFT 方案基于专家演示数据微调流式 VLA1. 高质量专家轨迹采集成本高、周期长;2. 模型易过拟合演示数据,面对新任务(如长序列抓取)性能暴跌;3. 无法通过环境交互动态优化动作策略现有 RL 方案直接将 RL 用于自回归 VLA 模型1. 适配对象局限于离散动作的自回归模型(如

机器人学长期以来一直是科学研究中的重要领域。早期的机器人主要依赖预编程的指令和人工设计的控制策略来完成任务分解与执行。这类方法通常应用于简单、重复性的任务,例如工厂流水线和物流分拣。近年来,人工智能的快速发展使研究者能够在图像、文本和点云等多模态数据中,利用深度学习的特征提取与轨迹预测能力。通过结合感知、检测、跟踪和定位等技术,研究者将机器人任务分解为多个阶段,以满足执行需求,从而推动了具身智能与

一、介绍缺陷检测被广泛使用于布匹瑕疵检测、工件表面质量检测、航空航天领域等。传统的算法对规则缺陷以及场景比较简单的场合,能够很好工作,但是对特征不明显的、形状多样、场景比较混乱的场合,则不再适用。近年来,基于深度学习的识别算法越来越成熟,许多公司开始尝试把深度学习算法应用到工业场合中。二、缺陷数据如下图所示,这里以布匹数据作为案例,常见的有以下三种缺陷,磨损、白点、多线。如何制作训练数...

现有的强化学习主要分为五种:通过价值选行为:Q-learning、Sarsa、Deep Q Network直接选行为:Policy Gradients想象环境并从中学习:Model Based RL回合更新:基础版的Policy Gradients、Monte-Carlo Learning单步更新:Q Learning、Sarsa、升级版Policy Gradients一、Q-Lear...

据悉,具身智能企业星动纪元在近日完成10亿元战略轮融资,估值破百亿。本轮融资由三星、高成投资、新加坡电信、友利资本(隶属韩国友利金融集团)、中金保时捷、中芯聚源、峰和资本、锡创投、广发乾和、鸿瑞集团等等新机构联合投资,鼎晖VGC、清控天诚等老股东超额追加投资。至此,星动纪元累计吸引16家国内外产业投资方,为具身智能行业之最,资方包括国际产业巨头,形成了"国际巨头+国内龙头"的生态矩阵,涵盖科技、汽

physical intelligence刚出的一篇blog,关于VLAs with Long and Short-Term Memory,不得不说,pi最近的动作也越来越多了。具身智能之心第一时间解读了下,和大家分享下~原博客链接:https://www.pi.website/research/memory。

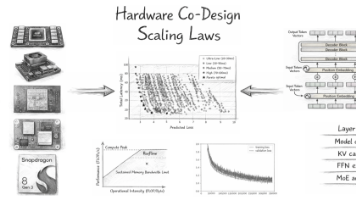

该研究的核心价值不仅在于实现了端侧 LLM 架构设计的效率与性能突破,更在于首次提出了可落地的端侧 LLM 硬件协同设计定律,构建了 “架构超参数-模型精度-硬件性能” 的统一建模框架,实现了从 “经验式设计” 到 “原理性优化” 的范式转变。建模跨越:首次将损失定律与 Roofline 硬件建模结合,实现了精度-延迟的显性映射,为多约束优化奠定基础;搜索跨越:提出 PLAS 框架,将架构搜索转化

3月2日,优理奇机器人(UniX AI) 宣布完成3亿元新一轮股权融资。中金汇融,洪山资本,广州产投,谢诺投资参与本轮融资,老股东吴中金控,涌铧投资持续超额追投。此次融资资金将主要用于公司深化软硬件全栈自研体系、加速产品迭代及全球渠道网络建设,推动“全栈机器人智能体”在真实商业场景的大规模应用落地。在去年的12月,优理奇刚完成两轮合计3亿元的融资,近日的新融资已经创下了三个月三轮的新速度。