简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

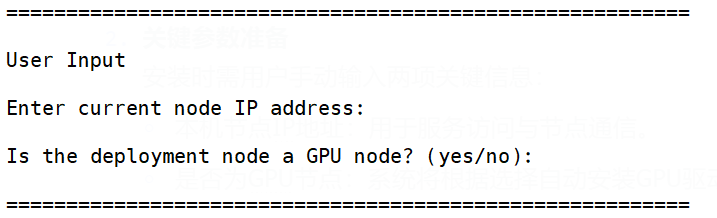

才真正体验到了“开箱即用”的畅快感。今天就以亲身经历,对比另一主流平台GPUStack,让大家体会一下什么才是真正的“大模型部署及管理神器”!,可以支持多个Ubuntu版本(22.04.2/20.04.6/18.04.6),这对无外网环境的金融/医疗等垂直行业客户堪称神器。作为一名长期奋战在AI开发一线的工程师,我曾被大模型部署的复杂性折磨到崩溃:环境配置、驱动冲突、分布式协调……部署时自动匹配推

才真正体验到了“开箱即用”的畅快感。今天就以亲身经历,对比另一主流平台GPUStack,让大家体会一下什么才是真正的“大模型部署及管理神器”!,可以支持多个Ubuntu版本(22.04.2/20.04.6/18.04.6),这对无外网环境的金融/医疗等垂直行业客户堪称神器。作为一名长期奋战在AI开发一线的工程师,我曾被大模型部署的复杂性折磨到崩溃:环境配置、驱动冲突、分布式协调……部署时自动匹配推

摘要:OpenStation与Dify组合架构解决了私有化AI部署中的三大痛点:模型管理碎片化、服务化成本高和应用迭代低效。二者深度集成后,可实现一键模型部署、自动流量分发和流式输出,形成从模型管理到应用发布的完整AI工程流水线。

本文介绍了OpenStation平台在本地化大模型应用中的完整技术闭环,包括模型服务部署、MCP工具管理和Agent联动三大核心模块。模型服务部署模块解决了"模型-资源-引擎"的匹配问题,支持从单机到分布式的高效推理;MCP工具模块提供预置和自定义工具能力,简化外部API调用;Agent管理模块将模型与工具绑定,实现智能决策。文章详细讲解了各模块的部署流程和技术细节,并通过天气

本文介绍了OpenStation+CozeStudio组合架构在AI私有化部署中的应用方案。该方案解决了模型管理分散、服务化成本高、应用迭代慢三大痛点:OpenStation负责模型本地化部署与全生命周期管理,CozeStudio实现可视化应用编排。文章详细展示了Qwen3模型部署流程、与CozeStudio的集成配置方法,并通过Agent智能体案例演示了从搭建到发布的完整流程。该组合架构通过标准

NVIDIA GPU Operator 摘要 NVIDIA GPU Operator 简化了 Kubernetes 集群中 GPU 资源的管理,通过容器化方式自动化部署和维护 GPU 驱动程序及相关组件。相比传统节点直装方式,其核心优势在于: 架构特点: 采用特权容器将驱动挂载到宿主机内核 通过 DaemonSet 实现批量部署和版本管理 严格匹配宿主机内核版本确保兼容性 功能亮点: 支持 vGP

OpenStation新版本针对大模型本地部署的两大痛点进行了优化:在模型生态方面,新增DeepSeek-V3、Moonshot等主流模型,实现多场景覆盖和即下即用,降低适配成本;在资源调度方面,支持单机/分布式部署的精细化GPU管理,避免资源浪费,提升利用率。新版本通过统一接口设计和卡级别性能校准,显著提升了部署效率和灵活性,为开发者提供了更便捷的本地部署解决方案。

OpenStation是一款专为大模型部署设计的全流程管理平台,提供从资源管理到服务上线的完整解决方案。平台支持CPU/GPU混合调度、模型断点续传、弹性伸缩服务等核心功能,可实现多节点分布式推理和精细化的资源控制。通过标准化API接口和WebUI集成,开发者能快速部署Qwen等主流大模型,并实现多租户权限管理。目前支持Ubuntu/CentOS系统,提供在线/离线两种部署方式,显著降低了大模型落

摘要:本文介绍如何利用OpenStation平台构建Confluence智能助手,解决开发团队知识管理痛点。通过部署Qwen3-1.7B模型、配置Confluence MCP工具和创建Agent服务,实现知识库的智能检索和分析。该方案无需编码,通过配置即可完成部署,将大模型推理能力与Confluence知识管理无缝融合,帮助团队从"人找信息"转向"信息找人"

面对上述那些实实在在的问题,OpenStation一站式大模型部署平台通过全自动化的安装流程与智能环境配置,无论是技术团队还是业务人员,都能在10分钟内完成从环境搭建到服务上线的全流程操作。:提供 在线 / 离线双部署模式,在线模式自动拉取最新依赖,离线模式支持断网环境下的完整部署(离线包已集成 10.1GB 的组件与镜像),从而解决离线部署困难问题。:企业内部生产环境常常严格隔离互联网,手动下载