简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

第一章:介绍了RAG的发展第二章:介绍了Transformer相关的基本原理,包括embedding、编码器、解码器等第三章:介绍了RAG环节里比较核心的文本向量化模型。首先介绍了和文本向量化模型比较相关的基础概念。然后介绍了一些稠密向量检索模型和稀疏检索模型。第四章:这一张比较琐碎,内容也比较多:(1)在RAG场景下的提示词技巧。(2)文本切块方法,包含基于规则的以及基于模型的。(3)向量数据库

西瓜书无疑是机器学习的必读书籍。本书作为该领域的入门教材,在内容上尽可能涵盖机器学习基础知识的各方面。

大模型火了之后,相信不少人都在尝试将预训练大模型应用到自己的场景上,希望得到一个垂类专家,而不是通用大模型。目前的思路,一是RAG(retrieval augmentedgeneration),在模型的输入prompt中加入尽可能多的“目标领域”的相关知识,引导模型在生成时尽量靠拢目标领域,运用prompt中给予的目标知识;二是有监督微调,用适量的专业领域的数据(或混通用语料)让模型更能生成目标场

RAG,即检索增强生成(Retrieval-Augmented Generation),是一种先进的自然语言处理技术架构,它旨在克服传统大型语言模型(LLMs)在处理开放域问题时的信息容量限制和时效性不足。RAG的核心机制融合了信息检索系统的精确性和语言模型的强大生成能力,为基于自然语言的任务提供了更为灵活和精准的解决方案。

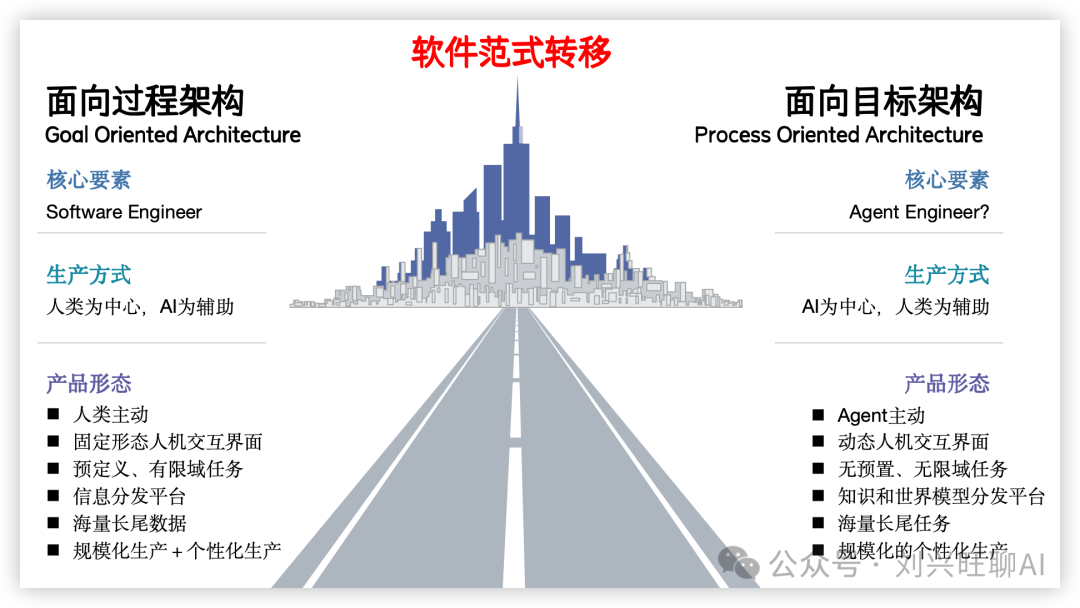

在这个大模型飞速发展、AI编程日益强大的时代,似乎到处都在喊:“程序员要失业了!”再加上经济下行、就业寒冬、35岁危机,感觉人生已经到达了高潮。但别慌,听我给你掰扯掰扯,如何在这个风口浪尖上乘风破浪,稳住我们的小饭碗。

人们听说大模型已经有两年多了,不少人自己测试了对话。但舆论对于大模型还是有很多误解,应用时摸不清特性,一不小心就上当,更不知道大模型是怎么开发出来的。性能顶级的Deepseek火爆开源之后,意想不到的事发生了,人们居然很简单地就把大模型部署用上了!一个朋友,在3000多元的联想lecoo酷310 PC机上,就安装Deepseek R1成功了。机器配置不高,装的是7B(70亿)参数的版本,聊天能力明

1.Llama 3 介绍Llama 3是由Meta公司发布的大型语言模型,其在多个关键基准测试中性能优于业界先进同类模型,尤其在代码生成等任务上实现了全面领先。Llama 3在技术层面实现了显著的突破。它采用了更为先进的预训练策略,使其在理解自然语言方面的能力得到了显著提升。此外,Llama 3还优化了其解码器,使得生成的文本更具逻辑性与连贯性。这些改进使得Llama 3在对话生成、问答系统等应用

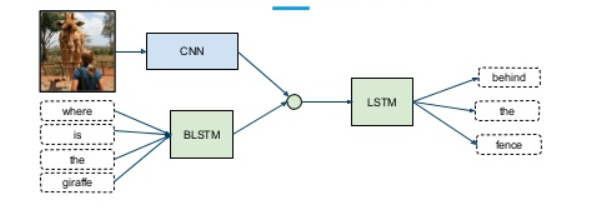

我们对世界的体验是多模态的 —— 我们看到物体,听到声音,感觉到质地,闻到气味,尝到味道。模态是指某件事发生或经历的方式,当一个研究问题包含多个模态时,它就具有多模态的特征。为了让人工智能在理解我们周围的世界方面取得进展,它需要能够同时解释这些多模态的信号。例如,图像通常与标签和文本解释相关联,文本包含图像,以更清楚地表达文章的中心思想。不同的模态具有非常不同的统计特性。这些数据被称为多模态大数据

这篇仅是开坑哈,后面会持续更新的~主旨就是想要在滚滚浪潮中帮助AI开发者发现、汇聚到简单、好用的AI大模型平台&开发者社区上来,共建国内繁荣AIGC生态!!有些规模太小、不好用、吃相太难看(没几个模型就要走付费变现路子的)的平台我就先不放上来啦。

包含无数组件的接口和集成、将这些组件组合成链和代理的基本运行时,以及链和代理的现成实现。LangSmith:一个开发者平台,可让您调试、测试、评估和监控基于任何 LLM 框架构建的链,并与 LangChain 无缝集成。现成的链(Off-the-shelf chains):用于完成更高级别任务的内置组件组合,约定大于配置,让您可以轻松上手。当用户向基于LangChain的聊天机器人输入提示(pro