简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

http://blog.csdn.net/pipisorry/article/details/52269952PyCharm提供两种远程调试(Remote Debugging)的方式: 配置远程的解释器(remote interpreter) 配置Python调试服务器(Python Debug Server)[配置Python调试服务器]本文主要说明远程的解释器(remote int

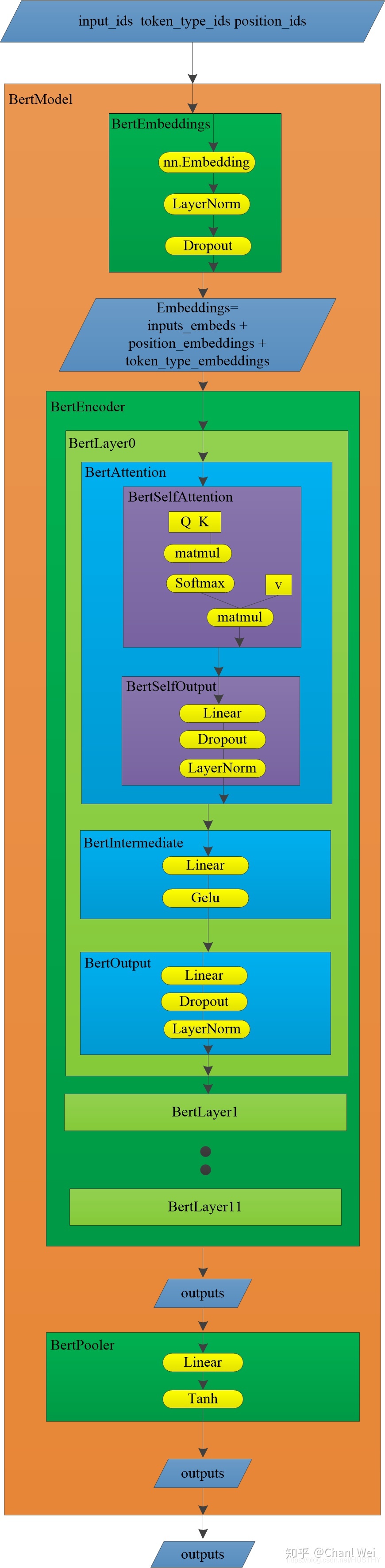

BERT出自的全称是Bidirectional Encoder Representation from Transformers,即双向Transformer的Encoder。作为一个Word2Vec的替代者,其在NLP领域的11个方向大幅刷新了精度,可以说是近年来自残差网络最优突破性的一项技术了。模型的主要创新点都在pre-train方法上,即用了Masked LM和Next Sentence

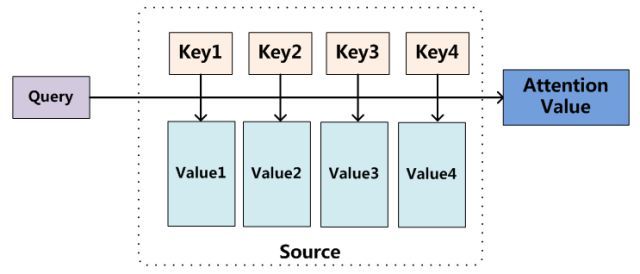

注意机制最早由Bahdanau等人于2014年提出(统计机器翻译中的对齐过程[NEURAL MACHINE TRANSLATION BY JOINTLY。

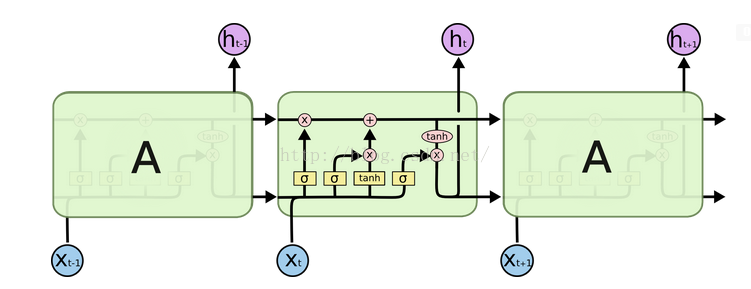

几种RNNs并不能很好的处理较长的序列。一个主要的原因是,RNN在训练中很容易发生梯度爆炸和梯度消失,这导致训练时梯度不能在较长序列中一直传递下去,从而使RNN无法捕捉到长距离的影响。

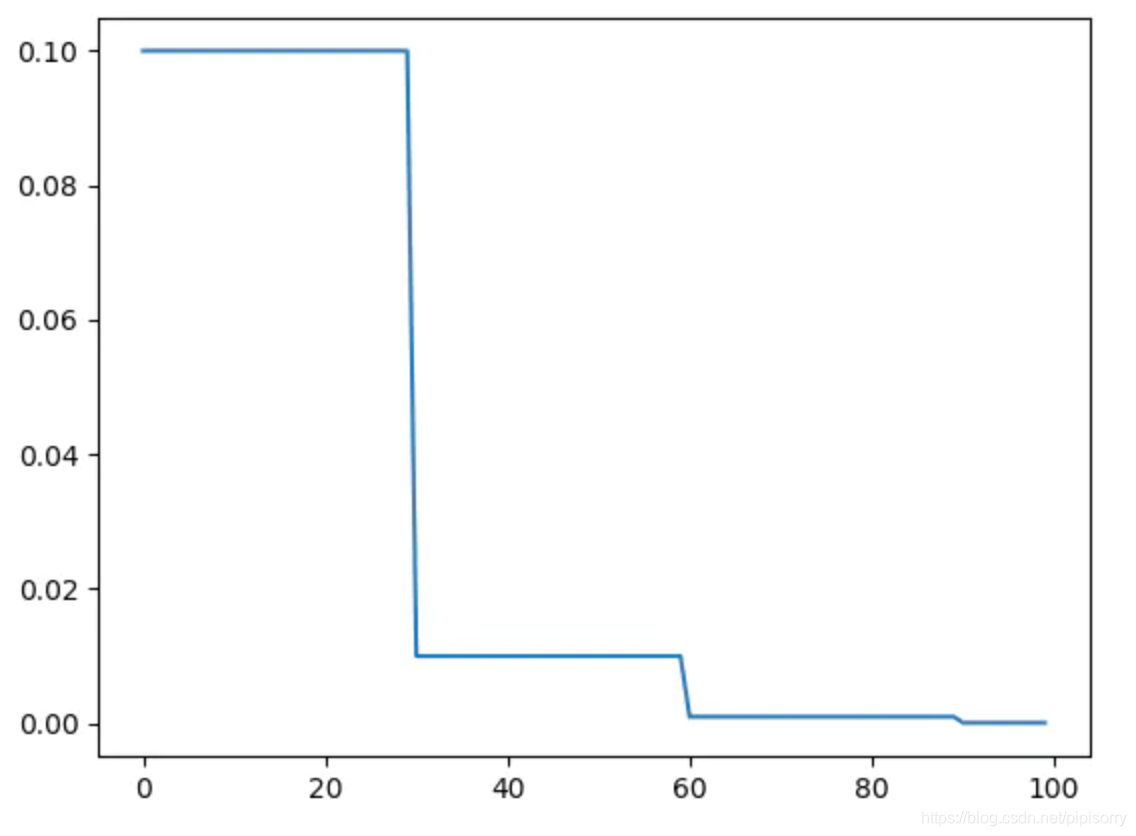

-柚子皮-学习率衰减import torch.optim as optimfrom torch.optim import lr_scheduler# 训练前的初始化optimizer = optim.Adam(net.parameters(), lr=0.001)#学习率衰减scheduler = lr_scheduler.StepLR(optimizer, 10, 0.1) # # 每过10个e

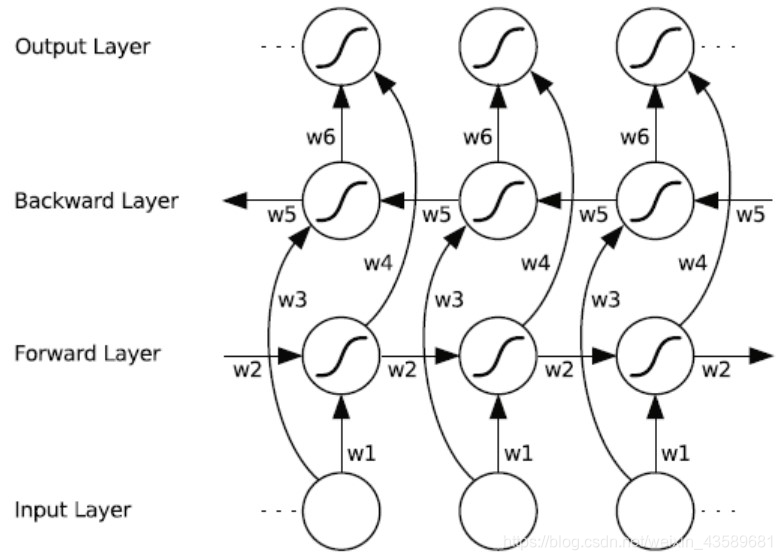

这里三条黑线就是所谓的 peephole,传统的 LSTM 中遗忘门、输入门和输出门只用了 h(t-1) 和 xt 来控制门缝的大小,peephole 的意思是说不但要考虑 h(t-1) 和 xt,也要考虑 Ct-1 和 Ct,其中遗忘门和输入门考虑了 Ct-1,而输出门考虑了 Ct。RNN和LSTM都只能依据之前时刻的时序信息来预测下一时刻的输出,但在有些问题中,当前时刻的输出不仅和之前的状态有

http://

http://blog.csdn.net/pipisorry/article/details/76095118词嵌入词嵌入其实就是将数据的原始表示表示成模型可处理的或者是更dense的低维表示(lz)。One-hot Embedding假设一共有个物体,每个物体有自己唯一的id,那么从物体的集合到有一个trivial的嵌入,就是把它映射到中的标准基,这种嵌入叫做On...

http://blog.csdn.net/pipisorry/article/details/53257188弹性分布式数据集RDD(Resilient Distributed Dataset)创建RDD并行集合 (Parallelized collections)RDD可从现有的集合创建。比如在Scala shell中:val collection = List("a", "b", "c", "

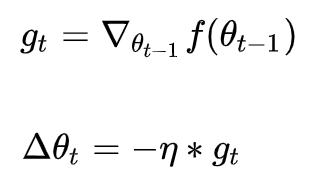

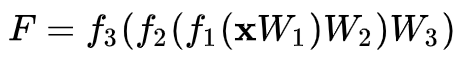

http://blog.csdn.net/pipisorry/article/details/52135832深度学习最优化算法深度学习框架中常见的最优化方法,如tensorflow中的最优化方法及相关参数如下:tf.train.Optimizertf.train.GradientDescentOptimizertf.train.AdadeltaOptimizertf.tr...