简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

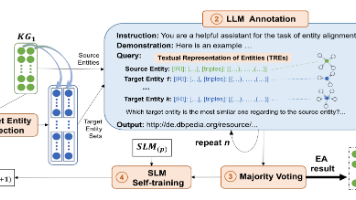

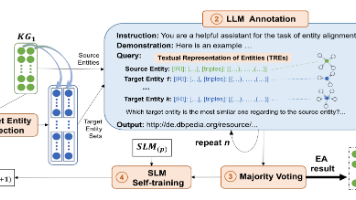

实体对齐(EA)对整合多源知识图谱(KG)至关重要。传统无监督EA方法试图消除人工干预,但常受限于准确率。随着大语言模型(LLM)兴起,利用其能力实现EA成为新方向,但面临两大挑战:如何构建基于LLM的EA问题框架,以及如何提取LLM中的背景知识实现无人工干预的EA。本文提出HLMEA——基于混合语言模型的无监督EA方法,将EA任务构建为筛选-单选问题,协同整合小语言模型(SLM)与LLM:SLM

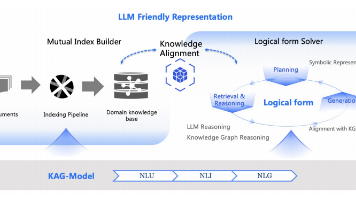

KAG框架通过知识增强生成技术显著提升大语言模型在专业领域的表现。该框架创新性地融合知识图谱与检索增强生成技术,提出五项核心设计:LLM友好的知识表示、图谱与文本块互索引、逻辑形式引导的混合推理引擎、语义推理对齐的知识校准以及KAG模型能力增强。实验表明,KAG在多跳问答任务中表现优异,HotpotQA和2Wiki数据集上F1值分别提升19.6%和33.5%。目前已在政务和医疗专业问答场景成功应用

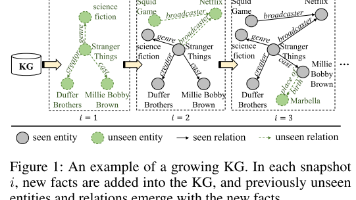

本文提出了一种终身知识图谱嵌入模型LKGE,用于处理不断增长的知识图谱。针对现有KG嵌入模型仅适用于静态图谱的局限性,该研究设计了遮蔽KG自动编码器进行嵌入学习与更新,通过嵌入迁移策略实现知识传递,并采用嵌入正则化防止灾难性遗忘。实验基于四种不同增长模式的数据集,结果表明LKGE在链接预测准确率、知识迁移能力和学习效率方面均优于现有方法。该模型能够有效适应新知识同时保留旧知识,为动态知识图谱应用提

实体对齐(EA)对整合多源知识图谱(KG)至关重要。传统无监督EA方法试图消除人工干预,但常受限于准确率。随着大语言模型(LLM)兴起,利用其能力实现EA成为新方向,但面临两大挑战:如何构建基于LLM的EA问题框架,以及如何提取LLM中的背景知识实现无人工干预的EA。本文提出HLMEA——基于混合语言模型的无监督EA方法,将EA任务构建为筛选-单选问题,协同整合小语言模型(SLM)与LLM:SLM

2021年英语六级作文(附翻译)2021年6月第1套:城市化作文题目:Directions: For this part, you are allowed 30 minutes to write an essay based on the graph below. You should start your essay with a brief description of the graph

实体对齐旨在识别来自不同知识图谱(KG)的等效实体对,这对于集成多源知识图谱至关重要。最近,随着 GNN 在实体对齐中的引入,近期模型的架构变得越来越复杂。我们甚至在这些方法中发现了两个反直觉的现象:(1)GNN 中的标准线性变换效果不佳。(2)许多为链接预测任务设计的先进知识图谱嵌入模型在实体对齐方面表现不佳。在本文中,我们将现有的实体对齐方法抽象为一个统一的框架,它不仅成功地解释了上述现象,而

实体对齐是知识图谱(KG)集成中一项基本且重要的技术。多年来,实体对齐的研究一直基于知识图谱是静态的假设,忽略了现实世界知识图谱增长的本质。随着知识图谱的增长,之前的对齐结果需要重新审视,同时新的实体对齐等待被发现。在本文中,我们提出并深入研究了一个现实但尚未探索的环境,称为持续实体对齐。为了避免每当新实体和三元组出现时在整个 KG 上重新训练整个模型,我们为此任务提出了一种持续对齐方法。它根据实