简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Failed to configure a DataSource: 'url' attribute is not specified and no embedded datasource could be configured.

位运算符主要是以二进制规则进行运算1.与(&)运算符使用规则:两个二进制操作数对应位同为1 结果位 才为1,其余情况为0;例如:整数 a = 15 整数 b = 127计算:(a & b)15的二进制位:0000 1111127的二进制为:0111 1111即:(a & b) = 152.或(|)运算符使用规则:两个二进制操作数对应位只要有一个为1 结果位 就为1,其余

往hive分区表中插入数据时,如果需要创建的分区很多,比如以表中某个字段进行分区存储,则需要复制粘贴修改很多sql去执行,效率低。因为hive是批处理系统,所以hive提供了一个动态分区功能,其可以基于查询参数的位置去推断分区的名称,从而建立分区。1、创建一个单一字段分区表hive>create table dpartition(id int ,name string )partitione

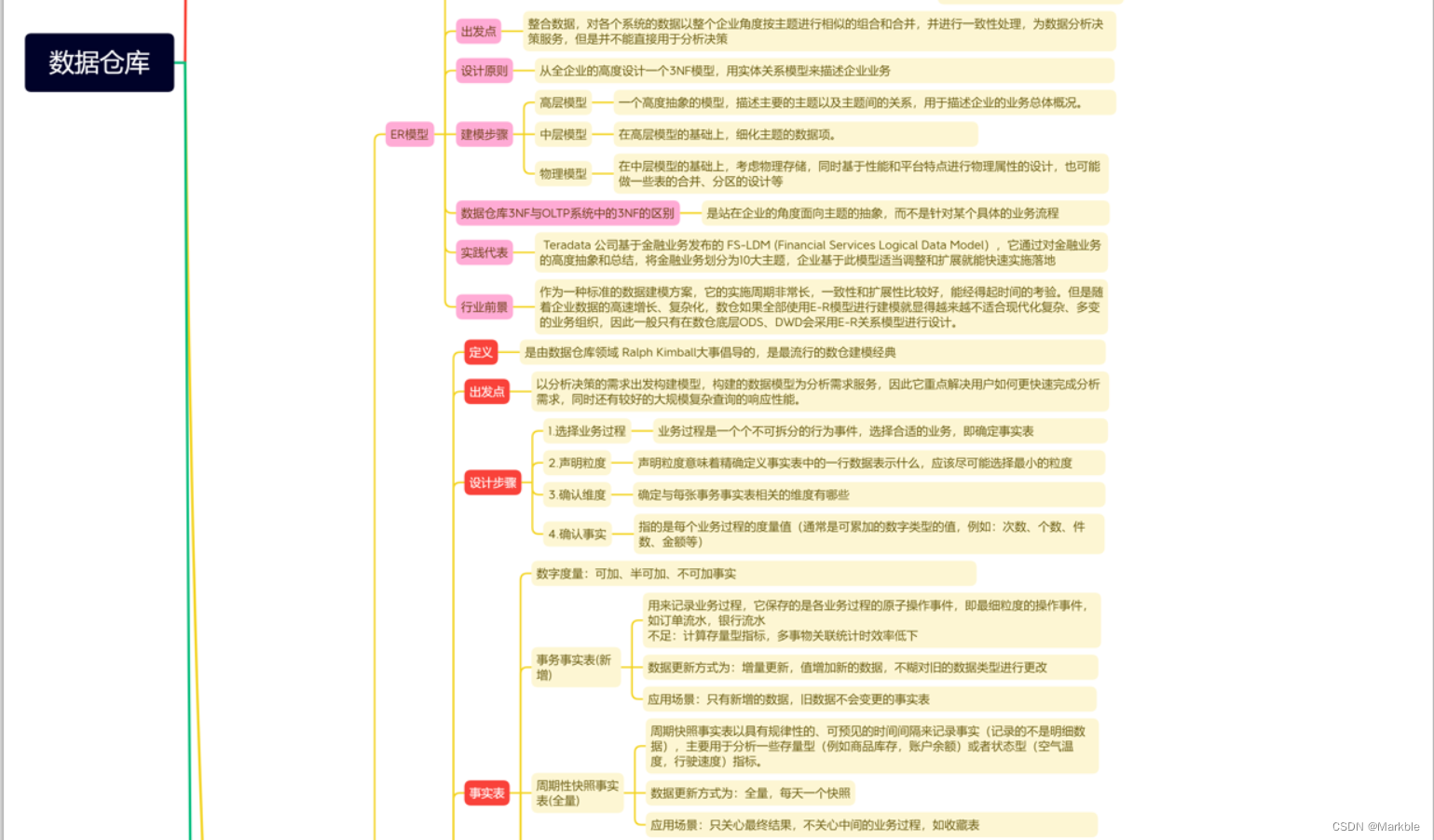

数据仓库基础知识,包含维度建模中事实表、维度表、模型的详细说明

一张图全方位了解数据仓库的相关知识

数据仓库-元数据管理详解

数据仓库-数据质量管理

数据仓库基础知识,包含维度建模中事实表、维度表、模型的详细说明

一、原理流程图拦截器链 Intercepter:进行简单的数据清洗和过滤如果只有一个Sink和一个Channel的话那就直接传过来了如果有多个Sink的话想要接受Channel的的数据必须要经过Sink组(也即是SinkProcessor),然后SinkProcessor启动sink,sink不断到channel中去轮询,将channel中的event事件拿过来。注意:同一个sink组(好多个si

数据治理贯穿数仓中数据的整个生命周期,从数据的产生、加载、清洗、计算,再到数据展示、应用,每个阶段都需要对数据进行治理,像有些比较大的企业都是有自己的数据治理平台或者会开发一些便捷的平台,对于没有平台的公司,这里根据自己的亲身实践简单整理一下。