简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

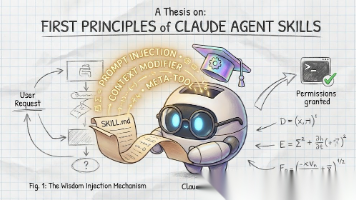

文章解析Claude Agent Skills的第一性原理:基于提示词的动态上下文注入与元工具架构。Skills不是可执行代码,而是通过Markdown指令"植入"模型,实现动态加载专家能力。文章从本质、架构、机制和流程四个维度剖析,揭示如何通过"元工具"将静态知识转化为动态上下文,实现功能无限扩展和按需加载。

文章总结了智能体(Agent)开发的19条实战经验,强调业务需求与实际实现间的差异。核心观点包括:明确业务真正需要的是"稳定"而非完全自动化;知识库构建需注重可检索性而非规模;意图识别需考虑测试与真实诉求区别;必须建立完善的评测体系和badcase库;确定性逻辑应优先于完全依赖模型;交付时需提供完整运营机制而非仅功能。这些经验对构建稳定、可控、实用的智能体系统具有重要指导价值。

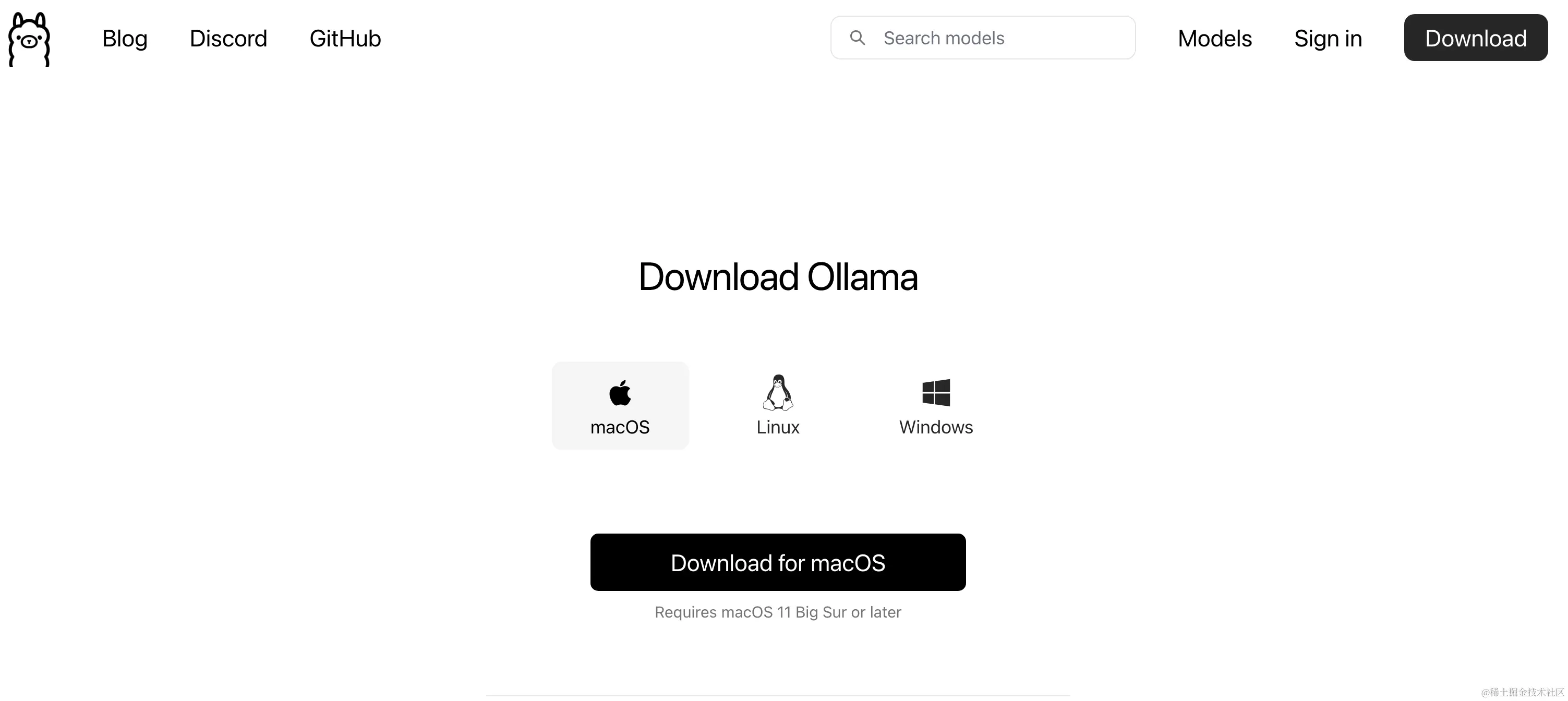

在当前的技术环境下,大型语言模型(LLMs)已经成为人工智能领域的一个重要里程碑。这些模型能够在各种任务上展现出人类水平的性能,包括但不限于文本生成、语言理解和问题解答。随着开源项目的发展,个人开发者现在有机会在本地部署这些强大的模型,以探索和利用它们的潜力。本文将详细介绍如何使用Ollama,一个开源项目,在Mac上本地运行大型模型(Win同理)。通过遵循以下步骤,即使是配备了几年前硬件的电脑,

在当前的技术环境下,大型语言模型(LLMs)已经成为人工智能领域的一个重要里程碑。这些模型能够在各种任务上展现出人类水平的性能,包括但不限于文本生成、语言理解和问题解答。随着开源项目的发展,个人开发者现在有机会在本地部署这些强大的模型,以探索和利用它们的潜力。本文将详细介绍如何使用Ollama,一个开源项目,在Mac上本地运行大型模型(Win同理)。通过遵循以下步骤,即使是配备了几年前硬件的电脑,

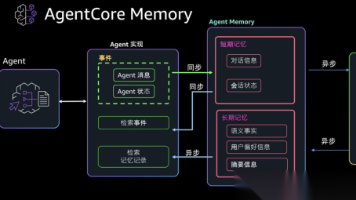

文章介绍智能体持久性记忆系统的实现,通过双路记忆堆栈(情节记忆+语义记忆)解决智能体"健忘"问题。使用向量数据库存储对话历史,图数据库管理实体关系,实现"交互-检索-生成-编码"闭环。提供完整代码实现,使智能体能够记住用户信息并提供深度个性化交互,从"工具"转变为"伴侣"。

文章介绍智能体持久性记忆系统的实现,通过双路记忆堆栈(情节记忆+语义记忆)解决智能体"健忘"问题。使用向量数据库存储对话历史,图数据库管理实体关系,实现"交互-检索-生成-编码"闭环。提供完整代码实现,使智能体能够记住用户信息并提供深度个性化交互,从"工具"转变为"伴侣"。

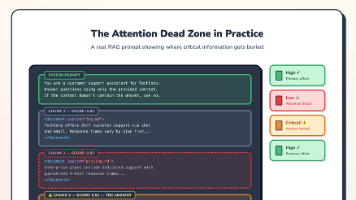

文章揭示RAG系统成败关键在于检索与生成之间的"增强层"。大模型对上下文位置有偏好效应,检索后处理管道(过滤、重排序、去重)至关重要,提示词架构影响模型表现。优化建议包括混合搜索、控制文本块数量、利用位置效应等,这些细节常被忽视,却是提升性能的关键。

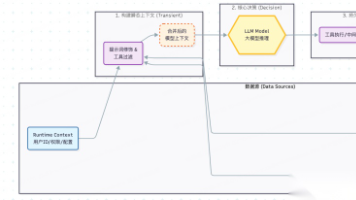

文章介绍了LangChain框架中通过上下文工程构建可靠AI智能体的方法。从数据来源(运行时上下文、状态、存储)和生命周期(瞬态上下文和持久上下文)两个维度详细解释了上下文的类型和使用方法。瞬态上下文通过中间件动态调整模型调用参数,持久上下文通过工具回写和生命周期管理实现智能体的连续性学习。最后提供了实用的避坑指南,帮助开发者构建生产级的上下文管道。

本文系统梳理了AI大模型的14个核心概念,从基础架构(Transformer)、数据处理(Token与Embedding)到训练优化(预训练、微调、对齐),再到前沿应用(RAG、Agent、MCP等)。文章深入浅出地解释了大模型如何实现"智能涌现",并探讨了幻觉问题、提示工程等关键技术挑战。这些相互关联的概念共同构成了现代大模型技术全景图,是理解AI发展路径的重要基石,适合小白和程序员系统学习大模

本文系统梳理了大模型技术发展历程,从1950年代符号主义开始,经历统计机器学习、神经网络革命,到2017年Transformer架构突破,再到预训练范式确立、规模扩张与多模态融合。文章详细分析了架构演进逻辑、训练技术突破及能力跃迁轨迹,并探讨当前挑战与未来方向,为理解大模型技术发展提供了全面视角。