简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

物联网(IoT)体系结构通常分为四层架构(感知层、网络层、平台层、应用层),每层承担特定功能,并通过协同工作实现万物互联。物联网的体系结构通过分层解耦,结合开源生态的持续创新(如边缘AI、5G融合),正推动从工业自动化到智慧生活的全域智能化升级。:感知层设备易受攻击(如僵尸网络),需结合TLS加密(OpenSSL)及设备认证。:采集物理世界数据(如温度、位置、图像),并转换为数字信号。

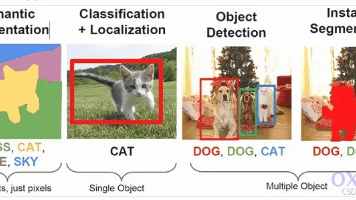

YOLO)是基于深度神经网络的目标检测算法,用在图像或视频中实时识别和定位多个对象。YOLO的主要特点是速度快且准确度较高,能够在实时场景下实现快速目标检测。YOLO是一种快速而准确的目标检测算法,被广泛应用于计算机视觉领域,包括实时视频分析、自动驾驶、安防监控、智能交通、缺陷检测等。在YOLO诞生之前,目标检测领域热门的深度学习模型是R-CNN系列模型,称之为二阶段模型(two-stage),其

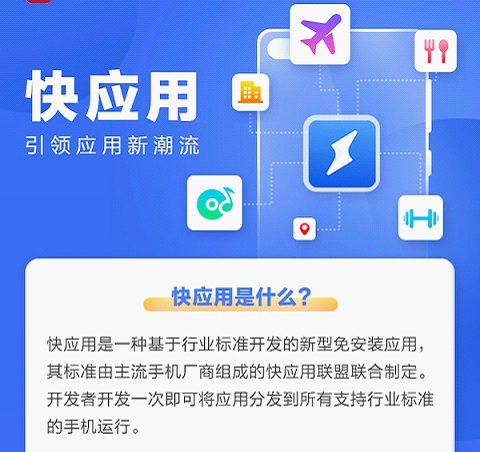

九大厂商同时宣布建立即时应用生态发展联盟,通过统一标准让开发者低成本接入,“快应用”在研发接口、场景接入、服务能力和接入方式上建设标准平台,以平台化的生态模式对个人开发者和企业开发者全品类开放。此次九大厂商共建“快应用”标准和平台,最大化降低了开发者的开发和推广成本,有了该标准,开发者可以做到一次性开发,在各厂商的手机上都能运行,极大地减少了开发者的成本。

受益于开源技术的发展,以及响应快速开发的实际业务需求,跨平台开发不仅限于移动端跨平台,桌面端虽然在市场应用方面场景不像移动端那么丰富,但也有市场的需求。相对于个人开发者而言,跨平台框架的使用,主要为了满足以下三个主要能力:1)生产力提升:框架能够帮助开发者实现快速开发,这是降本增效的根本。如果不能实现「快速」,那也就比自己从零开始写代码快不了太多了。2)框架打包后的体积轻量:开发者大部分是普通用户

NVIDIA 驱动是一种专门为 NVIDIA GPU(图形处理单元)设计的软件,它是计算机系统与 NVIDIA GPU 之间的桥梁。NVIDIA 驱动使操作系统能够识别并与 GPU 通信,从而发挥 GPU 的全部功能和性能。它包含了控制 GPU 运行、优化图形性能、提供 API 支持等关键组件。没有合适的驱动程序,GPU 就无法正常工作。nvidia-smi 是 NVIDIA 官方提供的一个命令行

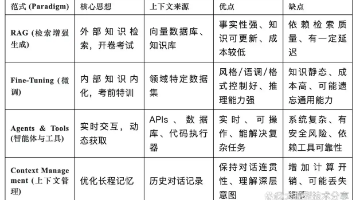

在实践中,最先进的AI应用(如 Palantir AIP、Databricks Mosaic AI Agent Framework 等)往往会融合以上所有范式,构建出一个能够根据任务需求,灵活地检索静态知识、调用实时工具、并保持长程对话记忆的复杂系统。百度安全验证。

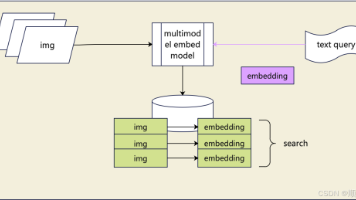

通用多模态检索(UMR)——简单说,就是用一个统一模型,实现“文本、图像、视频”等不同类型信息的跨模态搜索(比如“文搜图”“图搜视频”“图文组合搜内容”)。它的核心原理很直观:通过多模态表征模型,把文本、图片、视频这些“不同语言”的信息,统一转换成计算机能理解的“高维浮点数向量”(可以想象成一串带语义的数字密码)。这些向量被放进同一个“语义空间”后,就能通过计算“余弦相似度”,快速判断不同模态内容

通过上述方法,您可以在保持视频内容完整性的前提下,高效地将3-15分钟的视频转化为适合Qwen2.5 VL 32B理解的多模态输入,实现对视频内容的准确分析和理解。1)定码率抽帧存储技术,在高清监控中,将帧率从25帧/秒降低至8帧/秒(约12.5秒/帧)可显著节省存储空间。2)对于静态内容较多的视频(如会议记录),可适当延长抽帧间隔(如每8-10秒抽1帧)1)对于动作密集的视频(如体育赛事),可适

更新时间:2025/03/20说明配置项取值请参考《MindIE安装指南》中“配置MindIE > 配置MindIE Server >”章节的步骤3。系统读取配置文件时,会先校验文件大小,若文件大小范围不在(0MB, 10MB],将读取失败。

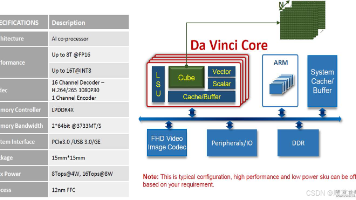

昇腾AI处理器本质上是一个片上系统(System on Chip,SoC),主要可以应用在和图像、视频、语音、文字处理相关的应用场景。其主要的架构组成部件包括特制的计算单元、大容量的存储单元和相应的控制单元。该芯片大致可以划为:芯片系统控制CPU(Control CPU),AI计算引擎(包括AI Core和AI CPU),多层级的片上系统缓存(Cache)或缓冲区(Buffer),数字视觉预处理模