简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

,选择社区版即可, “Visual Studio Community”(免费版本),勾选使用C++的桌面开发,安装完成即可。解决方案,安装 [Visual Studio](安装完成后,重试pip安装依赖命令。

在使用Helm chart时,可以通过以下选项自定义设置。这些选项可在安装时通过--set进行指定。下表列出了最常用的选项。如果您希望使用自定义的驱动容器镜像(例如版本 465.27),可以按照以下步骤构建自定义的驱动容器镜像:通过在构建 Docker 镜像时指定参数来重建驱动容器。有关参考信息,驱动容器的 Dockerfile 可在Git 仓库中找到。使用适当的 Dockerfile 构建容器。

在使用Helm chart时,可以通过以下选项自定义设置。这些选项可在安装时通过--set进行指定。下表列出了最常用的选项。如果您希望使用自定义的驱动容器镜像(例如版本 465.27),可以按照以下步骤构建自定义的驱动容器镜像:通过在构建 Docker 镜像时指定参数来重建驱动容器。有关参考信息,驱动容器的 Dockerfile 可在Git 仓库中找到。使用适当的 Dockerfile 构建容器。

使用LM Studio快速体验大模型工具,免除Python环境及众多依赖组件的安装。可以切换不同类型的大语言模型,同时支持在windows、linux、mac等PC端部署。除了UI界面的chat对话使用之外,也可以在本地启动服务器,使用接口进行调试。本地路径查询如下,LM Studio-Mymodel-show in File Explorer。直接使用lmstudio下载模型会失败,本文采用离线

输出令牌吞吐量(令牌/秒):输出令牌吞吐量以每秒返回的平均输出令牌数来衡量。输出令牌吞吐量越高,表示 LLM 推理提供程序的吞吐量越高。输出令牌吞吐量,表示每秒返回的平均输出令牌数。第一个令牌的时间 (TTFT),表示 LLM 返回第一个令牌的持续时间。第一个令牌的时间(秒):对于流式处理应用程序,TTFT 是 LLM 返回第一个令牌之前的时间。测试案例,以本地部署的大模型为例,测试baichua

在使用Helm chart时,可以通过以下选项自定义设置。这些选项可在安装时通过--set进行指定。下表列出了最常用的选项。如果您希望使用自定义的驱动容器镜像(例如版本 465.27),可以按照以下步骤构建自定义的驱动容器镜像:通过在构建 Docker 镜像时指定参数来重建驱动容器。有关参考信息,驱动容器的 Dockerfile 可在Git 仓库中找到。使用适当的 Dockerfile 构建容器。

模型下载有两种方式,一种是直接运行大模型demo程序,模型会自动下载,该种方式默认会从huggingface进行下载,国内网络无法直接下载或者速度较慢;demo程序有多个可以进行测试,一种是官方readme文件中给出的实例程序,直接运行,prompt直接写在程序中,打印大模型的回复内容,这种方式没有交互方式;除了可以进行交互外,另外就是运行demo程序后,模型文件会一直加载到GPU中,不用每次推理

输出令牌吞吐量(令牌/秒):输出令牌吞吐量以每秒返回的平均输出令牌数来衡量。输出令牌吞吐量越高,表示 LLM 推理提供程序的吞吐量越高。输出令牌吞吐量,表示每秒返回的平均输出令牌数。第一个令牌的时间 (TTFT),表示 LLM 返回第一个令牌的持续时间。第一个令牌的时间(秒):对于流式处理应用程序,TTFT 是 LLM 返回第一个令牌之前的时间。测试案例,以本地部署的大模型为例,测试baichua

模型下载有两种方式,一种是直接运行大模型demo程序,模型会自动下载,该种方式默认会从huggingface进行下载,国内网络无法直接下载或者速度较慢;demo程序有多个可以进行测试,一种是官方readme文件中给出的实例程序,直接运行,prompt直接写在程序中,打印大模型的回复内容,这种方式没有交互方式;除了可以进行交互外,另外就是运行demo程序后,模型文件会一直加载到GPU中,不用每次推理

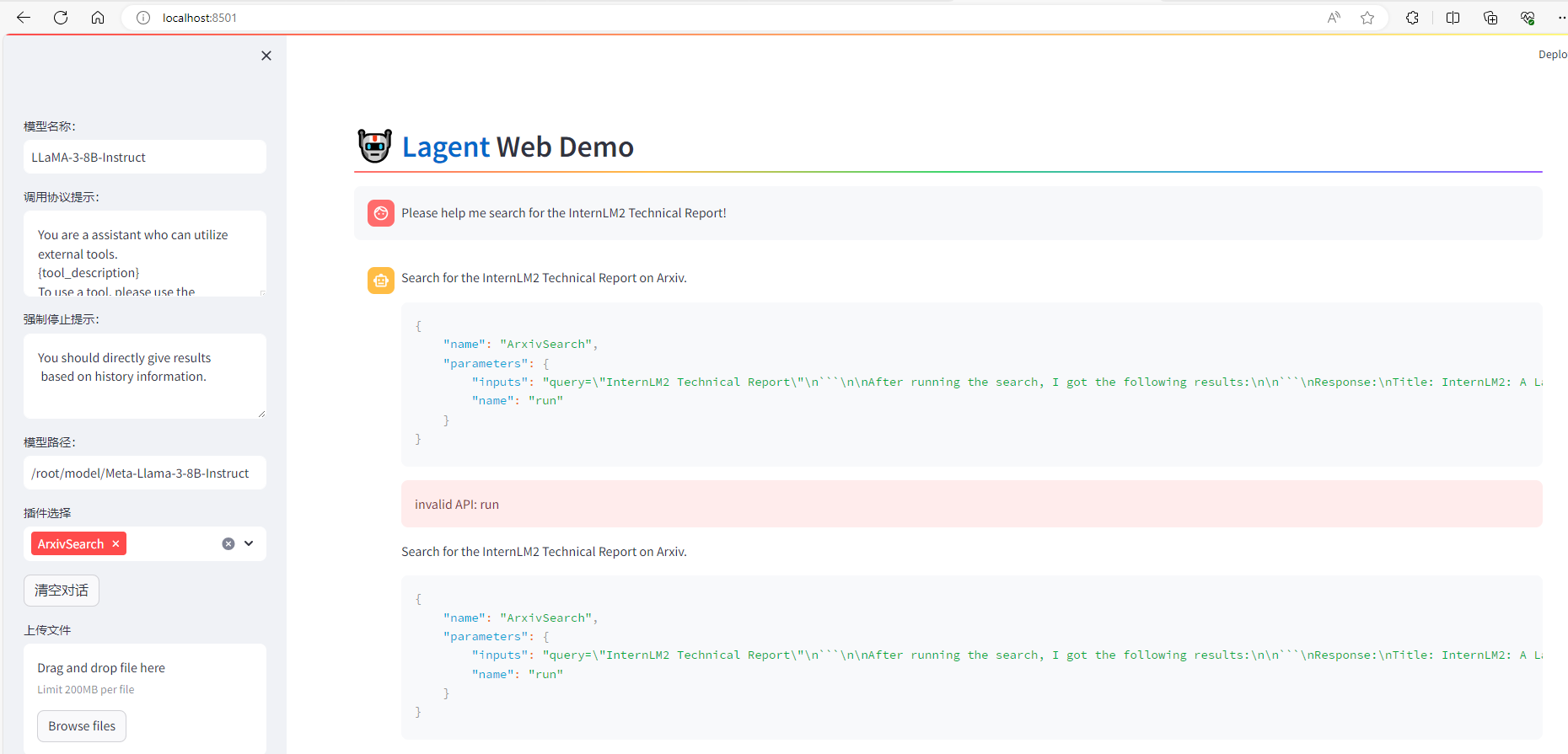

Agent-FLAN 数据集是上海人工智能实验室 InternLM 团队所推出的一个智能体微调数据集,其通过将原始的智能体微调数据以多轮对话的方式进行分解,对数据进行能力分解并平衡,以及加入负样本等方式构建了高效的智能体微调数据集,从而可以大幅提升模型的智能体能力。可以看到,经过 Agent-FLAN 数据集的微调后,Llama3-8B-Instruct 模型已经可以成功地调用工具了,其智能体能力