简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

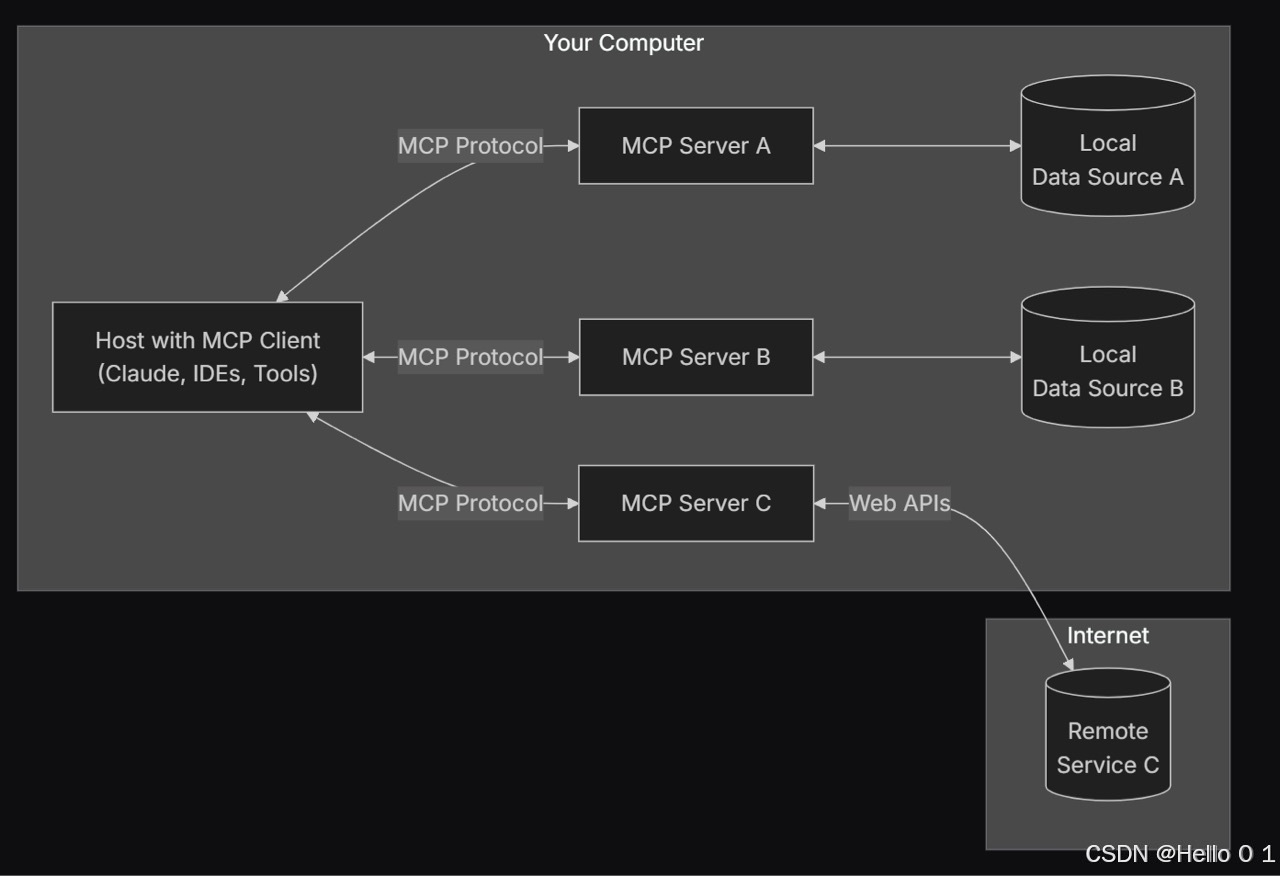

MCP(Model Context Protocol)是一种创新的通信协议,旨在让大型语言模型能够安全、高效地与外部资源进行交互。在AI技术快速发展的今天,MCP正成为连接AI与现实世界的重要桥梁。本文以自己开发的fetch_news MPC Server为例 ,基于MCP(Model Control Protocol)框架开发的新闻获取和分析服务器,专门用于获取最新新闻、搜索特定主题的新闻,并对

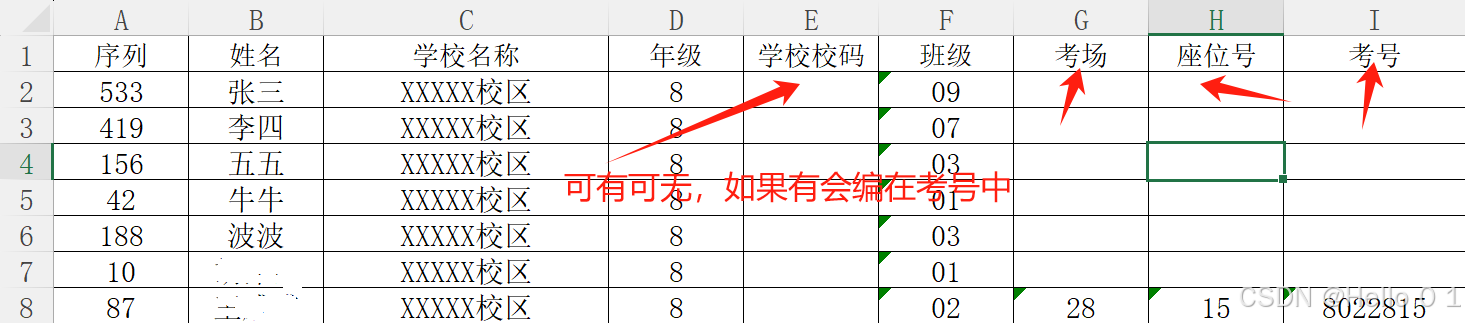

昨天,同事找到我,说要进行考场分配,并提出了相关要求。我便尝试让 DeepSeek 来帮忙,不管是用 VBA 还是 Python 代码,它却都没能解决问题。当时我忍不住吐槽了 DeepSeek(DS),可事后心里实在过意不去,毕竟投入了不少精力在它上面,就像自己的孩子,再怎么不好也是心头爱。今天早上,我不服输,重新仔细修改了 prompts,想让 DS 编写一个能用于考场分配的 VBA 程序,方

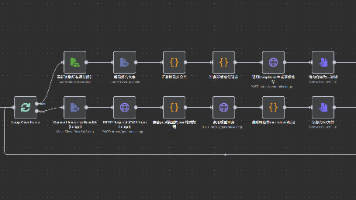

文章摘要: 本文介绍如何利用n8n低代码平台和Google Gemini AI搭建英语作文自动批改系统。系统采用"OCR+LLM"两阶段处理模式:先通过AI识别手写作文并转换为电子文本,再由大语言模型根据预设标准进行评分;最后汇总班级数据生成学情分析报告。教程详细讲解了Docker环境下的n8n部署步骤,包括文件夹创建、容器启动等操作,并解析了工作流中各节点的功能,如表单触发、

文章摘要: 本文介绍如何利用n8n低代码平台和Google Gemini AI搭建英语作文自动批改系统。系统采用"OCR+LLM"两阶段处理模式:先通过AI识别手写作文并转换为电子文本,再由大语言模型根据预设标准进行评分;最后汇总班级数据生成学情分析报告。教程详细讲解了Docker环境下的n8n部署步骤,包括文件夹创建、容器启动等操作,并解析了工作流中各节点的功能,如表单触发、

文章摘要: 本文介绍如何利用n8n低代码平台和Google Gemini AI搭建英语作文自动批改系统。系统采用"OCR+LLM"两阶段处理模式:先通过AI识别手写作文并转换为电子文本,再由大语言模型根据预设标准进行评分;最后汇总班级数据生成学情分析报告。教程详细讲解了Docker环境下的n8n部署步骤,包括文件夹创建、容器启动等操作,并解析了工作流中各节点的功能,如表单触发、

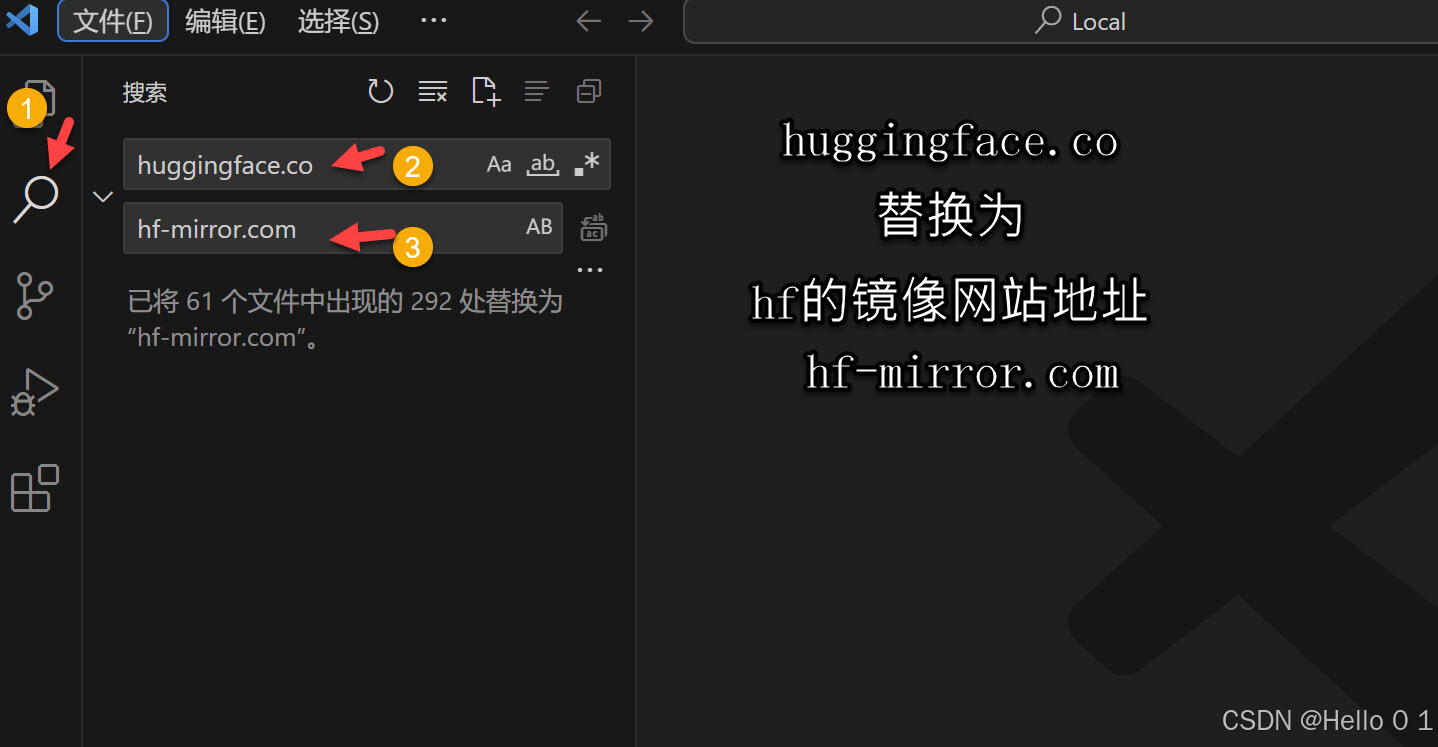

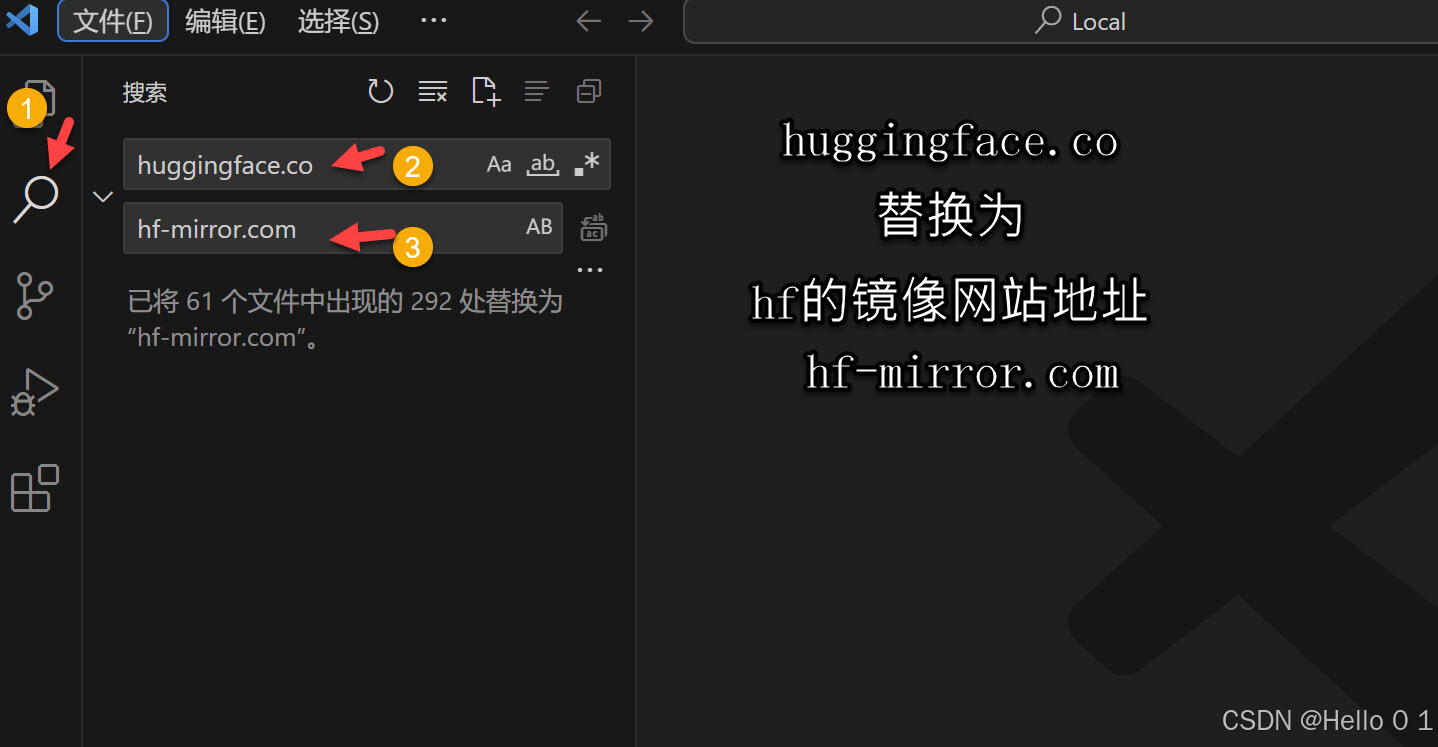

LM Studio 模型搜索Error: fetch failed 的处理

LM Studio 模型搜索Error: fetch failed 的处理

通过手势识别实现了控制 PowerPoint 播放幻灯片的功能。在识别到特定手势("Open_Palm")时,会模拟按下 "Page Down" 键,从而使幻灯片向下翻页。同时,通过 PyAutoGui() 控制鼠标和键盘进行交互操作。整个流程包括捕获视频帧、进行手势识别、根据识别结果执行相应操作等步骤。原项目帮助文档:Mediapipe 是由 Google 开发的一个开源库,旨在简化构建实时视觉

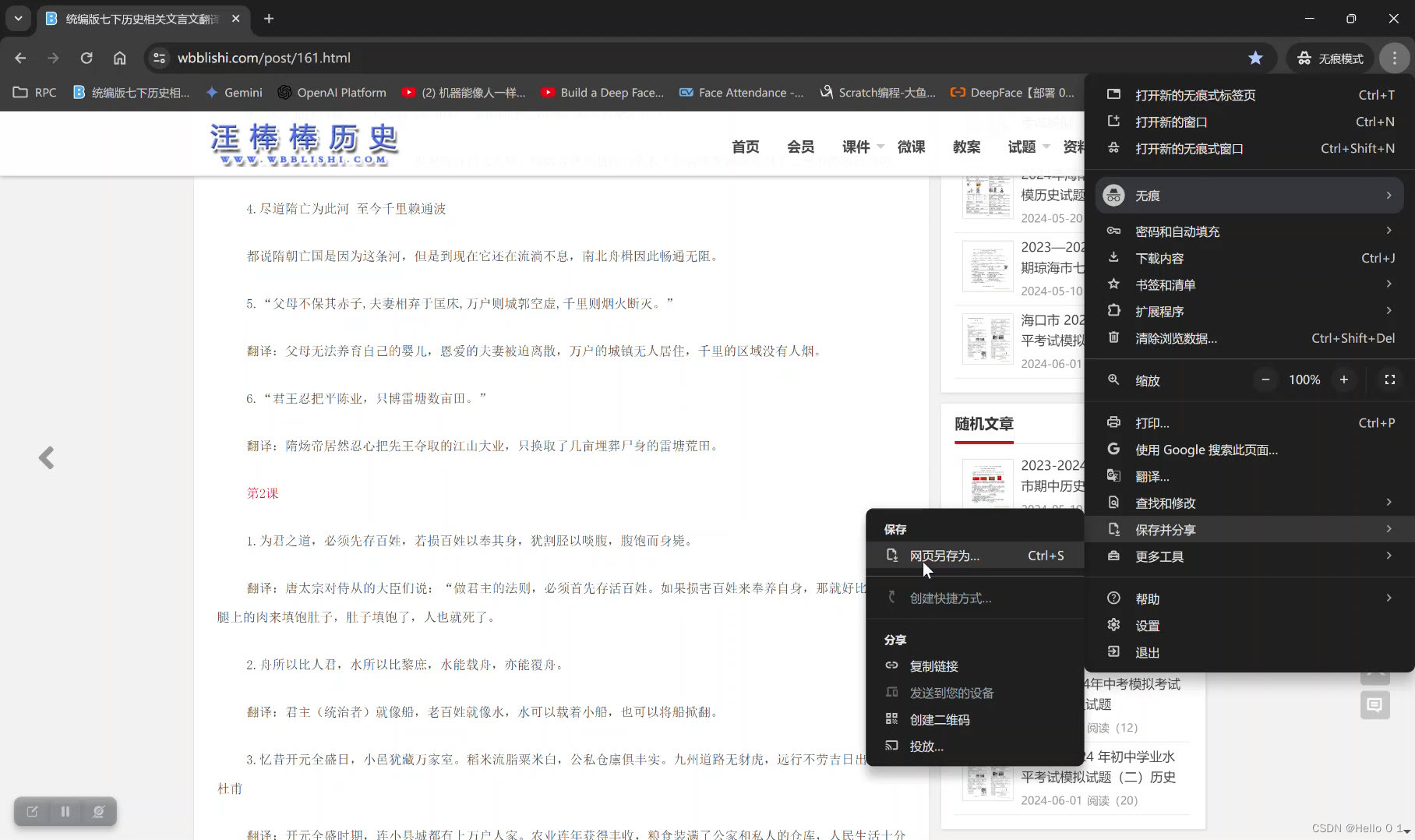

获取(复制)网页上的文字安装Toggle JavaScript 2.0(插件说明:Enable or disable JavaScript without the hassle.)禁止网页JavaScript。使用爬虫获取接口时,有些网站屏蔽了右键打开检查,可以点击chrome菜单中三个点中选择更多工具中的开发者工具。将网页地址传到微信的文件助手,打开链接,点击右上角三个点,选择“更多打开方式…登

而在异步编程中,当遇到一个异步操作时,它会被放入异步栈中,并立即返回控制权给调用者,允许之后的代码继续执行。然后,在异步操作完成后,异步栈会按照先进先出(FIFO)的顺序逐个执行已排队的异步操作。:由于异步栈不会阻塞主线程或其他异步操作,因此可以轻松地添加更多的异步操作,以构建复杂的异步程序。当异步操作完成时,相关的回调函数被调用,可以在其中处理操作的结果或进行下一步的操作。:异步栈可以捕获和处理