简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这个是连接hive报错的 大概率就是hiveConnection 和hiveDriver里解析hive url 和hive -d xxx=xxx这种时候出错了。背景:用dbeaver连接kerberos认证的hive,之前都是好好的,今天手贱点了下重置结果按照以前的死活连不上报上面的错误,其实这个错以前也遇到过忘了怎么解决的。明明显示了host为啥是null。说实话吧这个源码有点难搞,最近刚好我还

针对eventtime处理乱序数据,如何保证在需要的窗口内获得指定的数据?flink采用watermark allowedLateness() sideOutputLateData()三个机制来保证获取数据先来示例import org.apache.flink.streaming.api.TimeCharacteristicimport org.apache.flink.strea...

最常见的这个错误是类型转化异常,例如字符串Integer.parseInt("123abc"),abc不能转化为数字,通常在console报错栏可以找到对应位置。 由此在使用hibernate开发的时候 从数据库进进行多表连接查询,使用的是sql方法,查询的字段数据查到了,用List<User> users接收,在向前端传数据过程中mod

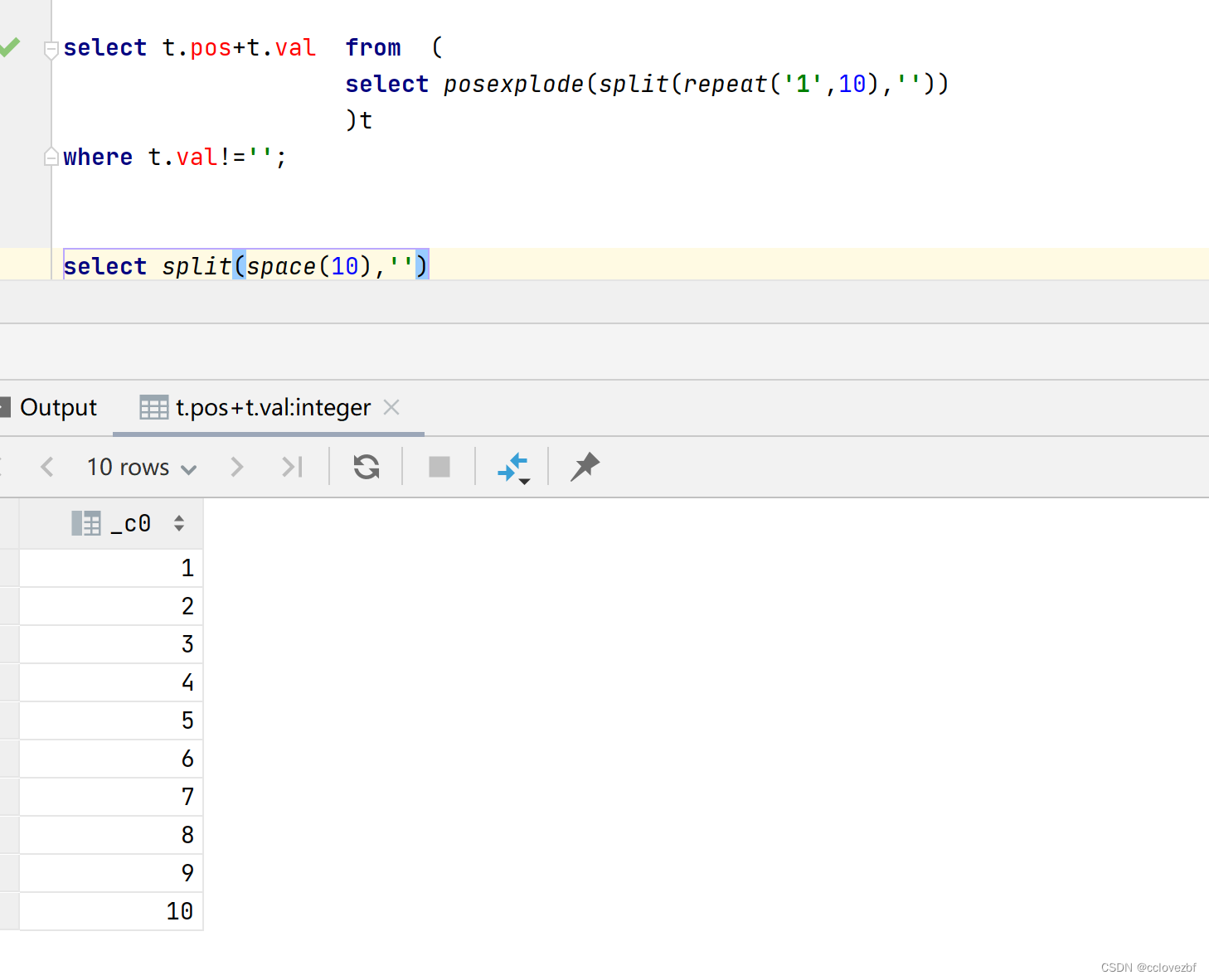

poexplode可以改为explode和rownumber。其中repeat函数可以改为space(10)2.udtf函数1变多。

第一步> install.packages("RODBC")第二步>https://downloads.mysql.com/archives/c-odbc/ 下载odbc.msi包,一路yes安装。第三步>我的电脑->控制面板->管理工具->ODBC 数据源(64 位)->添加->输入mysql信息记得test connect下第四步>libr

今天遇到个问题,例如selectcompany_name,concat_ws(',',collect_set(contract_num)) contract_numsfrom tablegroup by contract_num如果这个contract_nums数量有100个,我只显示5个。那么怎么办呢?1.基础版select concat_ws(",",array(array('1','2','

hive decimal计算出现null或者精度丢失

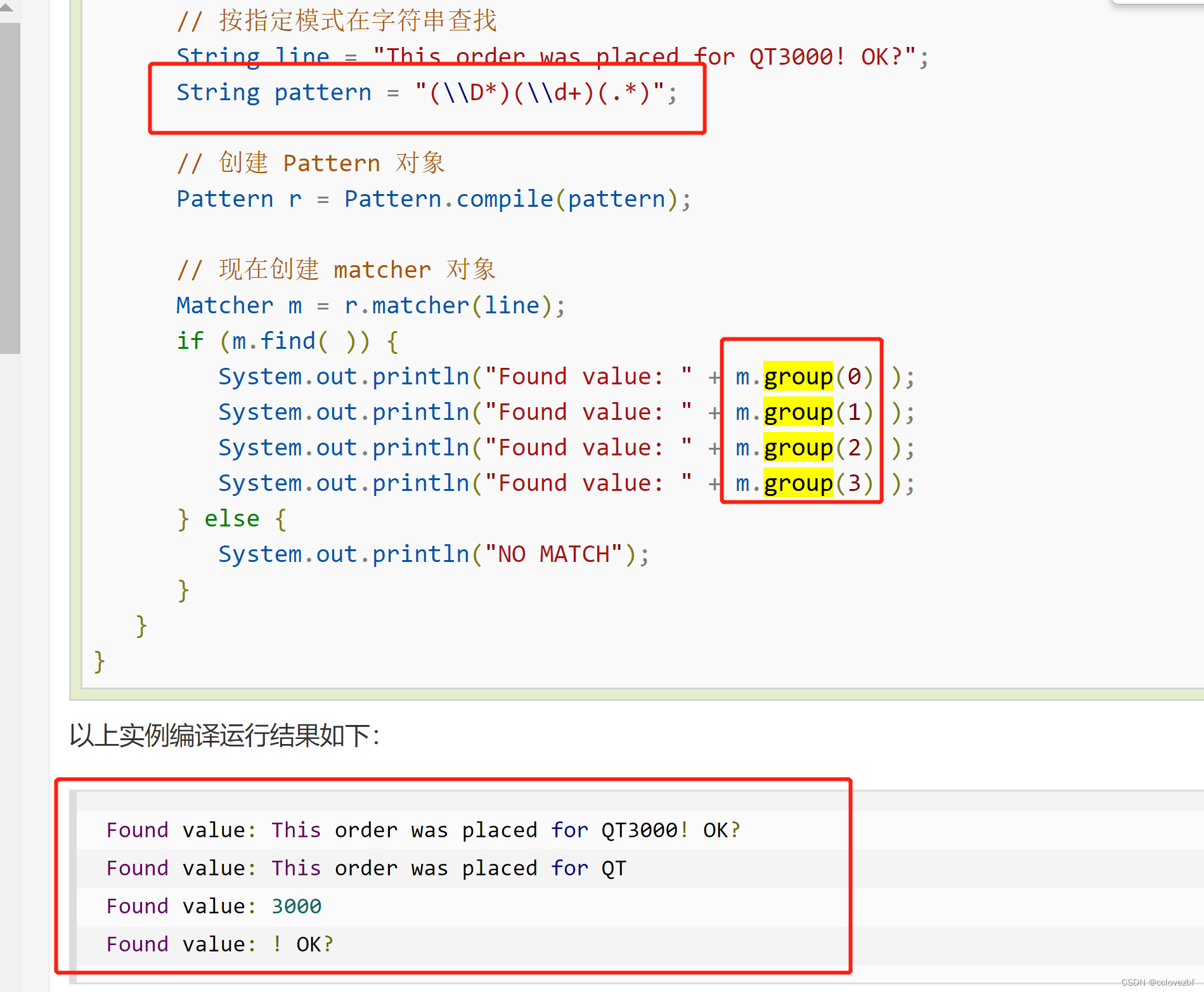

首先学习这个之前要先知道一些正则的基本知识。随便百度一下将下一个字符标记为一个特殊字符、或一个原义字符、或一个 向后引用、或一个八进制转义符。例如,'n' 匹配字符 "n"。'\n' 匹配一个换行符。序列 '\\' 匹配 "\" 而 "\(" 则匹配 "("。匹配输入字符串的开始位置。如果设置了 RegExp 对象的 Multiline 属性,^ 也匹配 '\n' 或 '\r' 之后的位置。匹配输

object MyKafkaSenderUtil {val props = new Properties()// Kafka服务端的主机名和端口号props.put("bootstrap.servers", "hadoop201:9092,hadoop202:9092,hadoop203:9092")// key序列化props.put("key...

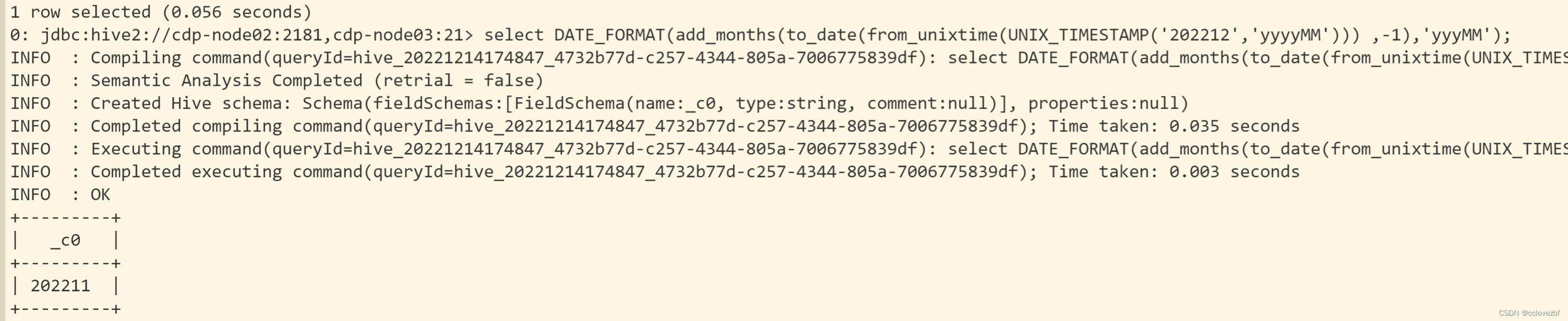

oracle存储过程中的各种oracle的独有用法如何转化为hive的函数,以及oracle和hive语法之间的差异