简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

强化学习两大应用方向:大模型训练与工业控制任务的核心算法解析

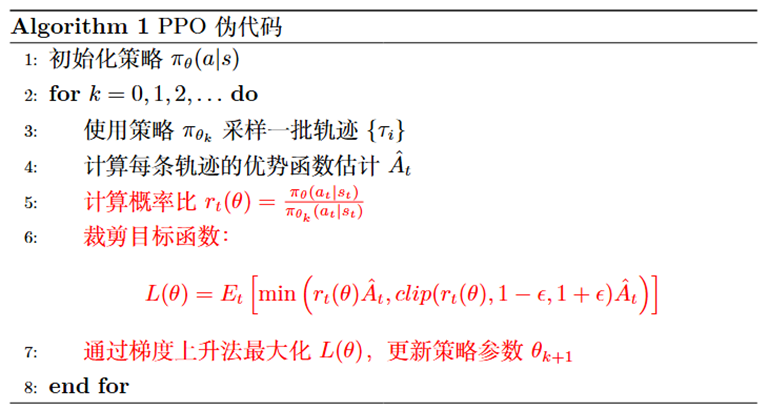

在OpenAI GPT系列模型的对齐训练中,PPO被用作基准算法,通过强化学习根据人类反馈(RLHF)优化模型输出,提升其安全性与生成质量。其核心思想是通过裁剪目标函数限制策略更新的幅度,从而避免训练过程中的剧烈波动。DPO是一种将强化学习问题转化为监督学习任务的算法,广泛用于大模型输出优化,如对话任务中安全性与一致性提升。强化学习在控制任务中可用于优化复杂系统中的动作决策,应对高维状态感知和连续

DSAC-T:Distributional Soft Actor-Critic with Three Refinements论文阅读笔记

为了解决标准的DSAC算法的这些问题,本文进一步引进了三个重要的改进来解决这些缺点,包括expected value substituting、twin value distribution learning和variance-based critic gradient adjusting,改进后的算法被命名为DSAC-T,并在强化学习基准任务与现实轮式机器人控制任务上进行测试。这是因为被高估的行

到底了