简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

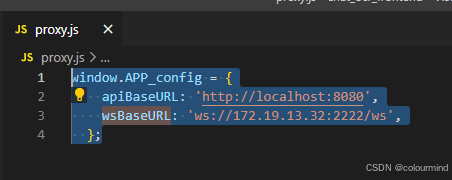

在Vue3项目中,为了灵活切换不同服务器部署,避免每次切换时重新打包代码,可以通过创建一个proxy.js配置文件来管理服务地址。将API和WebSocket的基地址写入proxy.js,并挂载到window对象上。在index.html中延迟加载proxy.js,确保在DOM加载完成后再访问window.APP_config。在main.js中,通过监听DOMContentLoaded事件,将配

本文想对比一下多机多卡(多机之间没有采用高速网络通信设备互联仅仅采用普通的以太网网卡带宽100M/S)训练和单机多卡训练的速度对比,为将来有可能去实践多机多卡大模型训练奠定一定的基础。采用LLaMA-Factory来进行单机多卡训练比较简单,更详细的过程就赘述了,这里仅仅给出一个训练命令和训练耗时截图,以方便和多机多卡配置进行对比。两台服务器上搭建完全相同的python训练环境,分布式训练采用的框

目录一、过拟合的表现以及判定1、模型过拟合的表现2、模型过拟合的判定二、过拟合的原因三、过拟合的解决方案1、模型层面2、数据层面3、训练层面4、其他最近在做NLP相关任务的时候,训练神经网络模型的过程中,遇到过模型过拟合的情况,到底怎么解决过拟合,来提高模型的性能,不是特别的清晰。以前学习机器学习的时候,也讲到了模型的过拟合,对里面怎么来解...

目录一、pynvml库的简单使用二、显存清理在跑神经网络训练或者推理的时候,有的时候很有必要实时监测一下显存的状态。NVIDIA显卡在终端管理界面,使用命令:watch -n 3 nvidia-smi可以指定每隔几秒中来显示一下显卡信息。当然NVIDIA也是开发了python库,很方便的实时查看GPU信息。一、pynvml库的简单使用这个pynvml库是NVIDIA为自己家显卡开发的一个获取显卡当

基于pytorch多GPU模型训练实践

以前了解过JAVA多线程多进程,python也学到过,但是就没有遇到过具体的业务场景,最近要做一个文本匹配的任务,需要对70W条文本数据进行推荐相似度的计算,需要做一个全遍历——也就是一个70W个元素的list遍历的时候,和自身做一些相关的计算。list中的每个元素没768维的向量,然后得出结果后,还需要排序,然后写入文件存储。这个场景就非常耗时,为了减少消耗时间,在单机的环境下,就想到了并...

转载自简书——隐马尔可夫模型 - HMM的三个问题 - 概率计算问题,把其中的有些公式排版做了简单修改!其中的后向概率算法有点难度!目录一、HMM案例回顾二、HMM典型的3个问题1、概率计算问题2、学习问题3、预测问题三、概率计算问题解决方案1、暴力直接计算法2、前向-后向算法2.1 前向算法:2.2HMM案例-前向算法2.3 后向算法...

NLP中的对抗训练FGMPGDFreeLBSMARTimport torchclass FGM():'''Example# 初始化fgm = FGM(model,epsilon=1,emb_name='word_embeddings.')for batch_input, batch_label in data:# 正常训练loss = model(batch_input, batch_label)

一、transformer简单原理和实现二、模型训练全流程三、解码策略总结1、贪心搜索(greedy search)2、集束搜索(beam search)3、Top-K采样和Top-p采样

目录一、python多进程及通信基本用法1、多进程的基本实现a、Process重写run方法b、使用Process和target方法c、直接使用Process类2、多进程的通信a、Queueb、Pipe二、python多进程实战1、使用进程池快速抽取数据2、多进程及通信完成数据清洗和保存3、多进程及通信实现异步任务需求写在最前面,说实话python多进程这块儿知识对于很少使用python多进程或者