简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

AI速报系列:Gemini 3.1 Pro Introduction

谷歌发布Gemini 3.1 Pro,强化复杂任务处理能力。该模型基于原生多模态架构,整合了Deep Think推理技术,显著提升了跨学科科研、软件工程等复杂问题的解决能力。采用MoE架构动态分配任务,支持连续视频和音频流处理。定价策略较竞品更具优势,输入端便宜60%。安全测试显示其风险可控,未达到自主进化警戒线。基准测试表明,Gemini 3.1 Pro重新确立了谷歌在AI领域的领先地位。

MoE混合专家模型 简介

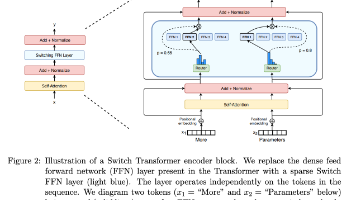

混合专家模型(MoE)是一种通过稀疏计算提升模型效率的架构。它基于Transformer,用多个独立专家网络替代传统前馈层,配合门控网络动态选择专家。MoE能在减少计算量的情况下扩大模型规模,比如Switch Transformer仅激活部分专家,使320B参数的模型计算量接近8B稠密模型。关键创新包括:1)稀疏MoE层实现条件计算;2)Top-k门控机制平衡负载;3)层级式结构支持模型深度扩展。

到底了