简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

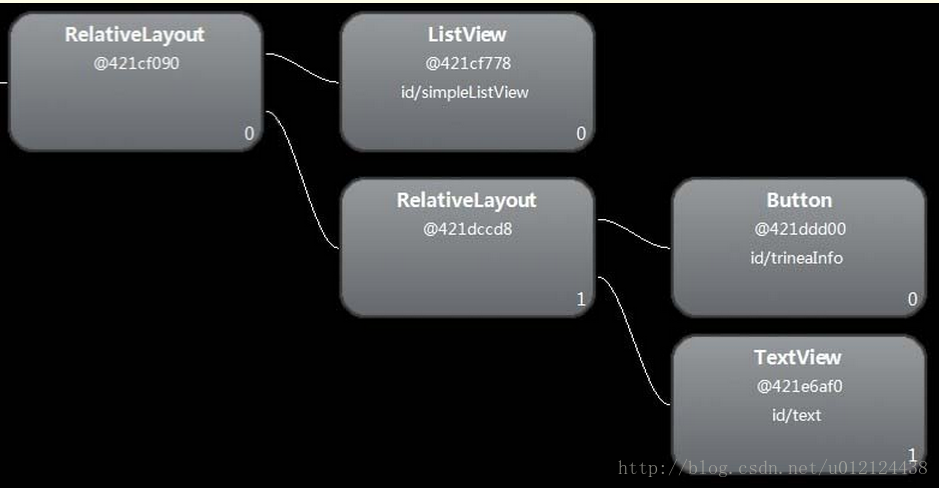

我们注意看注释5处,这里就解释了为什么include标签和被引入的布局的根元素都设置了id的情况下,通过被引入的根元素的id来查找子控件会找不到的情况。我们看到,注释5处的会判断include标签的id如果不是View.NO_ID的话会把该id设置给被引入的布局根元素的id,即此时在我们的例子中被引入的id为my_foot_parent_id的根元素RelativeLayout的id被设置成了in

在移动应用开发的广阔领域中,Android性能优化是一项至关重要的技能,它直接影响着应用的用户体验与市场竞争力。然而,对于许多开发者而言,性能优化似乎总是一片神秘莫测的领域,充满了各种术语与复杂的技术细节。本文将抽丝剥茧,用最通俗易懂的语言,揭开性能优化的面纱。如果你看完本文后仍感困惑,那么,是时候深入实践,亲自动手,才能真正掌握性能优化的精髓。由于文章内容比较多,篇幅有限,资料已经被整理成了PD

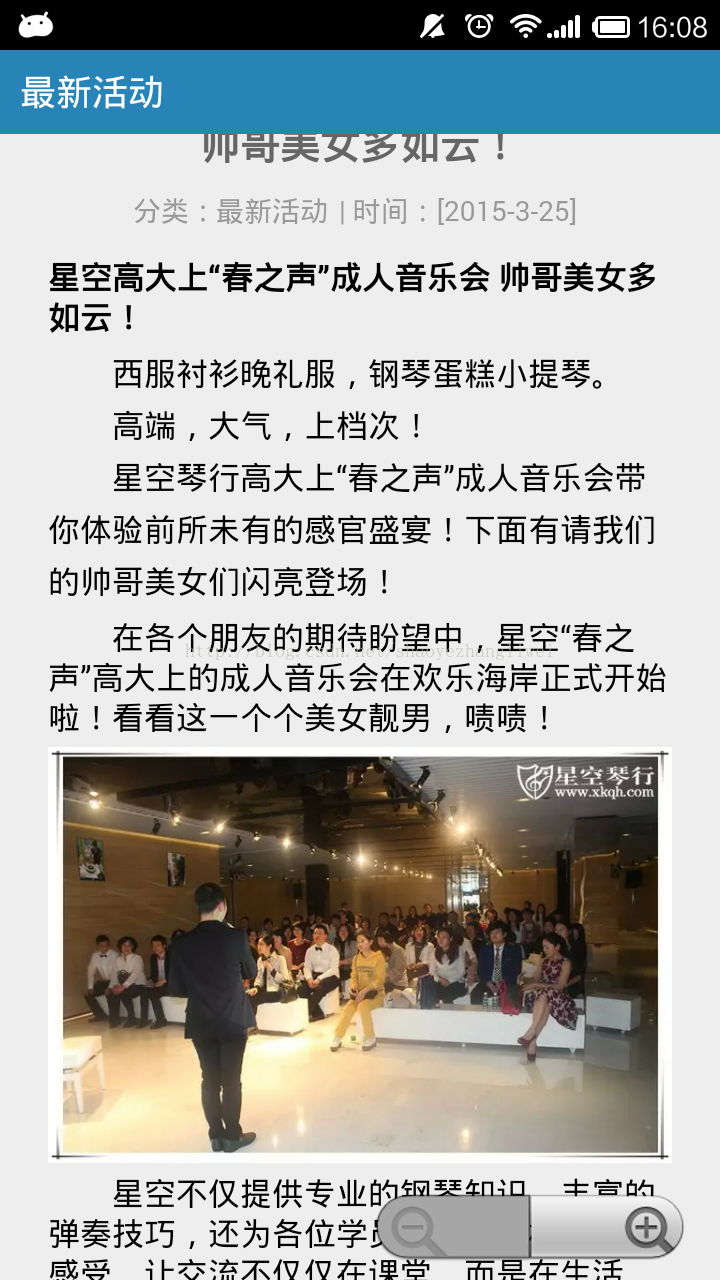

我当时想了两种思路:一种是在html页面加点击事件 点击跳入下一个页面 ,上面展示点击的 相关内容的大的文字或者图片。另一种思路是手势放大缩小这个页面。那么怎么能设置html页面在webview上加载以后 可以 放大缩小呢。个问题 : 就是网页上面的内容 字体或者图片等 设置的过小,就影响用户查看,看不清楚。4.企业级Android音视频开发学习路线+项目实战(附源码)我在做webview 嵌入H

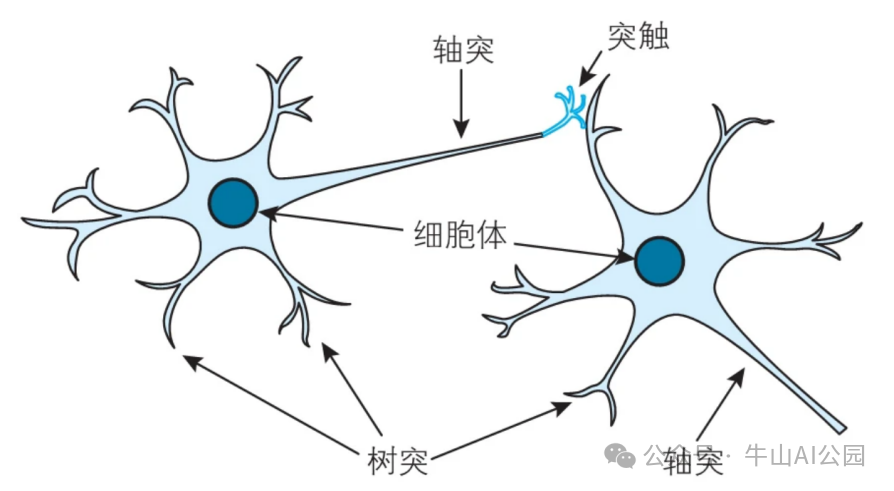

AI 模型训练是指通过数据驱动的方式,让人工智能(AI)系统从经验中学习,以便在给定的任务上进行预测、分类或生成等操作。这个过程通过优化模型的参数(如神经网络的权重和偏置)来最小化预测误差或损失,从而使模型能够在新数据上做出准确的判断,本文将介绍AI模型中神经网络和神经元的构造,以及AI训练的原理。

Text2SQL技术利用大语言模型将自然语言转换为SQL查询,解决企业数据利用痛点。文章详解其定义、核心组件(自然语言理解、Schema管理、SQL生成等)、处理流程及大模型选择策略。通过Function Calling和代码示例,实现安全可靠的自然语言查询数据库,让业务人员无需SQL技能即可直接探索数据,提升决策效率。

文章分享了大模型面试经验,指出面试已从死记硬背转向看重落地能力,不同轮次各有侧重。作者整理了2026年最新大模型面试题合集(含4大核心模块)和系统学习资料(视频教程、学习路线、项目案例、电子书籍),通过微信二维码免费领取,帮助求职者打牢基础、成功上岸大模型岗位。

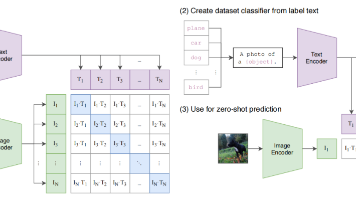

文章详细介绍了多模态大模型的基础算法CLIP(Contrastive Language-Image Pretraining)。通过对比学习,CLIP将图像和文本特征映射到同一语义空间,实现跨模态检索和零样本分类。文章以图文匹配和图像分类为例,详解了CLIP架构、zero-shot应用及训练思路,展示了如何通过文本和图像编码器将不同模态数据直接比较,为多模态应用奠定基础。

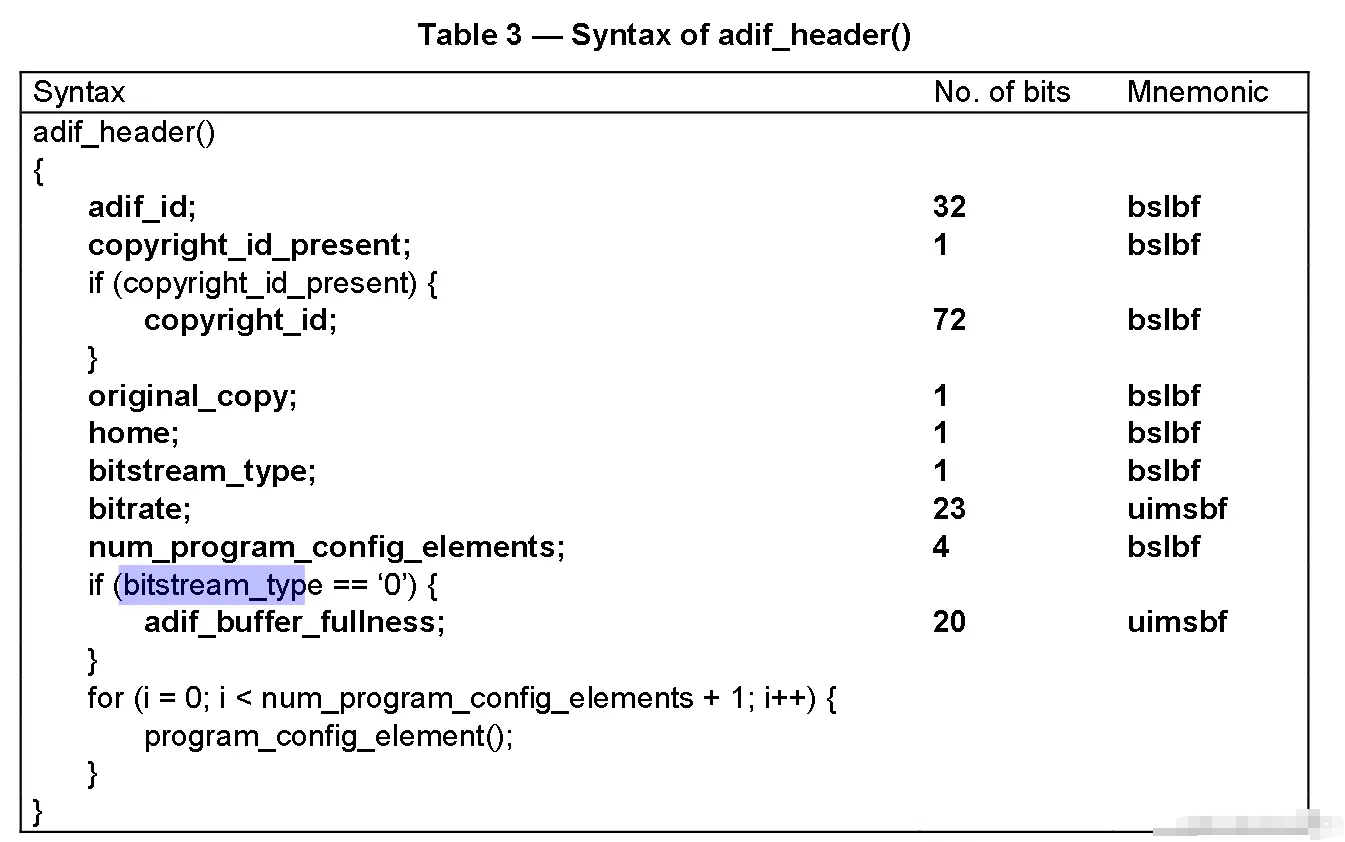

今天我们主要主要分析的是音频格式AAC。AAC全称Advanced Audio Coding,是相比于MP3更优秀的音频编码格式:更多的采样率,更多的声道,更好的压缩算法等。目前它也是MP4文件中音频部分的数据的常见编码格式。我们看到一般至少有两个数据流,其中一个就是音频流,Audio: aac (LC),表明音频就是使用了aac编码格式。

英伟达提出GDPO方法,解决GRPO在多奖励强化学习中因归一化导致奖励组合坍塌的问题。通过对各奖励信号分别进行解耦归一化,GDPO保留了不同奖励间的相对差异,实现更精准的多目标优化。在工具调用、数学推理和代码推理三项任务中,GDPO均稳定优于GRPO,展现出更强的训练稳定性和优化能力。

文章详细介绍了如何使用Docker+Dify+DeepSeek组合本地部署大模型并构建私有知识库的完整流程。从Docker安装、Dify部署、DeepSeek本地配置,到知识库创建和应用搭建,为读者提供了详细的步骤指导。通过这种方式,用户可以将自己的专业知识资料融入大模型,创建个性化的AI助手,实现高效的信息查询和知识管理,无需依赖公有云服务。