简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文分享了LLaMAFactory环境配置经验:使用conda创建Python3.11虚拟环境后,重点解决了flash-attention、torch(2.5.1)、bitsandbytes等依赖包的版本匹配问题,特别提醒需注意CUDA12.1环境变量配置。最后通过llamafactory-cli启动webui界面,并推荐使用swanlab云服务进行训练观测。该配置过程经过多次试错验证,为同类项目

saveToEs做了异常处理,是因为高版本的es会出现返回结果无法解析的问题,虽然更新成功了但一直报错导致消息无法成功消费(实际上已经消费了),这里取巧不让它报错。如果出现jvm问题,是因为rocketmq和java版本冲突,可以把java降至Java8。去logs/example/example.log查看是否报错,启动成功会有日志。rocketmq配置和es配置,canal没有配置。流程较长,

摘要:使用easydataset配置模型时出现"找不到模型"错误,主要原因是自定义模型名称不规范。经测试发现,模型名称需严格遵循官方规范(如deepseek需配置为deepseek-chat)。建议参考官方API文档确认正确名称,部分模型(如豆包)还需完成实名认证才能接入。按官方要求修改名称和地址后,问题得以解决。

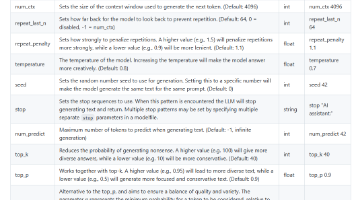

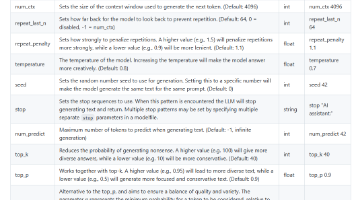

Ollama现已支持直接导入safetensors格式模型,无需转换为GGUF格式。用户需创建Modelfile文件配置导出参数,包括模板设置、系统参数及运行参数(如停止标记、上下文长度等)。使用时通过命令行执行"ollama create"命令加载模型,常见错误包括:Modelfile含中文导致解析失败,以及显存不足引发的CUDA错误(可通过nvidia-smi检查显存占用)

Ollama现已支持直接导入safetensors格式模型,无需转换为GGUF格式。用户需创建Modelfile文件配置导出参数,包括模板设置、系统参数及运行参数(如停止标记、上下文长度等)。使用时通过命令行执行"ollama create"命令加载模型,常见错误包括:Modelfile含中文导致解析失败,以及显存不足引发的CUDA错误(可通过nvidia-smi检查显存占用)

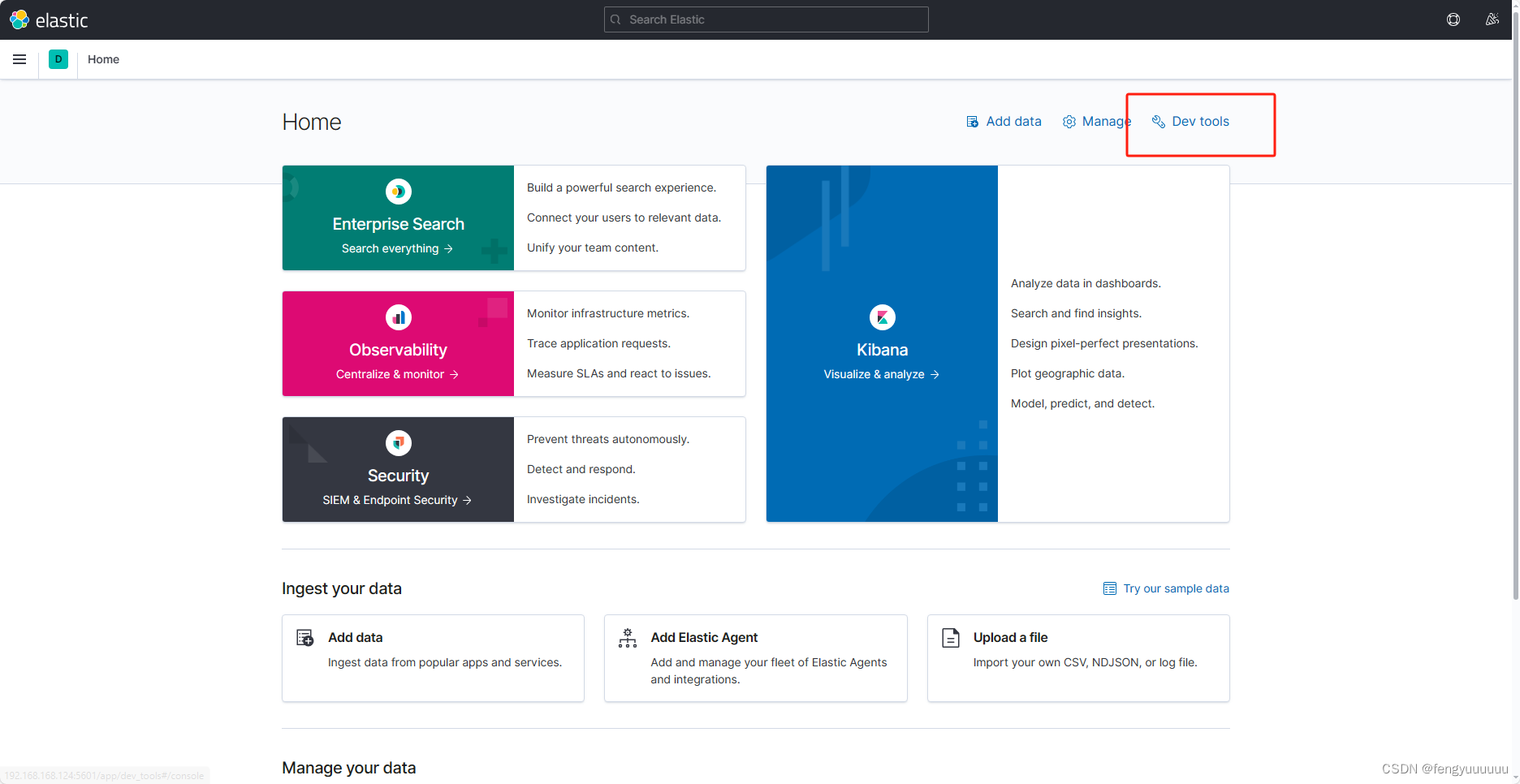

本文是我在学习es的笔记,如有疏漏,敬请指出#部署es,版本为7.12.1,端口号为9200#部署kibana,版本为7.12.1,端口号为5601!两者版本必须相同打开浏览器,进入kibana控制台红色为虚拟机的ip黄色为设置的kibana端口号。打开开发工具,就可以在kibana控制台内进行创建索引库、插入文档等操作在使用springboot时需要进行版本控制,在properties内控制版本