简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

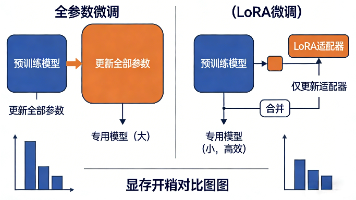

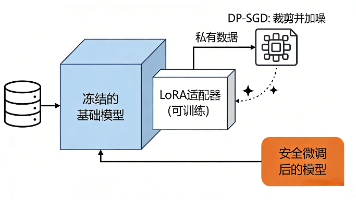

微调技术,特别是以LoRA为代表的高效微调,已经大大降低了赋予大模型专业能力的门槛。它不再是大厂的专属玩具,正逐渐成为企业和开发者解决垂直领域智能化问题的标准武器。微调技术会继续进化,参数效率更高,训练更快。不仅能微调文本,还能针对图像、音频等多模态数据进行专业适配。正如我们今天看到的,一站式、低代码/无代码的微调云平台正在成为主流。它们将数据管理、模型训练、效果评估和部署上线集成在一个无缝的流程

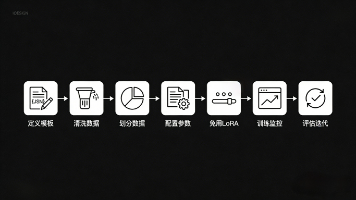

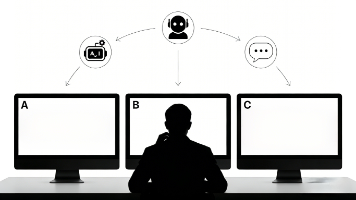

在这个过程中,如果你发现单纯的RAG还不够,需要让模型更深层次地掌握你的数据逻辑和风格——比如用你公司的客服对话记录去微调一个专属的客服模型——那么就需要涉及大模型微调。你是否遇到过这样的场景:兴奋地问ChatGPT一个关于你公司最新产品的问题,它却给你一个驴唇不对马嘴的回答,或者干脆说“我的知识截止于…它把复杂的微调过程变成了可视化的数据上传、参数配置和模型训练流程,让你无需深究代码和算力分配,

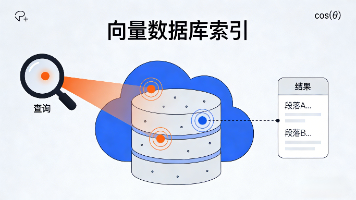

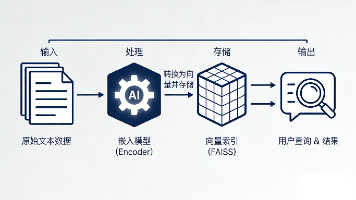

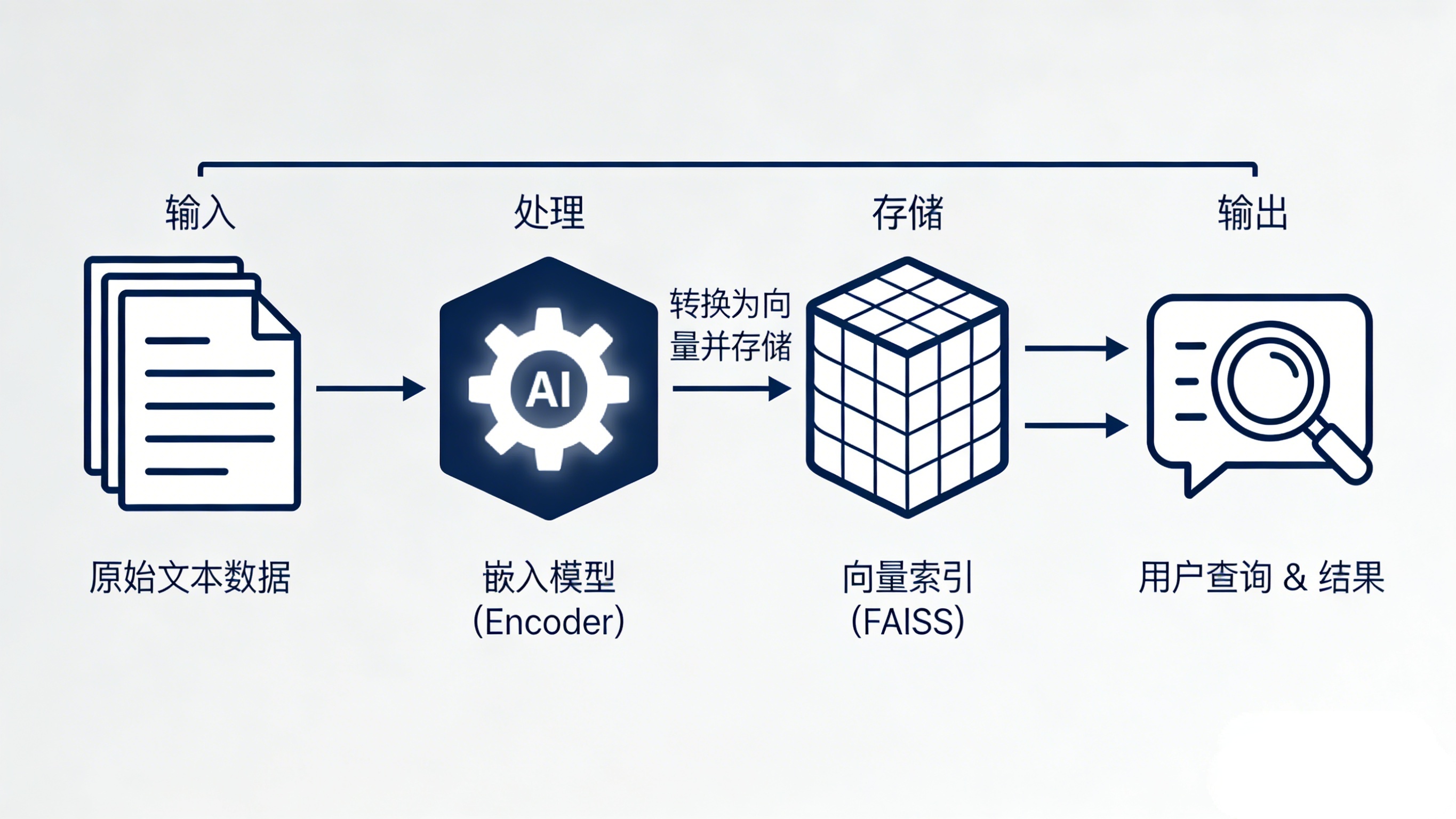

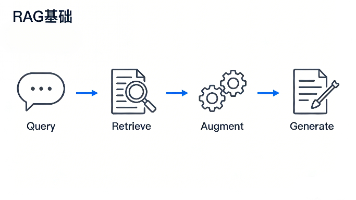

通过今天的分享,我们希望你已经对向量数据库不再陌生。它本质上是一个专门为“语义”设计的数据管理系统,通过将数据映射到连续向量空间并高效检索,实现了超越关键词匹配的智能查找。总结一下关键点:为什么需要它:打破大模型的知识边界,连接动态/私有数据,是构建RAG应用的基石。核心原理:嵌入模型把数据变成向量,向量数据库存储并基于向量距离进行智能检索。如何上手:从Faiss + Sentence-Trans

通过今天的分享,我们希望你已经对向量数据库不再陌生。它本质上是一个专门为“语义”设计的数据管理系统,通过将数据映射到连续向量空间并高效检索,实现了超越关键词匹配的智能查找。总结一下关键点:为什么需要它:打破大模型的知识边界,连接动态/私有数据,是构建RAG应用的基石。核心原理:嵌入模型把数据变成向量,向量数据库存储并基于向量距离进行智能检索。如何上手:从Faiss + Sentence-Trans

时,他很可能就懵了,甚至开始自由发挥。这样的平台,你无需关心代码和环境配置,只需上传准备好的问答对数据,就能轻松微调出一个属于你自己的“生成引擎”,无缝对接上述RAG流程,让最终助手的回答更精准、更专业。T5的特点是“万物皆可文本”,所有任务(问答、总结、翻译)都被转化成“输入文本 -> 输出文本”的形式,非常灵活。这样一来,大模型的回答就不再仅依赖于它的“记忆”,而是有了可靠的事实依据。当用户提

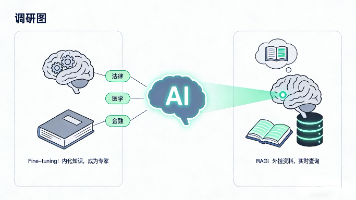

我们不用从头教它识字说话(那需要海量数据和算力,是预训练阶段做的事),而是用我们自己的、高质量的专业数据,去调整它内部的知识结构和表达方式,让它在你关心的领域里变得更加“专业”和“贴心”。它的核心逻辑是:在强大的通用基座模型(“通才”)基础上,通过我们特定领域的高质量数据(“专业教材”),采用高效的微调技术(如LoRA),以可控的成本,培养出一个满足我们专业化、个性化需求的“专才”。想象一下,Ch

传统微调方法,数据必须“接触”模型,风险不可控。对于企业和业务人员,理解其原理和流程,有助于你更好地与技术团队沟通需求,评估外部方案,甚至利用现有的低代码平台快速开启试点项目。它旨在让你能无代码或低代码地把自己的数据安全地“喂”进模型,直观地看到模型如何变得更“懂你”,是入门和实践的绝佳工具。本文将为你拆解其中的核心原理,并提供一个清晰的实践路径,让你即使没有深厚的代码基础,也能理解并启动安全可控

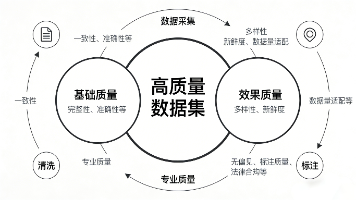

高质量数据集是AI成功的基石——比算法和算力更基础质量≠数量——1万条高质量数据可能比100万条垃圾数据更有用构建是系统工程——从采集、清洗、标注到迭代,每个环节都要质量控制验证必不可少——既要自动检查,也要人工评审和实际测试。

预训练阶段,模型通过阅读海量互联网文本,调整这些开关的状态,学会了语言的规律、世界的知识。微调阶段,我们就是用特定的小数据集,对这些已经基本就位的“开关”进行。无论你通过代码还是通过平台,当你成功将第一批数据“喂”给模型,并看到它开始用你期望的方式思考和回应时,你就已经握住了塑造智能未来的第一把钥匙。算法,分析每个“开关”应该向哪个方向(变大或变小)调整,才能让下次的“扣分”更少。效果好,但“手术

错误示范(模糊指令):json"instruction": "分析情感","input": "这款手机很棒,但电池不行。","output": "正面"正确示范(结构化、无歧义):json"instruction": "请对以下商品评论进行情感分析,严格按JSON格式输出。","input": "评论:这款手机很棒,但电池不行。","positive_aspects": ["设计", "性能"],