简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

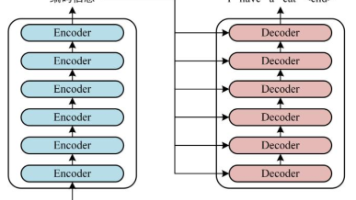

【摘要】本文探讨了卡尔曼滤波与Transformer模型的创新结合,用于时序预测问题。卡尔曼滤波作为经典状态估计工具,擅长从噪声数据中提取真实信号;而Transformer凭借注意力机制能捕捉长程时序依赖。两者优势互补:卡尔曼滤波预处理可提升数据质量,Transformer则学习复杂时序规律。文章通过完整代码示例演示了该方法的实现过程,包括数据生成、卡尔曼滤波去噪、Transformer模型构建、

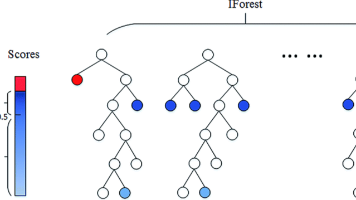

摘要:本文系统介绍了6种异常检测算法及其应用场景。通过电商欺诈检测等案例,说明了异常检测的核心逻辑:识别少数异常样本与正常样本的特征差异。详细讲解了孤立森林、One-Class SVM、LOF、ABOD、椭圆模型和VAE的数学原理与特点,并以鸢尾花数据集为例提供完整的Python实战代码。最后对比了各算法优缺点,帮助读者根据数据集特点选择合适的检测方法,包括训练速度、高维适应性和适用场景等关键指标

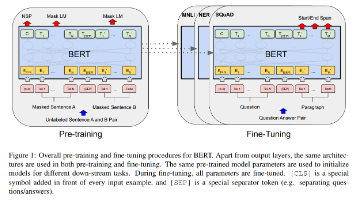

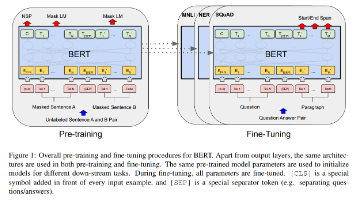

BERT家族是NLP领域的文本理解"天花板",从基础BERT到RoBERTa、ALBERT、DistilBERT等变体,通过不同优化策略提升性能。本文用"看书记笔记"类比解析6大模型差异,并实战对比中文情感分类任务。结果显示:BERT Large准确率最高(0.92),ALBERT参数最少(12M),DistilBERT速度最快(0.8ms)。适用场景建议:

BERT家族是NLP领域的文本理解"天花板",从基础BERT到RoBERTa、ALBERT、DistilBERT等变体,通过不同优化策略提升性能。本文用"看书记笔记"类比解析6大模型差异,并实战对比中文情感分类任务。结果显示:BERT Large准确率最高(0.92),ALBERT参数最少(12M),DistilBERT速度最快(0.8ms)。适用场景建议:

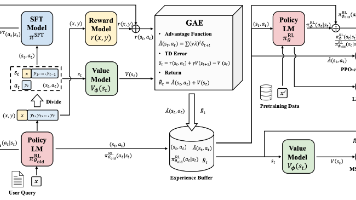

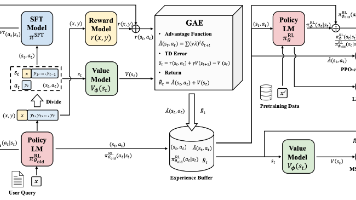

本文系统介绍了六种主流深度强化学习算法的原理与应用。DDPG适用于连续动作空间控制,PPO实现简单且性能稳定,TRPO理论严谨但实现复杂,SAC具有良好探索能力,TD3是DDPG的改进版本,MADDPG则专为多智能体系统设计。文章通过Pendulum-v1环境对比了这些算法的性能,提供了完整的代码实现和训练流程。结果表明,PPO和SAC通常表现最优,而TD3比DDPG更稳定。文章建议初学者从PPO

本文系统介绍了六种主流深度强化学习算法的原理与应用。DDPG适用于连续动作空间控制,PPO实现简单且性能稳定,TRPO理论严谨但实现复杂,SAC具有良好探索能力,TD3是DDPG的改进版本,MADDPG则专为多智能体系统设计。文章通过Pendulum-v1环境对比了这些算法的性能,提供了完整的代码实现和训练流程。结果表明,PPO和SAC通常表现最优,而TD3比DDPG更稳定。文章建议初学者从PPO

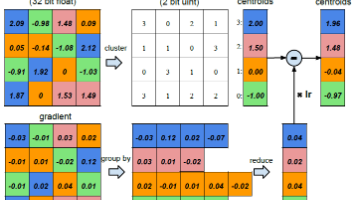

摘要:本文介绍了模型剪枝技术如何帮助解决大型神经网络在资源受限设备上的部署问题。文章详细解析了剪枝原理、分类(非结构化、结构化和混合剪枝)以及完整实施流程,包括评估、剪枝、微调和部署优化。通过PyTorch实战案例演示了MNIST数据集上的剪枝效果,对比了不同方法的参数压缩率和精度表现。最后提出工业部署建议,指出结构化剪枝的硬件友好特性,并推荐结合量化等技术的优化策略。模型剪枝能有效平衡模型精度与

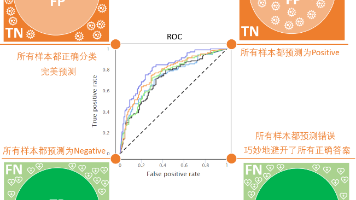

评估AI模型性能需区分准确率、精确率、召回率和F1分数。准确率衡量整体正确率但易受样本不均衡影响;精确率关注预测正例的准确性,适用于FP代价高的场景;召回率关注真实正例的识别率,适用于FN代价高的场景;F1分数则平衡精确率和召回率,适用于两者都需兼顾的情况。根据业务需求选择合适的评估指标才能有效判断模型效果。

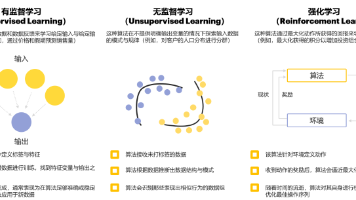

本文是一篇强化学习入门指南,用通俗语言讲解核心概念和算法,并附完整代码实现。文章首先通过对比监督学习和无监督学习,说明强化学习是通过"试错"最大化长期奖励的机器学习方法。然后详细解析了强化学习的5个组成部分(环境、智能体、状态、动作、奖励)和4个关键概念(策略、价值函数、Q值、贝尔曼方程)。接着介绍了三大算法分类(基于值、基于策略、基于模型),并通过一个Q-learning迷宫