简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

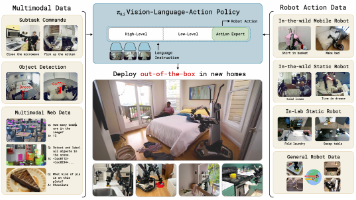

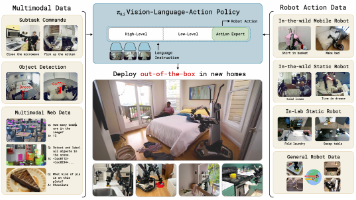

VLA(视觉-语言-行动模型)是一种端到端的多模态人工智能系统,它通过视觉感知、语言理解和行动执行三个模块的整合,直接将传感器输入映射为控制输出。世界模型则采取了不同的路径,它试图让AI学会理解物理世界的运行规律,通过预测未来状态来指导当前行动。其核心是让AI在内部模拟环境中进行“思想实验”,预测不同行动可能带来的后果。

VLA(视觉-语言-行动模型)是一种端到端的多模态人工智能系统,它通过视觉感知、语言理解和行动执行三个模块的整合,直接将传感器输入映射为控制输出。世界模型则采取了不同的路径,它试图让AI学会理解物理世界的运行规律,通过预测未来状态来指导当前行动。其核心是让AI在内部模拟环境中进行“思想实验”,预测不同行动可能带来的后果。

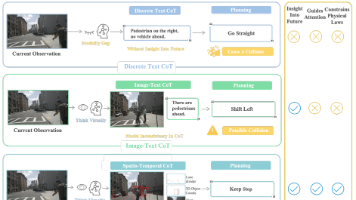

然而,当前的视觉语言模型大多采用为特定场景设计的离散文本“思维链”(Chain-of-Thought, CoT),这种方式本质上是对视觉信息的高度抽象和符号化压缩,可能导致时空关系的模糊和细粒度信息的丢失。大量的实验结果表明,FSDrive在轨迹规划、未来帧生成和场景理解等多个任务上均取得了优异的性能,展现了其在推动自动驾驶技术向更高阶的视觉推理迈进方面的巨大潜力。模型的决策不仅基于当前的视觉输入

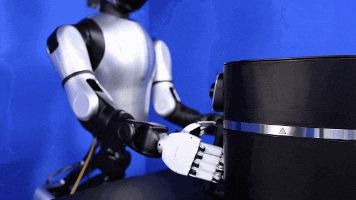

具身智能是一个广阔且充满活力的交叉学科领域。它不仅是算法的竞技场,也是系统工程、硬件设计与认知科学的交汇点。VLA和RL/IL是两个核心切入点,前者更前沿,后者更扎实。最重要的是,具身智能的研究并非必须依赖昂贵的硬件。利用开源的仿真环境、公开数据集和代码框架,在纯软件层面同样可以开展极具深度的研究。希望这份梳理能帮助你拨开迷雾,找到属于自己的那条研究路径,共同见证这场AI与物理世界融合的浪潮。