简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

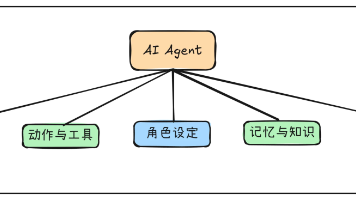

本文介绍 AI Agent 的组件构成。智能体(Agents) 是由多个组件系统构成的复杂单元。基于这些组件,智能体执行任务,实现任务目标。组件本身可能是简单或复杂的系统,通常可分为以下五大类别。

这就是我整理这份11阶段智能体构建工作流的原因——一个实用的端到端蓝图,带你从阶段0(思维转变)一路走到生产部署、可观测性和迭代。如果你想要的智能体不只是夸夸其谈,而是能可靠地执行任务,那么这就是你的路线图。

LLaMA-Factory 是一个开源的大语言模型(LLM)微调框架,旨在简化大规模语言模型的微调过程。该项目提供了一个用户友好的界面和全面的工具集,支持从数据准备到模型部署的完整流程。

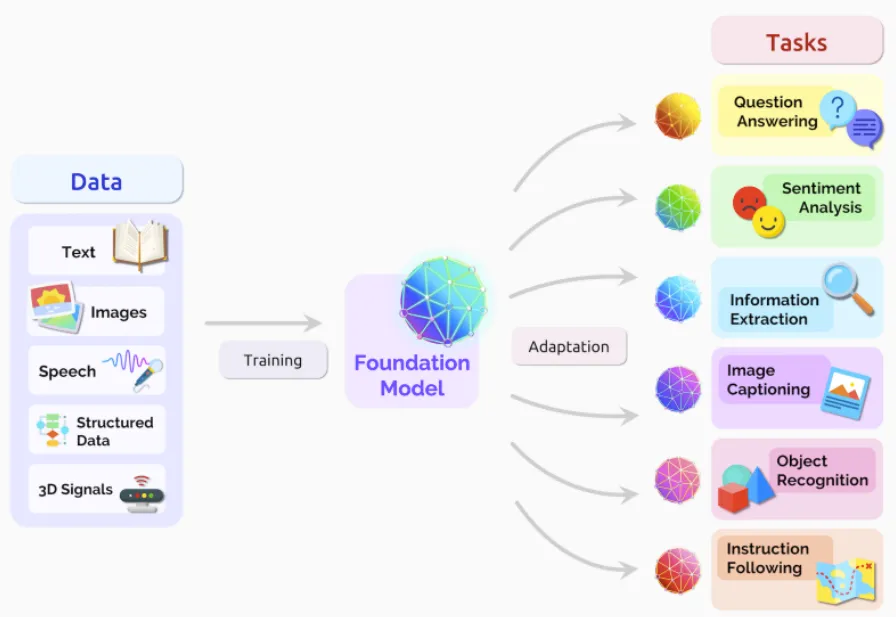

本文探索使用大语言模型(LargeLanguageModel,LLM),通过其对自然语言理解和生成的能力,揣摩用户意图,并对原始知识点进行汇总、整合,生成更贴切的答案。关于基本思路,验证效果和扩展方向,可以参考正文的介绍。

本文将带领您了解如何迅速在Windows平台上部署Ollama,这是一个开源的大语言模型(LLM)运行工具,以及如何通过Open WebUI和cpolar内网穿透技术,让您在任何地方都能访问您本地部署的AI语言模型,如llama2和千文qwen。

我们将使用 PyTorch 作为实现强化学习算法的数值计算库。PyTorch 是 Facebook 开发的科学计算和机器学习库,张量 (Tensor) 是 PyTorch 中的核心数据结构,类似于 NumPy 中的 ndarray。

OpenAI今天凌晨发布了GPT-4o Mini模型,奥特曼介绍中说“两年时间模型成本下降了99%”。 先说结论,从OpenAI官方提供的测评数据上看,GPT-4o mini的模型能力在行业基准测试中大部分基准测试都完胜同行业的同规格模型。仅在MathVista的测试中略低于Google的Gemini Flash模型。其余几项均完胜。

模型微调(Fine-Tuning)和检索增强生成(Retrieval-Augmented Generation,简称RAG)是两种不同的技术,它们都用于提升语言模型的性能,但各自采用的方法和侧重点有所不同。本文基于微软的论文对其进行了比较。

工作流(Workflow) 是 Dify 的核心功能之一,通过将复杂任务分解为更小的步骤(节点),降低系统复杂度,减少对提示词技术和模型推理能力的依赖,从而提高 LLM 应用在复杂任务中的性能,提升系统的可解释性、稳定性和容错性。

Ollama 是一个开源项目,它允许用户在其本地计算机上运行大型语言模型(LLM)。