用 Dify 搭建 AI 知识库

本文详解如何用Dify + 爬虫工具实现内容批量抓取与结构化存储,附全流程工作流设计,新手也能轻松上手

在 AI 内容创作领域,「知识库」是破解 “AI 幻觉” 的核心武器 —— 让 AI 基于真实数据输出内容,既能保证专业性,又能塑造账号的可信度。但如何高效将优质内容导入知识库?本文详解如何用Dify + 爬虫工具实现内容批量抓取与结构化存储,附全流程工作流设计,新手也能轻松上手

以下内容很有用呀,比较多

一、为什么需要「AI 知识库」?

- 痛点 1:AI 幻觉频发

:纯生成式 AI 易编造错误信息,知识库可强制约束输出范围。

- 痛点 2:内容生产低效

:人工整理资料耗时,批量导入可快速构建垂直领域知识库(如教育、财经等)。

- 场景案例

:某数学思维教培机构通过搭建 “数学知识库”,将小红书 / 公众号优质内容导入后,AI 生成的营销文案准确率提升 60%,人设专业度显著增强。

二、前期准备:3 步搭建数据通道

1. 创建 Dify 知识库

- 操作路径

:登录 Dify→「知识库」→「新建数据集」→命名为 “公众号内容库”。

- 关键细节

:创建后从 URL 中提取知识库 ID(格式为

datasets/{id}/documents),后续 API 调用需用到。

2. 生成 API 密钥

- 作用

:通过 HTTP 接口写入内容需身份验证,密钥权限覆盖所有知识库,需妥善保存。

- 操作

:「设置」→「API 密钥」→「新建密钥」→复制保存。

3. 安装 Firecrawl 爬虫工具

- 工具定位

:轻量化网页抓取工具,支持单页面 / 批量抓取,免费额度可满足日常测试。

- 安装方式

:浏览器插件市场搜索 “Firecrawl”→安装→注册账号→获取 API Key。

三、青铜操作:单篇公众号文章快速入库

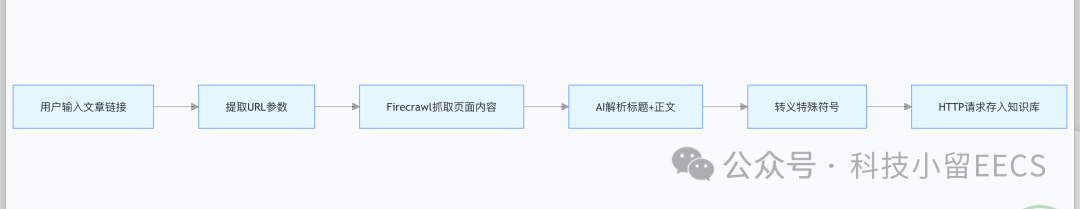

工作流逻辑拆解

分步操作指南

-

参数提取器

-

功能:从用户输入中识别 URL,支持手动输入或链接粘贴。

-

配置:设置正则表达式匹配

https://mp.weixin.qq.com/.*格式链接。

-

-

单页面抓取

- 反爬破解

:在请求头中添加浏览器伪装代码:

- 反爬破解

{"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36"}

输出格式:选择 Markdown,勾选 “仅抓取主要内容” 以过滤广告栏、导航栏等无关信息。内容解析与转义AI 提示词:“请从以下内容中提取完整标题和正文,请勿修改原文:{content}”。代码处理:使用 JavaScript 函数转义特殊符号(如换行符、引号),避免 HTTP 请求报错

function main({arg1}) {return {content: arg1.replace(/\\/g, '\\\\').replace(/"/g, '\\"').replace(/\n/g, '\\n').replace(/\r/g, '\\r').replace(/\t/g, '\\t')}}

-

HTTP 请求入库

- 接口调用

:复制 Dify API 文档中的 cURL 示例,填入知识库 ID 和 API 密钥。

- Headers 设置

:必须包含

Content-Type: application/json,确保服务器正确解析数据。

- 接口调用

测试验证

输入任意公众号文章链接,运行工作流,约 10 秒后可在 Dify 后台查看已存入的标题、正文及元数据(如 URL、抓取时间)。

四、批量导入 100 篇内容

核心思路

通过「迭代节点」循环处理 URL 数组,实现自动化批量抓取。

操作要点

-

URL 列表准备

-

工具:使用浏览器插件(如 Cursor 开发的 “网址采集器”)批量提取目标文章链接,保存为 CSV 或 JSON 格式。

-

-

迭代节点配置

-

输入类型:设置为 “Array”,确保工作流识别 URL 数组。

-

流程复用:在迭代内部复制单篇抓取的完整节点(参数提取→抓取→解析→入库),实现 “一次配置,批量运行”。

-

效率对比

-

手动单篇导入:每篇耗时 3-5 分钟,100 篇需 5-8 小时。

-

批量工作流:一次性提交 URL 列表,全自动运行,耗时约 20 分钟(受网络速度影响)。

五、未来扩展方向

-

深度搜索集成通过 Dify 对接搜索引擎 API(如 Bing、Google),输入关键词自动爬取全网相关内容,构建主题知识库(如 “新能源汽车趋势”)。

-

Agent 自主抓取结合 Agent 技术,赋予 AI “自主浏览网页” 能力:输入目标网站(如小红书),AI 自动识别相关内容并抓取入库,减少人工干预。

六、注意事项与避坑指南

- API 密钥安全

:避免泄露,定期更换;建议为不同业务创建独立密钥,限制权限范围。

- 爬虫频率控制

:单次批量抓取不超过 200 篇,避免触发公众号反爬机制(IP 封禁、验证码等)。

- 内容合规性

:仅抓取公开可访问内容,涉及版权的文章需获得授权,商业用途需特别注意法律风险。

搭建 AI 知识库的核心壁垒不是技术,而是 “数据资产的结构化能力”。通过 Dify + 爬虫的组合,我们不仅能解决 “内容导入难” 的痛点,更能为 AI 赋予 “领域专家” 的能力 —— 从被动生成到主动调用真实数据,这正是 AI 落地业务场景的关键一步。

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此,我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包,现在将这份 LLM大模型资料 分享出来: 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)