花落八股知多少

八股八股走起来

聚簇索引和非聚簇索引

什么是聚簇索引和非聚簇索引,如何理解回表、索引下推-腾讯云开发者社区-腾讯云

聚簇索引(主键索引):

- 按照主键字段构建,将表数据按照主键顺序存储在磁盘上,确保了行的物理存储顺序与主键的逻辑顺序相同,查找快。

- 非叶节点存储索引值,叶节点存储整行记录。

- 若没有显式定义主键,MySQL 会选择唯一非空索引作为主键;若没有,则会生成一个隐藏的主键。

非聚簇索引(非主键索引、二级索引):

- 按照非主键字段构建,不影响表中数据的物理存储顺序,将索引与数据分开存储,单独创建一张索引表,用于存储索引值和对应行指针(主键)。

- 非叶节点存储索引值,叶节点存储索引值以及指向数据页数据行的逻辑指针(主键、物理地址)。

- 此索引需要进行一次回表操作,即先通过索引查找主键,然后再通过主键查询所需数据行。

MySQL 中常用的存储引擎及其索引结构

InnoDB VS MyISAM

1. InnoDB(默认存储引擎)

- 索引结构:B + 树

- 特点:

- 聚簇索引

- 辅助索引:叶子节点包含主键值,先定位主键,再通过主键查询行数据(二次查询)。

- 支持事务、外键约束和行级锁,适合高并发、事务性应用。

2. MyISAM

- 索引结构:B + 树

- 特点:

- 非聚簇索引

- 不支持事务和外键,表级锁设计,适合读多写少的场景。

MongoDB & PGSQL & ORACLE & SPARKSQL & Flink

MongoDB

- 定义:开源的文档型非关系型数据库,以 BSON(类似 JSON 的二进制格式)存储数据,适合处理半结构化和非结构化数据,常用于互联网应用、大数据存储等场景。

- 优势:文档型 NoSQL,模式灵活,支持水平分片,适合高并发读写和非结构化数据。

- 索引类型:B-tree(默认)、Hashed(等值查询)、Geospatial(地理数据)。

Flink

- 定义:开源的分布式流处理框架,用于对无界和有界数据流进行有状态计算。

- 状态后端类型:内存(调试)、FsStateBackend(中等规模)、RocksDB(大规模,容错好)。

- 窗口类型:翻滚窗口(无重叠)、滑动窗口(重叠)、会话窗口(空闲时间触发)。

- Exactly-once实现:Checkpoint 机制 + 两阶段提交(2PC:准备+提交/回滚),确保故障恢复时数据仅处理一次。与 Kafka 集成时,通过协调 Kafka 的分区偏移量和 Flink 的 Checkpoint 来保证数据在生产和消费过程中仅被处理一次。

PostgreSQL

-

事务隔离级别:读未提交、读已提交(默认)、可重复读、串行化,通过 MVCC 和锁实现。

-

索引类型:B-tree(通用)、GiST(空间数据)、GIN(JSON / 数组)、BRIN(时序数据)。

-

如何处理大表:分区表(时间 / 范围分区)、创建覆盖索引、定期 VACUUM 分析统计信息。

Oracle

-

索引类型:B-tree(默认)、位图索引(低基数列)、函数索引(表达式查询)。

-

性能优化手段:优化 SQL(执行计划分析)、创建合适索引、调整 PGA/SGA 参数。

SparkSQL

- 定义: 分布式计算框架 Spark 中的结构化数据处理模块,而非传统意义上的关系型数据库(如 MySQL、PostgreSQL)。

- DataFrame 和 Dataset 区别:DataFrame 是无类型的

Dataset[Row],Dataset 有编译时类型安全,后者适合强类型场景。 - 查询优化方式:谓词下推、列裁剪、使用 Parquet 列式存储、缓存热数据。

- 与 Spark Streaming 集成:结构化流将流数据转为 DataFrame,支持 SQL 语法实时分析。

关系型数据库 VS 非关系型数据库 NoSQL

| 类型 | 关系型数据库(RDBMS) | 非关系型数据库(NoSQL) |

|---|---|---|

| 定义 | 基于关系模型(二维表结构),用 SQL 操作数据 | 不依赖关系模型,支持键值、文档、列族等多种数据模型 |

| 核心特点 | 结构化数据、强一致性、ACID 事务、表关联 | 半结构化 / 非结构化数据、最终一致性、灵活 schema、分布式扩展 |

| 典型产品 | MySQL、PostgreSQL、Oracle、SQL Server | MongoDB、Redis、Cassandra、DynamoDB |

慢查询优化

- EXPLAIN 分析:定位全表扫描、排序等性能瓶颈。

- 索引优化:1.创建复/联合索引(区分度最高、频繁使用列置左)、覆盖索引,避免索引失效 2.表索引数量<=5(索引数量越多,优化器生成执行计划的时间就越长,且占用额外存储空间)3.对where后的字段建索引,例如:select age,city,name from user where age = 20 and city = 'shenzhen' order by name; 建立(age,city,name)的索引比(age,city)和(name)的效果好,因为此时叶子节点的name已经排好序。

- sql优化:1.减少扫描数据量,优先过滤后关联。2.非必要不用select *(解析成本高,无需字段传输增加网络消耗)3.join多表时,小表驱动大表(小表到内存,去磁盘查找大表的次数少)4.允许记录重复时用union all代替union(去重增加耗时)

- 表结构优化:xxx

- 业务优化:xxx

- 架构优化:读写分离、分库分表、缓存机制、分布式数据库

索引失效

- 模糊搜索以通配符开头 (后缀匹配改前缀匹配,全文索引(FULLTEXT)替代模糊查询)。

- 对索引列进行计算/函数操作(如

UPPER(column))。 - 隐式类型转换(如

VARCHAR与INT比较)。 - 不满足最左前缀原则(复合索引)。

- 范围查询后索引截断(复合索引)。

- 统计信息不准确(MySQL 优化器基于统计信息(如索引基数)选择执行计划,若统计信息过时,可能误判)。手动更新:

ANALYZE TABLE users; - 索引选择性过低(索引选择性 = 唯一值数量 / 总行数,值越接近 1 表示选择性越好)。

- or

- is null

- is not null

排查索引失效步骤

- EXPLAIN 分析:通过

EXPLAIN SELECT ...查看执行计划,重点关注key(使用的索引)和rows(扫描行数)。 - 索引定义检查:确认索引是否存在、是否为复合索引、是否符合最左前缀原则。

- 统计信息更新:执行

ANALYZE TABLE更新统计信息,避免优化器误判。 - 慢查询日志:结合

long_query_time和slow_query_log定位耗时 SQL,针对性优化。”

优化复合索引步骤

- 最左前缀:将高频查询的字段放在索引最左侧(如

(user_id, order_time))。 - 选择性优先:将选择性高的字段前置(如唯一 ID 优于性别字段)。

- 覆盖索引:在查询仅需索引字段时(如

SELECT user_id, order_id),确保索引包含所有查询列。

在预算系统中,通过调整复合索引顺序,将某报表查询从 2 秒优化到 80ms。”

索引越多越好吗?

- 写性能下降:每次 INSERT/UPDATE/DELETE 需更新索引。

- 存储空间增加:索引文件占用额外磁盘空间。

- 维护成本:过多索引可能导致优化器选择错误执行路径。因此需遵循‘二八原则’,对 80% 的高频查询优化索引,避免冗余索引。”

“如何高效同步两个表的数据?”

- 回答:

“可以使用

MERGE语句或等效方案:- Oracle/SQL Server:直接使用

MERGE语句,根据匹配条件执行插入或更新。 - MySQL:使用

INSERT ... ON DUPLICATE KEY UPDATE或分批次UPDATE + INSERT。

例如,同步用户表数据:

sql

MERGE INTO users t USING new_users s ON (t.id = s.id) WHEN MATCHED THEN UPDATE SET t.name = s.name WHEN NOT MATCHED THEN INSERT VALUES (s.id, s.name); - Oracle/SQL Server:直接使用

Zookeeper

- 定义:开源的分布式协调服务,提供高性能、可靠性和可扩展性服务,简化分布式系统中的协调和管理任务,如配置管理、命名服务、分布式锁、选主等功能。

- 数据模型:基于树形结构的层次命名空间,类似文件系统目录结构(节点:ZNode)。

- 集群角色: Leader 负责处理客户端写请求,Follower 复制 Leader 操作,Observer 不参与选举和写操作投票,主要用于扩展读性能。

- 选举机制:通过 ZAB 协议的崩溃恢复阶段进行选举。集群启动或 Leader 宕机等情况时,节点会通过投票选出新的 Leader。通常基于半数以上节点同意原则,选举过程中会比较节点的 ZXID(事务 ID,越大越新)和节点 ID 等因素来确定 Leader。

- 机器台数:集群最少需要 3 台机器。集群规则为 2N + 1 台(N > 0),这样能保证在半数以上节点可用时集群就能正常工作,即容忍 N 台节点故障。

- 部署模式:单机模式、伪集群模式(在一台机器上模拟多个节点组成集群)、集群模式(多个真实节点组成集群)。

- ZAB 协议:ZooKeeper 实现分布式一致性的核心协议,专为 高可用分布式系统 设计,确保集群在节点故障时仍能保持数据一致性。

kafka (Apache Kafka)

定义:开源的分布式流处理平台,以高吞吐量、可扩展性和容错性为目标,主要用于实时数据处理、日志收集、消息队列等场景。

核心组件:

- Broker:集群节点,负责接收生产者消息、存储数据、为消费者提供读取服务,单个集群可包含多个 Broker。

- Topic:消息的逻辑分类,如 “用户点击日志”“订单数据” 等,每个 Topic 由多个 Partition 组成。

- Partition:Topic 的物理分片,每个 Partition 是有序的、不可变的日志序列,数据按顺序追加,保证分区内消息的顺序性。

- Replica:Partition 的副本,用于数据冗余和容错,分为 Leader(负责读写)和 Follower(同步 Leader 数据)。

- Zookeeper(旧架构依赖):早期 Kafka 依赖 Zookeeper 管理集群元数据(如 Broker 节点状态、Partition 分配等),新版本(3.0+)逐步移除对 Zookeeper 的依赖,转为自管理模式(KRaft 协议)。

注意:

- Partition 是 Kafka 实现高吞吐量的关键,每个 Partition 只能被一个 Consumer Group 中的一个 Consumer 消费(消费者负载均衡机制)。

- ISR(In-Sync Replica,同步副本集合,保证消息可靠性):每个 Partition 维护一个 ISR 列表,包含 Leader 和(与 Leader 保持同步的 )Follower 副本。

- 可靠性机制:

- 生产者发送消息到 Leader,Leader 写入日志后,等待 ISR 中所有 Follower 确认接收;

- 若 Leader 崩溃,Kafka 从 ISR 中选举新 Leader,确保已确认的消息不丢失;

- 通过

acks参数可配置可靠性级别:acks=0:生产者不等待确认,速度最快但可能丢消息;acks=1(默认):Leader 确认即返回,Follower 未同步时可能丢消息;acks=-1/all:ISR 全确认才返回,可靠性最高但延迟增加。

Kafka流程

Kafka是一种高吞吐量的分布式消息队列。简单来说,它就像一个超级大的消息中转站,能高效地处理大量消息。

它的主要组件有生产者、消费者和Broker。生产者就是消息的发送方,比如一个电商系统里,订单创建、支付等操作都能作为生产者,把相关消息发送到Kafka。消费者呢,就是接收消息的一方,像订单处理系统、数据分析系统等,会从Kafka里读取消息进行相应处理。Broker是Kafka集群中的服务器节点,负责存储和管理消息。

工作机制大致是这样的:生产者把消息发送到Kafka集群的某个主题下,每个主题可以有多个分区。消息会被顺序写入分区里。消费者从分区里按顺序读取消息。而且消费者可以组成消费组,同一个消费组里的消费者会分摊消费消息,不同消费组之间是独立的。

比如,一个电商系统里,订单创建消息发送到“order - topic”主题,有两个分区。有一个消费组A,包含三个消费者,那这三个消费者会分摊读取这个主题下的消息;另一个消费组B,只有一个消费者,那这个消费者就会读取所有消息。这样就可以根据业务需求灵活配置,实现不同的消息处理逻辑啦。

Kafka 如何保证消息不丢失?

- 生产者:acks=all + 重试机制;

- Broker:副本数≥2,ISR 副本同步;

- 消费者:手动提交 offset,处理完业务再提交。

解释:acks=all 呢,就是生产者发送消息后,需要等所有副本都确认收到消息了,才会认为消息发送成功。要是有副本没收到,生产者就会重新发送,这就是重试机制。这样能保证消息至少被发送成功一次。

Broker副本数大于等于2,就是说消息会被复制多份存到不同的Broker上,这样就算有个别Broker挂了,其他Broker上还有消息副本。ISR副本同步呢,ISR是指那些和Leader副本保持同步的副本集合,Kafka会保证这些同步的副本里都有消息,进一步保证消息不丢。

消费者手动提交offset,offset就是消息的偏移量,代表已经消费到哪里了。手动提交就是等业务处理完了再告诉Kafka这个偏移量,要是还没处理完就挂了,下次重启就可以从上次提交的位置接着消费,不会丢消息。要是自动提交,万一处理业务时出错了,消息可能就丢啦。

在Kafka里,每个分区都有一个Leader副本,生产者发送消息、消费者读取消息,默认都是和Leader副本打交道。其他副本就是Follower副本,它们会复制Leader副本的消息,和Leader保持数据同步。这样做是为了保证高可用性,要是Leader副本出问题了,Kafka会从Follower副本里选一个新的Leader,继续提供服务。

当Leader副本出问题,Zookeeper会检测到,然后触发选举。一般情况下,Kafka会选择ISR列表里第一个存活的Follower副本作为新的Leader。这样能保证新的Leader和原来的Leader数据差异最小,尽量减少数据丢失。不过这个选举过程挺复杂的,涉及到很多状态的切换和协调,Zookeeper会确保整个过程有序进行。

Zookeeper/Kraft协议选举范围:

broker角色分工:leader(处理主要的读写请求和管理工作)、follower(复制leader的数据,必要时参与选举成为新leader)、observer(辅助增强读性能,不参与选举)

broker中的分区的leader副本、follower副本

Kafka 分区(Partition)的作用?如何实现消息顺序消费?

- 分区提升并发处理能力,同一分区内消息有序;

- 顺序消费方案:按业务 ID 哈希路由到固定分区,消费者单线程处理。(多线程的话:考虑消息带顺序号,用全局的有序队列来协调各个线程,确保消息按整体顺序处理)

消息会被不同消费者重复消费吗?

一般情况下不会。Kafka的设计是让每个分区只能被一个消费者组里的一个消费者消费。这样就能保证消息被消费一次。不过在一些特殊配置或者故障情况下,可能会出现重复消费。比如消费者在处理完消息但还没来得及提交消费偏移量的时候挂了,新的消费者可能就会再次消费这条消息。不过可以通过一些机制来处理这种情况,比如在业务逻辑里用唯一ID去过滤重复消息。

选举:

每次有新的事务操作,Zookeeper的zxid / KRaft协议的LID 都会增加, 这个越大意味着当前broker节点数据更新,更适合当新的leader。

先说说Zookeeper吧。当Leader挂了,剩下的Follower节点会进入选举状态。它们会各自增加自己的事务ID(zxid),然后向其他节点发送包含自己zxid和节点ID的投票信息。收到投票的节点会比较zxid大小,如果发现收到的zxid更大,就会更新自己的投票信息并转发。当某个节点收集到超过半数节点的投票,且这些投票的zxid都不小于自己的zxid时,它就会成为新的Leader。Observer节点因为不参与投票,所以在这个过程中主要是接收新Leader的通知并同步数据。

再看KRaft协议。假设集群有n个Broker,当Leader故障,只要有超过半数(n/2向上取整)的Broker正常,选举就能进行。某个最先发现Leader故障的Broker会发起选举,它向其他Broker发送选举请求,里面包含自己的逻辑时钟(LID)。其他Broker收到请求后,如果自己的LID小于请求的LID,就会回复同意。当发起选举的Broker收到超过半数Broker的同意回复,它就会成为新的Leader。Observer节点在选举时不参与投票,但选举完成后会和其他Follower一样,从新Leader同步数据。

如果没收到超过半数同意回复,它就会等一会儿,然后再发起新一轮选举。在等待的这段时间里,它会继续监听其他Broker的状态。要是在这期间有其他Broker发起选举,而且那个Broker的LID更大,那它就会放弃这次选举,转而支持LID更大的那个Broker。这样不断尝试,直到有一个Broker能收集到足够多的同意回复,成为新的Leader。

Kafka如何保证消费的幂等性

幂等性指多次执行相同操作的结果与执行一次相同,即避免重复消费导致的数据不一致。在 Kafka 中,消费端幂等性需解决以下问题:

- 生产者重复发送消息(如网络抖动导致的重试)。

- 消费者重启后重复拉取(如偏移量未及时提交)。

面试高频问题与回答要点

-

Kafka 如何保证幂等性?

- 答:通过三层机制:生产者幂等性(PID + 序列号)保证单分区去重,事务机制(Transaction ID+2PC)支持跨分区一致性,消费端通过唯一 ID 或状态缓存实现最终幂等。

-

生产者幂等性和事务的区别?

- 答:幂等性仅作用于单分区,且不支持跨会话;事务通过 Transaction ID 和协调器实现跨分区、跨会话的幂等,需 2PC 流程,开销更高。

-

消费端如何处理重复消息?

- 答:可通过消息唯一 ID(如业务主键)结合 Redis 缓存去重,或在数据库设计中利用唯一索引 / 主键冲突避免重复插入,同时需保证偏移量提交与业务处理的原子性(如使用事务绑定)。

幂等性的核心设计原则

- 生产者优先:能用 Producer 幂等性或事务解决的场景,避免在消费端增加复杂度。

- 消费端兜底:对于跨系统、历史数据等场景,必须在消费端实现去重逻辑。

- 性能与一致性平衡:事务机制适合金融等强一致性场景,日志类场景可优先使用幂等生产者降低开销。

Kafka 与 RabbitMQ 的区别?

- Kafka:(把消息分散到多个分区存储)高吞吐量、分布式流处理,适合日志 / 监控数据;

- RabbitMQ:(FIFO、一个队列就是一条消息序列)灵活路由(Direct/Topic 等模式)、支持事务,适合企业级业务消息。

Kafka Steam VS Flink

| 维度 | Kafka Stream | Flink |

|---|---|---|

| 定位 | Kafka 内置流处理库,与 Kafka 深度集成 | 独立的分布式流处理框架,支持批流统一 |

| 部署方式 | 嵌入应用程序或作为 Kafka 插件运行 | 独立集群部署,支持 YARN/Kubernetes |

| 状态管理 | 轻量级状态,依赖 Kafka Topic 存储 | 完整状态后端(如 RocksDB、内存),支持大状态 |

| 窗口语义 | 支持时间窗口、会话窗口,但功能较简单 | 支持更复杂的窗口操作(如滑动窗口、全局窗口) |

| 生态整合 | 仅与 Kafka 生态集成 | 支持对接多种数据源(Kafka、MySQL、HDFS 等) |

消息队列

| 特性 | Kafka | RabbitMQ | RocketMQ |

|---|---|---|---|

| 吞吐量 | 高(百万级 / 秒) | 中(万级 / 秒) | 高(十万级 / 秒) |

| 消息顺序性 | 分区内有序 | 可保证(队列+路由) | 队列内有序 |

| 可靠性 | 高(多副本机制) | 高(持久化 + ACK 机制) | 高(多副本 + 持久化) |

| 应用场景 | 大数据流处理、日志收集 | 复杂业务逻辑、低延迟场景 | 金融交易、电商订单系统 |

| 技术栈 | Java/Scala | Erlang | Java |

进程 VS 线程 VS 协程

| 维度 | 进程(Process) | 线程(Thread) | 协程(Coroutine) |

|---|---|---|---|

| 本质 | 操作系统分配资源的最小单位 | 操作系统调度执行的最小单位 | 用户态轻量级执行单元(由编程语言或框架实现) |

| 资源分配 | 拥有独立的地址空间、内存、文件句柄等资源 | 共享进程的资源(如地址空间、堆内存) | 共享线程的资源(如栈、寄存器状态) |

| 调度方式 | 由操作系统内核调度,上下文切换开销大 | 由操作系统内核调度,上下文切换开销较小 | 由用户态程序(如框架)控制,上下文切换开销极低 |

| 并发性 | 多进程并发通过操作系统调度实现 | 多线程并发通过操作系统调度实现 | 单线程内通过协程调度器实现 “伪并发” |

| 典型应用 | 独立运行的程序(如浏览器、数据库服务) | 程序内并发任务(如 Web 服务器处理多请求) | 高 IO 密集型场景(如网络爬虫、消息处理) |

Spring AOP(面向切面编程)

将横切关注点(如日志、事务)与业务逻辑分离

- 切面(Aspect):封装横切关注点的类,包含通知和切点

- 通知(Advice):在特定连接点执行的代码(Before/After/Around/AfterReturning/AfterThrowing)

- 连接点(JoinPoint):程序执行过程中的点(如方法调用、异常抛出)

- 切点(Pointcut):定义匹配连接点的表达式(如

execution(* com.example.service.*.*(..))) - 织入(Weaving):将切面逻辑插入到目标对象的过程(编译时 / 加载时 / 运行时)

实现方式

- 静态代理:编译时生成代理类(如 AspectJ)。在静态代理中,代理类和被代理类都要实现同一个接口或继承同一个父类,代理类中包含了被代理类的实例,并在调用被代理类的方法前后执行相应的操作。缺点:需要为每个被代理类编写一个代理类,当被代理类的数量增多时,代码量会变得很大。

- 动态代理:运行时生成代理对象(如 Spring AOP)。在动态代理中,代理类不需要实现同一个接口或继承同一个父类,而是通过 Java 反射机制动态生成代理类,并在调用被代理类的方法前后执行相应的操作。优点是可以为多个被代理类生成同一个代理类,从而减少了代码量,缺点是实现复杂。

- JDK 动态代理:基于接口,要求被代理的类必须实现一个接口,它通过反射来接收被代理的类,并使用java.lang.reflect.InvocationHandler 接口和 java.lang.reflect.Proxy 类实现代理。Spring AOP 默认使用 JDK 的 java.lang.reflect.Proxy 类。通过 Proxy.newProxyInstance() 方法来创建代理类的实例。该方法接受三个参数:类加载器、代理类要实现的接口列表和 InvocationHandler 对象。

- CGLIB 代理:基于类继承(CGLIB是一个代码生成的类库,在运行时通过字节码技术动态地生成某个类的子类)。通过 Enhancer.create() 方法来创建代理类的实例。该方法接受一个类作为参数,表示要代理的类。

- CGLIB 动态代理无法代理 final 类和 final 方法;JDK 动态代理可以代理任意类。

典型场景

- 事务管理:

@Transactional注解基于 AOP 实现 - 日志记录:统一记录方法调用前后的日志

- 权限验证:方法调用前验证用户权限

- 缓存处理:方法调用前后操作缓存

- 异常处理:统一捕获和处理异常

Spring 动态代理失效的场景有哪些?

- 直接使用new关键字创建对象

- 内部方案调用,例如@Transactional注解失效(因为内部调用不会经过代理对象,直接调用了目标方法,没办法触发代理里的增强逻辑)

- 没有实现接口,用了CGLIB代理,proxy-target-class=false(禁用CGLIB代理)

Spring Boot 动态代理默认实现是 JDK 动态代理还是 CGLIB?怎么证明?

默认情况下,如果被代理对象实现了接口,就用JDK动态代理;要是没实现接口,就会用CGLIB代理。

Spring IOC(控制反转)/ DI(依赖注入)

- 控制反转(IOC):将对象的创建和管理控制权从代码转移到容器(IoC容器:负责创建和管理对象,以及解决对象之间的依赖关系)。

- 依赖注入(DI):通过容器将依赖对象注入到需要的组件中。

- 依赖查找(Dependency Lookup):通过容器提供的 API手动查找和获取所需依赖对象,例如 ApplicationContext.getBean() 。

实现方式

- 构造器注入:通过构造函数注入依赖

- Setter 注入:通过 setter 方法注入依赖

- 字段注入:通过注解(如 @Autowired查找类型匹配的bean、@Qualifier指定要注入的bean名称 和 @Value属性值注入)直接注入字段

- 接口注入:通过实现特定接口声明依赖

典型场景

- Spring 容器管理 Bean @Service @Autowired or 构造方法

- 配置外部化 @Configuration @Bean

- 测试解耦 @MockBean @Autowired

Spring框架

Spring 框架是一个用于构建企业级 Java 应用程序的开源框架。

以下是 Spring 框架的一些核心特点:

- 轻量级:Spring 框架采用了松耦合的设计原则,仅依赖于少量的第三方库,因此它是一个轻量级的框架。开发人员可以根据需要选择使用 Spring 的特定功能,而无需引入整个框架。

- 控制反转(IoC):Spring 框架通过控制反转(IoC)容器管理应用程序中的对象及其依赖关系。通过 IoC 容器,开发人员可以将对象的创建、组装和生命周期管理交给 Spring 框架处理,从而实现了松耦合和可测试性。

- 面向切面编程(AOP):Spring 框架支持面向切面编程,可以通过 AOP 在应用程序中实现横切关注点的模块化。例如,日志记录、事务管理和安全性等横切关注点可以通过 AOP 进行集中处理,而不会侵入业务逻辑的代码。

- 声明式事务管理:Spring 框架提供了声明式事务管理的支持。通过使用注解或 XML 配置,开发人员可以将事务管理逻辑与业务逻辑分离,并且可以轻松地在方法或类级别上应用事务。

- 框架整合:Spring 框架可以与许多其他开源框架和技术无缝集成,如 Hibernate、MyBatis、JPA、Struts 和 JSF 等。这使得开发人员可以使用 Spring 框架来整合和协调不同的技术,构建全面的企业应用程序。

- 测试支持:Spring 框架提供了广泛的测试支持,包括单元测试和集成测试。它提供了一个专门的测试上下文,可以轻松地编写和执行单元测试,以验证应用程序的行为和功能。例如:@ContextConfiguration(加载配置文件,设置测试用的数据源)和@SpringBootTest(开启Spring测试上下文)、@MockBean(创建模拟对象,隔离外部依赖)

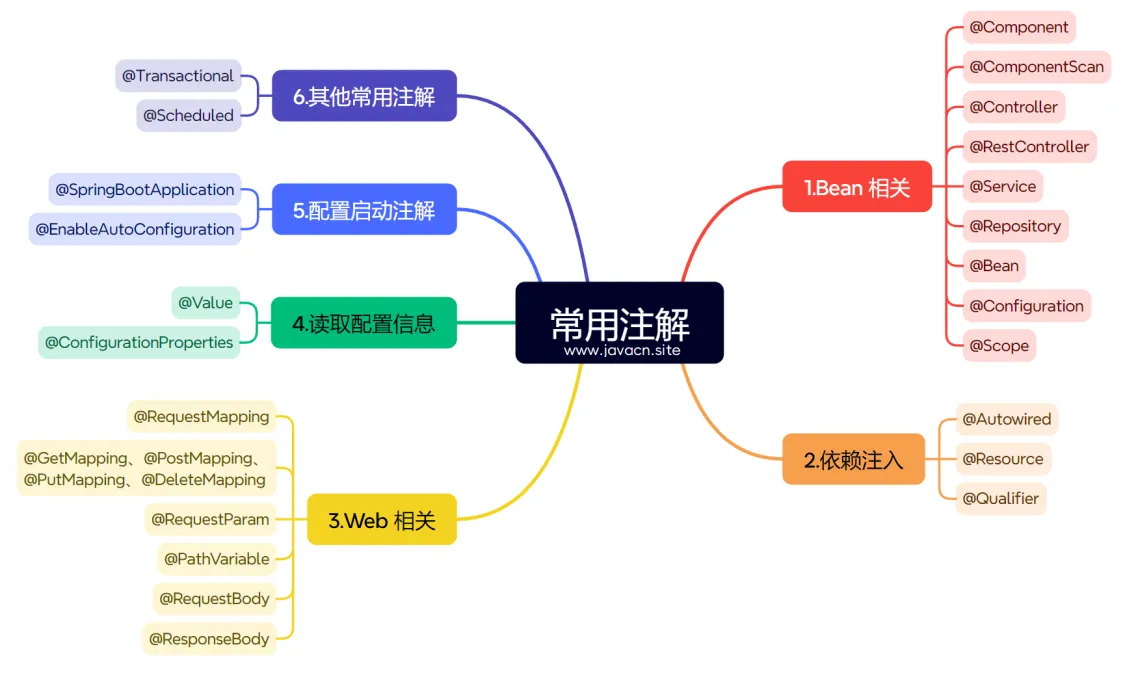

Spring 容器核心组件(常见注解)

- BeanFactory:基础 IOC 容器,负责创建和管理 Bean

- ApplicationContext:高级容器,扩展了 BeanFactory 的功能(如事件发布、国际化)

- @Component:通用组件注解,被 Spring 扫描并注册为 Bean

- @Service、@Repository(持久层)、@Controller:特定场景的组件注解

- @Configuration:配置类注解,声明 Bean 定义方法

scope(Spring Bean 实例的作用域)分为:

- singleton (默认单例):整个应用容器中只会创建一个bean实例,所有对该bean的引用都指向同一个实例。

- prototype (原型/多例):每次请求bean时都会创建新实例,适用于有状态的bean(如需要保存用户会话数据)。

- request (请求):在一次HTTP请求中共享同一个bean实例,请求结束后销毁,仅用于Web环境。

- session (会话):在同一个HTTP会话中共享bean实例,会话结束后销毁,仅用于Web环境。

- application (应用):在一个 ServletContext 中只存在一个 Bean 实例。该作用域只在 Spring ApplicationContext 上下文中有效。

- websocket:在一个 WebSocket 中只存在一个 Bean 实例。该作用域只在 Spring ApplicationContext 上下文中有效。

配置启动注解

1.@SpringBootApplication:用于标识 SpringBoot 应用程序的入口类。它是一个组合注解,包括了 @Configuration、@EnableAutoConfiguration 和 @ComponentScan 三个注解。

@SpringBootApplication

public class DemoApplication {

public static void main(String[] args) {

SpringApplication.run(DemoApplication.class, args);

}

}

2.@EnableAutoConfiguration:启用 Spring Boot 的自动配置机制,根据添加的依赖和配置文件自动配置 Spring 应用。

有状态bean VS 无状态bean

在软件开发中,有状态 bean和无状态 bean的核心区别在于是否保存 “状态数据”,具体对比如下:

| 维度 | 有状态 bean | 无状态 bean |

|---|---|---|

| 状态存储 | 包含可变成员变量,保存状态 | 无成员变量或仅含不可变变量,无状态 |

| 线程安全性 | 多线程访问需额外同步机制(易冲突) | 天然线程安全(无状态修改风险) |

| 复用性 | 状态与特定上下文绑定,复用性低 | 无状态依赖,可全局复用 |

| 典型场景 | 会话管理、购物车、用户偏好设置 | 工具类、服务层逻辑处理、无状态计算 |

框架中的应用

- Spring 框架:

- 单例 bean 默认设计为无状态(如

@Service/@Controller),避免多线程状态冲突。 - 有状态 bean 需显式配置为

prototype作用域(每次请求创建新实例)。

- 单例 bean 默认设计为无状态(如

- EJB(Enterprise JavaBeans):

- 有状态会话 Bean(Stateful Session Bean):保存特定客户端的状态,每个客户端对应一个实例。

- 无状态会话 Bean(Stateless Session Bean):不保存状态,可被多个客户端共享。

总结

- 无状态 bean 因线程安全、易复用,是框架设计的首选;

- 有状态 bean 需谨慎使用,通常通过原型模式或线程同步机制避免状态问题。

Bean的生命周期

在 Spring 中,Bean 的生命周期指的是 Bean 实例从创建到销毁的整个过程。Spring 容器负责管理 Bean 的生命周期,包括实例化、属性赋值、初始化、使用、销毁等过程。

Bean 的生命周期可以分为以下几个阶段:

实例化:在 Spring 容器启动时,会根据配置文件或注解等方式创建 Bean 的实例,也就是说实例化就是为 Bean 对象分配内存空间。根据 Bean 的作用域不同,实例化的方式也不同。例如,singleton 类型的 Bean 在容器启动时就会被实例化,而 prototype 类型的 Bean 则是在每次请求时才会被实例化。

属性赋值:在 Bean 实例化后,Spring 容器会自动将配置文件或注解中指定的属性值注入到 Bean 中。属性注入可以通过构造函数注入、Setter 方法注入、注解注入等方式实现。

初始化:在属性注入完成后,Spring 容器会调用 Bean 的初始化方法。Bean 的初始化方法可以通过实现 InitializingBean 接口、@PostConstruct 注解等方式实现。在初始化方法中,可以进行一些初始化操作,例如建立数据库连接、加载配置文件等。

使用:在 Bean 初始化完成后,Bean 就可以被应用程序使用了。在应用程序中,可以通过 Spring 容器获取 Bean 的实例,并调用 Bean 的方法。

销毁:在应用程序关闭时,Spring 容器会自动销毁所有的 Bean 实例。Bean 的销毁方法可以通过实现 DisposableBean 接口、@PreDestroy 注解等方式实现。在销毁方法中,可以进行一些清理操作,例如释放资源、关闭数据库连接等。

- 生命周期回调接口: BeanNameAware 、 BeanFactoryAware 、 InitializingBean (调用afterPropertiesSet() 方法)、 DisposableBean (调用destroy() 方法)。

- 注解回调: @PostConstruct (初始化后)、 @PreDestroy (销毁前)。

- 配置方式:XML中的 init-method 和 destroy-method ,或 @Bean 注解的 initMethod 、 destroyMethod 参数。

- 若Bean实现了 BeanNameAware 接口,会调用 setBeanName(String name) 方法,注入Bean的名称。

- 若实现了 BeanFactoryAware 接口,会调用 setBeanFactory(BeanFactory factory) 方法,注入容器实例。

- 若实现了 ApplicationContextAware 接口,会调用 setApplicationContext(ApplicationContext ctx) 方法,注入应用上下文。

如何保证单例Bean的线程安全

Spring 默认的 Bean 是单例模式,意味着容器中只有一个 Bean 实例,所有的线程都会使用并操作这个唯一的 Bean 实例,那么多个线程同时调用修改这个单例 Bean,就会产生线程安全问题。

有状态的单例 Bean 是非线程安全的,而无状态的 Bean 是线程安全的。

Spring 中保证单例 Bean 线程安全的手段有以下几个:

- 变为原型 Bean:在 Bean 上添加 @Scope("prototype") 注解,将其变为多例 Bean。这样每次注入时返回一个新的实例,避免竞争。

- 加锁:在 Bean 中对需要同步的方法或代码块添加同步锁 @Synchronized 或使用 Java 中的线程同步工具 ReentrantLock 等。

- 使用线程安全的集合/数据结构(可以参考:线程安全的数据结构)/Atomic家族例如AtomicInteger(.incrementAndGet(),.get()):如 Vector、Hashtable 代替 ArrayList、HashMap 等非线程安全集合。

- 变为无状态 Bean:不在 Bean 中保存状态,让 Bean 成为无状态 Bean。无状态的 Bean 没有共享变量,自然也无须考虑线程安全问题。

- 使用线程局部变量 ThreadLocal:在方法内部使用线程局部变量 ThreadLocal,因为 ThreadLocal 是线程独享的,所以也不存在线程安全问题。(使用 ThreadLocal 需要注意一个问题,在用完之后记得调用 ThreadLocal 的 remove 方法,不然会发生内存泄漏问题。)

@Autowired注解实现原理

Spring 中的 @Autowired 注解是通过依赖注入(DI)实现的。

当 Spring 容器启动时,它会扫描应用程序中的所有 Bean,并将它们存储在一个 BeanFactory 中。当应用程序需要使用某个 Bean 时,Spring 容器会自动将该 Bean 注入到应用程序中。

但再往底层说,DI 是通过 Java 反射机制实现的。具体来说,当 Spring 容器需要注入某个 Bean 时,它会使用 Java 反射机制来查找符合条件的 Bean,并将其注入到应用程序中。

所以说,@Autowired 注解是通过 DI 的方式,底层通过 Java 的反射机制来实现的。

@Autowired VS @Resource

用来实现依赖注入的注解(在 Spring/Spring Boot 项目中),但二者却有着 5 点不同:

- 来源不同:@Autowired 来自 Spring 框架,而 @Resource 来自于(Java)JSR-250;

- 依赖查找的顺序不同:@Autowired 先根据类型再根据名称查询,而 @Resource 先根据名称再根据类型查询;

- 支持的参数不同:@Autowired 只支持设置 1 个参数-required,而 @Resource 支持设置 7 个参数-name-type;

- 依赖注入的用法支持不同:@Autowired 既支持构造方法注入,又支持属性注入和 Setter 注入,而 @Resource 只支持属性注入和 Setter 注入;

- 编译器 IDEA 的提示不同:当注入 Mapper 对象时,使用 @Autowired 注解编译器会提示错误,而使用 @Resource 注解则不会提示错误。

BeanFactory VS FactoryBean

- 功能:BeanFactory 是一个容器,负责管理和创建 Bean 实例,处理依赖关系和属性注入等操作。FactoryBean 是一个接口,定义了创建 Bean 的规范和逻辑,它负责创建其他 Bean 实例。

- 使用方式:BeanFactory 使用配置文件或注解来定义 Bean 和它们之间的关系,它使用延迟初始化策略,即只有在需要时才创建 Bean 实例。FactoryBean 通常在 Spring 配置文件中配置,并由 BeanFactory 负责实例化和管理。

- 创建的对象:BeanFactory 创建和管理普通的 Bean 实例,而 FactoryBean 创建其他 Bean 实例。

- 灵活性:FactoryBean 具有更高的灵活性,因为它允许自定义的逻辑来创建和配置 Bean 实例。FactoryBean 的实现类可以根据特定的条件选择性地创建不同的 Bean 实例,或者在创建 Bean 之前进行一些初始化操作。这使得 FactoryBean 在某些情况下比 BeanFactory 更加强大和可扩展。

- 返回类型:BeanFactory 返回的是 Bean 实例本身,而 FactoryBean 返回的是由 FactoryBean 创建的 Bean 实例。因此,当使用 FactoryBean 时,需要通过调用 getObject() 方法来获取创建的 Bean 实例。

- FactoryBean 接口定义了三个方法:getObject()、getObjectType() 和 isSingleton()。getObject() 方法返回由 FactoryBean 创建的 Bean 实例,getObjectType() 方法返回创建的Bean的类型,而 isSingleton() 方法用于指示创建的 Bean 是否是单例。

Spring常见设计模式

1.工厂模式

工厂模式是一种创建型设计模式,它提供了一种创建对象的方式,使得应用程序可以更加灵活和可维护。在 Spring 中,FactoryBean 就是一个工厂模式的实现,使用它的工厂模式就可以创建出来其他的 Bean 对象。

2.单例模式

单例模式是一种创建型设计模式,它保证一个类只有一个实例,并提供了一个全局访问点。在 Spring 中,Bean 默认是单例的,这意味着每个 Bean 只会被创建一次,并且可以在整个应用程序中共享。

3.代理模式

代理模式是一种结构型设计模式,它允许开发人员在不修改原有代码的情况下,向应用程序中添加新的功能。在 Spring AOP(面向切面编程)就是使用代理模式的实现,它允许开发人员在方法调用前后执行一些自定义的操作,比如日志记录、性能监控等。

4.观察者模式

观察者模式是一种行为型设计模式,它定义了一种一对多的依赖关系,使得当一个对象的状态发生改变时,所有依赖于它的对象都会得到通知并自动更新。Spring 事件驱动模型使用观察者模式,ApplicationEventPublisher 事件发布者将事件发布给 ApplicationEventMulticaster 事件广播器,该广播器将事件派发给 @EventListener 注解的事件监听者。

5.模板方法模式

模板方法模式是一种行为型设计模式,它定义了一个算法的骨架,将一些步骤延迟到子类中实现。在 Spring 中,JdbcTemplate 就是一个模板方法模式的实现,它提供了一种简单的方式来执行 SQL 查询和更新操作。

6.适配器模式

适配器模式是一种结构型设计模式,它允许开发人员将一个类的接口转换成另一个类的接口,以满足客户端的需求。在 Spring 中,适配器模式常用于将不同类型的对象转换成统一的接口,比如将 Servlet API 转换成 Spring MVC 的控制器接口。

7.策略模式

策略模式是一种行为型设计模式,它定义了一系列算法,并将每个算法封装起来,使得它们可以互相替换。Spring 中的 TaskExecutor,TaskExecutor 提供了很多实现,比如以下这些:

- SyncTaskExecutor:直接在调用线程中执行任务,没有真正的异步;

- SimpleAsyncTaskExecutor:使用单线程池异步执行任务;

- ConcurrentTaskExecutor:使用线程池异步执行任务;

- SimpleTransactionalTaskExecutor:支持事务的 SimpleAsyncTaskExecutor。 这样,我们可以根据自己的需求选择不同的实现策略,使用策略模式的好处有以下这些:

- 可以在不修改原代码的基础上选择不同的算法或策略;

- 可减少程序中的条件语句,根据环境改变选择合适的策略;

- 扩展性好,如果有新的策略出现,只需要创建一个新的策略类,无须修改原代码。

Spring MVC (Model-View-Controller) VS Spring Boot VS Spring Cloud

| 维度 | Spring MVC | Spring Boot | Spring Cloud |

|---|---|---|---|

| 核心目标 | 构建 Web 应用 | 简化 Spring 应用开发 | 构建分布式微服务系统 |

| 技术定位 | 表现层框架(MVC) | 应用开发平台 | 微服务工具集 |

| 依赖管理 | 需手动配置大量依赖 | 起步依赖自动管理 | 基于 Spring Boot Starter |

| 部署方式 | WAR 包部署到外部容器 | 独立 JAR(内置服务器) | 通常容器化部署(Docker/K8s) |

| 核心组件 |

|

|

|

| 典型场景 | 传统/单体 Web 应用(前后端不分离)、REST API、表单提交与页面渲染 |

快速搭建独立应用

|

微服务架构下的服务治理

|

| 配置方式 | XML 或 Java Config | 自动配置 + application.properties | 集中配置中心(Config Server) |

| 服务发现 | 无 | 无 | 支持(Eureka/Nacos 等) |

| 负载均衡 | 需依赖外部负载均衡器(如 Nginx) | 无 | 客户端负载均衡(Ribbon) |

- 推荐使用 Spring Initializr(https://start.spring.io) 生成项目,自动处理版本依赖,不过默认生成的项目结构包含视图层配置

- 注意版本依赖需保持一致

- maven依赖冲突:通过mvn

dependency:tree (-Dincludes=groupId:artifactId)命令找出冲突的依赖,接着利用<dependencyManagement>统一管理版本,再通过<exclusions>排除冲突依赖或者显式指定版本来解决问题,最后验证调整后的结果mvn dependency:tree | grep conflicting-library。 - 分析依赖冲突mvn dependency:analyze

- 查看有效POM(包含继承和插值后的完整配置) mvn help:effective-pom

Spring VS SpringBoot

Spring 是一个轻量级的开源框架,它提供了一种简单的方式来构建企业级应用程序。Spring Boot 则是 Spring 框架的延伸和扩展,它提供了一种快速构建应用程序的方式。开发人员可以通过使用 Spring Boot Starter 来快速集成常用的第三方库和框架,使得开发人员可以快速构建出一个可运行的应用程序。

Spring Boot

- 简化配置: Spring Boot 采用约定大于配置的原则,提供了自动配置的特性,大部分情况下无需手动配置,可以快速启动和运行应用程序。同时,Spring Boot 提供了统一的配置模型,集成了大量常用的第三方库和框架,简化了配置过程。

- 内嵌服务器: Spring Boot 集成了常用的内嵌式服务器,如 Tomcat、Jetty 和 Undertow 等。这意味着不再需要单独安装和配置外部服务器,可以直接运行 Spring Boot 应用程序,简化了部署和发布过程。

- 自动装配: Spring Boot 提供了自动装配机制,根据应用程序的依赖关系和配置信息,智能地自动配置 Spring 的各种组件和功能,大大减少了开发人员的手动配置工作,提高了开发效率。

- 起步依赖: Spring Boot 引入了起步依赖(Starter Dependencies)的概念,它是一种可用于快速集成相关技术栈的依赖项集合。起步依赖能够自动处理依赖冲突和版本兼容性,并提供了默认的配置和依赖管理,简化了构建和管理项目的过程。

- 自动化监控和管理: Spring Boot 集成了 Actuator 模块,提供了对应用程序的自动化监控、管理和运维支持。通过 Actuator,可以获取应用程序的健康状况、性能指标、配置信息等,方便运维人员进行故障排查和性能优化。

- 丰富的生态系统: Spring Boot 建立在 Spring Framework 的基础上,可以无缝集成 Spring 的各种功能和扩展,如 Spring Data、Spring Security、Spring Integration 等。同时,Spring Boot 还提供了大量的第三方库和插件,可以方便地集成其他技术栈,构建全栈式应用程序。

- 可扩展性和灵活性: 尽管 Spring Boot 提供了很多自动化的功能和约定,但它也保持了良好的可扩展性和灵活性。开发人员可以根据自己的需求进行自定义配置和扩展,以满足特定的业务需求。

面试题:springboot为什么要搞内嵌服务器以及自动装配?

Spring Boot内嵌服务器主要是为了简化部署和提高开发效率。以前用传统的Spring项目,部署war包到外部服务器,像Tomcat,过程挺繁琐的。有了内嵌服务器,比如内嵌Tomcat、Jetty,直接打成可执行的jar包,一个命令就能启动项目,超级方便。

原理上呢,Spring Boot在打包时会把内嵌服务器的依赖都包含进去,启动时它会创建服务器实例,加载必要的配置,绑定端口。比如内嵌Tomcat,它会初始化Tomcat的类加载器、连接器这些组件,然后把Spring MVC相关的处理器等注册到服务器里。这样,项目一启动,服务器也就跟着运行起来,能接收和处理HTTP请求啦。

简单来说,Spring Boot的自动装配就是它能根据项目的依赖和配置,自动帮你把一些组件初始化并配置好。比如你在项目里加了Spring Web的依赖,它就会自动装配好Web相关的配置,像DispatcherServlet这些,你不用自己手动去配置很多东西啦。

原理呢,它是通过大量的条件注解和自动配置类实现的。Spring Boot会扫描classpath下的一些特定的类,根据类路径和依赖情况,判断是否满足自动装配的条件。要是满足,就会把对应的组件初始化并加入到Spring容器里。比如 Spring Data JPA ,只要你加了相关依赖,它就能根据你的实体类和数据库连接信息,自动配置好JPA的相关组件,让你方便地操作数据库。这样大大减少了样板代码,开发效率就提高啦。

Docker大全

一、镜像操作

1. 构建镜像

docker build -t <镜像名>:<标签> <构建上下文路径>

# 示例:从当前目录的Dockerfile构建镜像

docker build -t myapp:v1 .

2. 查看本地镜像

docker images # 查看所有本地镜像

docker image ls -q # 只显示镜像ID

3. 删除镜像

docker rmi <镜像ID> 或 <镜像名>:<标签>

# 强制删除(忽略依赖)

docker rmi -f <镜像ID>

4. 拉取 / 推送镜像

docker pull <镜像名>:<标签> # 从Registry拉取

docker push <镜像名>:<标签> # 推送至Registry

5. 保存 / 加载镜像

docker save <镜像名> > 镜像.tar # 导出镜像为文件

docker load -i 镜像.tar # 从文件导入镜像

二、容器操作

1. 运行容器

docker run [选项] <镜像名> [命令]

# 示例:后台运行并映射端口

docker run -d -p 8080:8080 myapp:v1

# 示例:交互式运行并挂载目录

docker run -it -v /本地路径:/容器路径 ubuntu bash

2. 查看容器

docker ps # 查看运行中的容器

docker ps -a # 查看所有容器(包括已停止的)

3. 停止 / 启动 / 重启容器

docker stop <容器ID或名称>

docker start <容器ID或名称>

docker restart <容器ID或名称>

4. 删除容器

docker rm <容器ID或名称>

# 删除所有已停止的容器

docker container prune

5. 进入容器

docker exec -it <容器ID或名称> bash # 进入交互式终端

# 示例:查看Nginx容器内部文件

docker exec -it nginx-container ls /etc/nginx

6. 查看容器日志

docker logs <容器ID或名称>

# 实时跟踪日志

docker logs -f <容器ID或名称>

三、网络管理

1. 查看网络

docker network ls # 查看所有网络

docker network inspect <网络名> # 查看网络详情

2. 创建网络

docker network create --driver bridge my-network

3. 运行容器并连接到网络

docker run -d --network my-network myapp:v1

四、数据卷管理

1. 创建数据卷

docker volume create my-volume

2. 查看数据卷

docker volume ls

docker volume inspect my-volume

3. 挂载数据卷

docker run -d -v my-volume:/data myapp:v1

五、其他常用命令

1. 查看系统信息

docker info # 查看Docker系统信息

docker stats # 实时监控容器资源使用

2. 清理资源

docker system prune # 清理临时文件、未使用镜像等

# 彻底清理(包括数据卷)

docker system prune -a --volumes

3. 查看容器进程

docker top <容器ID或名称>

4. 复制文件

docker cp <容器ID或名称>:<容器路径> <本地路径> # 从容器复制到本地

docker cp <本地路径> <容器ID或名称>:<容器路径> # 从本地复制到容器

六、常用选项速查表

|

选项 |

说明 |

示例 |

|---|---|---|

|

|

后台运行容器 |

|

|

|

端口映射(主机:容器) |

|

|

|

挂载卷 |

|

|

|

设置环境变量 |

|

|

|

指定容器名称 |

|

|

|

自动重启策略 |

|

|

|

交互式终端 |

|

七、实战示例

1. 运行 Nginx 服务器

docker run -d -p 80:80 --name webserver nginx

2. 运行 MySQL 数据库

docker run -d \

-p 3306:3306 \

-e MYSQL_ROOT_PASSWORD=password \

-e MYSQL_DATABASE=mydb \

--name mysql \

mysql:8.0

3. 构建并运行自定义应用

# 构建镜像

docker build -t myapp:v1 .

# 运行容器

docker run -d -p 8080:8080 myapp:v1Dockerfile

用于定义和自动化构建 Docker 镜像的文本文件

| 指令 | 功能 | 示例 |

|---|---|---|

FROM |

指定基础镜像 | FROM ubuntu:20.04 |

RUN |

执行命令(如安装软件) | RUN apt-get update && apt-get install -y python3 |

COPY |

复制本地文件到镜像 | COPY app.py /app/ |

ADD |

复制文件(支持远程 URL 和自动解压) | ADD https://example.com/file.txt /app/ |

CMD |

容器启动时执行的默认命令 | CMD ["python3", "app.py"] |

ENTRYPOINT |

配置容器启动时的执行命令 | ENTRYPOINT ["/usr/bin/nginx", "-g", "daemon off;"] |

ENV |

设置环境变量 | ENV DB_HOST=localhost |

EXPOSE |

声明容器监听的端口 | EXPOSE 8080 |

VOLUME |

创建挂载点(用于数据持久化) | VOLUME ["/data"] |

WORKDIR |

设置工作目录 | WORKDIR /app |

USER |

指定运行命令的用户 | USER appuser |

Docker 按顺序执行 Dockerfile 中的指令,并为每个指令创建一个镜像层。如果某一层的内容未变,下次构建时会复用缓存,显著加速构建过程。例如:

- 修改

requirements.txt后,RUN pip install层会重新构建 - 仅修改应用代码时,只有

COPY . .及后续层会重新构建

以下是一个简单的 Python Flask 应用的 Dockerfile:

# 使用官方 Python 基础镜像

FROM python:3.9-slim

# 设置工作目录

WORKDIR /app

# 复制依赖文件并安装

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

# 复制应用代码

COPY . .

# 暴露端口

EXPOSE 5000

# 设置环境变量

ENV FLASK_APP=app.py

ENV FLASK_ENV=development

# 启动命令

CMD ["flask", "run", "--host=0.0.0.0"]

如何使用 Dockerfile 构建镜像?

- 在项目根目录创建

Dockerfile - 执行

docker build命令:docker build -t my-flask-app:1.0 . # -t:指定镜像标签(名称:版本) # .:构建上下文路径(通常为当前目录) - 构建完成后,使用

docker images查看生成的镜像 - 使用

docker run启动容器:docker run -p 5000:5000 my-flask-app:1.0

Shell常见命令

文件与目录操作

ls # 列出目录内容

cd [目录] # 切换目录

pwd # 显示当前工作目录

mkdir [目录] # 创建新目录

rm [文件] # 删除文件

rm -r [目录] # 递归删除目录

cp [源] [目标] # 复制文件或目录

mv [源] [目标] # 移动文件或目录/重命名

touch [文件] # 创建空文件

文件内容查看

cat [文件] # 查看文件内容

less [文件] # 分页查看文件内容

head [文件] # 查看文件前几行

tail [文件] # 查看文件后几行

grep [模式] [文件] # 在文件中搜索内容

文件权限与所有者

chmod [权限] [文件] # 修改文件权限

chown [用户] [文件] # 修改文件所有者

chgrp [组] [文件] # 修改文件所属组

系统信息

uname -a # 显示系统信息

hostname # 显示主机名

whoami # 显示当前用户名

date # 显示当前日期和时间

df -h # 显示磁盘使用情况

free -h # 显示内存使用情况

top # 显示系统进程

ps # 显示当前进程

网络操作

ping [地址] # 测试网络连接

ifconfig # 显示网络接口信息

ip addr # 显示IP地址信息

netstat -tulpn # 显示网络连接和端口

curl [URL] # 传输URL数据

wget [URL] # 下载文件

其他常用命令

echo [内容] # 打印内容到标准输出

man [命令] # 查看命令手册

history # 显示命令历史

| # 管道:将一个命令的输出作为另一个命令的输入

> [文件] # 输出重定向(覆盖)

>> [文件] # 输出重定向(追加)

# 创建目录并切换到该目录

mkdir my_project && cd my_project

# 查看当前目录下所有文件并按大小排序

ls -lSh

# 查找包含"error"的日志行

grep "error" app.log

# 查看系统负载并将结果保存到文件

top -b -n 1 > system_load.txt

# 下载文件并保存为指定名称

wget -O data.csv https://example.com/data.csvchmod 777 test.sh 、 chomd -R 777 logs/:用于修改文件或目录权限的命令,它会将文件或目录的权限设置为最高级别,即所有用户(所有者、所属组和其他用户)都拥有读取、写入和执行的权限。

| 数字 | 权限组合 | 解释 |

|---|---|---|

| 7 | 读 + 写 + 执行 | rwx (4+2+1) |

| 6 | 读 + 写 | rw- (4+2) |

| 5 | 读 + 执行 | r-x (4+1) |

| 4 | 只读 | r-- (4) |

| 0 | 无权限 | --- |

Java VS Python VS C++ VS C VS Golang 一览表

| 维度 | Java | Python | C++ | C | Golang |

|---|---|---|---|---|---|

| 语言类型 | 静态类型、编译型(通过 JVM 执行) | 动态类型、解释型 | 静态类型、编译型 | 静态类型、编译型 | 静态类型、编译型 |

| 设计范式 | 面向对象、支持泛型 | 面向对象、函数式、脚本化 | 面向对象、泛型、过程式、元编程 | 过程式、结构化 | 面向对象(基于组合)、函数式、并发 |

| 执行方式 | 编译为字节码,由 JVM 解释执行 | 逐行解释执行 | 直接编译为机器码 | 直接编译为机器码 | 编译为机器码(可静态链接) |

| 性能 | 中高性能(JIT 编译优化后接近 C++) | 性能较低(动态类型和解释执行) | 高性能(接近 C) | 高性能(系统级编程语言) | 高性能(接近 C,并发效率高) |

| 内存管理 | 自动垃圾回收(GC) | 自动垃圾回收(GC) | 手动管理(需开发者分配 / 释放内存) | 手动管理(需开发者分配 / 释放内存) | 自动垃圾回收(GC,效率较高) |

| 开发效率 | 中等(语法严谨,开发周期较长) | 高(语法简洁,开发速度快) | 低(语法复杂,开发难度高) | 低(底层操作多,开发复杂度高) | 高(语法简洁,开发效率接近 Go) |

| 学习难度 | 中等(适合初学者入门面向对象) | 低(语法简单,适合零基础入门) | 高(语法复杂,概念繁多) | 中等(需理解指针和内存管理) | 中等(语法简洁,但并发模型需适应) |

| 主要应用场景 | 企业级应用(Web、Android 开发)、大型系统 | 数据分析、人工智能、脚本自动化、Web 开发(Django/Flask) | 系统开发、游戏引擎、高性能服务、嵌入式 | 操作系统、嵌入式系统、驱动开发、底层软件 | 云计算、微服务、网络编程、分布式系统、容器技术(Docker/Kubernetes) |

| 并发模型 | 基于线程(需手动处理同步问题) |

基于线程(受 GIL 限制,多线程效率低) Global Interpreter Lock,全局解释器锁)确保同一时刻只有一个线程执行 Python 字节码。 |

基于线程(手动管理同步)、C++11 引入异步 | 基于线程 / 进程(手动管理同步) | 基于 goroutine(轻量级线程)和 channel(通信机制) |

| 生态系统 | 庞大(Spring、Hibernate 等框架) | 丰富(NumPy、TensorFlow、Django 等) | 较丰富(Qt、OpenCV 等库) | 标准库较小(依赖第三方库) | 快速增长(Go 标准库完善,云原生相关库丰富) |

| 跨平台性 | 强(一次编写,到处运行,依赖 JVM) | 强(解释器支持多平台) | 较强(需针对不同平台编译) | 较强(需针对不同平台编译) | 强(编译后可生成各平台可执行文件) |

| 语法特点 | 语法严谨,面向对象特性完整 | 语法简洁,缩进敏感,动态类型灵活 | 语法复杂,支持多种编程范式 | 语法简洁,强调底层操作 | 语法简洁清晰,接近 C 但更现代化,支持并发原语 |

| 典型项目 | Android 系统、Spring 框架、Hadoop | Python 数据分析库、TensorFlow、PyTorch | Windows 内核部分模块、游戏引擎(如 Unreal Engine) | Unix/Linux 内核、嵌入式系统、MySQL | Docker、Kubernetes、Go 语言标准库 |

| 适合人群 | 企业级开发人员、Android 开发者 | 数据科学家、AI 工程师、脚本开发者 | 系统工程师、游戏开发者、高性能计算工程师 | 底层开发人员、嵌入式工程师 | 云原生开发者、分布式系统开发者、希望平衡性能与开发效率的工程师 |

Java的代码执行过程

Java源代码(.java) → 编译器(javac) → 字节码(.class) → 类加载器 → JVM运行时环境 → 执行引擎 → 操作系统

Java 的代码执行过程涉及编译、加载和运行多个阶段,充分体现了 "一次编写,到处运行" 的跨平台特性。

其中执行引擎:

- 解释执行:逐行解释字节码为机器码(启动快,但性能低)。

- JIT 编译(Just-In-Time):

- 热点代码(如循环体)动态编译为机器码,缓存复用。

- Java 的性能优化主要依赖 JIT(如 HotSpot VM 的 C1/C2 编译器)。

- 本地方法接口(JNI):调用 C/C++ 等本地代码。

常见问题排查

- ClassNotFoundException:类加载器无法找到指定类。

- OutOfMemoryError:堆内存不足,需调整

-Xmx参数。 - NoClassDefFoundError:编译时存在但运行时找不到类(如依赖冲突)。

Java类加载器

-

类加载器(ClassLoader):

- 启动类加载器(Bootstrap ClassLoader):加载 JRE 核心类(如

java.lang.*)。 - 扩展类加载器(Extension ClassLoader):加载 JRE 扩展目录中的类。

- 应用类加载器(Application ClassLoader):加载用户路径(

classpath)下的类。 - 自定义类加载器:按需动态加载类(如 Web 容器、热部署)。

- 启动类加载器(Bootstrap ClassLoader):加载 JRE 核心类(如

-

加载过程:

- 加载:通过类的全限定名(如

java.util.ArrayList)查找并加载.class文件。 - 验证:检查字节码的正确性和安全性(如类型检查、访问权限验证)。

- 准备:为静态变量分配内存并设置初始值(如

int初始为 0)。 - 解析:将符号引用转换为直接引用(如类名→内存地址)。

- 初始化:执行静态代码块和静态变量赋值(按顺序执行)。

- 加载:通过类的全限定名(如

Java类初始化顺序

静态成员初始化

- 父类静态变量 / 静态代码块(按声明顺序执行)

- 子类静态变量 / 静态代码块(按声明顺序执行)

实例成员初始化

- 父类实例变量 / 非静态代码块(按声明顺序执行)

- 父类构造函数

- 子类实例变量 / 非静态代码块(按声明顺序执行)

- 子类构造函数

JVM 内存区域(运行时数据区)

- 方法区:存储类信息、常量池、静态变量(1.8 后改为元空间,使用本地内存)。

- 堆(Heap):对象实例和数组分配以及垃圾回收。

- 栈(Stack):每个线程拥有独立的栈,存储局部变量、方法调用帧。

- 程序计数器:记录当前线程执行的字节码行号。

- 本地方法栈:为本地方法(如

native方法)服务。

JVM进程

├── 线程共享区域

│ ├── 堆(Heap)

│ │ ├── 年轻代(Eden+Survivor)

│ │ └── 老年代(Tenured)

│ └── 方法区(Metaspace)

├── 线程私有区域

│ ├── 栈(Stack)

│ │ ├── 局部变量表

│ │ ├── 操作数栈

│ │ └── 方法调用帧

│ └── 程序计数器

└── 直接内存(Direct Memory)JMM(Java 内存模型,Java Memory Model)

- 定义:JMM 是一种抽象规范,定义了线程间的可见性和有序性规则

- 核心问题:解决多线程环境下的内存可见性和指令重排序问题

- 关键技术:

volatile、synchronized、final关键字

JVM性能优化

- JIT 编译:热点代码优化。

- AOT 编译(提前编译):如 GraalVM,将 Java 直接编译为本地二进制,减少启动时间。

- JVM 参数调优:如堆大小(

-Xmx)、GC 策略(-XX:+UseG1GC)。

JVM 参数

堆内存配置

# 初始/最大堆大小(建议Xms=Xmx避免GC时的resize开销)

java -Xms512m -Xmx1024m MainClass

# 新生代大小(Eden+2*Survivor)

java -Xmn256m MainClass

# 新生代与老年代比例(默认1:2)

java -XX:NewRatio=2 MainClass

GC 策略配置

# 使用G1垃圾收集器(Java 9+默认)

java -XX:+UseG1GC MainClass

# 使用CMS收集器(老年代并发标记清除)

java -XX:+UseConcMarkSweepGC MainClass

# 设置GC日志输出

java -Xlog:gc*:file=gc.log:time,tid,tags MainClass

元空间配置

# 元空间初始/最大大小(替代永久代)

java -XX:MetaspaceSize=128m -XX:MaxMetaspaceSize=256m MainClass垃圾回收

- 自动内存管理:对象不再被引用时,由 GC 自动回收内存。

- 分代回收:新生代(Eden、Survivor)和老年代采用不同的回收策略。

-

新生代(Young Generation)

-

Eden 区:新对象创建区

-

Survivor 区(S0/S1):Eden 区 GC 后存活的对象移至此处

-

Minor GC:新生代 GC,频繁且速度快

-

-

老年代(Old Generation)

-

长期存活的对象(经过多次 Minor GC 后仍存活)进入老年代

-

Major GC/Full GC:老年代 GC,耗时较长

-

-

永久代 / 元空间(PermGen/Metaspace)

-

存储类元数据(Java 8 后使用元空间,避免永久代 OOM)

-

- 常见 GC 算法:标记 - 清除、标记 - 整理、复制算法。

标记 - 清除(Mark-Sweep)

- 标记:标记所有存活对象

- 清除:回收未标记的对象

- 缺点:产生内存碎片

标记 - 整理(Mark-Compact)

- 标记:标记所有存活对象

- 整理:将存活对象移动到内存一端,然后清理边界外的内存

- 优点:避免内存碎片

复制(Copying)

- 将内存分为两块,每次只使用一块

- GC 时将存活对象复制到另一块,然后清空当前块

- 优点:效率高,无碎片

- 缺点:内存利用率低(需预留一半空间)

分代收集(Generational Collection)

-

新生代:使用复制算法(大部分对象很快死亡)

-

老年代:使用标记 - 清除或标记 - 整理(对象存活率高)

垃圾收集器

| GC 类型 | 触发区域 | 触发条件 | 回收对象 | 耗时 |

|---|---|---|---|---|

| Minor GC | 新生代(Eden+Survivor) | Eden 区满 | 新生代中不再存活的对象 | 极短(毫秒级) |

| Major GC | 老年代 | 老年代空间不足 | 老年代中不再存活的对象 | 较长 |

| Full GC | 整个堆 + 方法区 | 1. 调用System.gc()2. 老年代空间不足 3. 元空间不足 4. CMS GC 时并发模式失败 |

整个堆内存(新生代 + 老年代 + 元空间)中不再存活的对象 | 最长(秒级) |

(1) CMS(Concurrent Mark Sweep)

- CMS:基于标记 - 清除算法,专注于降低停顿时间,可能产生内存碎片(初始标记STW → 并发标记 → 重新标记STW → 并发清除)

- G1:基于分区Region(选择垃圾最多的 Region复制&清空)和标记 - 整理算法,可预测停顿时间(通过

-XX:MaxGCPauseMillis参数控制),更适合大内存场景(初始标记STW → 并发标记 → 最终标记STW → 筛选回收STW)

对象是否存活

引用计数法:

- 每个对象维护一个引用计数器,当有新引用指向该对象时,计数器加 1;当引用失效时,计数器减 1。

- 对象存活条件:计数器值为 0 时,对象被判定为可回收。

- 问题:循环引用

可达性分析:

- 从GC Roots出发,通过引用链遍历所有可达对象,这些对象被标记为 “存活”。

- 对象存活条件:无法通过引用链从 GC Roots 到达的对象被判定为可回收。

- 解决了循环引用问题

- STW

调优实战建议

-

监控工具:

jstat:查看 GC 统计信息jmap:生成堆转储文件jhat/MAT:分析堆转储文件jconsole/jvisualvm:可视化监控工具G1GCViewer:专门分析 G1 GC 日志

-

调优策略:

- 吞吐量优先:使用

Parallel Scavenge + Parallel Old - 低延迟优先:使用 G1 或 ZGC

- 大内存场景:增加堆大小,使用 G1/ZGC

- 避免 Full GC:合理设置新生代大小,减少对象进入老年代

- 吞吐量优先:使用

-

常见问题排查:

- 频繁 Full GC:检查是否存在内存泄漏或大对象分配

- GC 时间过长:调整收集器类型或堆参数

- OutOfMemoryError:分析堆转储文件,确定问题根源

对象如何晋升到老年代?

- 经历多次 Minor GC 后仍存活(默认 15 次,由

-XX:MaxTenuringThreshold控制) - 大对象直接进入老年代(

-XX:PretenureSizeThreshold控制阈值) - 动态对象年龄判定:Survivor 区相同年龄的对象总和超过 Survivor 空间一半,年龄≥该年龄的对象直接进入老年代

优化GC性能

- 调整堆大小和分代比例

- 选择合适的垃圾收集器(如 G1/ZGC)

- 避免创建大对象(防止直接进入老年代)

- 减少对象存活时间(及时释放不再使用的对象)

对象初始化顺序

- 分配内存空间

- 初始化对象成员变量(默认值)

- 执行构造函数代码(显式赋值和初始化逻辑)

- 将引用指向分配的内存地址

java 继承 VS 接口 VS 抽象类

| 特性 | 继承(extends) | 接口(implements) | 抽象类(abstract class) |

|---|---|---|---|

| 定义 | 子类继承父类的属性和方法 | 定义方法签名,不包含实现 | 包含抽象方法的类 |

| 多实现 | 仅能继承一个父类 | 可实现多个接口 | 仅能继承一个抽象类 |

| 访问修饰符 | 可使用所有访问修饰符 | 隐式public abstract方法 |

可使用所有访问修饰符 |

| 成员变量 | 可包含任意类型变量 | 隐式public static final常量 |

可包含任意类型变量 |

| 设计目的 | 代码复用和扩展 | 定义行为规范 | 部分实现 + 部分抽象 |

final

- 修饰类:不可被继承(如

String类) - 修饰方法:不可被子类重写

- 修饰变量:初始化后不可修改(引用类型则引用不可变,但对象内容可变)

Java基本数据类型

| 分类 | 子类型 | 具体类型 | 位数 | 默认值 | 示例 | 特点 / 用途 |

|---|---|---|---|---|---|---|

| 基本数据类型 | 整数类型 | byte |

8 位 | 0 |

byte b = 100; |

最小整数类型,适合节省内存(如文件 IO、网络数据) |

short |

16 位 | 0 |

short s = 30000; |

较少使用,偶尔用于大型数组以节省空间 | ||

int |

32 位 | 0 |

int num = 1000; |

最常用的整数类型,默认整数运算类型 | ||

long |

64 位 | 0L |

long l = 10000000000L; |

用于大整数,需加L后缀 |

||

| 浮点类型 | float |

32 位 | 0.0f |

float f = 3.14f; |

单精度,需加f后缀,适合科学计算(精度要求不高) |

|

double |

64 位 | 0.0d |

double d = 3.14159; |

双精度,默认浮点运算类型,适合大多数场景 | ||

| 字符类型 | char |

16 位 | '\u0000' |

char c = 'A'; |

存储单个 Unicode 字符,可直接赋值整数(如char c = 65;表示 'A') |

|

| 布尔类型 | boolean |

未定义 | false |

boolean flag = true; |

表示逻辑值,仅允许true或false,不可与其他类型转换 |

|

| 引用数据类型 | 类(Class) | String, Integer, Date, 自定义类(如Person) |

- | null |

String name = "Alice"; |

最常见的引用类型,可封装多个属性和方法 |

| 接口(Interface) | List, Runnable, Serializable |

- | null |

List<Integer> list = new ArrayList<>(); |

实现多态的关键,定义行为规范 | |

| 数组(Array) | int[], String[], 多维数组(如int[][]) |

- | null |

int[] numbers = new int[5]; |

存储固定长度的同类型元素 | |

| 包装类 | - | Byte, Short, Integer, Long, Float, Double, Character, Boolean |

- | null |

Integer num = 100; |

为基本类型提供对象操作,支持自动装箱 / 拆箱和泛型 |

| 原子类型 | - | AtomicInteger, AtomicLong, AtomicBoolean, AtomicReference<T> |

- | 对应基本类型默认值 | AtomicInteger count = new AtomicInteger(0); |

基于 CAS 实现无锁线程安全操作,适合高并发场景下的计数器、标志位等 |

原子类型位于java.util.concurrent.atomic包下,提供无锁的线程安全操作int vs Integer vs AtomicInteger

int:基本类型,非线程安全Integer:包装类,支持自动装箱 / 拆箱,非线程安全AtomicInteger:线程安全,基于 CAS 实现原子操作,适合高并发场景

反射(Reflection)

含义:程序在运行时对自身结构进行访问以及修改的能力。在运行时动态获取类的信息(如方法、字段、注解),动态地创建对象、调用方法,还能访问属性。主要应用场景如下:

框架开发

- 依赖注入(DI):Spring 框架借助反射,依据配置文件或者注解来动态注入对象的依赖。

- ORM 映射:Hibernate 通过反射将 Java 对象和数据库表进行映射。

注解处理

Java 的注解(Annotation)需要配合反射机制才能发挥作用。通过反射,可以获取类、方法或字段上的注解信息,进而实现特定的逻辑。

序列化和反序列化

- JSON 处理:Jackson、Gson 等库利用反射来解析 JSON 数据并创建对象。

- 深度克隆:通过反射可以递归复制对象的所有字段。

动态代理

Java 的动态代理是 AOP(面向切面编程)的关键技术,它依赖反射机制在运行时创建代理类。

插件与扩展机制

通过反射,程序能够在运行时动态加载和使用外部类,从而实现插件化架构。

- 服务发现:Java 的 SPI(Service Provider Interface)机制借助反射来发现和加载服务实现类。

- 热部署:在不重启应用的情况下,动态更新类的实现。

单元测试

JUnit 等测试框架依靠反射来自动发现和执行测试方法。

调试与监控工具

反射可以用于获取程序的内部状态,这对调试和监控工具很有帮助。

- 内存分析:通过反射遍历对象的字段,辅助内存泄漏检测。

- 性能监控:动态调用方法并记录执行时间。

优点:增强代码灵活性,支持框架动态扩展

缺点:效率低,操作开销大;破坏封装,不安全;JVM版本不同的兼容性

// 获取 Class 对象

Class<?> userClass = User.class;

// 创建对象

Constructor<?> constructor = userClass.getConstructor(Long.class, String.class);

User user = (User) constructor.newInstance(1L, "john");

// 调用方法

Method setUsernameMethod = userClass.getMethod("setUsername", String.class);

setUsernameMethod.invoke(user, "john_doe");

// 访问私有字段

Field usernameField = userClass.getDeclaredField("username");

usernameField.setAccessible(true);

String username = (String) usernameField.get(user);访问私有构造函数:

- 获取目标类的

Class对象。 - 使用

getDeclaredConstructor()获取私有构造函数(包括参数类型)。 - 调用

setAccessible(true)突破访问限制。 - 通过

newInstance()创建实例。

关键方法解析

-

getDeclaredConstructor(Class<?>... parameterTypes)

获取指定参数类型的构造函数,包括私有构造函数。 -

setAccessible(true)

禁用 Java 的访问控制检查,允许访问私有成员。 -

newInstance(Object... initargs)

调用构造函数创建实例,参数对应构造函数的参数列表。

映射

含义:存储键值对的数据结构,其核心思想是通过键来快速查找对应的值。主要应用场景如下:

缓存数据

- LRU 缓存:借助

LinkedHashMap可以轻松实现最近最少使用(LRU)的缓存策略。 - 本地数据缓存:在不需要分布式缓存的场景下,可以使用

ConcurrentHashMap来缓存轻量级数据。

配置管理

- 属性文件解析:

Properties类继承自Hashtable,可用于加载.properties文件。 - 运行时配置:微服务中的动态配置(如 Spring Cloud Config)可以用映射结构存储。

数据统计与聚合

- 单词计数:统计文本中每个单词的出现次数。

import java.util.HashMap;

import java.util.Map;

public class WordCounter {

public static void main(String[] args) {

String text = "hello world hello java";

Map<String, Integer> countMap = new HashMap<>();

for (String word : text.split(" ")) {

countMap.put(word, countMap.getOrDefault(word, 0) + 1);

}

System.out.println(countMap); // 输出: {hello=2, world=1, java=1}

}

}- 分组统计:按照某个字段对数据进行分组,例如统计不同部门的员工数量。

对象关系映射ORM

ORM 框架(如 Hibernate)会把数据库记录映射为 Java 对象,这个过程通常会使用映射结构。

- 结果集映射:将 SQL 查询结果集(ResultSet)转换为

Map<String, Object>。

路由与调度

- URL 路由:Spring MVC 的

RequestMappingHandlerMapping会将 URL 映射到对应的 Controller 方法。

算法与数据结构

- 两数之和:LeetCode 经典题目,可以用 HashMap 在 O (n) 时间复杂度内解决。

import java.util.HashMap;

import java.util.Map;

public class TwoSum {

public int[] twoSum(int[] nums, int target) {

Map<Integer, Integer> map = new HashMap<>();

for (int i = 0; i < nums.length; i++) {

int complement = target - nums[i];

if (map.containsKey(complement)) {

return new int[]{map.get(complement), i};

}

map.put(nums[i], i);

}

return new int[0];

}

}

多语言支持(国际化)

常见映射实现类(xxxMap)

- HashMap:无序、线程不安全,key 支持 null,性能较高。

- TreeMap:按键的自然顺序排序,基于红黑树实现。

- LinkedHashMap:保持插入顺序或者访问顺序。

- ConcurrentHashMap:线程安全的 HashMap,适合高并发场景。

- Hashtable:线程安全但效率较低,key 不支持 null(已被 ConcurrentHashMap 替代)。

位与

0 & 0 = 0

0 & 1 = 0

1 & 0 = 0

1 & 1 = 1位或

0 | 0 = 0

0 | 1 = 1

1 | 0 = 1

1 | 1 = 1异或

- 相同为 0,不同为 1。

典型哈希函数

MD5、SHA-1、SHA-2、SHA-3、BLAKE2/BLAKE3、密码学哈希函数(如 Argon2、scrypt)

Java 集合框架中的 Map 实现类详解及面试题分析

一、HashMap

核心特性

-

数据结构:数组 + 链表(JDK1.8 后引入红黑树,链表长度≥8 时转换)。

-

无序性:遍历时顺序与插入顺序无关,依赖哈希值分布。

-

线程不安全:多线程操作可能导致数据不一致(如扩容时的链表成环)。

-

null 支持:key 和 value 均可为 null(key 只能有一个 null)。

-

性能:平均时间复杂度 O (1),适合高频查询场景。

-

仅当

n为 2 的幂次方时,两者等价(计算索引):hash % n等价于hash & (n - 1)

源码关键点

-

哈希冲突解决:链地址法(链表 + 红黑树)。

-

扩容机制:默认容量 16,负载因子 0.75,超过阈值(16×0.75=12)时扩容为 2 倍。

-

hash 算法:扰动函数优化(JDK1.8 简化为

key.hashCode() ^ (hashCode >>> 16))。

链表转红黑树的条件

1. 核心条件

链表长度 ≥ 8 且 数组长度 ≥ 64 时,链表会转换为红黑树。

2. 为什么需要数组长度 ≥ 64?

- 若数组长度过小(如 16),即使链表转树,元素分布仍可能不均匀,导致查询效率提升有限。

- 优先扩容数组,让元素分布更均匀,减少链表长度,比直接转树更高效。

3. 红黑树转回链表的条件

当树节点数 ≤ 6 时,红黑树会退化为链表。

面试题

-

HashMap 为什么线程不安全?

答:多线程同时操作时可能出现:扩容时链表成环,导致死循环;并发 put 时数据覆盖(如 A 线程刚计算完位置,B 线程插入元素,A 线程再插入时覆盖)。 -

JDK1.7 和 1.8 的 HashMap 有什么区别?

答:1.8 引入红黑树(链表过长时转换),优化了哈希算法和扩容方式(1.7 头插法可能成环,1.8 尾插法避免)。

| 特性 | JDK1.7 | JDK1.8 |

|---|---|---|

| 数据结构 | 数组 + 链表 | 数组 + 链表 + 红黑树(链表≥8 且数组≥64 时) |

| 插入方式 | 头插法(扩容时链表反转) | 尾插法(扩容时保持原顺序) |

| 哈希算法 | 4 次位运算 + 5 次异或 | 1 次异或 + 1 次右移(简化) |

| 扩容逻辑 | 全部重新哈希 | 高低位分离(无需重新计算哈希) |

| 链表成环 | 多线程下可能成环 | 彻底解决(尾插法 + 高低位分离) |

| 性能 | 链表较长时查询 O (n) | 树化后查询 O (log n) |

二、TreeMap

核心特性

-

数据结构:红黑树(自平衡二叉搜索树)。

-

有序性:按键的自然顺序(实现

Comparable)或自定义比较器排序。 -

线程不安全:需外部同步(如

Collections.synchronizedMap())。 -

null 限制:key 不能为 null(会抛出

NullPointerException)。 -

性能:查询、插入、删除平均 O (log n),适合需要排序的场景。

源码关键点

-

排序实现:通过

compareTo()或Comparator比较 key。 -

红黑树特性:节点颜色、左右子树高度差≤1,保证查询效率。

面试题

-

TreeMap 如何实现排序?

答:依赖 key 的自然排序(实现Comparable)或构造时传入Comparator,内部通过红黑树维护有序性。 -

TreeMap 和 HashMap 的性能对比?

答:HashMap 查询 O (1) 更快,但 TreeMap 支持有序遍历和范围查询(如subMap()),适合需要排序的场景。

三、LinkedHashMap

核心特性

-

数据结构:哈希表 + 双向链表(记录插入顺序或访问顺序)。

-

有序性:可保持插入顺序(默认)或访问顺序(

accessOrder=true)。 -

线程不安全:继承自 HashMap,需外部同步。

-

null 支持:key 和 value 可为 null(同 HashMap)。

-

应用场景:LRU 缓存(访问顺序模式)、需要保留插入顺序的场景。

源码关键点

-

双向链表节点:每个节点包含

before和after指针,维护顺序。 -

LRU 实现:访问元素时将其移至链表尾部,超出容量时删除头部元素。

面试题

-

如何用 LinkedHashMap 实现 LRU 缓存?

答:构造时设置accessOrder=true,重写removeEldestEntry()方法,当缓存超过容量时删除最久未访问的节点(链表头部)。 -

LinkedHashMap 的迭代效率比 HashMap 高吗?

答:是的,因为 LinkedHashMap 通过链表维护顺序,迭代时无需遍历整个数组,直接按链表顺序访问。

四、ConcurrentHashMap

核心特性

-

数据结构:JDK1.7 为分段锁(Segment 数组 + 链表),1.8 为 CAS+ synchronized + 红黑树(优化锁粒度)。

-

线程安全:支持高并发操作,读操作无锁,写操作通过锁分段或 CAS 保证原子性。

-

null 限制:key 和 value 均不能为 null(避免与

null返回值混淆,需用containsKey(null)判断)。 -

性能:并发场景下比 Hashtable 效率高,读操作几乎无开销。

源码关键点

-

JDK1.8 优化:放弃分段锁,改用 Node 数组 + 红黑树,写操作时对单个节点加锁(synchronized)。

-

CAS 操作:用于无锁化更新(如

putIfAbsent),提升并发性能。

面试题

-

ConcurrentHashMap 如何保证线程安全?

答:1.8 中通过:-

读操作:volatile 保证可见性,无锁;

-

写操作:对修改的节点加 synchronized 锁,结合 CAS 操作避免竞争。

-

-

ConcurrentHashMap 和 Hashtable 的区别?

答:ConcurrentHashMap 锁粒度更细(1.8 为节点级锁),性能更高;Hashtable 使用全局锁,并发效率低,且已被废弃。

五、Hashtable

核心特性

- 数据结构:数组 + 链表,与 JDK1.7 的 HashMap 类似。

- 线程安全:通过

synchronized修饰所有公共方法(全局锁),并发性能差。 - null 限制:key 和 value 均不能为 null(会抛出

NullPointerException)。 - 应用场景:已被 ConcurrentHashMap 替代,仅在兼容旧代码时使用。

面试题

- Hashtable 为什么被淘汰?

答:全局锁导致并发时竞争激烈,性能低下;ConcurrentHashMap 通过分段锁(1.7)或节点锁(1.8)大幅提升并发效率,且支持 null 以外的场景。

六、综合对比表格

| 实现类 | 数据结构 | 线程安全 | 有序性 | null 支持 | 并发性能 | 典型场景 |

|---|---|---|---|---|---|---|

| HashMap | 数组 + 链表 + 红黑树 | 否 | 无序 | key/value 均可 | 高 | 高频查询、单线程场景 |

| TreeMap | 红黑树 | 否 | 按键排序 | key 不可 | 中(O (log n)) | 需要排序、范围查询 |

| LinkedHashMap | 哈希表 + 双向链表 | 否 | 插入 / 访问顺序 | key/value 均可 | 中 | LRU 缓存、保留顺序 |

| ConcurrentHashMap | 数组 + 链表 + 红黑树 | 是 | 无序 | 均不可 | 极高 | 高并发读写、线程安全场景 |

| Hashtable | 数组 + 链表 | 是 | 无序 | 均不可 | 低 | 旧代码兼容、少量并发场景 |

七、高频面试题汇总

-

HashMap 的底层实现原理?扩容机制?

答:见前文 HashMap 源码关键点,扩容时长度翻倍,重新计算哈希值并迁移元素(1.8 优化为头尾节点分离,避免链表反转)。 -

ConcurrentHashMap 在 JDK1.7 和 1.8 的区别?

答:1.7 用 Segment 分段锁(数组 + 链表),1.8 用 CAS+synchronized + 红黑树,锁粒度更细,避免头插法成环问题。 -

为什么 HashMap 的默认负载因子是 0.75?

答:平衡空间和哈希冲突:0.75 时,哈希冲突概率较低,且空间利用率较高(若设为 1,冲突激增;设为 0.5,空间浪费)。 -

如何选择 Map 实现类?

答:- 单线程、无序:HashMap;

- 需排序:TreeMap;

- 需保留顺序:LinkedHashMap;

- 高并发:ConcurrentHashMap。

-

HashMap 的 key 需要重写哪些方法?为什么?

答:重写hashCode()和equals(),保证相同 key 的哈希值一致,且通过 equals 判断相等时能正确定位元素。

序列化 & 反序列化

- 序列化:将对象转换为字节流,便于存储或传输

- 反序列化:将字节流恢复为对象

- 实现方式:实现

java.io.Serializable接口 serialVersionUID:确保序列化和反序列化版本一致性- 静态字段不会被序列化(属于类,不属于对象)

- 被

transient修饰的字段不会被序列化

JNI(Java Native Interface)

Java 提供的一种机制,允许 Java 代码与本地代码(如 C、C++)进行交互。通过 JNI,Java 程序可以调用本地方法访问底层系统资源(如硬件驱动、操作系统 API),或复用已有 C/C++ 库的功能。

事务传播特性 (PROPAGATION_)

Spring 事务传播机制是指在多个事务方法相互调用的情况下,如何管理这些事务的提交和回滚。

| 传播行为 | 含义 | 示例场景 | 异常处理 | 使用频率 |

|---|---|---|---|---|

| REQUIRED (默认) | 当前存在事务则加入,否则创建新事务。 | 服务层方法调用(如订单创建关联库存扣减)。 | 任何异常导致整个事务回滚。 | ★★★★★ |

| SUPPORTS | 当前存在事务则加入,否则以非事务方式执行。 | 查询操作(如用户信息查询)。 | 仅事务内异常回滚,非事务不回滚。 | ★★★☆☆ |

| MANDATORY | 当前必须存在事务,否则抛出异常。 | 敏感操作(如财务转账)。 | 无事务时立即抛异常,不执行方法。 | ★★☆☆☆ |

| REQUIRES_NEW | 始终创建新事务,挂起当前事务(如果存在)。 | 日志记录(独立于主业务事务)。 | 新事务异常不影响原事务,反之亦然。 | ★★★★☆ |

| NOT_SUPPORTED | 以非事务方式执行,挂起当前事务(如果存在)。 | 无需事务的耗时操作(如文件上传)。 | 任何异常不触发回滚。 | ★★☆☆☆ |

| NEVER | 以非事务方式执行,若当前存在事务则抛出异常。 | 禁止事务的操作(如批处理)。 | 存在事务时立即抛异常,不执行方法。 | ★☆☆☆☆ |

| NESTED | 当前存在事务时创建嵌套事务(子事务),否则等同于 REQUIRED。子事务可独立回滚。 | 分步操作(如批量导入时部分失败)。 | 子事务异常仅回滚子事务,父事务可选择回滚。 | ★★★☆☆ |

注意:内部方法调用事务失效,因为Spring事务基于AOP动态代理(通过代理对象实现事务拦截:通过代理对象调用方法,才能在方法前后加上事务相关逻辑:开启、提交或回滚事务),而内部调用=this<>代理对象,不会触发事务拦截。

解决:将内部调用方法提取成外部类的方法,或者在类A中注入自己,通过注入对象调用即可。

事务的ACID特性

事务(Transaction) 是由一组不可分割的 SQL 操作组成的逻辑单元,这些操作要么全部成功执行,要么全部失败回滚。满足 ACID 特性,即原子性、一致性、隔离性、持久性。

1. 原子性(Atomicity)

- 定义:事务中的所有操作要么全部完成,要么全部不完成,不存在中间状态。

- 实现机制:通过数据库的undo log实现回滚。如果事务执行过程中发生错误,系统会回滚所有已执行的操作,恢复到事务开始前的状态。

2. 一致性(Consistency)

- 定义:事务执行前后,数据库的完整性约束(如主键约束、外键约束、业务规则等)必须保持一致。

- 实现机制:

- 数据库通过约束检查(如唯一性约束、非空约束)确保数据符合规则。

- 应用层需保证业务逻辑的正确性(如转账时总金额不变)。

3. 隔离性(Isolation)

- 定义:多个事务并发执行时,每个事务的执行不受其他事务干扰,如同串行执行一样。

- 隔离级别:SQL 标准定义了 4 种隔离级别,从低到高依次为:

- 读未提交(Read Uncommitted):允许读取尚未提交的数据,maybe脏读。

- 读已提交(Read Committed):只允许读取已提交的数据,避免脏读,maybe不可重复读。

- 可重复读(Repeatable Read):确保同一事务中多次读取同一数据的结果一致,避免不可重复读,但可能导致幻读(InnoDB 通过 MVCC 解决)。

- 串行化(Serializable):强制事务串行执行,避免所有并发问题,但性能最低。

- 实现机制:

- 锁机制(如行锁、表锁)。

- 多版本并发控制(MVCC)(如 InnoDB 的快照读)。

4. 持久性(Durability)

- 定义:一旦事务提交,其对数据库的修改将永久保存,即使系统崩溃也不会丢失。

- 实现机制:

- 预写日志(WAL, Write-Ahead Logging):事务修改先写入日志(redo log),再异步刷新到磁盘数据文件。

- 检查点(Checkpoint):定期将内存中的脏页刷新到磁盘,减少崩溃恢复时间。

注意权衡:

- 高性能 vs 强一致性:高并发场景下,严格的隔离级别可能导致锁争用,降低性能(如 Serializable)。

- CAP 定理:分布式系统中,需在一致性(Consistency)、可用性(Availability)和分区容忍性(Partition Tolerance)之间权衡。

间隙锁

间隙锁是 MySQL InnoDB 存储引擎在可重复读(Repeatable Read) 隔离级别下,为解决幻读问题引入的锁机制。它锁定的不是具体数据行,而是数据行之间的 “间隙”,阻止其他事务在间隙中插入数据,从而避免幻读。

-

间隙锁的作用是什么?如何解决幻读?

- 答:间隙锁锁定索引间隙,阻止其他事务在间隙中插入数据。例如,事务 A 查询

id>10时加(10, +∞)间隙锁,事务 B 无法插入id=11,避免幻读。

- 答:间隙锁锁定索引间隙,阻止其他事务在间隙中插入数据。例如,事务 A 查询

-

间隙锁的锁定范围如何确定?

- 答:取决于查询条件和索引:

- 等值查询

id=3:锁定(前一个id, 3]的临键锁,如(1,3]; - 范围查询

id>3:锁定(3, +∞)所有间隙; - 无索引查询:升级为表锁,锁定

(-∞, +∞)。

- 等值查询

- 答:取决于查询条件和索引:

-

间隙锁会导致死锁吗?如何优化?

- 答:会。当两个事务互相等待对方持有的间隙锁时可能死锁。优化方式包括:降低隔离级别至

读已提交、为查询字段添加索引、缩小锁定范围(用SELECT ... FOR UPDATE替代UPDATE,仅对查询结果加锁,而非全范围)避免长事务(减少事务持有间隙锁的时间,降低冲突概率)等。

- 答:会。当两个事务互相等待对方持有的间隙锁时可能死锁。优化方式包括:降低隔离级别至

多版本并发控制 - MVCC

MVCC通过为每个数据版本记录时间戳来实现,读操作不会修改数据,读的时某个时间点的快照,写操作会生成新的版本,这样读操作无需等待写操作完成,同时写操作也不会阻塞,在InnoDB存储引擎里,使用undo log来实现MVCC。

锁

数据库锁:排他锁与共享锁

1. 排他锁(X 锁,Exclusive Lock)

-

定义:又称写锁,持有排他锁的事务可读写数据,其他事务无法获取该数据的任何锁(读 / 写均阻塞)。

-

使用场景:写操作(如 UPDATE、DELETE)需确保数据独占性。

2. 共享锁(S 锁,Shared Lock)

-

定义:又称读锁,持有共享锁的事务可读取数据,但无法修改;其他事务可获取共享锁(读操作并发),但无法获取排他锁(写操作阻塞)。

-

使用场景:读操作需保证数据一致性,且允许其他读操作并发。

3. 锁兼容性矩阵

|

锁类型 |

共享锁(S) |

排他锁(X) |

|---|---|---|

|

共享锁(S) |

兼容 |

不兼容 |

|

排他锁(X) |

不兼容 |

不兼容 |

编程层面:悲观锁与乐观锁

1. 悲观锁(Pessimistic Lock)

-

核心思想:假设并发操作时数据冲突概率高,提前对数据加锁,阻止其他操作修改。

-

数据库层面:使用排他锁、共享锁(如前文的

FOR UPDATE); -

代码层面:Java 中的

synchronized、ReentrantLock。

2. 乐观锁(Optimistic Lock)

-

核心思想:假设并发操作时数据冲突概率低,不提前加锁,而是在更新时检查数据是否被修改。

-

版本号机制:表中添加

version字段,更新时判断版本是否一致(如UPDATE table SET stock=stock-1, version=version+1 WHERE id=1 AND version=1); -

时间戳(Timestamp):类似版本号,通过时间戳判断数据是否过期;

-

CAS(Compare-And-Swap):硬件级原子操作(如 Java 的

AtomicInteger)。

四、分布式场景:Redis 分布式锁

1. 核心需求与挑战

-

场景:多节点分布式系统中,需保证跨节点的操作互斥(如秒杀、分布式任务调度)。

-

挑战:

-

单点故障(主节点宕机导致锁丢失);解决办法:redlock

-

锁超时(业务执行时间超过锁过期时间,导致锁被提前释放);解决办法:用定时任务来延长锁的过期时间,在获取锁之后,启动一个定时任务,每隔一段时间就去检查一下锁在不在,如果在就延长过期时间,定时任务单线程使用Timer,多线程使用TimerTask和ScheduledExecutorService替代Timer,线程安全;

-

误删锁(A 节点释放 B 节点的锁);解决办法:clientId(客户端唯一标识,释放锁时通过 Lua 脚本验证,防止误删)

-

2. Redlock 算法

-

核心思想:通过多 Redis 节点(至少 5 个)实现分布式锁,多数节点加锁成功才认为获取锁,提升可靠性。

-

步骤:

-

获取当前时间戳(毫秒);

-

依次向 5 个 Redis 节点请求加锁(使用相同 key 和过期时间);

-

若在多数节点(≥3)加锁成功,且总耗时小于锁过期时间,则认为获取锁成功;

-

若失败,向所有节点释放锁(即使部分节点加锁失败)。

-

代码层面常见锁机制(以 Java 为例)

1. 内置锁:synchronized

-

隐式加锁,自动释放(进入代码块加锁,退出释放);

-

可作用于方法、代码块,基于 JVM 实现。

2. 显式锁:ReentrantLock (可重入锁)

-

显式加锁(

lock())和释放(unlock()),需配合finally防止死锁; -

支持公平锁(按申请顺序获取锁)、可中断锁、超时获取锁等高级功能。

3. 读写锁:ReentrantReadWriteLock

-

分离读锁(共享)和写锁(排他),允许多线程并发读,但写操作独占;

-

适合读多写少场景(如缓存更新)。

4. 原子类:CAS 机制(基于硬件级compareAndSwap操作,无锁实现原子更新)

|

锁类型 |

核心特点 |

典型场景 |

优缺点 |

|---|---|---|---|

|

排他锁(X 锁) |

写操作独占,阻塞其他读写 |

资金转账、库存扣减 |

安全性高,但并发性能低 |

|

共享锁(S 锁) |

读操作共享,写操作阻塞 |

报表查询、商品详情页 |

读并发高,但写操作可能阻塞 |

|

悲观锁 |

提前加锁,阻止冲突 |

强一致性场景(如金融交易) |

实现简单,但可能导致线程阻塞 |

|

乐观锁 |

事后检查,冲突时重试 |

读多写少场景(如商品浏览计数) |

无锁开销,但需处理冲突重试 |

|

Redis 分布式锁 |

跨节点互斥,基于缓存实现 |

分布式秒杀、全局任务调度 |

需处理单点故障和时钟同步问题 |

|

synchronized |

JVM 内置,自动管理生命周期 |

简单的单节点线程安全控制 |

语法简洁,功能有限(无超时、公平性) |

|

ReentrantLock |

显式控制,支持高级功能 |

复杂并发场景(如定时任务调度) |

功能强大,但需手动释放锁 |

最佳实践

-

锁粒度控制:避免锁范围过大(如整表锁),尽量使用行级锁或更细粒度的锁。

-

超时机制:分布式锁必须设置过期时间,避免服务宕机导致死锁;代码层面的锁可使用

tryLock(timeout)防止永久阻塞。 -

幂等性设计:结合锁与幂等机制(如唯一 ID),避免重复操作(如重复下单)。

- 监控与告警:对分布式锁的获取失败率、锁超时情况进行监控,及时发现问题。

线程安全的数据结构

| 数据结构 | 锁类型 | 备注 |

|---|---|---|

| Vector | synchronized 方法 |

所有方法都被同步,性能较差,已被 ArrayList + Collections.synchronizedList 替代 |

| Hashtable | synchronized 方法 |

所有方法都被同步,不允许 null 键值,已被 ConcurrentHashMap 替代 |

| ConcurrentHashMap 1.7 | 分段锁(Segment 数组) | 使用分段锁,不同段可并发访问,默认 16 个段 |

| ConcurrentHashMap 1.8 | CAS + synchronized(Node 节点) | 采用 CAS 和 synchronized 优化,锁粒度更小,并发性能更高 |

| CopyOnWriteArrayList | ReentrantLock | 写操作时复制数组,读操作无锁,适用于读多写少场景 |

| Collections.synchronizedList | synchronized 块 |

包装普通 List,所有操作通过同一把锁同步 |

| AtomicIntegerArray | CAS(Compare-and-Swap) | 原子操作数组,基于 Unsafe 类实现无锁并发 |

| ArrayBlockingQueue | ReentrantLock(公平 / 非公平) | 有界阻塞队列,FIFO 顺序 |

| LinkedBlockingQueue | ReentrantLock(两把锁) | 可选有界阻塞队列,读写分离锁,吞吐量较高 |

| PriorityBlockingQueue | ReentrantLock | 无界优先级阻塞队列,元素需实现 Comparable 接口 |

补充说明:

- 锁粒度:ConcurrentHashMap 1.8 锁粒度最小(Node 节点),Vector/Hashtable 锁粒度最大(整个对象)。

- 适用场景:

- 读多写少:CopyOnWriteArrayList、ConcurrentHashMap 1.8。

- 高并发写入:ConcurrentHashMap 1.8(优于 1.7)。

- 阻塞队列:ArrayBlockingQueue(有界)、LinkedBlockingQueue(可选有界)。

- Null 值支持:只有 ConcurrentHashMap 和 CopyOnWriteArrayList 允许 null 值。

- 迭代器特性:CopyOnWriteArrayList 的迭代器支持弱一致性(创建时的快照),其他结构的迭代器可能抛出 ConcurrentModificationException。

- 在 ConcurrentHashMap 1.8里,插入元素时先看数组对应位置,若为空,用CAS操作尝试插入,不用加锁;若该位置已有节点(哈希冲突),就可能在链表或红黑树上操作,这时会用到锁。数组初始长度16,负载因子0.75,链表长度超8且数组长度至少64时,链表会转成红黑树。

- ReentrantLock 是Java并发包中的锁,可重入,同一个线程能多次获取和释放。有公平锁(按照顺序来获取)和非公平锁(即来即获取)模式。使用时在 try 块获取锁, finally 块释放锁,防止死锁,能替代 synchronized 实现更灵活的同步控制。

- StringBuilder 和 Buffer都用于字符串拼接。 StringBuffer线程安全(使用synchronized),适用于多线程,但性能稍逊,出现较早。 StringBuilder非线程安全,单线程性能好,是后来引入的。根据线程环境选就行,单线程用 StringBuilder ,多线程用 StringBuffer。StringBuffer / StringBuilder sa = new StringBuffer() /new StringBuilder(); sa.append("111"); sa.append("222"); String result = sa.toString();

- Vector是一种动态数组数据结构。它和ArrayList很相似,底层都是用数组来存储元素。不过Vector是线程安全的,很多方法都加了同步锁,在多线程环境下能保证数据一致性。但因为加锁,性能会比ArrayList差一些。当数组满了需要扩容时,均会翻倍扩容。

- CAS机制下会存在ABA问题,使用AtomicStampedReference(给数据加上版本号) 来解决 ABA 问题。

- CAS 的局限性:需解决 ABA 问题、自旋开销和多变量原子性问题,常与 Volatile 结合使用。

常见设计模式

| 类型 | 模式名称 | 核心思想 | 典型应用场景 |

|---|---|---|---|

| 创建型模式 | 单例模式(Singleton) | 确保类只有一个实例,提供全局访问点 | 日志工具、线程池、配置管理器 |

| 工厂方法模式(Factory Method) | 定义创建对象的接口,由子类决定实例化哪个类 | JDBC 驱动加载、框架插件扩展 | |

| 抽象工厂模式(Abstract Factory) | 提供创建相关对象家族的接口,无需指定具体类 | GUI 组件库(如跨平台 UI 控件)、游戏场景生成 | |

| 建造者模式(Builder) | 将复杂对象的构建与表示分离,允许相同构建过程创建不同表示 | 复杂对象初始化(如 SQL 查询构造器)、文档生成 | |

| 原型模式(Prototype) | 通过复制现有对象创建新对象,避免重复初始化 | 游戏角色克隆、配置对象复制 | |

| 结构型模式 | 适配器模式(Adapter) | 将一个类的接口转换为客户端期望的另一个接口,解决接口不兼容问题 | 旧系统接口兼容、第三方库整合 |

| 桥接模式(Bridge) | 将抽象部分与实现部分分离,使两者可独立变化 | 多平台适配(如操作系统与图形库分离)、UI 主题切换 | |

| 组合模式(Composite) | 将对象组合成树形结构,表示 "部分 - 整体" 层次结构,统一处理单个对象和组合对象 | 文件系统目录结构、组织结构管理、游戏场景物体 | |

| 装饰器模式(Decorator) | 动态地为对象添加额外功能,避免继承导致的类爆炸 | IO 流处理(如 BufferedInputStream 包装)、日志增强 | |

| 外观模式(Facade) | 为复杂子系统提供统一接口,简化客户端与子系统的交互 | 框架 API 封装(如 Spring JDBC)、系统集成接口 | |

| 享元模式(Flyweight) | 共享多个对象的公共部分,减少内存占用 | 文本编辑器字符渲染、游戏中大量相似对象(如士兵) | |

| 代理模式(Proxy) | 为其他对象提供代理,控制对原对象的访问 | 远程调用(如 RPC 代理)、延迟加载(如图像加载) | |

| 行为型模式 | 责任链模式(Chain of Responsibility) | 将请求发送者与接收者解耦,多个对象可处理请求并形成链条,直到请求被处理 | 审批流程、错误处理链、Servlet 过滤器 |

| 命令模式(Command) | 将请求封装为对象,使发送者与接收者解耦,支持请求排队、撤销等操作 | 编辑器撤销 / 重做、游戏按键命令、分布式任务 | |

| 迭代器模式(Iterator) | 提供遍历集合元素的统一接口,不暴露集合内部表示 | 集合框架(如 Java 的 Iterator)、自定义数据结构遍历 | |

| 中介者模式(Mediator) | 定义中介对象协调其他对象交互,避免对象间直接引用 | GUI 界面组件交互(如按钮与文本框联动)、网络聊天系统 | |

| 备忘录模式(Memento) | 在不破坏封装的前提下,捕获对象状态并保存,可恢复至先前状态 | 编辑器撤销功能、游戏存档、数据库事务回滚 | |

| 观察者模式(Observer) | 定义对象间的一对多依赖,主题状态变化时通知所有观察者 | 消息推送(如新闻订阅)、事件监听(如按钮点击) | |

| 状态模式(State) | 对象行为随状态改变而变化,将状态转换封装为独立类 | 电梯状态控制、订单状态机、游戏角色状态切换 | |

| 策略模式(Strategy) | 定义一系列算法,将每个算法封装为独立类,可相互替换 | 排序算法选择、支付方式切换、路由策略选择 | |

| 模板方法模式(Template Method) | 定义算法骨架,将具体步骤延迟到子类实现 | 框架设计(如 JDBCTemplate)、日志处理流程 | |

| 访问者模式(Visitor) | 封装作用于对象结构中各元素的操作,使操作可独立于元素变化 | 编译器语法树遍历、文档解析、数据统计报表 |

选择指南

-

当需要控制对象创建时:

- 若需唯一实例 → 单例模式;

- 若需延迟对象创建 → 工厂方法 / 抽象工厂;

- 若需复杂对象构建流程 → 建造者模式。

-

当需要处理对象结构时:

- 若需接口兼容 → 适配器模式;

- 若需动态添加功能 → 装饰器模式;

- 若需表示 "部分 - 整体" 关系 → 组合模式。

-

当需要优化对象交互时:

- 若需一对多状态通知 → 观察者模式;

- 若需算法动态切换 → 策略模式;

- 若需流程标准化 → 模板方法模式。

DispatcherServlet(Spring Web MVC的核心控制器,引入spring-boot-starter-web依赖后自动配置)

- 负责接收HTTP请求,根据URL等信息,将请求分发到对应的处理器(Controller)去处理。

- 负责视图解析、异常处理等。

PageHelper

性能瓶颈&注意事项:

- 处理大宽表时,分页插件会进行原始sql包装,给全量数据分配行号id,然后排序取行号id在startIndex和pageSize范围内的

- 是双层子查询结构

- 脱外套后提速超1000倍

- 要注意现在很多框架里都封装了pageHelper插件,要去掉参数中的RowBounds才可以转手动分页哦

- 此外,分页一定要注意排序,例如order by createDt,id结合使用,否则会导致同一行数据出现在多页面中

- 查询总数如果非必要也建议拿掉

java 1.8 新特性

| 特性分类 | 核心内容 | 示例代码 | 应用场景 |

|---|---|---|---|

| Lambda 表达式 | 简化函数式接口实现,用更简洁的语法表示匿名函数 | () -> System.out.println("Hello")(a, b) -> a + b |

线程创建、事件监听、集合遍历等 |

| Stream API |

提供流式数据处理能力,支持过滤、映射、聚合等操作

|

list.stream().filter(n -> n>5).mapToInt(Integer::intValue).sum() |

集合数据处理、数据分析、并行计算 |

| 函数式接口 | 仅含一个抽象方法的接口,可被 Lambda 实现 | @FunctionalInterfaceinterface Predicate<T> { boolean test(T t); } |

作为 Lambda 的目标类型、行为参数传递 |

| 接口默认 / 静态方法 | 接口中可实现默认方法(default)和静态方法,解决接口演进问题 |

interface MyInterface {<br> default void method() {}<br> static void func() {}<br>} |

接口升级时不破坏现有实现、工具方法封装 |

| 新日期时间 API | java.time包,提供线程安全、易用的日期时间处理类 |

LocalDate today = LocalDate.now();ZonedDateTime zdt = ZonedDateTime.now(); |

日常日期计算、时区处理、格式化显示 |

| 方法引用 | 简化 Lambda,直接引用已有方法(静态方法、实例方法等) | System.out::printlnString::toUpperCaseArrayList::new |

代码复用、减少冗余 Lambda 表达式 |

| Optional 类 |

封装可能为 null 的值,避免 NPE,明确表示值的存在性

|

Optional<String> opt = Optional.of("data");opt.orElse("default"); |

方法返回值、对象属性的空值处理 |

| 并行流 | 通过parallelStream()利用多核 CPU 并行处理集合数据 |

list.parallelStream().forEach(System.out::println); |

大数据量集合的高性能处理 |

| 重复注解 | 允许在同一位置多次使用相同注解,通过@Repeatable元注解实现 |

@Author("Alice")<br>@Author("Bob")<br>public class Book {} |

多作者标注、多配置项声明 |

| Base64 编码 | 内置java.util.Base64类,支持编解码 |

String encoded = Base64.getEncoder().encodeToString("data".getBytes()); |

数据传输、密码存储、文件编码 |

| Nashorn 引擎 | JVM 内置 JavaScript 引擎,支持 Java 与 JS 互调 | ScriptEngine engine = new NashornScriptEngine();engine.eval("print('Hello')"); |

动态脚本执行、前端后端逻辑集成 |

| 元空间(Metaspace) | 替代永久代(PermGen),使用本地内存,减少 OOM 风险 | - | 类加载、动态代理、字节码生成场景 |

并发&并行

并发:多个任务在同一时间段内交替执行,宏观上看似同时运行,但微观上是分时复用 CPU 资源。通过时间片轮转或任务切换实现多任务处理。适用于 I/O 密集型任务(如 Web 服务器处理多个请求)。例如:线程、协程、事件循环。

并行:多个任务在同一时刻真正同时执行,依赖多核 CPU 或多处理器硬件支持。通过物理资源并行实现真正的同时执行。适用于计算密集型任务(如科学计算、图像处理)。例如:多线程、多进程、GPU 计算。

transient

用于修饰类的成员变量,指示该变量在对象序列化时应被忽略。这意味着当对象被序列化(如写入文件或通过网络传输)时,被 transient 修饰的变量不会被保存或传输,其值会被设为默认值(如 null、0 或 false)。

Volatile

一、Volatile 的作用是什么?

核心回答:

Volatile 是 Java 的轻量级同步机制,主要解决两大问题:

- 可见性:确保一个线程修改变量后,其他线程能立即看到最新值(通过禁止 CPU 缓存重排和强制从主内存读取)。

- 有序性:通过内存屏障(Memory Barrier)禁止指令重排序,保证 volatile 变量的读写操作按代码顺序执行。

底层实现:

- 写操作时,JMM(Java 内存模型)会在指令后插入

StoreStore和StoreLoad屏障,强制刷新主内存。 - 读操作时,插入

LoadLoad和LoadStore屏障,强制从主内存读取。

二、Volatile 能保证原子性吗?为什么?

核心回答:

不能。Volatile 仅保证单次读 / 写操作的原子性,但无法保证复合操作(如 i++)的原子性。原因:

- 复合操作(如 i++)的字节码包含 3 步:读取(load)、修改(inc)、写入(store),Volatile 无法保证这三步的原子性。

- 示例:多线程同时执行

i++时,可能出现线程 A 读取 i=10,线程 B 也读取 i=10,最终 i=11 而非 12。

延伸问题:

- 如何保证原子性?

答:使用synchronized、Lock或原子类(如AtomicInteger)。

三、Volatile 和 Synchronized 的区别?

| 维度 | Volatile | Synchronized |

|---|---|---|

| 作用范围 | 修饰变量,保证可见性和有序性 | 修饰方法或代码块,保证原子性和互斥性 |

| 性能开销 | 轻量级,仅插入内存屏障 | 重量级,涉及线程阻塞和唤醒 |

| 原子性 | 不保证(除 boolean、long、double 的读写) | 完全保证 |

| 可见性 | 保证 | 保证(同步块结束时刷新主内存) |

| 底层实现 | 内存屏障 | monitorenter/monitorexit指令 |

四、Volatile 的应用场景有哪些?

典型场景:

- 状态标记变量(如

boolean running = false):volatile boolean stop = false; // 线程A修改stop=true,线程B能立即感知并退出循环 while (!stop) { doTask(); } - 双重检查锁定(DCL)优化单例模式:

public class Singleton { private volatile static Singleton instance; // 禁止指令重排 public static Singleton getInstance() { if (instance == null) { // 第一层检查 synchronized (Singleton.class) { if (instance == null) { // 第二层检查 instance = new Singleton(); // 可能被重排的三步操作 } } } return instance; } }

关键:若instance未加volatile,可能因指令重排导致其他线程获取到未初始化完成的对象。

五、Volatile 变量的读写过程如何实现可见性?

JMM 模型解释:

- 写操作:

- 线程修改 volatile 变量时,强制将值刷新到主内存。

- 其他线程缓存中的该变量失效,下次读取时必须从主内存获取。

- 读操作:

- 线程读取 volatile 变量时,强制从主内存读取最新值,而非本地缓存。

六、Volatile 禁止指令重排序的原理是什么?

内存屏障机制:

- JVM 在生成字节码时,会在 volatile 变量的读写操作前后插入内存屏障:

- 写操作前:插入

StoreStore屏障,确保屏障前的写操作先于 volatile 写操作完成。 - 写操作后:插入

StoreLoad屏障,确保 volatile 写操作先于后续读 / 写操作。 - 读操作前:插入

LoadLoad屏障,确保 volatile 读操作先于屏障后的读操作。 - 读操作后:插入

LoadStore屏障,确保屏障前的读操作先于 volatile 读操作完成。

- 写操作前:插入

七、Volatile 能解决循环依赖吗?为什么?

核心回答:

不能。Volatile 的作用是保证变量的可见性和有序性,而循环依赖属于对象引用关系问题(如 A 引用 B,B 引用 A),需通过设计层面(如弱引用、依赖注入)解决,与 Volatile 无关。

八、面试高频陷阱问题:Volatile 修饰 long/double 变量时是否保证原子性?

JLS 规范:

- 对于 64 位基本类型(long/double),JVM 允许非原子性读写(“半写” 问题),但实际 JVM 实现中几乎都保证了原子性。

- 结论:面试中回答 “理论上不保证,实际 JVM 实现通常保证”,并强调 volatile 本身不保证复合操作的原子性。

总结:Volatile 核心考点速记

- 两大特性:可见性(主内存同步)、有序性(禁止重排),不保证原子性。

- 应用场景:状态标记、DCL 单例、轻量级同步(替代 synchronized 的场景)。

- 底层原理:内存屏障插入、主内存与工作内存的强制同步。

- 与 Synchronized 对比:轻量级、作用范围不同,后者保证原子性和互斥性。

springboot层级划分

Controller 层、Service 层、Repository 层、Config层

┌─────────────────────────────────────────┐

│ 表现层 (Presentation) │

│ ┌─────────────────────────────────────┐ │

│ │ Controller DTO ExceptionHandler │ │

│ └─────────────────────────────────────┘ │

└─────────────────────────────────────────┘

│ ↑ │

▼ ▼ ▼

┌─────────────────────────────────────────┐

│ 业务逻辑层 (Service) │

│ ┌─────────────────────────────────────┐ │

│ │ Service接口 Service实现类 │ │

│ │ 事务管理 业务异常处理 │ │

│ └─────────────────────────────────────┘ │

└─────────────────────────────────────────┘

│ ↑ │

▼ ▼ ▼

┌─────────────────────────────────────────┐

│ 数据访问层 (Repository) │

│ ┌─────────────────────────────────────┐ │

│ │ Repository/DAO Entity Mapper │ │

│ └─────────────────────────────────────┘ │

└─────────────────────────────────────────┘

│ ↑ │

▼ ▼ ▼

┌─────────────────────────────────────────┐

│ 基础设施层 (Infrastructure) │

│ ┌─────────────────────────────────────┐ │

│ │ Config Utils External Client │ │

│ └─────────────────────────────────────┘ │

└─────────────────────────────────────────┘MVC VS MVP VS MVVM

MVC(Model-View-Controller)

将应用分为三个主要部分:

- Model:负责数据和业务逻辑。

- View:负责 UI 展示,通常直接渲染 Model 数据。

- Controller:接收用户输入,协调 Model 和 View 的交互。

MVP(Model-View-Presenter)

将 Controller 改为 Presenter,强化解耦:

- Model:同 MVC。

- View:更被动,只负责显示 UI 和传递用户操作,不包含业务逻辑。

- Presenter:处理所有业务逻辑,与 View 通过接口交互,持有 View 引用。

MVVM(Model-View-ViewModel)

引入 ViewModel 和数据绑定:

- Model:同 MVC。

- View:只负责 UI 展示,通常由 XAML 或 HTML 定义。

- ViewModel:暴露属性和命令,通过数据绑定自动更新 View,反之亦然。

DDD

DDD(Domain-Driven Design,领域驱动设计)是一种软件开发方法论,由 Eric Evans 在 2004 年提出,核心是将业务领域知识与技术实现深度融合,通过领域模型驱动软件设计。

TDD

TDD(Test-Driven Development,测试驱动开发)是一种软件开发方法论,核心是先写测试,后实现代码,通过测试来驱动功能的设计和实现。

多线程

什么是线程池?为什么要用它?

线程池是管理一组预先创建的线程的资源池,用于执行异步任务。

优点:

- 减少线程创建 / 销毁开销,提升响应速度

- 控制并发线程数,防止资源耗尽

- 提供任务队列和拒绝策略,增强稳定性

高频面试题:

- 如何创建线程池?

使用Executors工厂方法(如newFixedThreadPool)或手动配置ThreadPoolExecutor。

如何减少线程上下文切换?

- 无锁并发编程:如使用

ConcurrentHashMap替代synchronized Map - CAS 操作:使用

Atomic类(如AtomicInteger)减少锁竞争 - 合理配置线程数:CPU 密集型任务线程数 = CPU 核心数,IO 密集型可适当增加

- 使用协程(Coroutine):轻量级线程,减少内核级切换开销

Java 线程池核心参数及拒绝策略?

- 核心参数:corePoolSize(核心线程数)、maximumPoolSize(最大线程数)、keepAliveTime(空闲线程存活时间)、workQueue(工作队列:存储待执行任务的阻塞队列,当核心线程已满时,新任务会被放入队列等待)、RejectedExecutionHandler(拒绝策略:当最大线程数已满且工作队列也满时,新提交的任务会被拒绝。)

- workQueue:

- ArrayBlockingQueue:有界队列,指定固定容量(如

new ArrayBlockingQueue<>(100)); - LinkedBlockingQueue:无界队列(默认容量为

Integer.MAX_VALUE),可能导致 OOM; - SynchronousQueue:直接提交队列,不存储任务,每个插入操作必须等待另一个线程的移除操作。

- 拒绝策略:

- AbortPolicy(默认):抛出

RejectedExecutionException异常; - CallerRunsPolicy:由提交任务的线程(调用

execute()的线程)直接执行该任务; - DiscardPolicy:直接丢弃任务,不做任何处理;

- DiscardOldestPolicy:丢弃队列中最老的任务,尝试重新提交当前任务。

异步处理场景中如何保证结果回调的可靠性?

- 用 CompletableFuture 的 whenComplete/handle 回调,结合线程池隔离;

- 失败时记录日志 + 重试机制(如定时任务扫描失败记录)。

Java 创建多线程的方式

1. 继承 Thread 类

public class MyThread extends Thread {

@Override

public void run() {

System.out.println("Thread running");

}

}

// 使用

MyThread thread = new MyThread();

thread.start();

2. 实现 Runnable 接口

public class MyRunnable implements Runnable {

@Override

public void run() {

System.out.println("Runnable running");

}

}

// 使用

Thread thread = new Thread(new MyRunnable());

thread.start();

3. 实现 Callable 接口(带返回值)

import java.util.concurrent.*;

public class MyCallable implements Callable<Integer> {

@Override

public Integer call() {

return 123;

}

}

// 使用

ExecutorService executor = Executors.newSingleThreadExecutor();

Future<Integer> future = executor.submit(new MyCallable());

Integer result = future.get();

4. 使用线程池(推荐)

ExecutorService executor = Executors.newFixedThreadPool(5);

executor.submit(() -> {

System.out.println("Task executed by thread pool");

});

executor.shutdown();

多线程中身份信息管理方案

1. 使用 ThreadLocal

ThreadLocal为每个使用该变量的线程都提供一个独立的变量副本:

public class UserContext {

private static final ThreadLocal<User> userThreadLocal = new ThreadLocal<>();

public static void setUser(User user) {

userThreadLocal.set(user);

}

public static User getUser() {

return userThreadLocal.get();

}

public static void clear() {

userThreadLocal.remove(); // 避免内存泄漏

}

}

// 在拦截器或过滤器中设置用户信息

UserContext.setUser(currentUser);

// 在业务逻辑中获取

User user = UserContext.getUser();

2. InheritableThreadLocal(子线程继承父线程数据)

private static final InheritableThreadLocal<User> userThreadLocal =

new InheritableThreadLocal<>();

3. 使用 MDC(Mapped Diagnostic Context)

// SLF4J MDC示例

import org.slf4j.MDC;

// 在请求入口设置

MDC.put("userId", currentUser.getId());

// 在日志中自动打印

logger.info("Processing request");

// 请求结束时清除

MDC.clear();- 内存泄漏:使用完

ThreadLocal后必须调用remove() - 线程池场景:线程会被复用,需在任务开始 / 结束时手动设置 / 清除

- 异步任务传递:若使用

CompletableFuture等异步 API,需手动传递上下文

ThreadLocal 原理及内存泄漏原因?

- 每个线程维护

ThreadLocalMap,键为弱引用ThreadLocal对象 - 若线程长期存活且未调用

remove(),会导致值对象无法被回收

单例模式实现

1. 双检锁(Double-Checked Locking) 是一种延迟初始化(Lazy Initialization)的优化模式,通过两次检查实例是否已创建,避免不必要的同步开销。

DCL

public class Singleton {

private static volatile Singleton instance; // 注意:必须使用volatile关键字

private Singleton() {} // 私有构造函数

public static Singleton getInstance() {

if (instance == null) { // 第一次检查:不加锁

synchronized (Singleton.class) {

if (instance == null) { // 第二次检查:加锁后

instance = new Singleton(); // 关键步骤

}

}

}

return instance;

}

}

饿汉式单例(Eager Initialization)

class SafeSingleton {

private static final SafeSingleton instance = new SafeSingleton();

public static SafeSingleton getInstance() {

return instance;

}

}

线程安全原理:

- 类加载机制保证:Java 的类加载过程是线程安全的,静态变量instance会在类第一次加载时初始化,且只初始化一次。

- 无需同步:没有锁开销,调用getInstance()直接返回已创建的实例,性能最优。2. 静态内部类(推荐)

public class Singleton {

private Singleton() {}

private static class SingletonHolder {

private static final Singleton INSTANCE = new Singleton();

}

public static Singleton getInstance() {

return SingletonHolder.INSTANCE; // 类加载时自动初始化,线程安全

}

}

原理:Java 类加载机制保证静态内部类的初始化是线程安全且延迟的。

3. 枚举单例(最简)

public enum Singleton {

INSTANCE;

public void doSomething() {

// 业务方法

}

}

优势:自动处理序列化和反射攻击,线程安全。

静态内部类

静态内部类(Static Nested Class)的初始化时机由 Java 的类加载机制决定,遵循懒加载(Lazy Initialization) 原则:

- 首次被主动引用时

- 反射调用时

- 被其他类继承时(有限情况)

数据库连接池

数据库连接池是用于管理数据库连接的一种技术,它预先创建一组数据库连接并保存在池中,应用程序需要连接时从池中获取,使用完后再归还池中。

Spring Boot 默认使用 HikariCP 作为连接池(若存在于类路径中),只需在 application.properties 或 application.yml 中配置数据库连接信息即可。

配置示例(application.properties)

spring.datasource.url=jdbc:mysql://localhost:3306/mydb

spring.datasource.username=root

spring.datasource.password=password

spring.datasource.driver-class-name=com.mysql.cj.jdbc.Driver

# HikariCP 额外配置(可选)

spring.datasource.hikari.minimum-idle=5

spring.datasource.hikari.maximum-pool-size=10

spring.datasource.hikari.idle-timeout=30000

spring.datasource.hikari.max-lifetime=1800000关键参数

-

最大连接数 (max connections):连接池中允许的最大连接数量,超过此数量的请求将被阻塞或拒绝。

- 最小空闲连接数 (min idle connections):连接池中保持的最小空闲连接数量,当空闲连接数低于此值时,连接池会创建新的连接。

- 连接超时时间 (connection timeout):获取连接的最大等待时间,超过此时间将抛出异常。

- 连接回收时间 (connection lifetime/recycle):连接在池中保持的最长时间,超过此时间的连接将被关闭并重新创建。

Cookie、Token、Session

Cookie(客户端状态存储) 是由服务器生成、存储在客户端(浏览器 / 手机)的小段文本数据,每次请求时会自动附带至服务器。可通过Expires或Max-Age设置过期时间,默认随浏览器关闭失效。

- 首次访问:服务器返回响应时,通过

Set-Cookie头部设置 Cookie(如用户 ID、会话 ID)。 - 后续请求:浏览器自动携带 Cookie 至服务器,服务器解析后识别用户状态。

Session 是存储在服务器端的用户状态数据,通过Session ID与客户端关联(通常存储在 Cookie 中)。

- 首次登录:服务器生成

Session ID,存储用户信息(如角色、权限),并通过 Cookie 返回JSESSIONID。 - 后续请求:浏览器携带

JSESSIONID,服务器根据 ID 查询 Session 数据。 - 过期机制:默认 30 分钟未活动则失效,可通过

sessionTimeout配置。

Token 是客户端携带的加密字符串,包含用户身份信息,服务器无需存储状态即可验证合法性。例如:JWT(JSON Web Token)、OAuth 2.0 Access Token。

Cookie 安全:

- 启用

HttpOnly防止 XSS 攻击。 - 启用

Secure仅在 HTTPS 下传输。 - 配置

SameSite为Strict/Lax防止 CSRF 攻击。

Session 安全:

- 定期更新

JSESSIONID(如登录后刷新 Session)。 - 分布式环境使用 Redis 存储 Session,避免单点故障。

- 设置合理的过期时间,超时后强制登出。

Token 安全:

- 使用 HTTPS 传输 Token,防止中间人攻击。

- 采用非对称加密(如 RS256),服务器仅保存公钥。

- 实现 Token 黑名单机制(如用户登出时将 Token 加入 Redis 黑名单)。

- 短有效期 Token + 长有效期 Refresh Token 组合(如 OAuth 2.0)。

HTTP 请求和 HTTP 会话

1. HTTP 请求(HTTP Request)

-

定义:客户端(如浏览器)向服务器发送的一次数据请求,包含请求方法(GET/POST 等)、URL、请求头和请求体等信息。

- 特点:

- 无状态:每个请求都是独立的,服务器不会自动记录请求之间的关联。

- 生命周期:从客户端发送请求开始,到服务器返回响应结束,持续时间短。

- 场景:例如用户点击一次链接、提交一次表单,都是一次 HTTP 请求。

2. HTTP 会话(HTTP Session)

-

定义:用于跟踪客户端与服务器之间的交互状态,将多次请求关联起来,通常通过

Session ID标识。 - 特点:

- 有状态:服务器通过 Session 保存用户状态(如登录信息、购物车数据),不同请求可共享 Session 数据。

- 生命周期:从用户首次访问创建 Session 开始,到超时(默认 30 分钟左右)或主动销毁结束。

- 实现方式:

- Cookie:服务器通过 Set-Cookie 响应头将 Session ID 存入客户端 Cookie,后续请求携带 Cookie 以识别会话。

- URL 重写:将 Session ID 拼入 URL(如

/path;jsessionid=xxx),适用于禁用 Cookie 的场景。

3. 核心对比

| 维度 | HTTP 请求 | HTTP 会话(Session) |

|---|---|---|

| 状态跟踪 | 无状态,单次请求独立 | 有状态,跟踪多次请求的关联关系 |

| 数据存储 | 不保存数据 | 保存用户状态数据(如登录信息) |

| 持续时间 | 单次请求 - 响应周期内有效 | 从创建到超时 / 销毁,持续时间较长 |

| 应用场景 | 单次数据获取 / 提交 | 跨请求的状态保持(如登录、购物车) |

4. 关联关系

-

一次 HTTP 会话由多次 HTTP 请求组成,每次请求通过 Session ID 关联到同一会话。

- 例如:用户登录后,后续浏览商品、添加购物车等请求,都会通过 Session 共享登录状态。

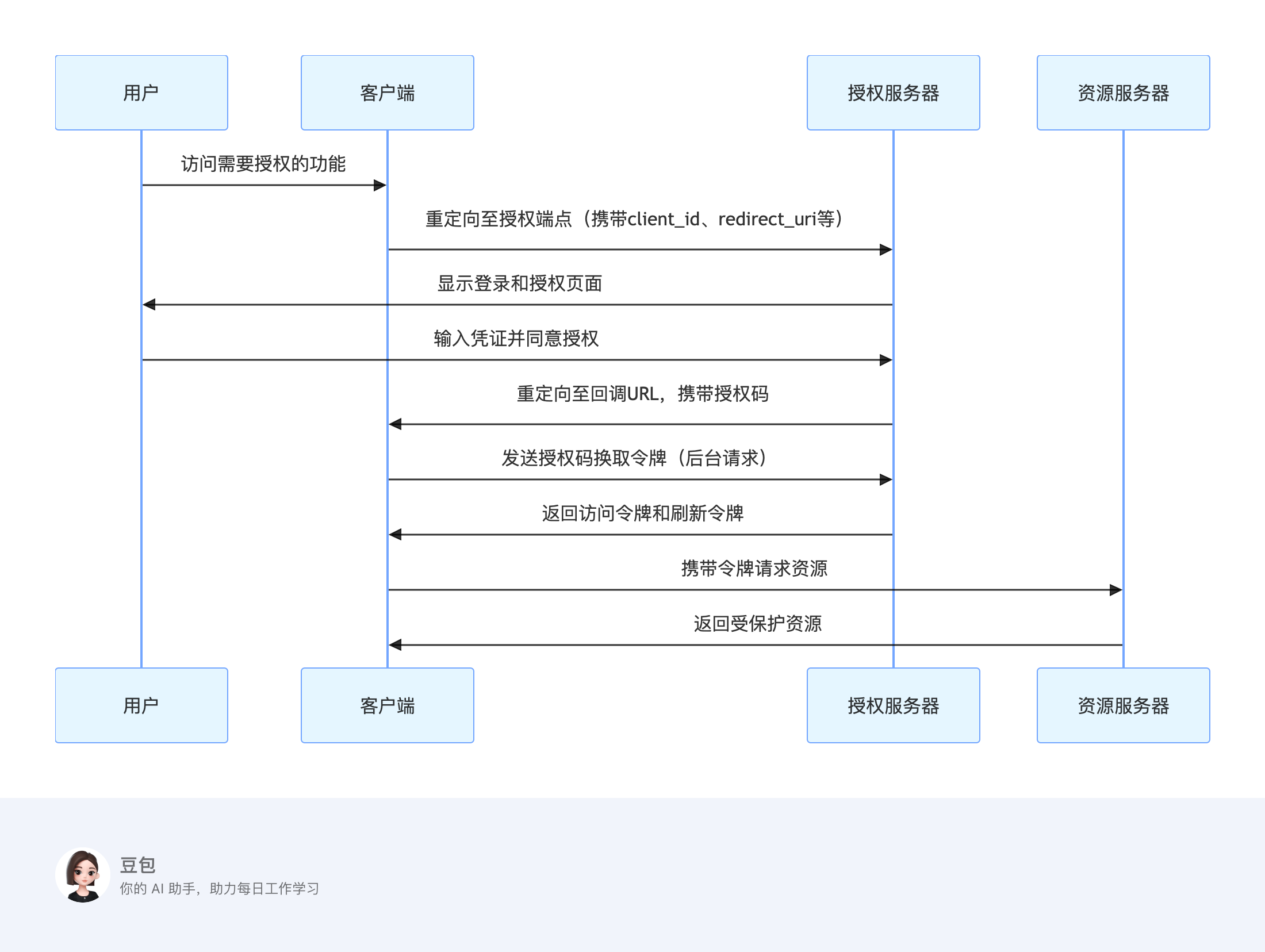

OAuth 2.0

单体架构 VS 微服务

微服务:把一个大型的软件应用拆分成一个个小的、独立的服务。每个服务都能单独运行、部署和维护,他们之间通过网络来互相通信和协作。

| 维度 | 单体架构 | 微服务架构 |

|---|---|---|

| 组织形式 | 单一代码库,单一部署单元 | 多个独立服务,独立部署 |

| 开发效率 | 初期高,后期因代码膨胀降低 | 团队并行开发,效率更高 |

| 技术栈 | 统一技术栈 | 各服务可自由选择技术栈 |

| 故障影响 | 单点故障导致整体不可用 | 单个服务故障不影响全局 |

| 扩展性 | 整体扩展,资源浪费 | 按需扩展特定服务 |

| 部署复杂度 | 低(单一部署单元) | 高(需管理多个服务) |

| 团队协作 | 适合小团队,沟通成本低 | 适合大团队,需明确服务边界 |

| 典型场景 | 中小型应用、功能稳定的系统 | 大型复杂系统、快速迭代的产品 |

-

微服务架构中常见的治理组件有哪些?各自解决什么问题?

- 注册中心(如 Nacos/Eureka):服务注册与发现,解决服务实例动态管理问题;

- 网关(如 Spring Cloud Gateway/APISIX):请求路由、负载均衡、权限控制;

- 熔断与限流(如 Sentinel/Hystrix):防止级联故障,保障服务可用性;

- 服务网格(如 Istio):流量治理、可观测性增强(链路追踪、Metrics 监控)。

-

微服务调用的分布式事务如何解决?

- 两阶段提交(2PC,例如XA协议):强一致性,适合金融场景;

- 最终一致性(如消息队列事务消息、TCC 模式):适用于高并发业务;

- 举例如:用 RocketMQ 事务消息实现订单与库存的异步一致性。

两阶段提交:把事务的提交过程分成准备和提交两个阶段。在准备阶段,所有参与者都要准备好提交,并且锁住相关资源。在提交阶段,如果所有参与者都准备就绪,协调器就会通知大家正式提交事务;要是有任何一个参与者不同意,就会回滚事务。它的优点是比较简单直接,能保证强一致性,但缺点是性能开销大,一旦协调器出问题,可能会导致事务阻塞。

最终一致性:不要求事务在每个阶段都保持强一致,允许系统在一定时间内达到最终的一致性。它通过异步通信和补偿机制来实现,性能更好,也更灵活,能适应高并发场景。不过,实现起来相对复杂一些,而且可能会出现数据不一致的情况。可以通过引入重试机制、用定时任务检查并修复解决。

总的来说,两阶段提交适合对一致性要求极高、并发量不太大的场景;最终一致性则更适合高并发、对一致性要求没那么严格的场景。

事务回滚:在微服务里,一般会用分布式事务框架来实现回滚。比如说,XA协议就是一种常见的实现方式,它通过在每个参与者中加入事务管理器,来记录事务的状态和操作日志。一旦需要回滚,事务管理器就会根据日志把事务操作撤销。还有一些框架像TCC,它是通过每个服务自己实现Try、Confirm和Cancel接口来完成回滚的。Try阶段记录操作,Confirm阶段提交,要是失败就进入Cancel阶段回滚。

K8s

- Node 是 K8s 集群中的工作节点(可以是物理机或虚拟机)

- Pod 运行在 Node 上,由 kubelet 管理

- 容器 是 Pod 的组成单元,共享 Pod 的网络和存储

Kubernetes(简称 K8s)是一个开源的容器编排平台,用于自动化部署、扩展和管理容器化应用。它将容器化的应用抽象为更高层次的资源,提供统一的管理接口。

关键组件

- Master 节点:集群控制中心,包含 API Server、Scheduler、Controller Manager 等

- Worker 节点:运行应用容器的工作节点,包含 Kubelet、Kube-proxy 和 Container Runtime

- Pod:K8s 最小调度单元,包含一个或多个紧密关联的容器

- Service:为 Pod 提供稳定的网络访问地址

- Deployment:声明式定义 Pod 的部署和扩缩策略

- ConfigMap/Secret:外部化配置和敏感信息管理

- Volume:持久化存储

- Ingress:集群外部访问入口控制器

Java 后端开发常见 K8s 面试问答

(一)基础概念类

Q1:什么是 K8s?为什么需要它?

A1:

K8s 是容器编排平台,解决了容器化应用的部署、扩展、管理和运维难题。传统容器管理需要手动处理容器调度、负载均衡、故障恢复等,而 K8s 提供自动化解决方案,提升开发效率和系统可靠性。

Q2:K8s 中的 Pod 是什么?为什么不直接部署容器?

A2:

- Pod 是 K8s 最小调度单元,一个 Pod 可包含多个紧密关联的容器(如主应用容器 + 日志收集容器)。

- 设计 Pod 的原因:

- 容器间共享网络和存储

- 支持原子调度(Pod 作为整体调度)

- 简化应用模型(将多个协作容器视为单一实体)

Q3:Deployment 和 ReplicaSet 的区别是什么?

A3:

- ReplicaSet:确保指定数量的 Pod 副本始终运行,实现基本的副本控制。

- Deployment:管理 ReplicaSet 的生命周期,支持滚动更新、回滚等高级特性。

关系:Deployment → ReplicaSet → Pod

Q4:什么是 Service?有哪些类型?

A4:

- Service:为 Pod 提供稳定的网络访问地址,解耦客户端与 Pod 的直接依赖。

- 类型:

- ClusterIP:集群内部访问(默认类型)

- NodePort:通过节点端口暴露服务(外部可访问)

- LoadBalancer:集成云提供商负载均衡器

- ExternalName:将服务映射到外部域名

(二)实践应用类

Q5:如何在 K8s 中部署 Java 应用?

A5:

- 创建 Docker 镜像:基于 OpenJDK 基础镜像打包应用

- 编写 Deployment 配置:定义 Pod 规格(如内存 / CPU 限制)

- 创建 Service:暴露应用端口

- 可选配置:

- ConfigMap 挂载配置文件

- Secret 管理敏感信息(如数据库密码)

- Horizontal Pod Autoscaler(HPA)实现自动扩缩

示例 Deployment 片段:

apiVersion: apps/v1

kind: Deployment

metadata:

name: java-app-deployment

spec:

replicas: 3

selector:

matchLabels:

app: java-app

template:

metadata:

labels:

app: java-app

spec:

containers:

- name: java-app-container

image: my-java-app:1.0.0

ports:

- containerPort: 8080

resources:

requests:

memory: "512Mi"

cpu: "250m"

limits:

memory: "1Gi"

cpu: "500m"

env:

- name: DB_URL

valueFrom:

configMapKeyRef:

name: db-config

key: url

Q6:如何实现 Java 应用的滚动更新和回滚?

A6:

-

滚动更新:

修改 Deployment 的镜像版本,K8s 会逐步替换旧 Pod(默认每次替换 25%)。kubectl set image deployment/java-app-deployment java-app-container=my-java-app:2.0.0 -

回滚:

kubectl rollout undo deployment/java-app-deployment

Q7:如何优化 Java 应用在 K8s 中的性能?

A7:

- 合理设置资源请求和限制:避免资源浪费或竞争

- 启用 JVM 容器感知参数:

java -XX:+UseContainerSupport -XX:MaxRAMPercentage=75.0 -jar app.jar - 使用合适的垃圾回收器:如 G1(适合容器环境)

- 实现健康检查:配置 Liveness 和 Readiness Probes

- 避免全局锁:高并发场景优化同步机制

(三)高级特性类

Q8:什么是 Horizontal Pod Autoscaler(HPA)?如何为 Java 应用配置?

A8:

- HPA:基于 CPU、内存或自定义指标自动调整 Pod 数量。

配置示例:

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: java-app-hpa

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: java-app-deployment

minReplicas: 2

maxReplicas: 10

metrics:

- type: Resource

resource:

name: cpu

target:

type: Utilization