面试官:你的系统限流阈值是怎么设定的?系统限流阈值设定的工程实践与深度思考

在分布式系统的稳定性保障体系中,熔断、降级、限流构成了不可或缺的"三重防线"。然而,相较于熔断和降级的相对直观,限流技术的复杂性往往被低估。许多工程师能够熟练掌握各种限流算法的实现原理,却在面对一个看似简单的问题时陷入沉默:“你们系统的限流阈值是如何确定的?”

系统限流阈值设定的工程实践与深度思考

作者:默语佬

专栏:高并发系统架构设计

标签:限流策略、阈值计算、系统容量规划、性能调优

🚀 引言

在分布式系统的稳定性保障体系中,熔断、降级、限流构成了不可或缺的"三重防线"。然而,相较于熔断和降级的相对直观,限流技术的复杂性往往被低估。许多工程师能够熟练掌握各种限流算法的实现原理,却在面对一个看似简单的问题时陷入沉默:“你们系统的限流阈值是如何确定的?”

这个问题的深度远超表面,它不仅考验你对算法理论的掌握,更检验你将理论转化为生产实践的工程能力。今天,我将从一个资深架构师的视角,为你深度剖析限流阈值设定的科学方法论。

📋 目录

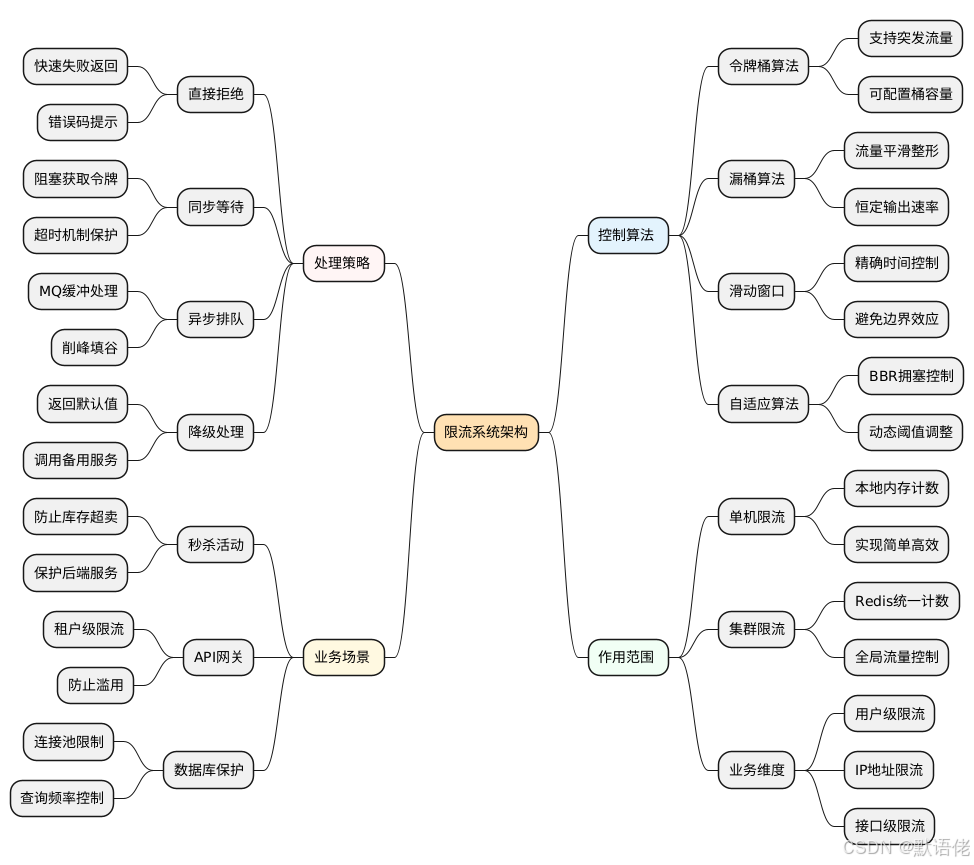

🎯 限流技术基础架构

核心组成要素

限流系统的设计可以抽象为三个核心维度的技术决策:控制算法、作用范围、处理策略。

算法分类与特征

从实现机制的角度,限流算法可以划分为静态配置型和动态自适应型两大类别:

| 算法类型 | 典型实现 | 配置方式 | 适应性 | 实现复杂度 |

|---|---|---|---|---|

| 静态配置 | 令牌桶、漏桶、滑动窗口 | 人工预设阈值 | 固定不变 | 简单 |

| 动态自适应 | BBR、自定义指标 | 算法自动调节 | 实时响应 | 复杂 |

⚙️ 限流算法深度解析

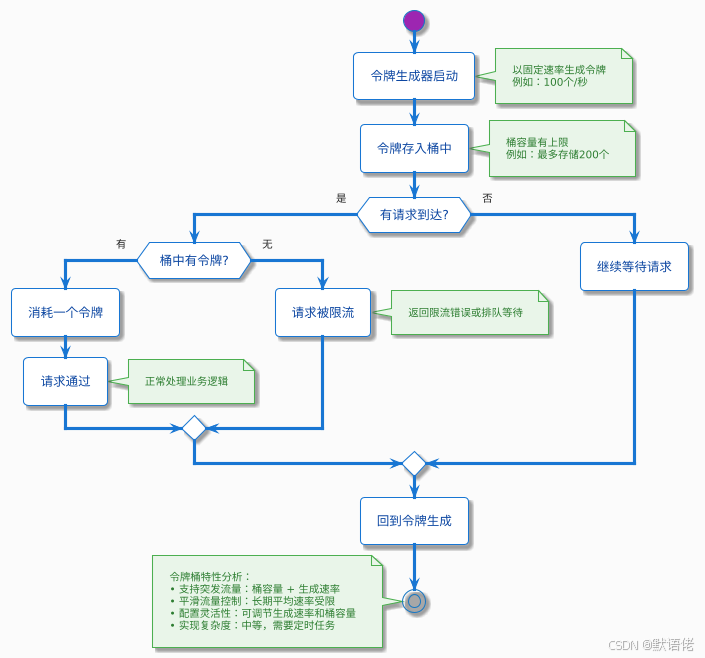

令牌桶算法:突发流量的优雅处理

令牌桶算法通过"预存令牌"的机制,为系统提供了处理合理突发流量的能力。

核心参数配置策略

令牌桶的两个关键参数需要根据业务特征精心设计:

- 令牌生成速率:决定系统的长期平均处理能力

- 桶容量大小:决定系统对突发流量的容忍度

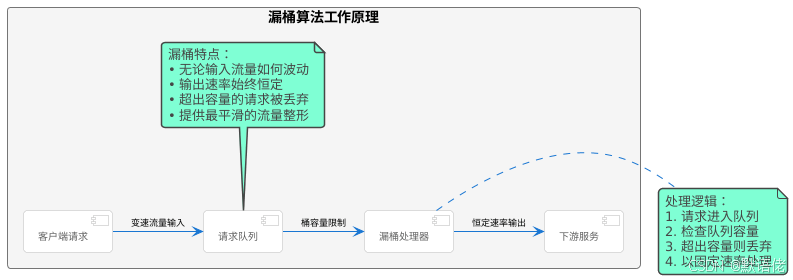

漏桶算法:绝对平滑的流量整形

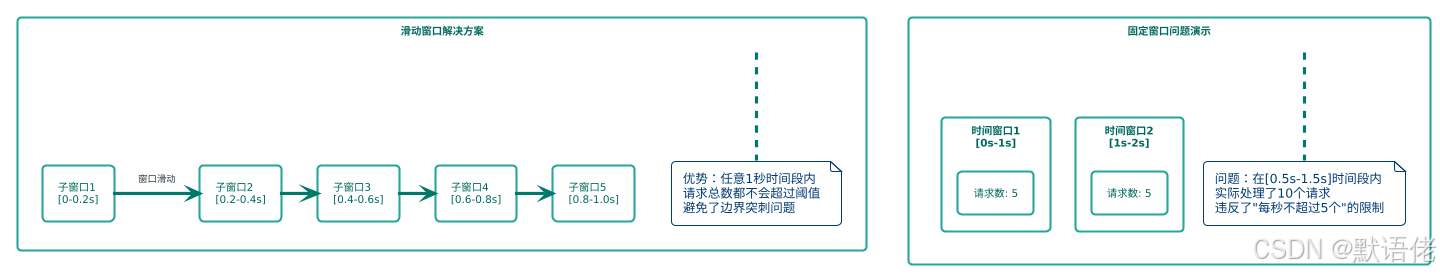

滑动窗口算法:精确的时间边界控制

滑动窗口算法解决了固定窗口在时间边界处的流量突刺问题。

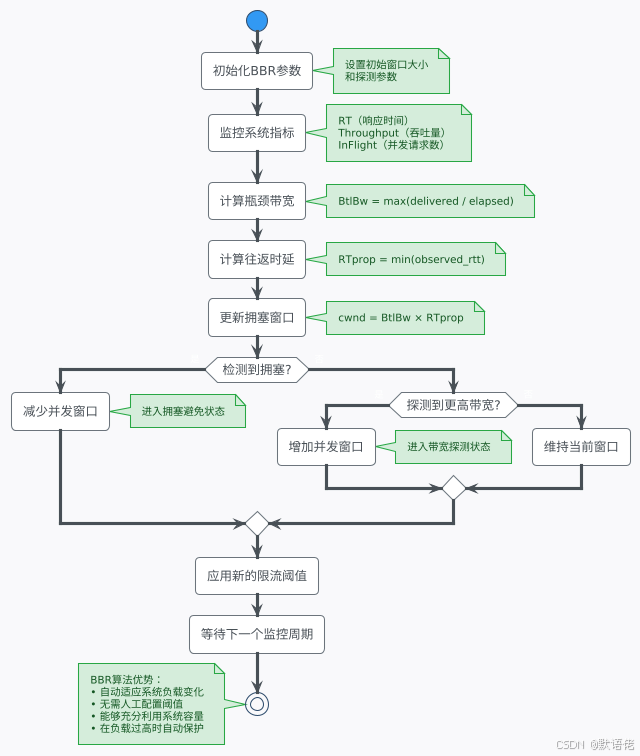

自适应限流:BBR算法的工程应用

BBR(Bottleneck Bandwidth and Round-trip propagation time)算法借鉴TCP拥塞控制思想,通过监控系统关键指标实现动态限流。

🔬 阈值计算的科学方法论

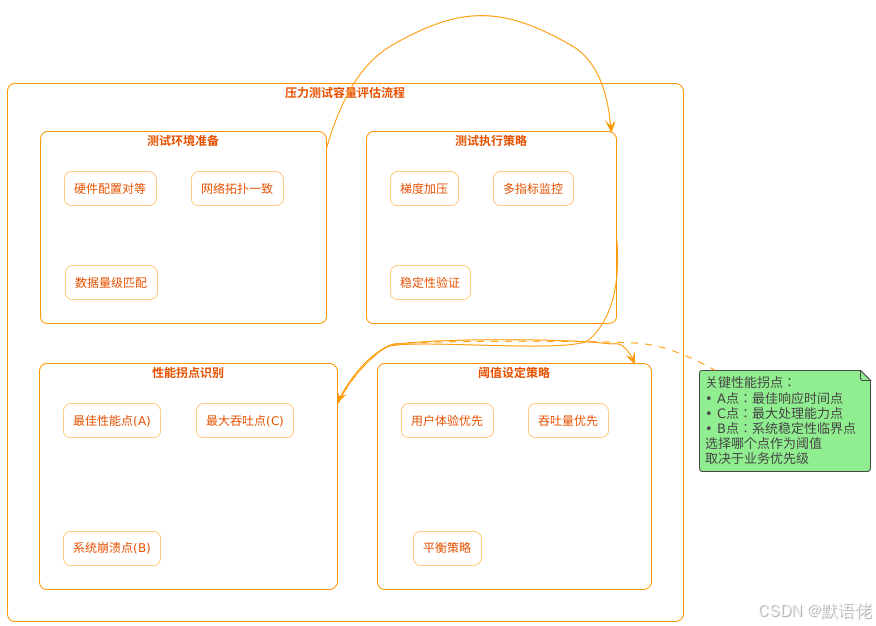

方法一:压力测试驱动的容量评估(金标准)

压力测试是确定系统真实容量的最科学方法,通过系统性的性能测试找到系统的性能拐点。

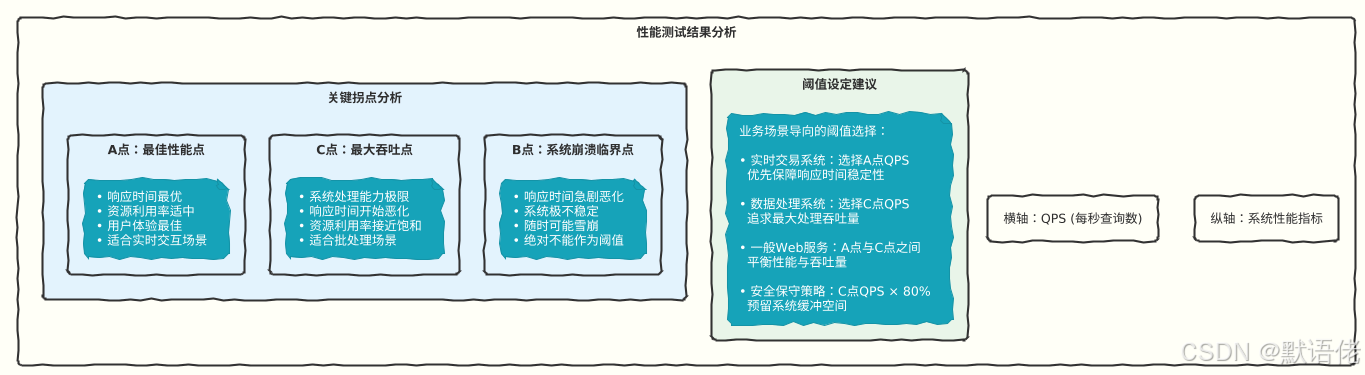

性能曲线分析与阈值选择

基于压测数据,我们可以绘制出经典的性能特征曲线:

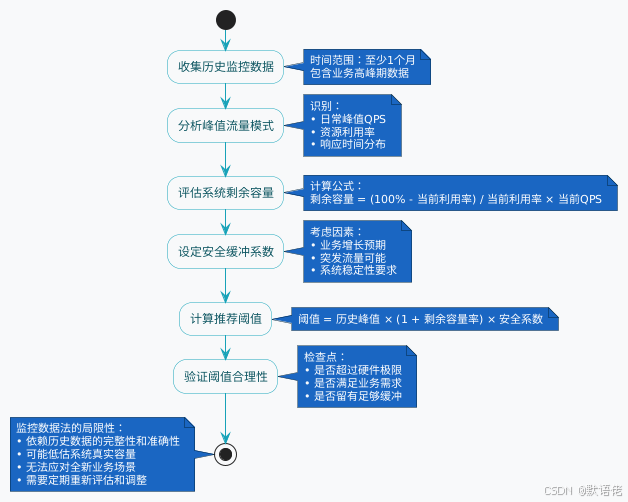

方法二:监控数据驱动的经验推导

当无法进行充分压测时,可以基于历史监控数据进行阈值推算。

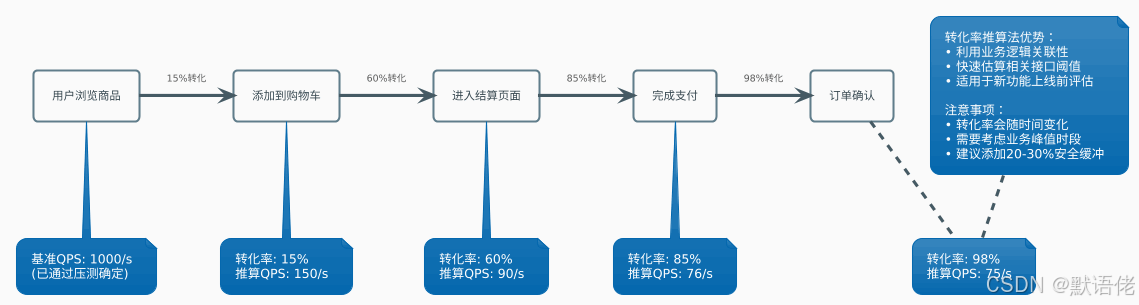

方法三:业务转化率驱动的关联推算

通过分析业务流程中各环节的转化率,推算相关联接口的合理阈值。

方法四:理论计算与资源建模

基于系统资源消耗模型进行理论计算,适用于缺乏历史数据的全新系统。

/**

* 基于资源消耗的理论QPS计算模型

*

* @author 默语佬

*/

public class TheoreticalQpsCalculator {

/**

* 计算单机理论QPS上限

*

* @param avgProcessingTime 单请求平均处理时间(ms)

* @param cpuCores CPU核心数

* @param concurrencyFactor 并发系数(通常0.6-0.8)

* @return 理论QPS上限

*/

public static int calculateTheoreticalQps(

double avgProcessingTime,

int cpuCores,

double concurrencyFactor) {

// 基础计算公式

double baseQps = (1000.0 / avgProcessingTime) * cpuCores;

// 考虑并发效率损失

double theoreticalQps = baseQps * concurrencyFactor;

return (int) Math.floor(theoreticalQps);

}

/**

* 请求处理时间分解分析

*/

public static class RequestProcessingBreakdown {

private double rpcCallTime = 0; // RPC调用耗时

private double redisAccessTime = 0; // Redis访问耗时

private double dbQueryTime = 0; // 数据库查询耗时

private double businessLogicTime = 0; // 业务逻辑处理耗时

private double serializationTime = 0; // 序列化耗时

public double getTotalProcessingTime() {

return rpcCallTime + redisAccessTime + dbQueryTime +

businessLogicTime + serializationTime;

}

// 详细的性能分析示例

public static RequestProcessingBreakdown analyzeEcommerceOrder() {

RequestProcessingBreakdown breakdown = new RequestProcessingBreakdown();

// 下游服务调用:用户信息验证

breakdown.rpcCallTime = 25.0; // 25ms

// Redis缓存访问:商品信息、库存信息

breakdown.redisAccessTime = 2.0 * 2; // 2次访问,每次2ms

// 数据库查询:订单表写入、库存扣减

breakdown.dbQueryTime = 15.0; // 15ms

// 业务逻辑:价格计算、优惠券验证、风控检查

breakdown.businessLogicTime = 8.0; // 8ms

// 序列化:请求解析、响应构建

breakdown.serializationTime = 3.0; // 3ms

return breakdown; // 总计:53ms

}

}

/**

* 实际应用示例

*/

public static void main(String[] args) {

// 分析电商订单处理接口

RequestProcessingBreakdown breakdown =

RequestProcessingBreakdown.analyzeEcommerceOrder();

double avgTime = breakdown.getTotalProcessingTime(); // 53ms

int cpuCores = 8; // 8核CPU

double concurrencyFactor = 0.7; // 70%并发效率

int theoreticalQps = calculateTheoreticalQps(avgTime, cpuCores, concurrencyFactor);

System.out.println("=== 理论QPS计算结果 ===");

System.out.println("单请求处理时间: " + avgTime + "ms");

System.out.println("CPU核心数: " + cpuCores);

System.out.println("并发效率系数: " + concurrencyFactor);

System.out.println("理论QPS上限: " + theoreticalQps);

// 应用安全系数

int recommendedThreshold = (int) (theoreticalQps * 0.6); // 60%安全系数

System.out.println("推荐限流阈值: " + recommendedThreshold);

}

}

🏭 生产环境实战案例

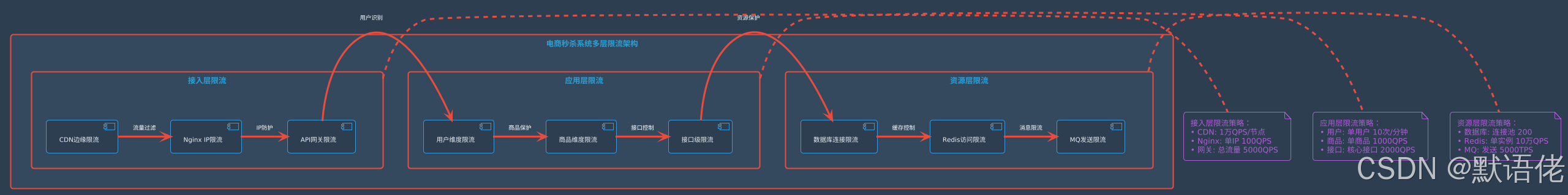

案例一:电商秒杀系统的多层限流设计

案例二:微服务间的自适应限流

基于服务调用链的健康状态,实现动态限流阈值调整:

/**

* 微服务自适应限流器

* 基于下游服务健康状态动态调整限流阈值

*

* @author 默语佬

*/

@Component

public class AdaptiveRateLimiter {

private static final Logger logger = LoggerFactory.getLogger(AdaptiveRateLimiter.class);

@Autowired

private ServiceHealthMonitor healthMonitor;

@Autowired

private RedisTemplate<String, String> redisTemplate;

// 基础限流配置

private final Map<String, RateLimitConfig> baseConfigs = new ConcurrentHashMap<>();

/**

* 自适应限流决策

*

* @param serviceId 目标服务ID

* @param currentQps 当前QPS

* @return 是否允许通过

*/

public boolean allowRequest(String serviceId, int currentQps) {

RateLimitConfig config = getAdaptiveConfig(serviceId);

// 获取当前时间窗口的请求计数

String key = buildRateLimitKey(serviceId);

String countStr = redisTemplate.opsForValue().get(key);

int currentCount = countStr != null ? Integer.parseInt(countStr) : 0;

if (currentCount >= config.getThreshold()) {

logger.warn("服务 {} 触发限流,当前QPS: {}, 阈值: {}",

serviceId, currentCount, config.getThreshold());

return false;

}

// 增加计数

redisTemplate.opsForValue().increment(key, 1);

redisTemplate.expire(key, Duration.ofSeconds(1));

return true;

}

/**

* 基于服务健康状态动态调整限流配置

*/

private RateLimitConfig getAdaptiveConfig(String serviceId) {

RateLimitConfig baseConfig = baseConfigs.get(serviceId);

if (baseConfig == null) {

baseConfig = loadBaseConfig(serviceId);

baseConfigs.put(serviceId, baseConfig);

}

// 获取下游服务健康指标

ServiceHealthMetrics metrics = healthMonitor.getHealthMetrics(serviceId);

// 计算动态调整系数

double adjustmentFactor = calculateAdjustmentFactor(metrics);

// 应用调整系数

int adaptiveThreshold = (int) (baseConfig.getBaseThreshold() * adjustmentFactor);

return RateLimitConfig.builder()

.serviceId(serviceId)

.threshold(adaptiveThreshold)

.adjustmentFactor(adjustmentFactor)

.lastUpdateTime(System.currentTimeMillis())

.build();

}

/**

* 计算基于健康指标的调整系数

*/

private double calculateAdjustmentFactor(ServiceHealthMetrics metrics) {

double factor = 1.0;

// 基于响应时间调整

if (metrics.getAvgResponseTime() > 1000) { // 超过1秒

factor *= 0.7; // 降低30%

} else if (metrics.getAvgResponseTime() > 500) { // 超过500ms

factor *= 0.85; // 降低15%

}

// 基于错误率调整

if (metrics.getErrorRate() > 0.05) { // 错误率超过5%

factor *= 0.6; // 降低40%

} else if (metrics.getErrorRate() > 0.02) { // 错误率超过2%

factor *= 0.8; // 降低20%

}

// 基于CPU利用率调整

if (metrics.getCpuUsage() > 0.8) { // CPU超过80%

factor *= 0.75; // 降低25%

}

// 确保调整系数在合理范围内

return Math.max(0.3, Math.min(1.2, factor));

}

private String buildRateLimitKey(String serviceId) {

long currentSecond = System.currentTimeMillis() / 1000;

return String.format("rate_limit:%s:%d", serviceId, currentSecond);

}

/**

* 限流配置类

*/

@Data

@Builder

public static class RateLimitConfig {

private String serviceId;

private int baseThreshold; // 基础阈值

private int threshold; // 当前生效阈值

private double adjustmentFactor; // 调整系数

private long lastUpdateTime; // 最后更新时间

}

/**

* 服务健康指标

*/

@Data

public static class ServiceHealthMetrics {

private double avgResponseTime; // 平均响应时间(ms)

private double errorRate; // 错误率(0-1)

private double cpuUsage; // CPU使用率(0-1)

private double memoryUsage; // 内存使用率(0-1)

private int activeConnections; // 活跃连接数

}

}

🚀 高级限流策略设计

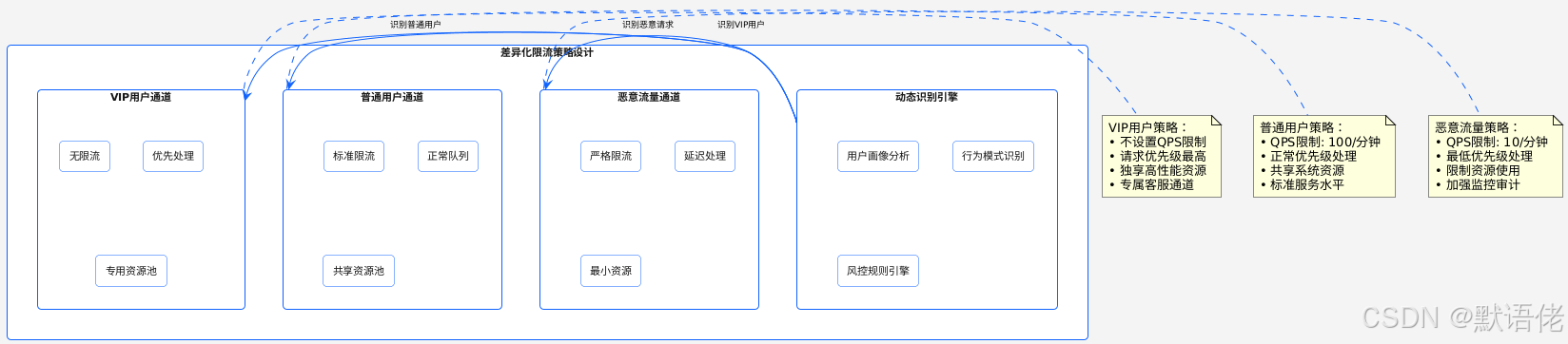

基于业务优先级的差异化限流

分布式限流的一致性保障

/**

* 分布式限流的Redis Lua脚本实现

* 保证原子性和一致性

*

* @author 默语佬

*/

@Service

public class DistributedRateLimiter {

@Autowired

private RedisTemplate<String, String> redisTemplate;

// 滑动窗口限流Lua脚本

private static final String SLIDING_WINDOW_SCRIPT =

"local key = KEYS[1] " +

"local window = tonumber(ARGV[1]) " +

"local limit = tonumber(ARGV[2]) " +

"local current_time = tonumber(ARGV[3]) " +

// 清理过期数据

"redis.call('ZREMRANGEBYSCORE', key, '-inf', current_time - window * 1000) " +

// 获取当前窗口内的请求数

"local current_requests = redis.call('ZCARD', key) " +

"if current_requests < limit then " +

" redis.call('ZADD', key, current_time, current_time) " +

" redis.call('EXPIRE', key, window + 1) " +

" return {1, current_requests + 1} " +

"else " +

" return {0, current_requests} " +

"end";

/**

* 分布式滑动窗口限流

*

* @param key 限流键

* @param windowSizeSeconds 窗口大小(秒)

* @param limit 限流阈值

* @return 限流结果

*/

public RateLimitResult slidingWindowLimit(String key, int windowSizeSeconds, int limit) {

DefaultRedisScript<List> script = new DefaultRedisScript<>();

script.setScriptText(SLIDING_WINDOW_SCRIPT);

script.setResultType(List.class);

List<String> keys = Collections.singletonList(key);

Object[] args = {

String.valueOf(windowSizeSeconds),

String.valueOf(limit),

String.valueOf(System.currentTimeMillis())

};

List result = redisTemplate.execute(script, keys, args);

boolean allowed = ((Long) result.get(0)) == 1;

long currentCount = (Long) result.get(1);

return RateLimitResult.builder()

.allowed(allowed)

.currentCount(currentCount)

.limit(limit)

.remainingCount(Math.max(0, limit - currentCount))

.resetTime(System.currentTimeMillis() + windowSizeSeconds * 1000)

.build();

}

@Data

@Builder

public static class RateLimitResult {

private boolean allowed; // 是否允许通过

private long currentCount; // 当前计数

private long limit; // 限流阈值

private long remainingCount; // 剩余配额

private long resetTime; // 重置时间

}

}

📊 总结与最佳实践

限流阈值设定的工程方法论

通过本文的深度分析,我们可以总结出一套完整的限流阈值设定方法论:

🎯 科学评估的四层递进法

- 压力测试法(首选):通过系统性能测试找到真实容量边界

- 监控数据法(补充):基于历史数据推算合理阈值范围

- 业务关联法(辅助):利用转化率推算相关接口阈值

- 理论计算法(兜底):基于资源消耗模型进行估算

🔧 动态调优的持续改进策略

- 配置中心化管理:支持热更新,无需重启服务

- 多维度监控告警:实时跟踪限流效果和系统健康状态

- A/B测试验证:小流量验证新阈值的有效性

- 自动化回滚机制:异常情况下快速恢复到安全配置

🚀 面试中的亮点展示

当面试官询问限流阈值设定时,展现你的技术深度:

- 方法论完整性:从压测到监控到理论计算的全方位覆盖

- 实战经验丰富:结合具体业务场景的案例分析

- 技术视野前瞻:自适应限流、分布式一致性等高级话题

- 工程能力突出:从理论到实践的完整落地方案

🔮 技术发展趋势展望

- AI驱动的智能限流:基于机器学习的流量预测和自动调优

- 云原生限流方案:容器化环境下的弹性限流策略

- 边缘计算限流:CDN和边缘节点的分布式限流协调

- 业务感知限流:结合业务语义的智能化流量管控

关于作者

默语佬,资深系统架构师,专注于高并发系统设计与性能优化,在大型互联网公司有多年的分布式系统架构经验。对系统稳定性保障、容量规划、性能调优等领域有深入研究和丰富实践。

如果这篇文章对你有帮助,请点赞👍、收藏⭐、关注🔔,你的支持是我持续创作的动力!

本文为原创技术文章,转载请注明出处。欢迎在评论区分享你的限流实践经验和遇到的技术挑战!

更多推荐

已为社区贡献112条内容

已为社区贡献112条内容

所有评论(0)