LangChain-大模型介绍

模型是“数据炼成的规律工厂”。大语言模型借千亿参数、自监督“完形填空”习得通用语言,聊天写代码样样通。嵌入模型把文字转语义向量,支撑搜索推荐RAG。API、本地、SDK三法接入,敏感数据选本地,快速原型用API。

🌈 个人主页:Zfox_

🔥 系列专栏:LangChain-AI 应用开发框架

一:🔥 认识模型

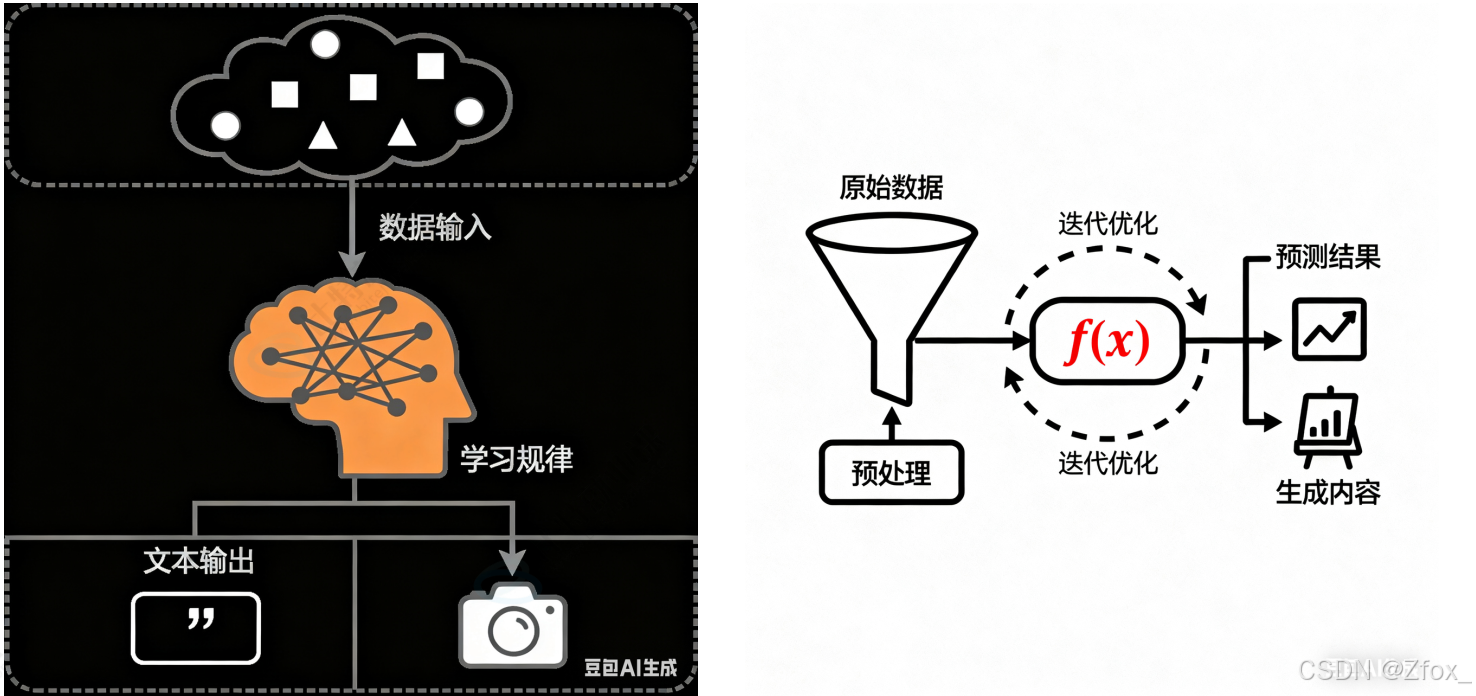

模型是⼀个从数据中学习规律的“数学函数”或“程序”。旨在处理和⽣成信息的算法,通常模仿⼈类的认知功能。通过从⼤型数据集中学习模式和洞察,这些模型可以进⾏预测、⽣成⽂本、图像或其他输出,从⽽增强各个⾏业的各种应⽤。

可以简单理解为模型是⼀个"超级加⼯⼚",这个⼯⼚是经过特殊训练的,训练师给它看了海量的例⼦ (数据),并告诉它该怎么做。通过看这些例⼦,它⾃⼰摸索出了⼀套规则,学会了完成某个"特定任务"。模型就是⼀套学到的"规则"或者"模式",它能根据你给的东西,产⽣你想要的东西。

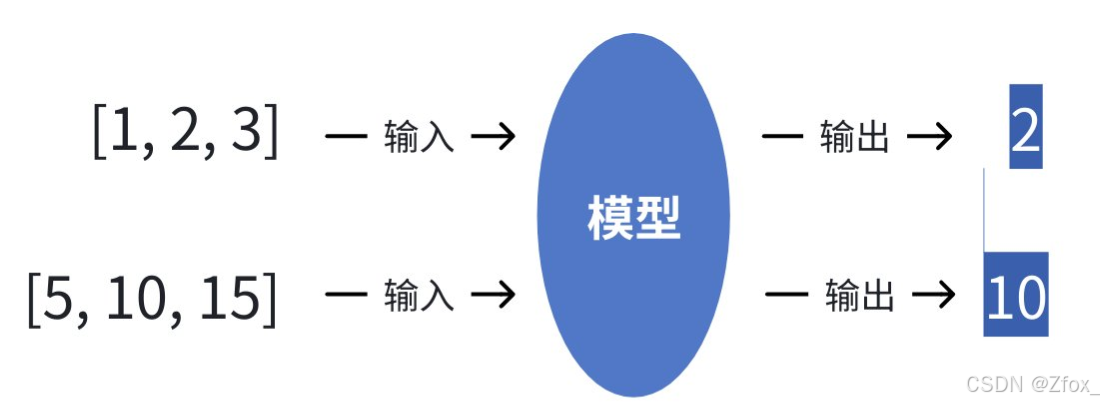

最简单的⽐喻:给模型很多组数据:

模型的任务就是找出输⼊和输出之间的规律(⽐如:输出是中间那个数)。学成之后:当我们再输⼊[8, 9, 10] 时,它能根据学到的规律预测出输出应该是 9 。

模型的关键特点在于:

- 特定任务:⼀个模型通常只擅⻓⼀件事。⽐如:

- ⼀个模型专⻔识别图⽚⾥是不是猫。

- ⼀个模型专⻔预测明天会不会下⾬。

- ⼀个模型专⻔判断⼀条评论是好评还是差评。

- 需要“标注数据”:训练这种模型需要⼤量“标准答案”。(⽐如:成千上万张已经标注好“是猫”或“不是猫”的图⽚)。

- 参数较少:参数是模型从数据中学到的“知识要点”或“内部规则”(⽐如:上述⽰例中的规则仅是"中间数")。参数较少说明模型的复杂度和能⼒相对有限。

二:🔥 认识⼤语⾔模型

🦋 什么是⼤语⾔模型?

⼤语⾔模型(LargeLanguageModel,LLM)是指基于⼤规模神经⽹络(参数规模通常达数⼗亿⾄万亿级别,例如 GPT-3 包含 1750 亿参数),通过⾃监督或半监督⽅式,对海量⽂本进⾏训练的语⾔模型。

名词解释:

- 神经⽹络:⼀个极其⾼效的“团队⼯作流程”或“条件反射链”。

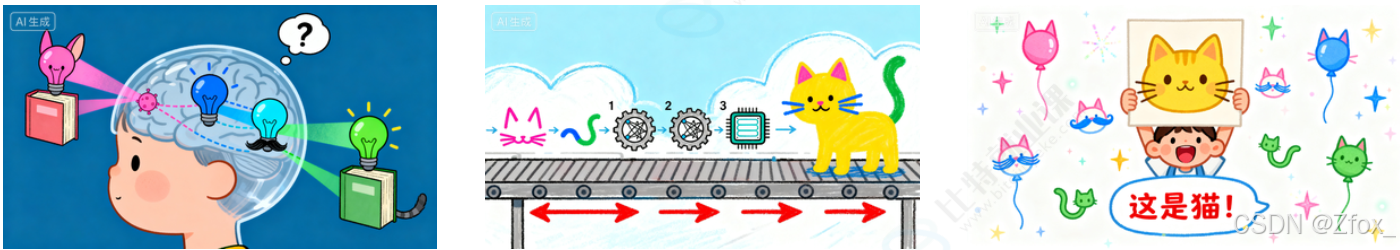

例如教⼀个⼩朋友识别猫:

- 不会只给⼀条规则(⽐如“有胡⼦就是猫”),因为兔⼦也有胡⼦。

- 我们会让他看很多猫的图⽚,他⼤脑⾥的视觉神经会协同⼯作:

- 有的神经元负责识别“尖⽿朵”,

- 有的负责识别“胡须”,

- 有的负责识别“⽑茸茸的尾巴”。

- 这些神经元⼀层层地传递和组合信息,最后⼤脑综合判断:“这是猫!”

神经⽹络就是模仿⼈脑的这种⼯作⽅式。

- 它由⼤量虚拟的“神经元”(也就是参数)和连接组成。

- 每个神经元都像⼀个⼩处理单元,负责处理⼀点点信息。⽆数个神经元分成很多层,前⼀层的输出作为后⼀层的输⼊。

- 通过海量数据的训练,这个⽹络会⾃⼰调整每个“神经元”的重要性(即参数的值),最终形成⼀个⾮常复杂的“判断流⽔线”。⽐如,⼀个识别猫的神经⽹络,某些参数可能专⻔负责识别猫的眼睛,另⼀些参数专⻔负责识别猫的轮廓。

简单说:神经⽹络就是⼀个通过数据训练出来的、由⼤量参数组成的复杂决策系统

- ⾃监督学习:“完形填空”超级⼤师。

例如我们想学会⼀⻔外语,但没有⽼师给出题和批改。怎么办?

- 我们可以拿⼀本该语⾔的⼩说,⾃⼰玩“完形填空”:随机盖住⼀个词,然后根据上下⽂猜测这个词是什么。

- ⼀开始猜得乱七⼋糟。

- 但不断地重复这个过程,看了成千上万本书后,对这个语⾔的语法、词汇搭配、上下⽂逻辑了如指掌。现在不仅能轻松猜对被盖住的词,甚⾄能⾃⼰写出流畅的⽂章。

⾃监督学习就是这个过程。

- 模型⾯对海量的、没有标签的原始⽂本(⽐如互联⽹上的所有⽂章、⽹⻚)。

- 它⾃⼰给⾃⼰创造任务:把⼀句话中间的某个词遮住,然后尝试根据前后的词来预测这个被遮住的词。

- 通过亿万次这样的练习,模型就深刻地学会了语⾔的规律。它不需要⼈类⼿动去给每句话标注“这是主语”、“这是谓语”。

简单说:⾃监督就是让模型从数据本⾝找规律,⾃⼰给⾃⼰当⽼师。

- 半监督学习:“师⽗领进⻔,修⾏在个⼈”。

例如你想学做菜:

- 师傅先教你⼏道招牌菜(⽐如⿇婆⾖腐、宫保鸡丁)⸺这相当于给了你⼀些“有标注的数据”(菜谱和成品)。

- 然后,师傅让你去尝遍天下各种美⻝,⾃⼰研究其中的⻔道⸺这相当于接触海量的“⽆标注数据”(各种未知的⻝材和味道)。

- 你结合师傅教的基本功和⾃⼰尝遍天下美⻝的经验,最终不仅能完美复刻招牌菜,还能创新出新的菜式。这就是“半监督”。

先⽤少量带标签的数据让模型“⼊⻔”,掌握⼀些基本规则,然后再让它去海量的⽆标签数据中⾃我学习和提升。这对于⼤语⾔模型来说也是⼀种常⽤的训练⽅式。

简单说:半监督就是“少量指导+⼤量⾃学”的结合模式。

- 语⾔模型:⼀个“超级⾃动补全”或“语⾔预测器”。

例如你在⽤⼿机打字,输⼊“今天天⽓真”,输⼊法会⾃动提⽰“好”、“不错”、“冷”等。这个输⼊法之所以能提⽰,就是因为它内部有⼀个⼩型的“语⾔模型”,它根据你输⼊的前⽂,计算下⼀个词最可能是什么。

语⾔模型的核⼼任务就是预测下⼀个词。⼀个强⼤的语⾔模型,能够根据⼀段话,预测出最合理、最通顺的下⼀个词是什么,这样⼀个个词接下去,就能⽣成⼀整段话、⼀篇⽂章。

简单说:语⾔模型就是⼀个计算“接下来最可能说什么”的模型。

现在,我们再回头看那段描述,就⼀⽬了然了。翻译成⼤⽩话就是:

⼤语⾔模型是⼀个:

- ⽤“超级团队⼯作流程”(⼤规模神经⽹络)搭建的,拥有数百亿甚⾄上万亿个“脑细胞”(参数)的“超级⾃动补全系统”(语⾔模型)。

- 它学习的⽅式,主要是通过⾃⼰玩“海量完形填空”(⾃监督学习),或者“少量名师指导+海量⾃学”(半监督学习)……

- 从互联⽹上所有的⽂本数据中学会了语⾔的规律。

因此,它具有以下⼏个核⼼特点:

- 规模巨⼤:它的“脑细胞”(参数)特别多(通常达到数⼗亿甚⾄万亿级别),所以思考问题更复杂、更全⾯,就像⼀⽀百万⼤军和⼀个⼩分队的区别。

- 通⽤性强:它不是为单⼀任务训练的。因为它通过“完形填空”学会的是整个语⾔世界的底层规律(语法、逻辑、知识关联),⽽不是只背会了“猫的图⽚”。所以它能举⼀反三,把底层能⼒灵活应⽤到聊天、翻译、写代码等各种任务上。这种“涌现”能⼒,就像孩⼦通过⼤量阅读后,突然能写出意想不到的优美句⼦⼀样。

- 训练⽅式不同:主要使⽤⾃监督学习,从海量⽆标注的原始⽂本中学习。它不依赖⼈⼯⼀张张地给图⽚标“这是猫”,⽽是直接从原始⽂本中⾃学,效率极⾼,规模可以做得⾮常⼤。

- 交互⽅式⾰命:我们不⽤点按钮、写代码,直接像对⼈说话⼀样给它指令(Prompt)它就能听懂并执⾏,⽐如你直接说“写⼀⾸关于春天的诗”,它就能给你写出来。

🦋 主流的⼤语⾔模型

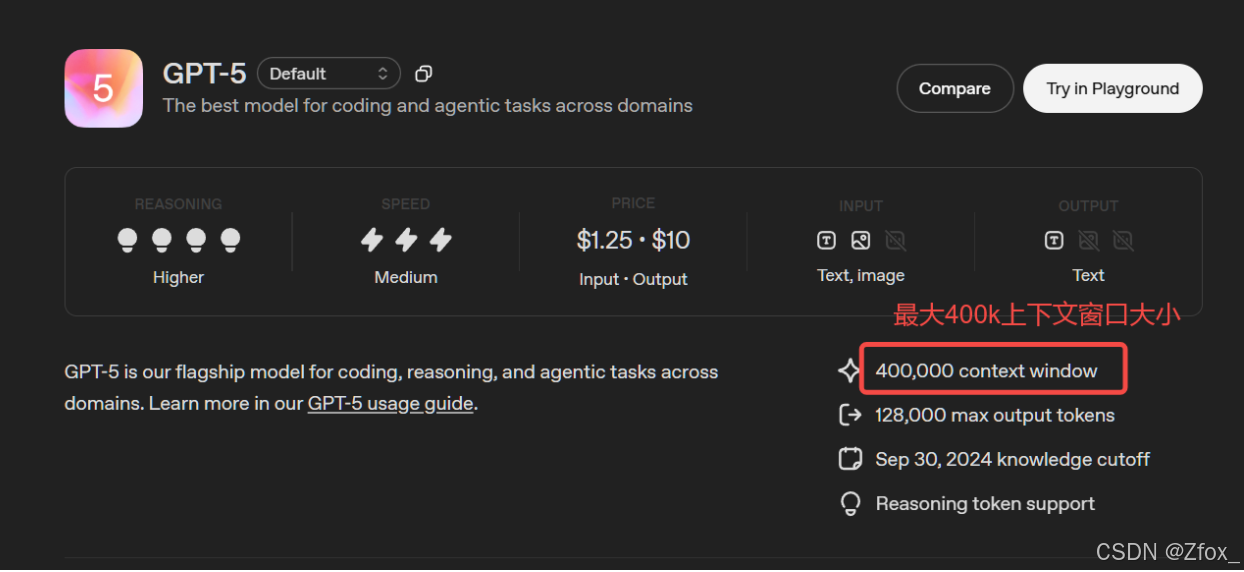

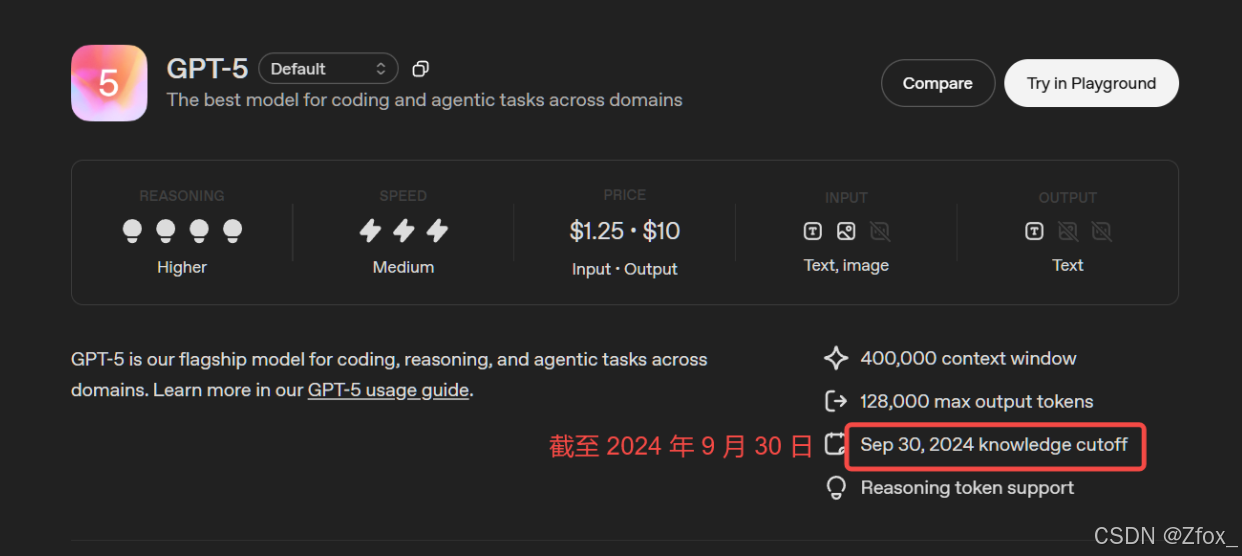

- GPT-5(OpenAI):⽀持400k背景信息⻓度,128k最⼤输出标记,在多轮复杂推理、创意写作中表现突出

- DeepSeekR1(深度求索):开源,专注于逻辑推理与数学求解,⽀持128K⻓上下⽂和多语⾔(20+语⾔),在科技领域表现突出

- Qwen2.5-72B-Instruct(阿⾥巴巴):通义千问开源模型家族重要成员,擅⻓代码⽣成结构化数据(如JSON)处理⻆⾊扮演对话等,尤其适合企业级复杂任务,⽀持包括中⽂英⽂法语等29种语⾔

- Gemini2.5Pro(Google):多模态融合标杆,⽀持图像/代码/⽂本混合输⼊,适合跨模态任务(如图⽂⽣成、技术⽂档解析)

其他参考:

- HuggingfaceLLM性能排⾏榜:https://huggingface.co/spaces/ArtificialAnalysis/LLMPerformance-Leaderboard

- 发展历程参考:https://segmentfault.com/a/1190000046532208

🦋 LLM的能⼒包括哪些?

⼤模型,对不少⼈来说已变得⽿熟能详,从⼤型科技公司到初创企业,都纷纷投⾝于这场技术变⾰。AI⼤模型不仅仅是技术圈的热⻔话题,它也正⽇新⽉异的速度融⼊我们的⽇常⽣活,改变着我们获取信息、处理⼯作、甚⾄进⾏创作的⽅式。

我们将⼤模型的能⼒归纳为四点,这不仅仅是技术指标,更是它改变世界的核⼼利器。

🎀 语⾔⼤师:理解与创造的⾰命

想象⼀下,你是否发⽣过以下类似问题:

- 对学⽣:你是否为论⽂的开头绞尽脑汁?

- 对职场⼈:⼀封礼貌⼜坚决的投诉邮件怎么写?

LLM可以⼲什么?对于:

- 论⽂的开头:告诉⼤模型你的主题和观点,它能为你⽣成⼏个不同⻛格的引⾔段落。例如: “写⼀篇关于《基于深度学习的晶粒度智能评级⽅法》的⼤学⽣论⽂开头供我参考。”

- 投诉邮件:把情况告诉它,它即刻⽣成,你稍作修改就能发送。例如: "帮我写⼀封礼貌⼜坚决的投诉邮件,事情的经过是:xxx

我们发现,它真正“读懂”了⼈类语⾔的千变万化,并能进⾏⾼质量创作。这不是简单的关键词匹配,⽽是理解了上下⽂、情感甚⾄潜台词。

🎀 知识巨⼈:拥有“全互联⽹”的记忆

我们可以问它: “⽤物理学原理解释为什么猫咪总能四脚着地?” 。它不仅能回答,还能类⽐

我们可以让它: “对⽐⼀下古希腊哲学和春秋战国百家争鸣的异同” 。它能为我们提供清晰的思路。

可以看出,⼤模型是⼀个被压缩的、可对话的“互联⽹知识库”。它通过学习海量数据,将知识内在关联,形成了⼀个⽴体的知识⽹络,⽽不仅仅是存储。

🎀 逻辑与代码巫师:从思维到实现的跨越

⼀个复杂的功能,对程序员来说,只需⽤中⽂描述:“写⼀个Python函数,能⾃动爬取某个⽹⻚的最新标题并保存到Excel⾥。”代码瞬间⽣成。

我们可以把⼀道复杂的数学题丢给它,如 “微分⽅程y"-3y’+2y=3x-2e^x的特解y*的形式为?” ,它不仅能给出答案,还能⼀步步展⽰解题过程,成为你的私⼈家教。

可以看出,⼤模型不仅能处理语⾔,还能处理严格的逻辑和编程语法。这证明了它的能⼒超越了“⽂科”,进⼊了需要精确和推理的“理科”领域。

🎀 多模态先知:开启“全感知”AI的⼤⻔

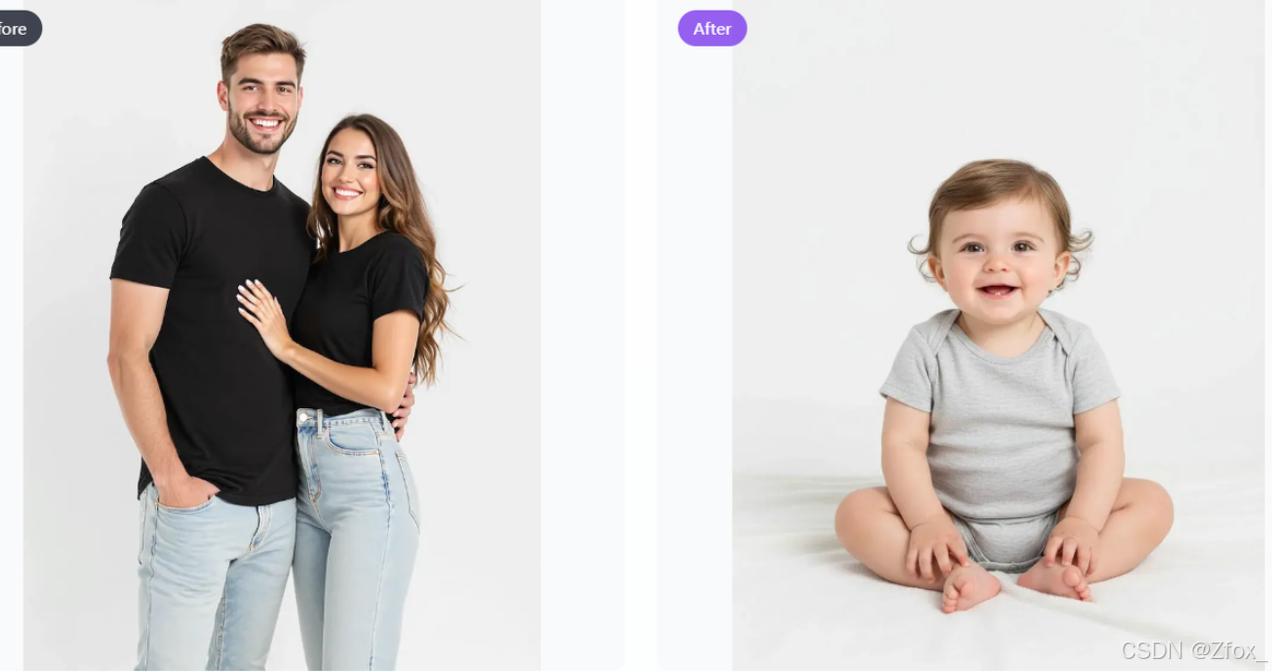

想象⼀下,上传⼀张照⽚,再加⼊⼀段描述,AI可实现快速的对话式创意⼯作流程。https://nanobanana.im/

-

AI婴⼉预测和⽣成: “⽣成他们的宝宝的样⼦ - ⽗⺟双⽅特征的融合。专业的照⽚质量。”

-

3D图形: “请把这张照⽚变成⼀个⼈物。在它后⾯,放置⼀个印有⻆⾊形象的盒⼦。在它旁边,添加⼀台计算机,其屏幕显⽰ Blender 建模过程。在盒⼦前⾯,为⼈偶添加⼀个圆形塑料底座,让它站在上⾯。底座的 PVC 材质应具有晶莹剔透、半透明的质感,并将整个场景设置在室内。”

可以看到,它打破“⽂本”的界限,连接视觉、听觉的世界,让AI更接近⼈类的感知⽅式。这是⽬前最前沿、最令⼈兴奋的能⼒,它让AI真正成为“全能型”助⼿。

🦋 LLM的接⼊⽅式

前⾯我们演⽰的都是通过现成的客⼾端,来进⾏AI⾏为,如聊天、⽣图等。如果现在要我们⾃⼰写⼀个AI应⽤来实现相关AI⾏为,则需要我们⾃⾏接⼊LLM。

常⻅的原⽣LLM(不经过第三⽅平台或复杂的代理层,直接与⼤语⾔模型提供⽅进⾏交互的⽅法)接⼊⽅式有三种:【API远程调⽤】、【开源模型本地部署】和【SDK和官⽅客户端库】

🎀 API接⼊

这是⽬前最主流、最便捷的接⼊⽅式,尤其适⽤于快速开发、集成到现有应⽤以及不想管理硬件资源的场景。

通过HTTP请求(通常是RESTfulAPI)直接调⽤模型提供商部署在云端的模型服务。代表⼚商: OpenAI(GPT-4o),Anthropic(Claude),Google(Gemini),百度⽂⼼⼀⾔,阿⾥通义千问,智谱AI等。

典型流程就是:

- 注册账号并获取APIKey:在模型提供商的平台上注册,获得⽤于⾝份验证的密钥。

- 查阅API⽂档:了解请求的端点、参数(如模型名称、提⽰词、温度、最⼤⽣成⻓度等)和返回的数据格式。

- 构建HTTP请求:在你的代码中,使⽤HTTP客⼾端库(如Python的 requests )构建⼀个包含APIKey(通常在Header中)和请求体(JSON格式,包含你的提⽰和参数)的请求。

- 发送请求并处理响应:将请求发送到提供商指定的API地址,然后解析返回的JSON数据,提取⽣成的⽂本。

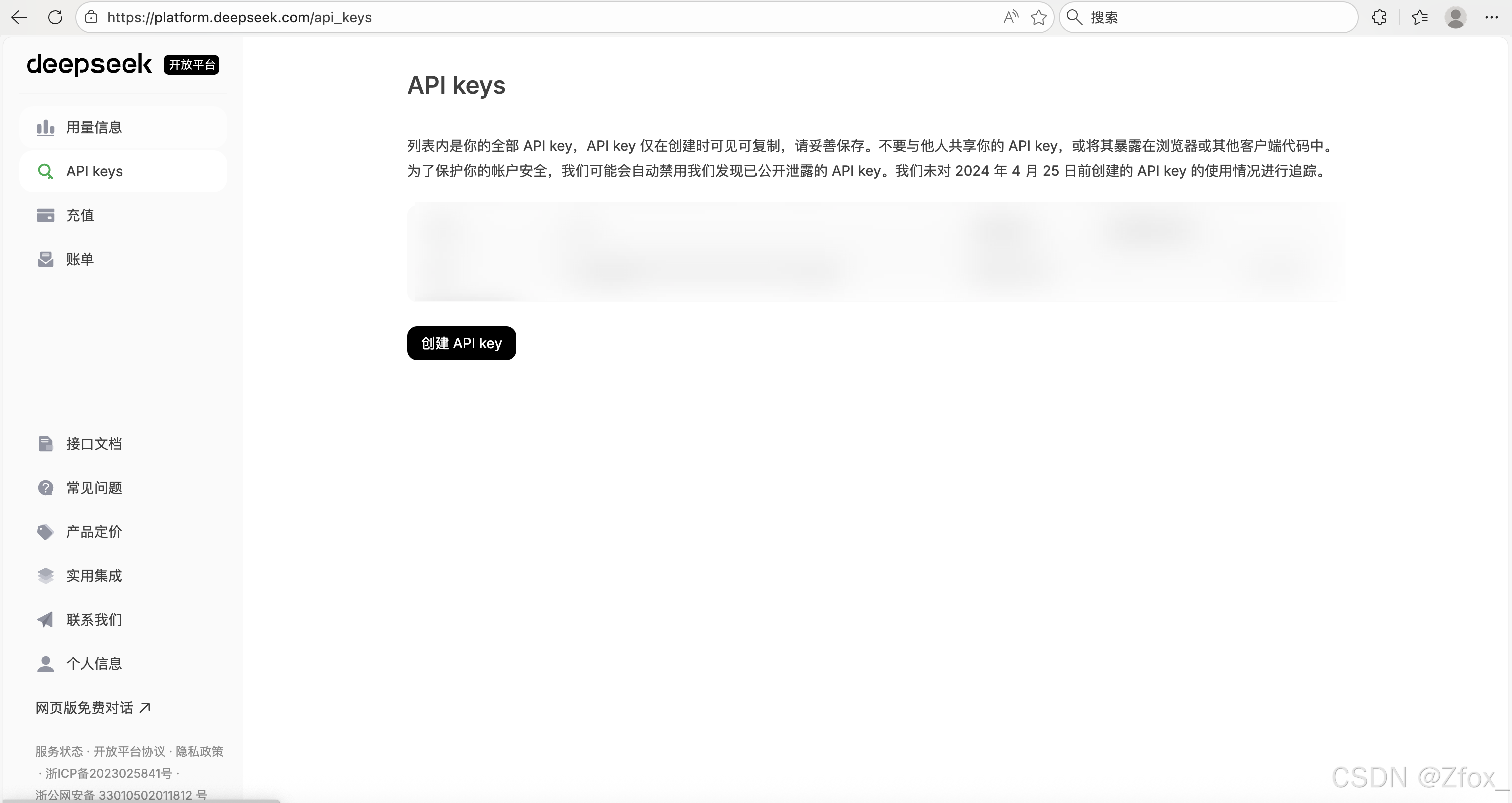

以deepseek为例,官⽹地址:https://www.deepseek.com/

如果没有账号先注册账号,登录成功后,选择API开放平台⻚⾯:

新增APIkey:

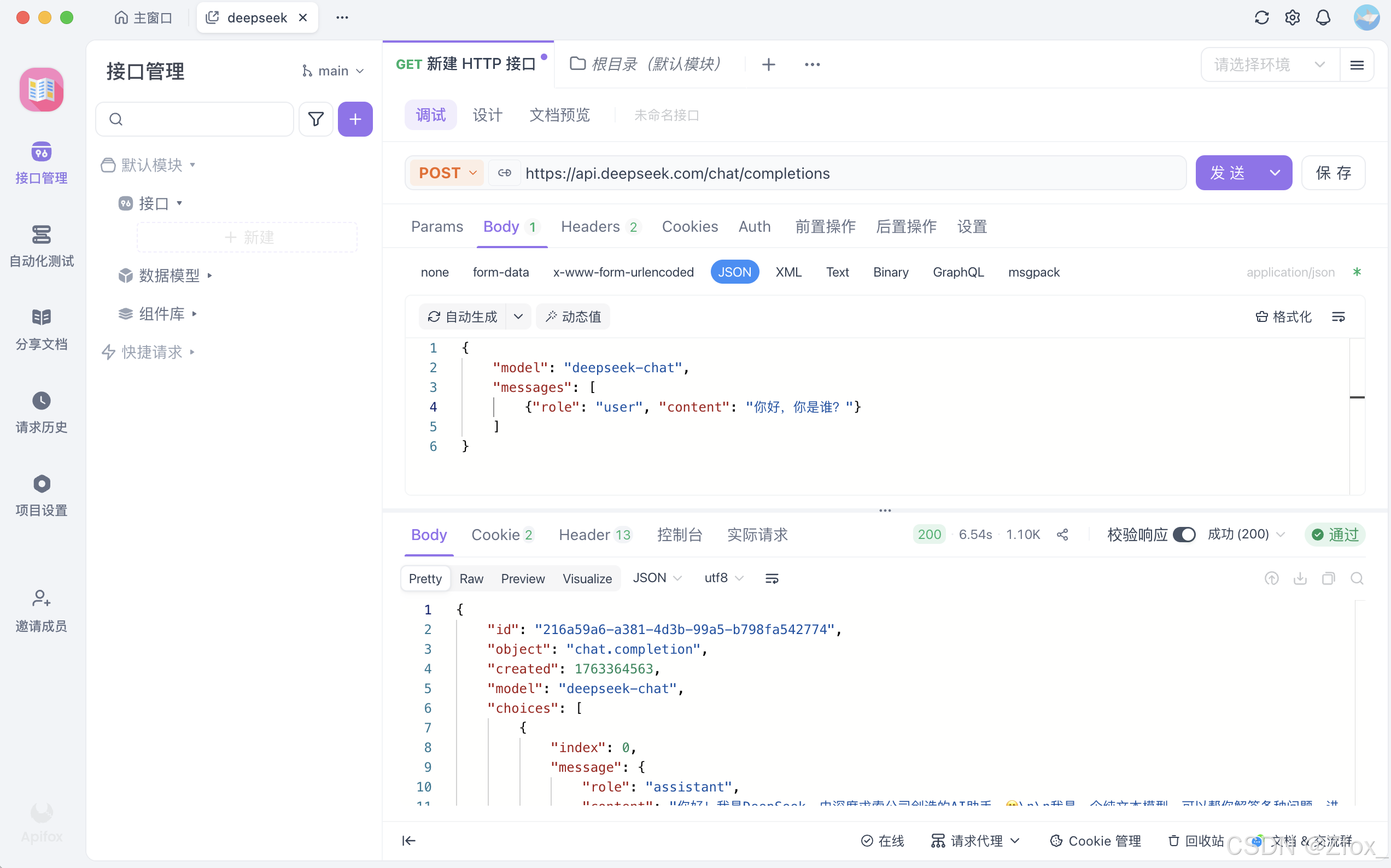

调⽤:

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer ${DEEPSEEK_API_KEY}" \

-d '{

"model": "deepseek-chat",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": false

}'

或使⽤HTTP客户端(如Apifox)发起调⽤:

输出:

{

"id": "216a59a6-a381-4d3b-99a5-b798fa542774",

"object": "chat.completion",

"created": 1763364563,

"model": "deepseek-chat",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "你好!我是DeepSeek,由深度求索公司创造的AI助手。😊\n\n我是一个纯文本模型,可以帮你解答各种问题、进行对话交流、协助处理文本任务等。虽然我不支持多模态识别功能,但我具有文件上传功能,可以读取和处理图像、txt、pdf、ppt、word、excel等文件中的文字信息。\n\n我的知识截止到2024年7月,拥有128K的上下文长度,而且完全免费使用!如果需要联网搜索最新信息,你可以在Web或App上手动点开联网搜索按键。\n\n有什么我可以帮助你的吗?无论是学习、工作还是日常问题,我都很乐意为你提供帮助!✨"

},

"logprobs": null,

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 8,

"completion_tokens": 138,

"total_tokens": 146,

"prompt_tokens_details": {

"cached_tokens": 0

},

"prompt_cache_hit_tokens": 0,

"prompt_cache_miss_tokens": 8

},

"system_fingerprint": "fp_ffc7281d48_prod0820_fp8_kvcache"

}

🎀 本地接⼊

⼤模型本地部署,这种⽅式就是将开源的⼤型语⾔模型(如Llama、ChatGLM、Qwen等)部署在你⾃⼰的硬件环境(本地服务器或私有云)中。核⼼概念就是,将下载模型的⽂件(权重和配置⽂件),使⽤专⻔的推理框架在本地服务器或GPU上加载并运⾏模型,然后通过类似API的⽅式进⾏交互。

典型流程是:

- 获取模型:从HuggingFace(国外)、魔搭社区(国内)等平台下载开源模型的权重。(平台参考本篇章第四节)

- 准备环境:配置具有⾜够显存(如NVIDIAGPU)的服务器,安装必要的驱动和推理框架。

- 选择推理框架:使⽤专为⽣产环境设计的框架来部署模型,例如:

- vLLM:特别注重⾼吞吐量的推理服务,性能极佳。

- TGI:HuggingFace推出的推理框架,功能全⾯。

- Ollama:⾮常⽤⼾友好,可以⼀键拉取和运⾏模型,适合快速⼊⻔和本地开发。

- LMStudio:提供图形化界⾯,让本地运⾏模型像使⽤软件⼀样简单。

- 启动服务并调⽤:框架会启动⼀个本地API服务器(如 http://localhost:8000 ),你可以像调⽤云端API⼀样向这个本地地址发送请求。

以Ollama为例,下⾯我们来演⽰下具体过程。

DeepSeek R1本地化部署 Ollama + Chatbox 打造最强 AI 工具

🎀 SDK接⼊

这并⾮⼀种独⽴的接⼊⽅式,⽽是对第⼀种API接⼊的封装和简化。模型提供商通常会发布官⽅编程语⾔SDK,为我们封装好了底层的HTTP请求细节,提供⼀个更符合编程习惯的、语⾔特定的函数库。

典型流程(以OpenAIPythonSDK为例):

安装库:

pip install openai

安装OpenAISDK后,可以创建⼀个名为 example.py 的⽂件并将⽰例代码复制到其中:

from openai import OpenAI

client = OpenAI(api_key="your-api-key")

response = client.responses.create(

model="gpt-5",

input="介绍⼀下你⾃⼰。"

)

print(response.output_text)

相⽐直接构造HTTP请求,代码更简洁、更易读、更易维护。

🎀 问题与思考

对于以上三种接⼊⽅式,我们该如何选择?

- 看数据敏感性:如果数据极其敏感,必须留在内部,本地部署是唯⼀选择。

- 看技术实⼒和资源:如果团队没有强⼤的MLops(机器学习运维)能⼒,也没有预算购买和维护GPU服务器,云端API是更实际的选择。

- 看成本和规模:如果应⽤规模很⼤,⻓期来看,本地部署的固定成本可能低于持续的API调⽤费⽤。反之,⼩规模应⽤⽤API更划算。

- 看定制需求:如果只是使⽤模型的通⽤能⼒,云端API⾜够。如果需要⽤⾃⼰的数据微调模型,则需要选择⽀持微调的API或直接本地部署。

实际上,只要是原⽣LLM,⽆论怎么接⼊都有限制。为什么?

- 输⼊⻓度限制:所有LLM都有固定的输⼊⻓度(如4K、8K、128K、400KToken)。我们⽆法将⼀本⼏百⻚的PDF或整个公司知识库直接塞给模型。

- 缺乏私有知识:模型的训练数据有截⽌⽇期,且不包含我们的私⼈数据(如公司内部⽂档、个⼈笔记等)。让它基于这些知识回答问题,⾮常困难。

- 复杂任务处理能⼒弱:原⽣API本质是⼀个“⼀问⼀答”的接⼝。对于需要多个步骤的复杂任务(如“分析这份财报,总结要点,并⽣成⼀份PPT⼤纲”),我们需要⾃⼰编写复杂的逻辑来拆解任务、多次调⽤API并管理中间状态。

- 输出格式不可控:虽然可以通过提⽰词要求模型输出JSON或特定格式,但它仍可能产⽣格式错误或不合规的内容,需要我们⾃⼰编写后处理代码来校验和清洗。

像LangChain这样的框架,正是为了系统性地解决这些问题⽽诞⽣的。

三:🔥 认识嵌⼊模型

🦋 什么是嵌⼊模型?

🐧 ⼤语⾔模型是⽣成式模型。它理解输⼊并⽣成新的⽂本(回答问题、写⽂章)。它内部实际上也使⽤嵌⼊技术来理解输⼊,但最终⽬标是“创造”。

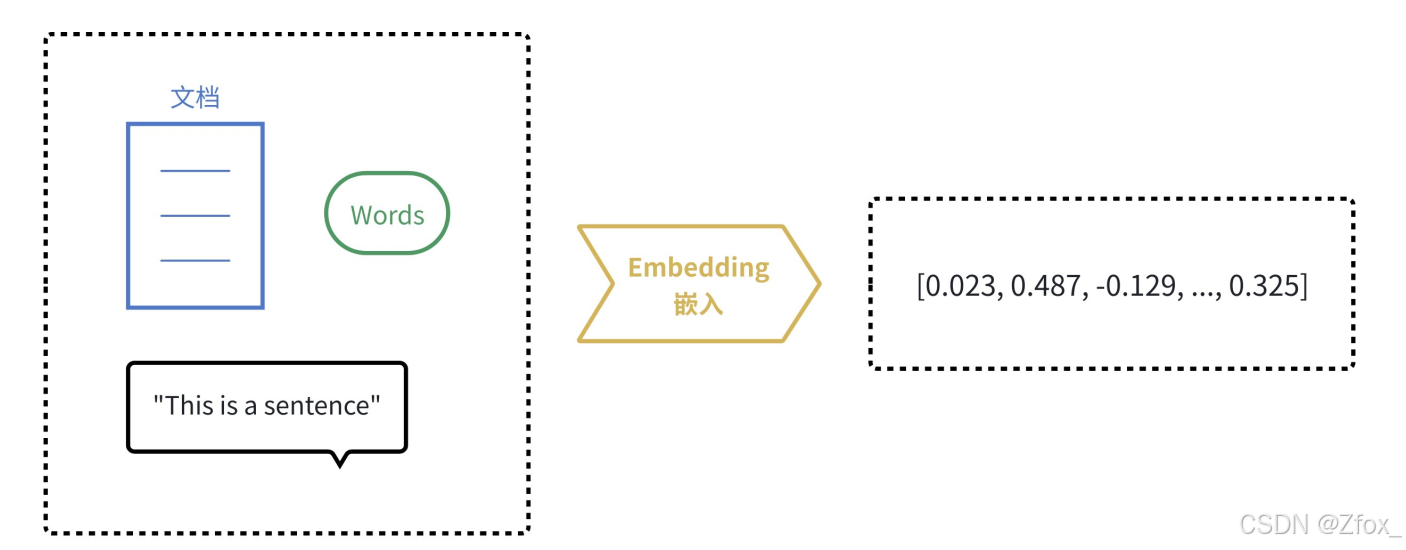

⽽嵌⼊模型(EmbeddingModel)是表⽰型模型。它的⽬标不是⽣成⽂本,⽽是为输⼊的⽂本创建⼀个最佳的、富含语义的数值表⽰(向量)。

由于计算机天⽣擅⻓处理数字,但不理解⽂字、图⽚的含义。嵌⼊(Embedding)的核⼼思想就是将⼈类世界的符号(如单词、句⼦、产品、⽤⼾、图⽚)转换为计算机能够理解的数值形式(即向量,本质上是⼀个数字列表),并且要求这种转换能够保留原始符号的语义和关系。

我们可以把它想象成⼀个翻译过程,把⼈类语⾔“翻译”成计算机的“数学语⾔”。

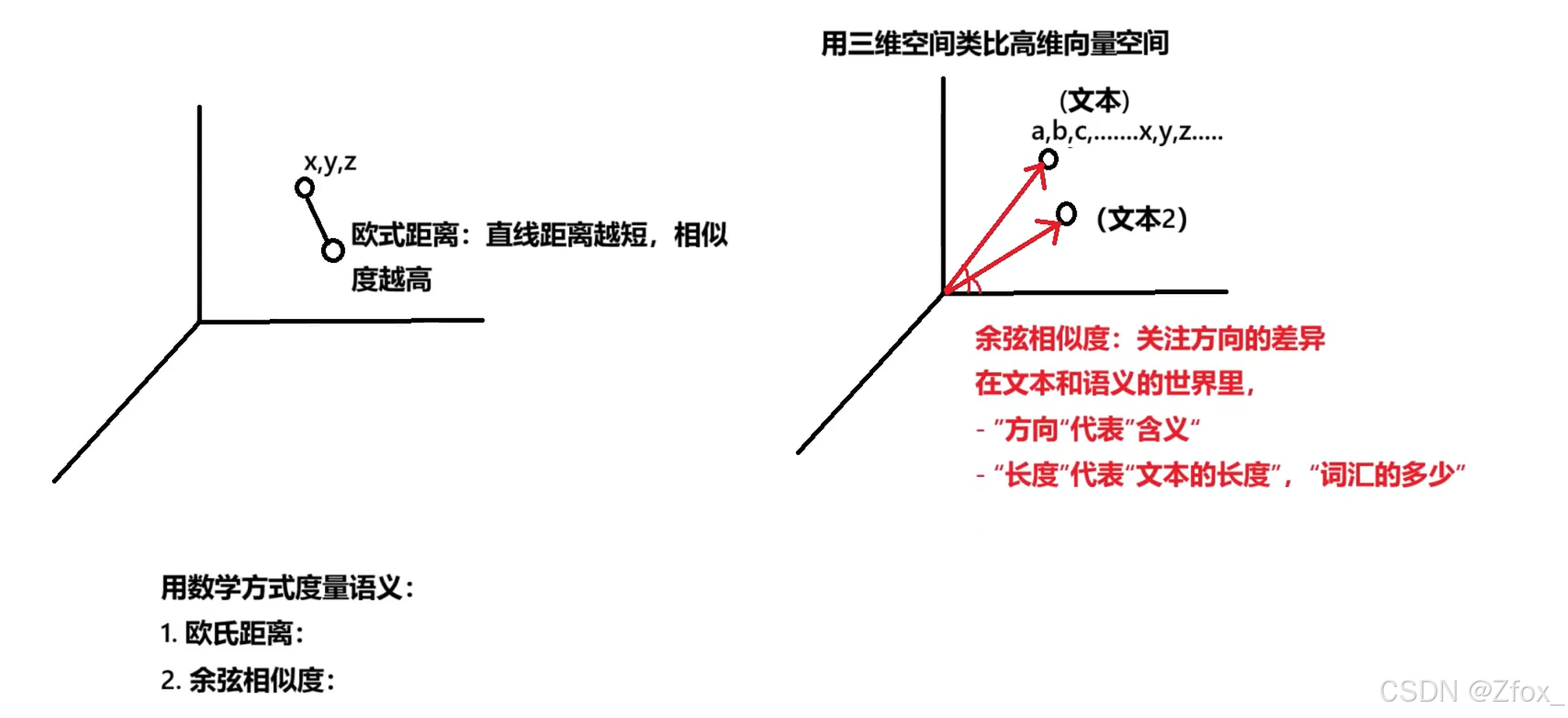

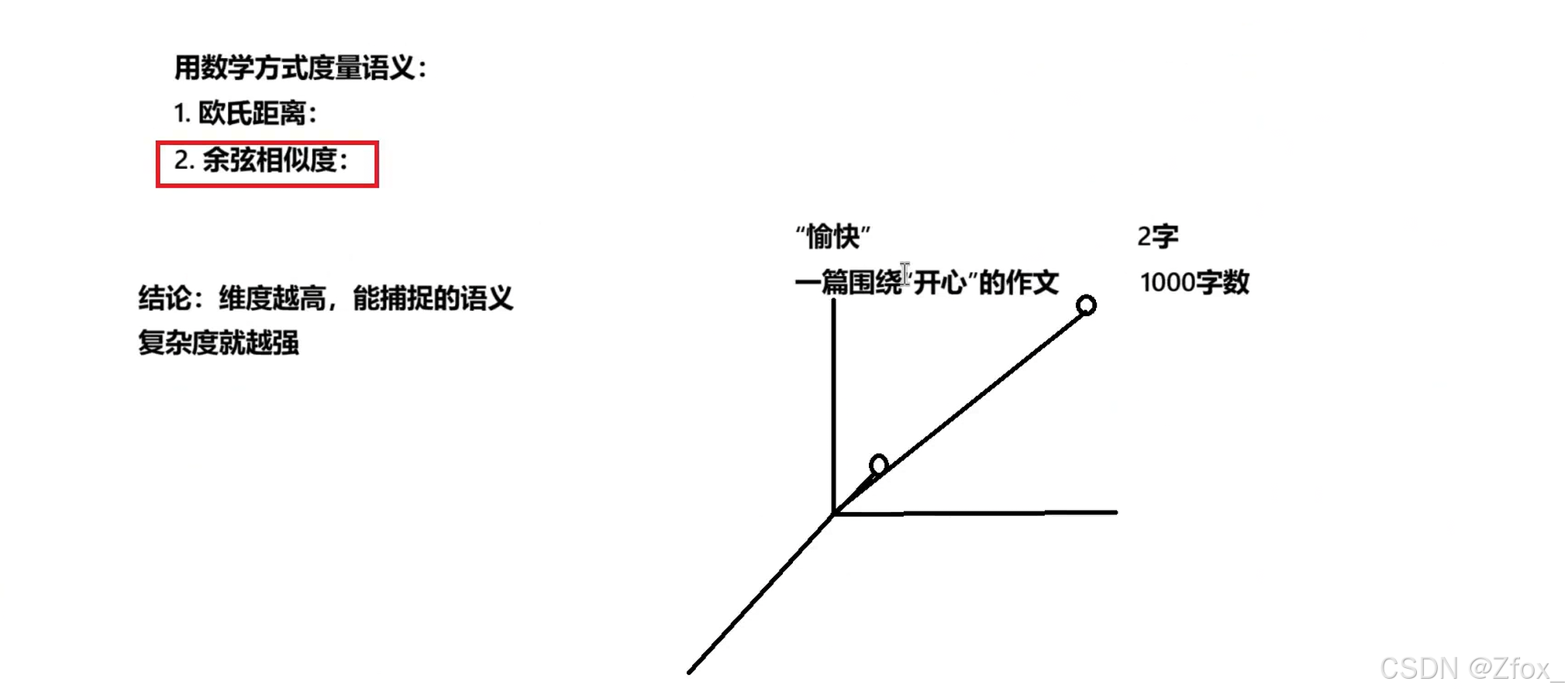

结论:既然是“数学语⾔”,那么我们可以⽤数学的⽅式来⽐较向量,从⽽达到【度量语义】的⽬的!

维度可以类比大模型的参数,参数越大,语义复杂度就越强

🦋 嵌⼊模型应⽤场景

根据嵌⼊的特性,由此延伸出了许多嵌⼊模型在AI应⽤的使⽤场景:

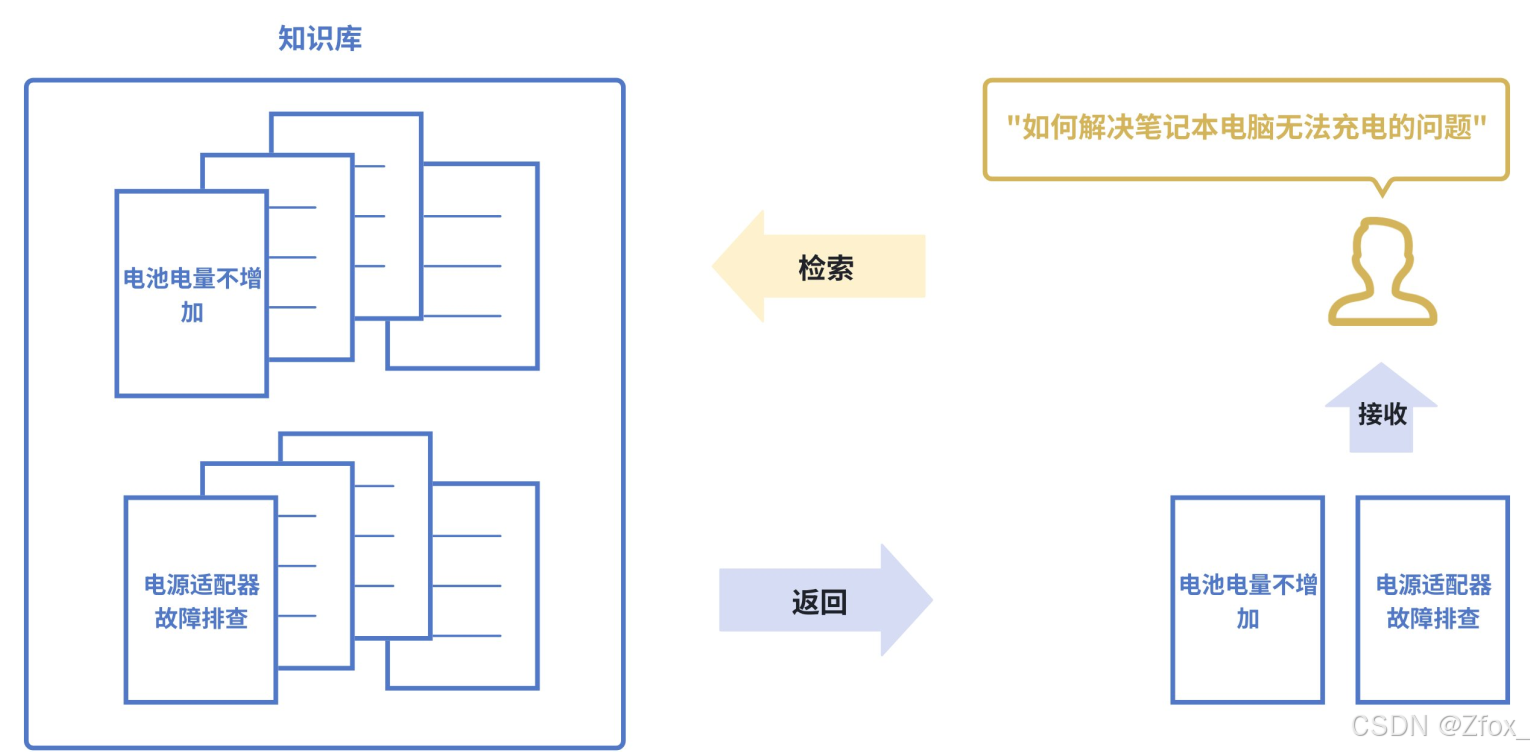

- 语义搜索(SemanticSearch)

传统搜索:依赖关键词匹配(搜 “苹果” ,只能找到包含 “苹果” 这个词的⽂档)。

语义搜索:则能将查询和⽂档都转换为向量,通过计算向量间的相似度来找到相关内容,即使⽂档中没有查询的确切词汇也能被检索到。如下图所⽰,即使知识库中并未直接出现 “笔记本电脑⽆法充电” 这个词组,语义搜索也能通过向量相似度精准地找到该⽂档。

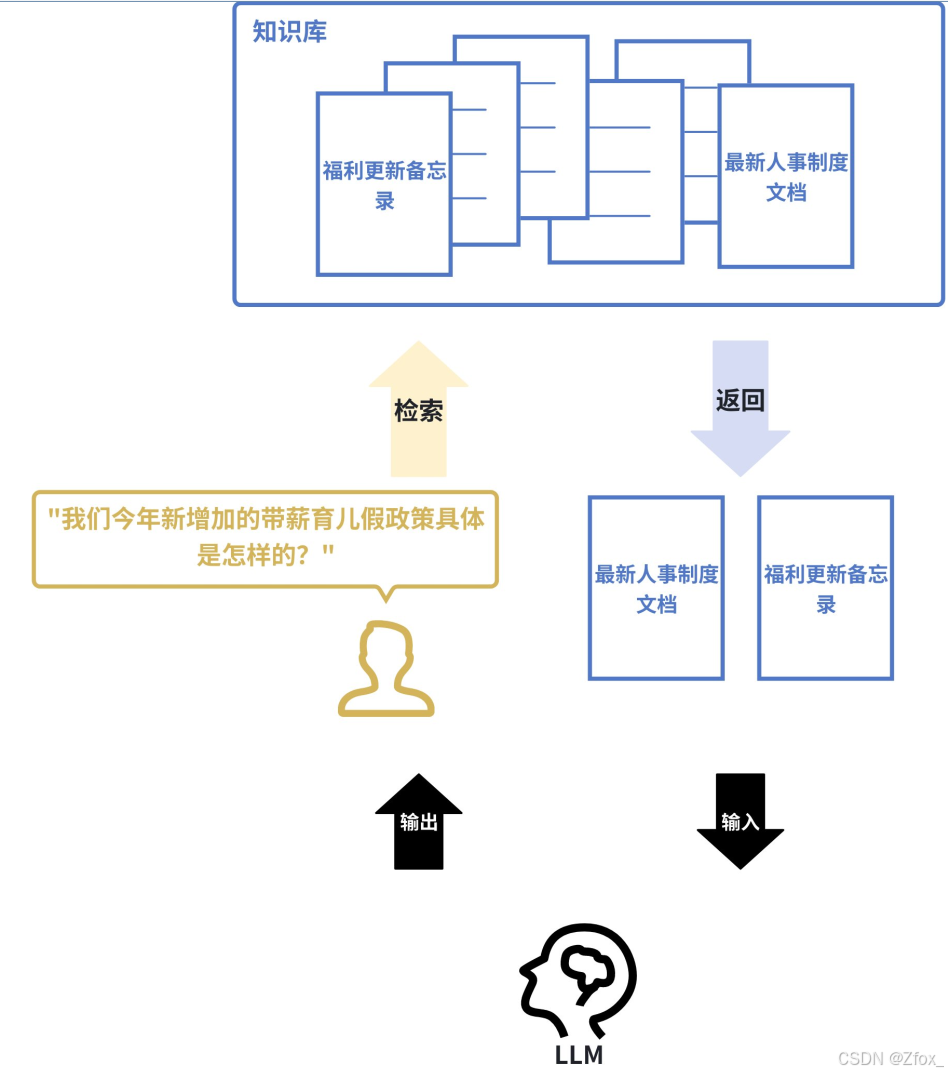

- 检索增强⽣成(Retrieval-AugmentedGeneration,RAG)

这是当前⼤语⾔模型应⽤的核⼼模式。当⽤⼾向LLM提问时,系统⾸先使⽤嵌⼊模型在知识库(如公司内部⽂档)中进⾏语义搜索,找到最相关的内容,然后将这些内容和问题⼀起交给LLM来⽣成答案。这极⼤地提⾼了答案的准确性和时效性。

例如:⼀家公司的内部客服机器⼈接到员⼯提问: “我们今年新增加的带薪育⼉假政策具体是怎样的?” 系统会⾸先使⽤嵌⼊模型在公司的最新⼈事制度⽂档、福利更新备忘录等资料中进⾏语义搜索,找到关于“今年育⼉假规定”的具体条款,然后将这些【条款】和【问题】⼀起提交给LLM,LLM便能⽣成⼀个准确、具体的摘要回答,⽽⾮仅凭其内部训练数据可能产⽣的过时或泛泛的答案。

- 推荐系统(RecommendationSystems)

将⽤⼾(根据其历史⾏为、偏好)和物品(商品、电影、新闻)都转换为向量。喜欢相似物品的⽤⼾,其向量会接近;相似的物品,其向量也会接近。通过计算⽤⼾和物品向量的相似度,就可以进⾏精准推荐。

例如:⼀个流媒体平台将⽤⼾A(喜欢观看《盗梦空间》和《⿊镜》)和所有电影都表⽰为向量。系统发现⽤⼾A的向量与那些也喜欢《盗梦空间》和《⿊镜》的⽤⼾向量很接近,⽽这些⽤⼾普遍还喜欢《星际穿越》。尽管⽤⼾A从未看过《星际穿越》,但通过计算⽤⼾向量与电影向量的相似度,系统会将这部电影推荐给⽤⼾A。

- 异常检测(AnomalyDetection)

正常数据的向量通常会聚集在⼀起。如果⼀个新数据的向量远离⼤多数向量的聚集区,它就可能是⼀个异常点(如垃圾邮件、欺诈交易)。

例如:⼀个信⽤卡交易反欺诈系统,通过学习海量正常交易记录(如⾦额、地点、时间、商⼾类型等特征的向量)形成了“正常交易”的向量聚集区。当⼀笔新的交易发⽣时,系统将其转换为向量。如果该向量出现在“正常聚集区”之外(例如,⼀笔发⽣在通常消费地之外的⾼额交易),系统则会将其标记为潜在的欺诈交易并进⾏警报。

🦋 主流的嵌⼊模型

- text-embedding-3-large(OpenAI):OpenAI最强⼤的英语和⾮英语任务嵌⼊模型。默认维度3072,可降维如1024维;输⼊令牌⻓度⽀持为8192

- Qwen3-Embedding-8B(阿⾥巴巴):开源模型,⽀持100+种语⾔;上下⽂⻓度32k;嵌⼊维度最⾼4096,⽀持⽤⼾定义的输出维度,范围从32到4096。推理需要⼀定的GPU计算资源(例如,⾄少需要16GB以上显存的GPU才能⾼效运⾏)。

- gemini-embedding-001(Google):⽀持100+种语⾔;默认维度3072,可选降维版本:1536维或768维;输⼊令牌⻓度⽀持为2048

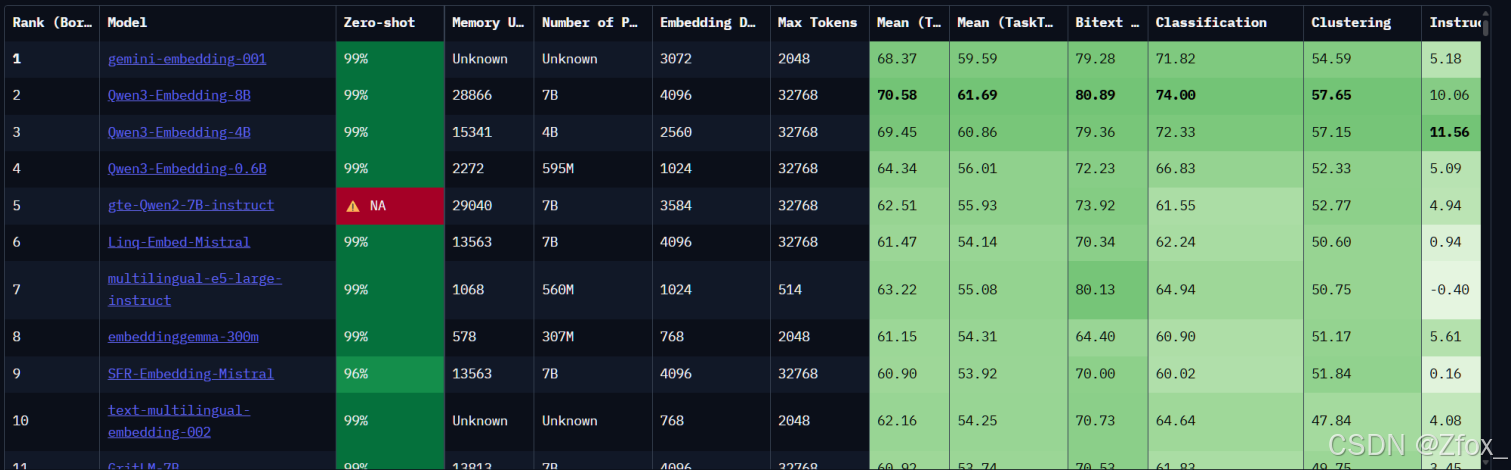

其他参考:

- Huggingface的MTEB评测:https://huggingface.co/spaces/mteb/leaderboard

Huggingface的MTEB(MassiveMultilingualTextEmbeddingBenchmark)评测,是业界⽐较公认的标准

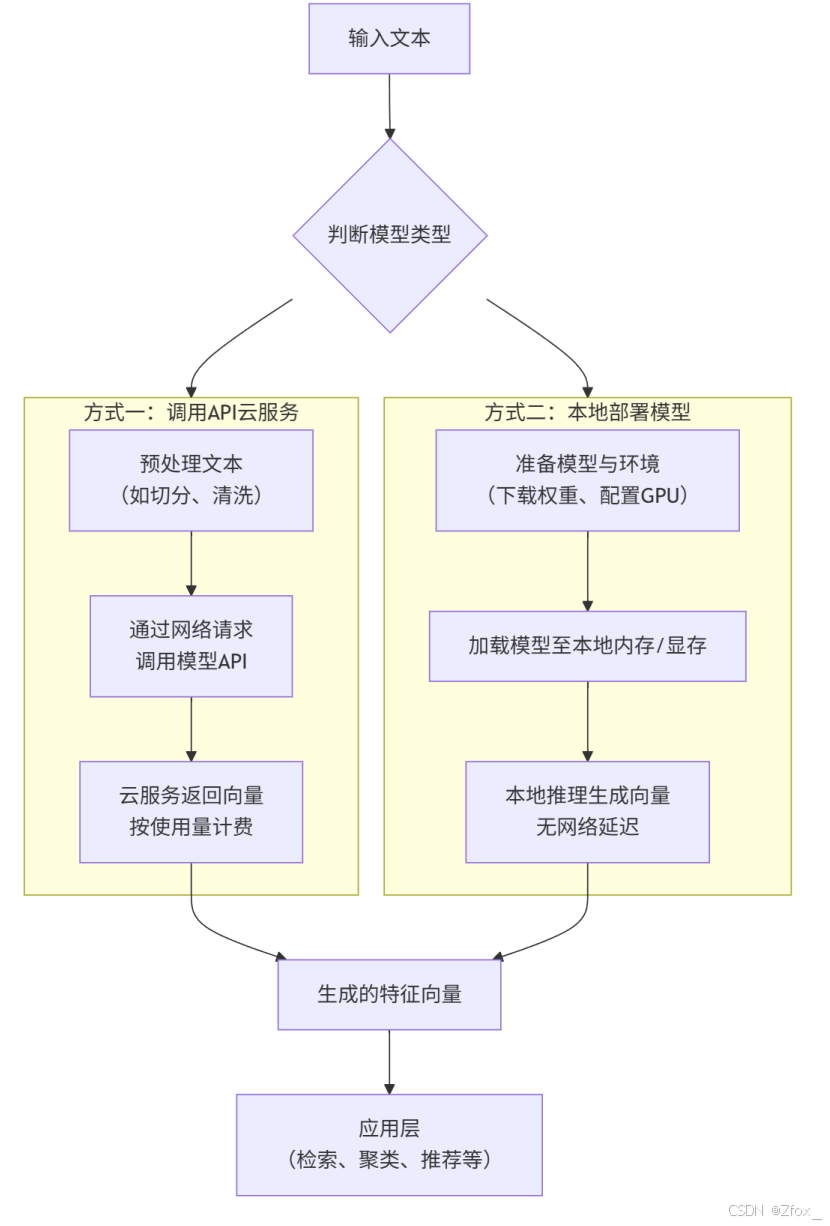

🦋 嵌⼊模型接⼊⽅式

嵌⼊模型接⼊和使⽤⽅式根据模型类型(开源或闭源)有根本性的不同。下图清晰地展⽰了两种典型的接⼊流程:

🎀 API接⼊(闭源)

这是最快速、最简单的⽅式,⽆需管理任何基础设施。只需要向模型提供商的服务端发送⼀个HTTP请求即可。

适⽤模型: text-embedding-3-large , gemini-embedding-001 等。

通⽤步骤:

- 注册账号并获取 APIKey:在对应的云服务平台(如OpenAIPlatform,GoogleAIStudio/VertexAI)上注册账号,获取⽤于⾝份验证的 APIKey。

- 安装SDK或构造HTTP 请求:使⽤官⽅提供的 SDK(如 openai , google-generativeai )或直接构造 HTTP 请求。

- 调⽤API并处理响应:发送⽂本,接收返回的 JSON 格式的向量数据。

⽰例1:发起HTTP请求

curl https://api.openai.com/v1/embeddings

-H "Content-Type: application/json"

-H "Authorization: Bearer $OPENAI_API_KEY"

-d '{

"input": "Your text string goes here",

"model": "text-embedding-3-small"

}'

响应包含嵌⼊向量(浮点数列表)以及⼀些其他元数据:

{

"object": "list",

"data": [

{

"object": "embedding",

"index": 0,

"embedding": [

-0.006929283495992422,

-0.005336422007530928,

-4.547132266452536e-05,

-0.024047505110502243

],

}

],

"model": "text-embedding-3-small",

"usage": {

"prompt_tokens": 5,

"total_tokens": 5

}

}

⽰例2:接⼊SDK

安装库:

pip install openai

⽰例代码:

# 使⽤ OpenAI Python SDK

from openai import OpenAI

import os

# 1. 设置 API Key

client = OpenAI(api_key="your-api-key")

# 2. 准备输⼊⽂本

text = "这是⼀段需要转换为向量的⽂本。"

# 3. 调⽤ API

response = client.embeddings.create(

model="text-embedding-3-large", # 指定模型

input=text,

dimensions=1024 # 可选:指定输出维度,例如从3072降维到1024

)

#4. 获取向量

embedding = response.data[0].embedding

print(f"向量维度:{len(embedding)}")

print(embedding)

🎀 本地部署(开源)

这种⽅式需要⾃⾏准备计算资源(通常是带有GPU的机器)来运⾏模型,适合对数据隐私、成本和控制权有更⾼要求的场景。

适⽤模型: Qwen3-Embedding-8B 等。

通⽤步骤:

- 环境准备:准备⼀台有⾜够GPU显存的服务器(对于Qwen3-Embedding-8B,需要⾄少16GB以上显存)。

- 模型下载:从HuggingFace等模型仓库下载模型权重⽂件和配置⽂件。

- 代码集成:使⽤像 transformers 这样的库来加载模型并进⾏推理。

这部分有兴趣的可以下来⾃⾏研究。对于⼤多数初创项⽬或原型验证,从API⽅式开始是最佳选择。当应⽤规模化或⾯临严格的数据合规要求时,再考虑迁移到本地部署开源模型。

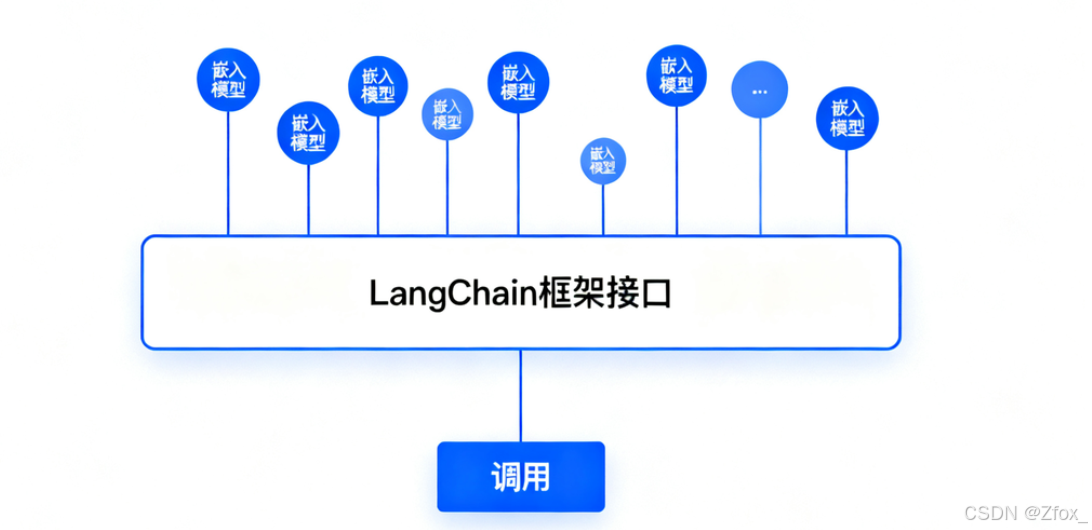

在实际应⽤中,直接调⽤嵌⼊模型获取结果,与直接调⽤原⽣LLM存在相似的问题:⽆论是通过API还是本地部署获得向量,下⼀步通常都是将它们存⼊向量数据库(如Chroma,Milvus,Pinecone等)以供后续检索。 为了便于切换不同的嵌⼊模型,很多项⽬会使⽤像LangChain这样的框架,它们提供了统⼀的嵌⼊模型接⼝。

四:🔥 模型平台(⾃⾏研究)

🦋 HuggingFace(国外)

HuggingFace是⼀个知名的开源库和平台,该平台以其强⼤的Transformer模型库和易⽤的API⽽闻名,为开发者和研究⼈员提供了丰富的预训练模型、⼯具和资源。对于从事AI研究的⼈来说,其重要性不亚于GitHub。

🦋 魔搭社区(国内)

魔搭(ModelScope)是由阿⾥巴巴达摩院推出的开源模型即服务(MaaS)共享平台,汇聚了计算机视觉、⾃然语⾔处理、语⾳等多领域的数千个预训练AI模型。其核⼼理念是"开源、开放、共创",通过提供丰富的⼯具链和社区⽣态,降低AI开发⻔槛,尤其为企业本地私有化部署提供了⼀条⾼效路径。

官⽹:https://www.modelscope.cn/(界⾯和HuggingFace设计的基本⼀样)

五:🔥 共勉

😋 以上就是我对 大模型介绍 的理解, 觉得这篇博客对你有帮助的,可以点赞收藏关注支持一波~ 😉

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)