四、混合云算力调度:本地集群与公有云(阿里云)弹性扩展的无缝协同与资源统一管理

摘要: 本文探讨大模型算力建设中混合云架构的优化方案,解决传统“本地+云”模式的管理割裂、数据协同难、调度低效等问题。通过构建统一管理平面(Kubernetes联邦)、安全数据链路(专线+分层访问)、一致运行环境(容器镜像同步),实现本地与云资源的无缝协同。智能调度策略结合自动/手动触发机制、任务分层优先级和成本管控(预算限制、计费优化),提升资源利用率与响应效率。实践表明,该方案可将运维效率提升

🌈 大家好,我是没事学AI, 欢迎加入文章下方的QQ群互动学习。

🚀 记得【关注】【点赞】【收藏】,你的鼓励是我更新的最大动力。

目录

在大模型算力建设中,“按需弹性”是核心诉求之一——企业既需要本地集群保障核心数据安全与训练稳定性,又需要公有云应对算力峰值(如大促前需求预测、年度数据复盘),避免本地资源闲置浪费。但传统“本地+云”架构常面临“管理割裂、数据孤岛、调度低效”的问题,难以形成协同效应。本文将拆解混合云算力调度方案,详解本地与云集群的统一管理、数据协同、智能调度逻辑,为大模型场景提供“安全可控+弹性高效”的算力支撑。

一、混合云算力调度的核心痛点与需求

企业在落地“本地+云”算力架构时,往往会遇到三类典型问题,这些痛点直接制约了混合云的价值发挥:

- 管理割裂:本地集群用Kubernetes管理,公有云用云厂商原生控制台管理,两套系统独立运维——运维人员需切换平台查看资源状态(如本地GPU利用率、云节点运行状态),且无法统一调度任务,某企业曾因管理割裂导致云资源闲置3天未发现,额外产生数万元成本。

- 数据协同难:大模型训练需依赖TB级本地数据(如设备日志、生产记录),若将数据全量迁移至云端,不仅耗时久(10TB数据通过公网传输需数天),还存在数据泄露风险;若仅在本地训练,又无法利用云算力,陷入“数据不敢动、算力用不上”的僵局。

- 调度不智能:多数企业采用“人工判断+手动扩容”的方式——当本地算力不足时,运维人员手动在云厂商控制台创建节点、部署环境、提交任务,整个流程需2-4小时,无法应对突发算力需求(如临时增加的模型微调任务),且易出现“扩容不及时”或“缩容不及时”的成本浪费。

此外,大模型场景对混合云还提出特殊需求:一是环境一致性(本地与云节点的操作系统、驱动版本、容器环境需完全一致,否则模型训练易报错);二是低延迟数据访问(即使数据不迁移,云节点也需快速读取本地数据);三是成本可控(避免云资源“无限扩容”导致成本失控)。

二、混合云架构设计:本地集群与公有云的无缝协同基础

要实现混合云算力调度,需先搭建“统一管理、数据互通、环境一致”的基础架构,解决“割裂”与“协同”问题,核心分为三部分:统一管理平面、安全数据链路、一致运行环境。

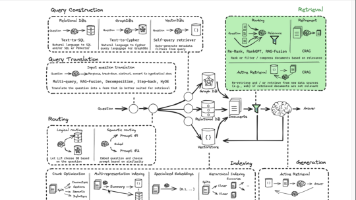

2.1 统一管理平面:Kubernetes联邦(Kubernetes Federation)

通过Kubernetes联邦将本地集群与公有云集群纳入同一管理体系,实现“一套平台管所有资源”:

- 架构组成:

- 联邦控制平面:部署在本地核心节点,包含联邦API Server、联邦Controller Manager,负责接收全局任务请求、管理子集群(本地集群+云集群)状态;

- 子集群注册:将本地Kubernetes集群(如16节点GPU集群)与公有云Kubernetes集群(如阿里云ACK集群)作为“子集群”注册到联邦控制平面,注册时需配置集群凭证(通过密钥加密存储)、资源类型(如GPU节点、CPU节点)、地理区域;

- 全局资源视图:在联邦控制平面搭建可视化 dashboard,实时展示所有子集群的资源状态(如本地集群GPU利用率75%、云集群GPU利用率30%)、任务分布(如10个训练任务在本地、3个在云端),支持按业务部门、任务类型筛选查看。

- 核心能力:

- 跨集群任务调度:用户提交任务时无需指定子集群,联邦控制平面自动根据资源状态分配任务(如本地资源充足时优先调度到本地,不足时调度到云端);

- 统一资源配额:为不同业务部门设置全局资源配额(如生产部门可使用80%本地GPU+50%云GPU,研发部门可使用20%本地GPU+30%云GPU),避免某部门独占资源;

- 跨集群服务发现:若模型服务需跨集群部署(如本地部署核心服务、云端部署非核心服务),联邦控制平面可实现跨集群服务注册与发现,业务系统无需感知服务所在集群。

某企业采用该架构后,运维人员从“管理两套系统”变为“管理一套系统”,运维效率提升60%,任务调度响应时间从小时级缩短至分钟级。

2.2 安全数据链路:专线+数据分层访问

为解决“数据不敢动、云节点读数慢”的问题,设计“专线传输+数据分层访问”方案,保障数据安全与访问效率:

- 专线连接:与公有云厂商(如阿里云)签订专线服务(如阿里云专线),带宽配置10Gbps-100Gbps,直接连接企业本地数据中心与云厂商区域节点,替代公网传输:

- 传输效率:1TB数据通过专线传输仅需15-20分钟(公网需数小时),满足云节点读取本地数据的时效性需求;

- 数据安全:专线传输不经过公网,配合IPsec加密协议,避免数据在传输过程中被窃取或篡改,满足行业合规要求(如制造业数据安全标准)。

- 数据分层访问:

- 核心数据本地化:将敏感数据(如设备核心参数、用户隐私信息)存储在本地分布式存储(如Ceph容量池),云节点通过专线直接读取,不进行数据迁移;

- 非核心数据云端化:将非敏感数据(如公开数据集、模型训练日志)同步至云厂商对象存储(如阿里云OSS),云节点可直接读取,减少本地存储压力;

- 缓存加速:在云集群部署分布式缓存(如Redis),缓存云节点频繁访问的本地数据(如某训练任务的样本数据),缓存命中率达80%以上,进一步降低数据访问延迟。

某制造业企业采用该方案后,云节点读取本地1TB训练数据的时间从2小时缩短至20分钟,且未发生任何数据安全事件,兼顾了效率与安全。

2.3 一致运行环境:容器镜像与配置统一

大模型训练对环境一致性要求极高(如CUDA版本、PyTorch版本、依赖库版本),若本地与云节点环境不一致,易出现“本地训练正常、云端训练报错”的问题。解决方案是“统一容器镜像+统一配置管理”:

- 统一容器镜像仓库:

- 在本地搭建私有镜像仓库(如Harbor),存储大模型训练与推理所需的容器镜像,镜像中预装固定版本的操作系统(如Ubuntu 20.04)、CUDA(如11.8)、PyTorch(如2.0.1)、依赖库(如DeepSpeed 0.9.5);

- 将私有镜像仓库通过专线同步至云厂商镜像仓库(如阿里云ACR),确保本地与云端使用完全相同的镜像,避免“镜像版本差异”导致的兼容问题;

- 镜像标签管理:为镜像添加清晰标签(如“train:torch2.0.1-cuda11.8-deepspeed0.9.5”),用户提交任务时指定标签,联邦控制平面自动拉取对应镜像。

- 统一配置管理:

- 采用Kubernetes ConfigMap与Secret管理任务配置:将训练参数(如batch size、学习率)存储在ConfigMap,敏感信息(如API密钥、存储凭证)存储在Secret;

- 配置全局同步:在联邦控制平面创建“全局ConfigMap/Secret”,自动同步到所有子集群(本地+云端),确保任务在不同集群使用相同配置,无需重复创建。

某企业通过该方案,解决了“环境不一致”导致的90%以上的训练报错问题,任务跨集群迁移成功率从60%提升至100%。

三、智能调度策略:实现“本地优先、云端弹性、成本最优”

基础架构搭建完成后,需通过智能调度策略最大化混合云价值——让算力“该用则用、该省则省”,核心策略分为“触发机制”“调度逻辑”“成本控制”三部分。

3.1 调度触发机制:自动+手动双模式

根据算力需求的紧急程度与可预测性,设计两种调度触发方式:

- 自动触发:基于资源负载与时间规则自动触发扩缩容,无需人工干预:

- 资源负载触发:联邦控制平面实时采集本地集群资源利用率(每30秒刷新一次),设置阈值:

- 扩容阈值:当本地GPU利用率连续5分钟≥85%,且任务排队数量≥5个时,自动向云集群发起扩容请求,按“每次增加5-10个GPU节点”的步长扩容;

- 缩容阈值:当本地GPU利用率连续10分钟≤40%,且云集群GPU节点空闲时间≥1小时时,自动向云集群发起缩容请求,优先释放最早创建的云节点;

- 时间规则触发:基于历史数据(如过去3个月的算力需求曲线),设置定时调度规则:

- 例1:每月最后一周是“模型月度迭代期”,提前24小时自动扩容10个云GPU节点,迭代结束后自动缩容;

- 例2:每天凌晨2点-6点是本地算力低谷期,自动将云集群空闲节点释放,降低夜间成本。

- 资源负载触发:联邦控制平面实时采集本地集群资源利用率(每30秒刷新一次),设置阈值:

- 手动触发:支持运维人员或业务用户通过管理平台手动触发调度,应对突发或特殊需求:

- 紧急扩容:当出现临时大算力需求(如生产故障需紧急训练故障诊断模型),用户可手动指定扩容数量(如“扩容20个云GPU节点”),调度系统10分钟内完成节点创建与环境部署;

- 强制缩容:当云资源成本超出预算时,管理员可手动触发“强制缩容”,优先保留核心任务所在的云节点,非核心任务迁移至本地(若本地有资源)或暂停。

某企业采用“自动为主、手动为辅”的触发机制后,算力需求响应时间从2小时缩短至10分钟,云资源闲置率从25%降至8%。

3.2 任务调度逻辑:分层优先+资源适配

联邦控制平面在分配任务时,需遵循“分层优先、资源适配”的逻辑,确保核心任务稳定、非核心任务高效:

- 任务分层优先:将任务按优先级从高到低分为5级(生产核心>生产常规>客服>研发>探索),调度时:

- 高优先级任务(如生产核心任务):优先调度到本地集群(资源充足时),本地资源不足时调度到云集群的“高性能节点”(如阿里云g100实例,配备H100 GPU);

- 低优先级任务(如研发探索任务):仅在本地资源空闲时调度到本地,否则调度到云集群的“成本优化节点”(如阿里云抢占式实例,成本比按量付费低40%-60%);

- 资源适配调度:根据任务的资源需求(如GPU显存、CPU核数、内存大小),匹配最合适的集群节点:

- 大显存需求任务(如万亿参数模型训练,需80GB+显存):优先调度到本地DGX A100节点或云集群H100节点,避免因显存不足导致任务失败;

- 高CPU需求任务(如数据预处理,需多线程并行):优先调度到本地CPU集群或云集群CPU密集型节点,不占用宝贵的GPU资源;

- 低延迟需求任务(如实时推理服务):优先调度到本地集群(离业务系统近,网络延迟低),非实时任务可调度到云端。

某企业通过该调度逻辑,核心任务的资源满足率从85%提升至100%,GPU资源浪费率从15%降至5%,任务完成效率提升30%。

3.3 成本控制策略:从“无序扩容”到“精准管控”

混合云场景下,成本失控是企业最大顾虑之一,需通过“预算管控、计费优化、成本分析”三重策略控制成本:

- 预算管控:

- 全局预算设置:在联邦控制平面为每个业务部门、每个月设置云资源预算上限(如生产部门每月云成本不超过10万元,研发部门不超过5万元),实时监控预算使用进度;

- 超预算预警与限制:当某部门云成本达到预算的80%时,触发预警(短信+邮件通知);达到100%时,自动禁止该部门新增云资源,仅允许使用已创建的节点;

- 计费优化:

- 优先使用云厂商折扣方案:如阿里云的“预留实例”(长期使用场景,成本比按量付费低30%)、“抢占式实例”(非核心任务,成本低40%-60%),调度系统自动根据任务类型选择计费方式;

- 错峰调度:将非紧急任务(如数据预处理、模型归档)调度到云厂商“闲时折扣时段”(如部分厂商凌晨时段有额外折扣),进一步降低成本;

- 成本分析:

- 成本归因:自动统计每个任务、每个部门、每个业务场景的云资源成本(如“设备故障诊断模型训练”消耗云成本2万元,“研发探索任务”消耗1.5万元),生成成本报表;

- 优化建议:基于成本数据,为企业提供优化建议(如“某研发任务长期占用云GPU但利用率仅30%,建议迁移至本地空闲节点”),某企业通过该功能,每月云成本降低25%。

四、实践效果:安全、高效、低成本的混合云算力支撑

某企业采用上述混合云算力调度方案后,实现了显著的业务价值提升:

- 效率提升:

- 算力需求响应时间:从2小时缩短至10分钟,突发任务处理能力提升12倍;

- 任务完成周期:100亿参数模型训练周期从14天缩短至8天,效率提升43%;

- 资源利用率:本地GPU利用率从55%提升至75%,云GPU利用率从60%提升至85%;

- 成本优化:

- 云资源成本:每月平均成本降低25%,避免了“无序扩容”导致的浪费;

- 运维成本:运维人员工作量减少60%,无需同时管理多套系统;

- 安全保障:

- 数据安全:核心数据未迁移至云端,通过专线+加密保障访问安全,未发生数据泄露;

- 任务稳定性:跨集群任务迁移成功率100%,环境一致性问题导致的报错率降至0.5%以下。

五、总结与落地建议

混合云算力调度的核心价值是“取长补短”——用本地集群保障安全与稳定,用公有云实现弹性与高效,通过统一管理、智能调度、成本控制解决“割裂”与“浪费”问题。企业在落地时需注意三点:

- 安全优先:核心数据尽量本地化,数据传输需用专线+加密,避免因“追求效率”忽视数据安全;

- 循序渐进:先实现“统一管理+自动调度”基础功能,再逐步引入“成本优化+智能预测”高级功能,降低落地难度;

- 数据驱动:定期分析混合云算力使用数据(如资源利用率、成本占比、任务效率),持续优化调度策略,让算力“越用越高效”。

通过这套混合云方案,企业可在“安全可控”的前提下,充分利用公有云的弹性算力,避免本地资源闲置与算力不足的矛盾,为大模型的持续迭代提供“按需分配、成本最优”的算力支撑。

更多推荐

已为社区贡献31条内容

已为社区贡献31条内容

所有评论(0)