MLLM 在电商域互动内容生产的实践

在内容互动业务应用中,内容数据形式多样,下游应用通常需要结合多种模态输入,以满足不同的业务需求。MLLM 已经在多个理解和生成任务上表现出显著优势,我们亟需将其和内容互动业务结合,提升各方面效果。任务拆解作为大模型训练的重要一环,我们专注于文本和多模态数据,构建一套自动化的高质量数据优化方案。通过提升数据的一致性、对齐性与效率,我们实现了显著的增益。基于优化后的数据,我们致力于提升模型的性能与训练

在内容互动业务应用中,内容数据形式多样,下游应用通常需要结合多种模态输入,以满足不同的业务需求。MLLM 已经在多个理解和生成任务上表现出显著优势,我们亟需将其和内容互动业务结合,提升各方面效果。

任务拆解

数据目标: 作为大模型训练的重要一环,我们专注于文本和多模态数据,构建一套自动化的高质量数据优化方案。通过提升数据的一致性、对齐性与效率,我们实现了显著的增益。

模型目标:基于优化后的数据,我们致力于提升模型的性能与训练效率,包括两个方面:

-

多模态结合:通过有效融合文本、视频和音频等多种模态,增强模型对信息的综合理解能力。使其能够应对多种模态的输入,进行正确输出。

-

人类偏好对齐:通过分析和学习用户的行为和偏好,调整模型的输出以更好地满足人类的期望。这包括在生成内容时,考虑用户的个性化需求和期望,确保模型的决策过程与人类的意图高度一致。

解决方案

▐ 1. 融合人类反馈的多模态 reward 模型

-

任务背景

多模态语料库的数据量非常大,并且包含大量噪声。如果直接将这些未经处理的数据用于模型训练,存在两个问题:

-

噪声数据的存在会干扰模型的学习过程,使得模型偏离关注点,无法准确捕捉数据特征。

-

庞大的数据量将增加计算资源的消耗和训练时间,造成资源极大的浪费。

因此,在进行多模态训练之前,应当首先进行数据清洗和过滤,以提高数据的质量,从而提升模型的整体表现和训练效率。

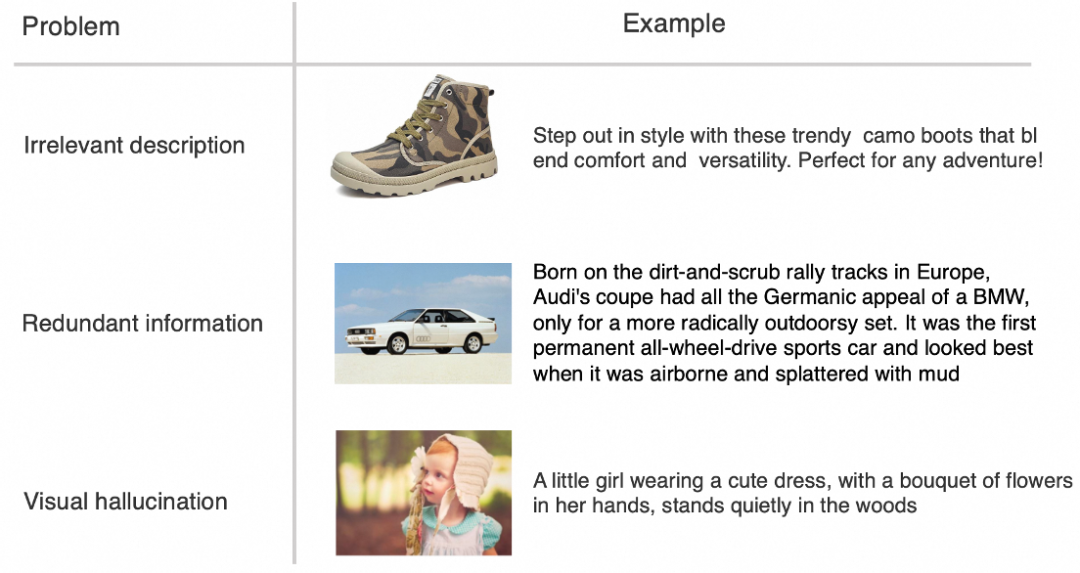

噪声样本分类

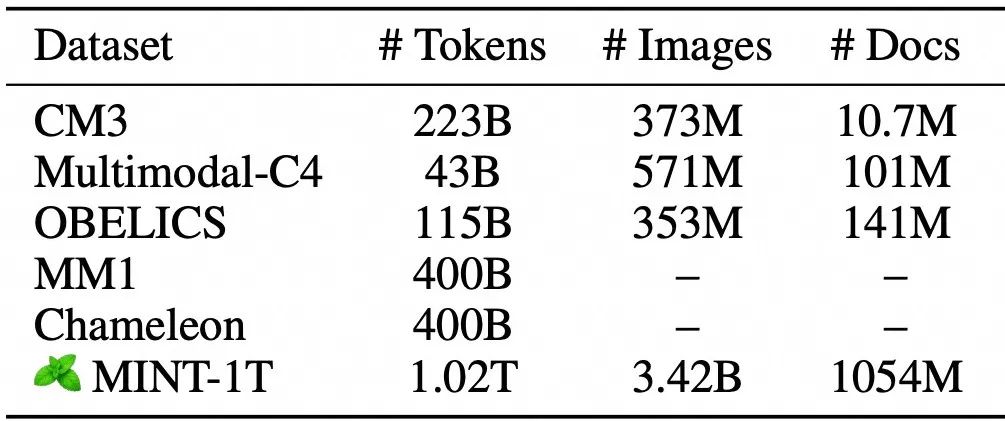

多模态数据量

-

解决路径

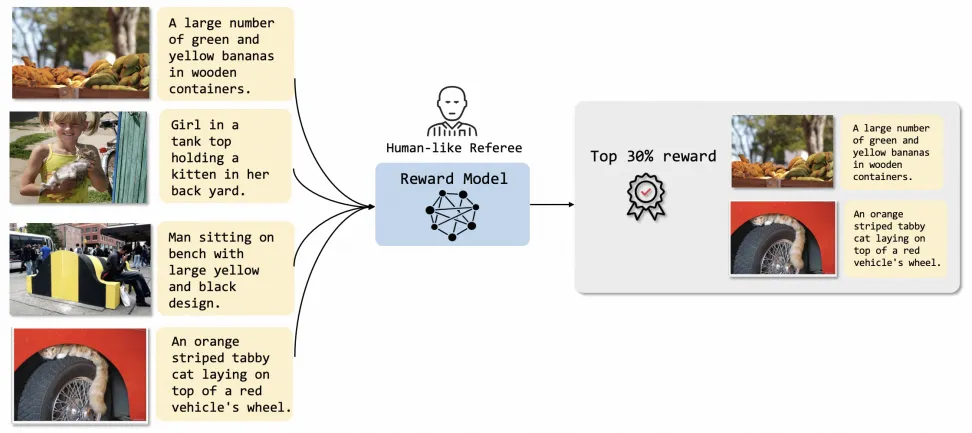

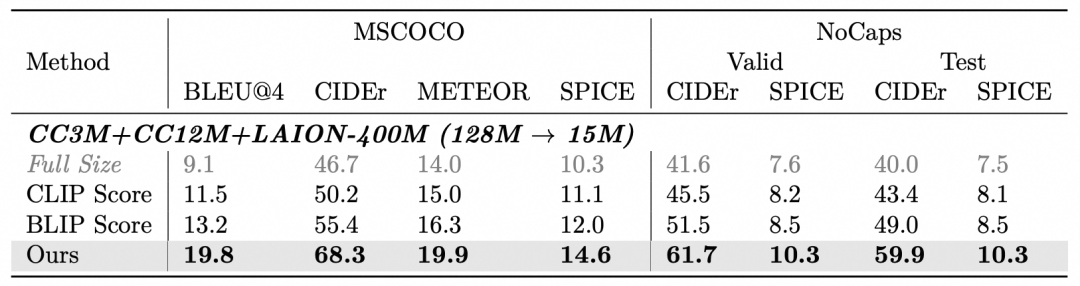

现有方案依赖于 CLIP Score 和 BLIP Score 之类的指标,这些指标来自于预训练的模型。然而,这些模型往往是在未经精细筛选的、噪声较大的数据集上训练的,这可能会在筛选过的数据集中延续错误和不匹配的问题。我们提出了一种新的算法,创新性地引入人类知识过滤高质量图文对齐数据,构建了一个多模态 reward 模型。

-

算法设计

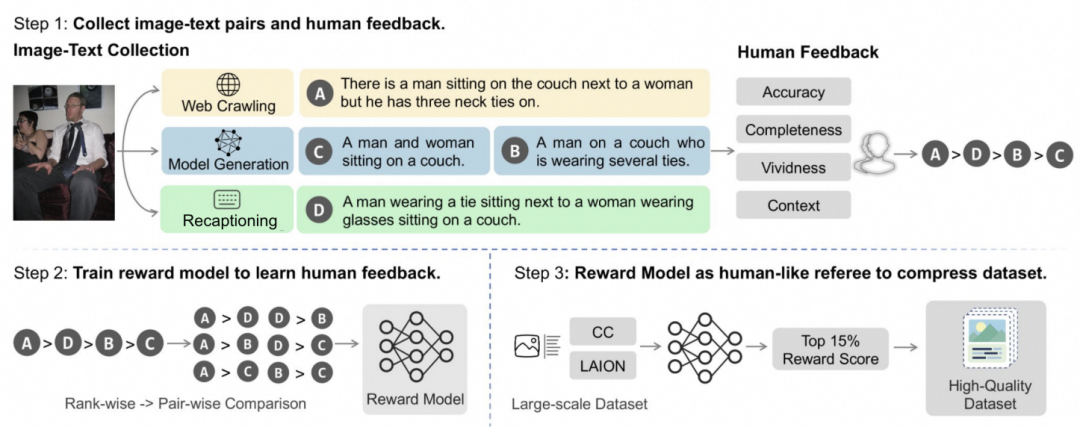

Overview: 整体大图

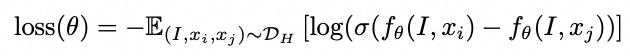

Step1. 偏好数据标注

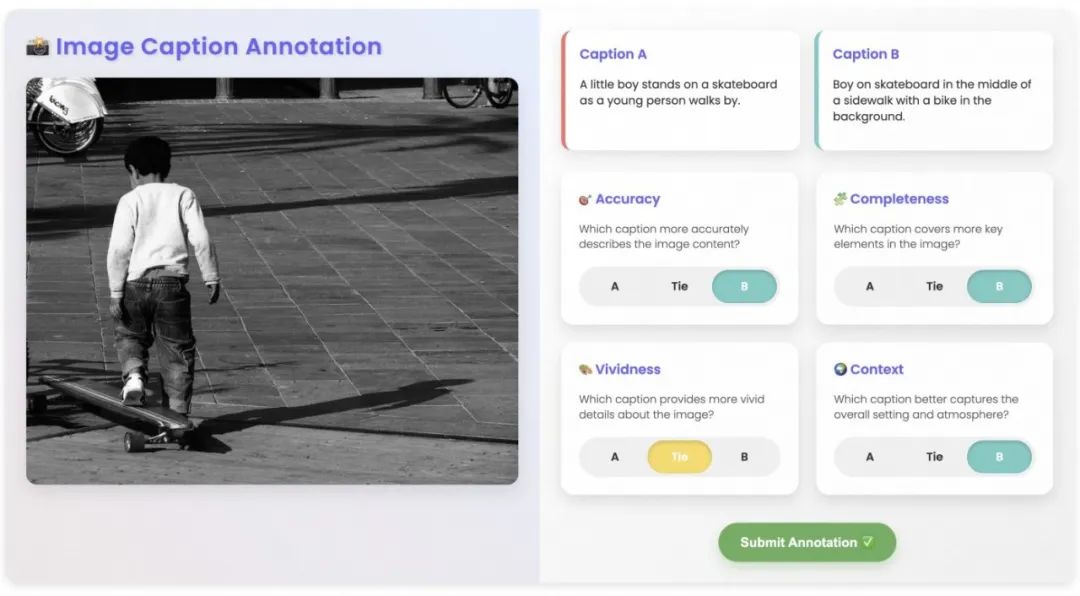

我们从四个维度:准确度、完整度、细节度、背景感,描述图像和文本的对齐性,得到人类打标的多模态偏好数据 HF-dataset。具体地,针对每个图像,我们会

-

通过模型生成、人工标注等多个方式,生成不同粒度的 caption

-

培训打标人员,对四个维度打分,得到每个维度的准确得分

Step2. Reward Model 训练

受到 InstructGPT 的启发,我们训练了一个奖励模型,以学习 HF-dataset 数据集中的人类标注知识。该模型作为一种自动化的标注工具,旨在帮助对齐图像与文本之间的对应关系。具体地,我们将偏好标注转化为排名,并将奖励模型的训练形式化为一个成对排名问题。

-

对于 HF-dataset 数据集中的每个图像 I,我们有 m 个由人类标注者排名的文本描述,表示为 x1,x2,…,xm。如果 xi 比 xj ,我们将其组织成一个比较对 (I,xi,xj)。对于每个图像生成 多个比较对。

-

我们遵循 Bradley-Terry 模型来定义成对损失函数,优化模型拉远正负比较样本,表达式为:

基于此优化函数,我们将得到一个细粒度理解人类打标员偏好的 reward model。

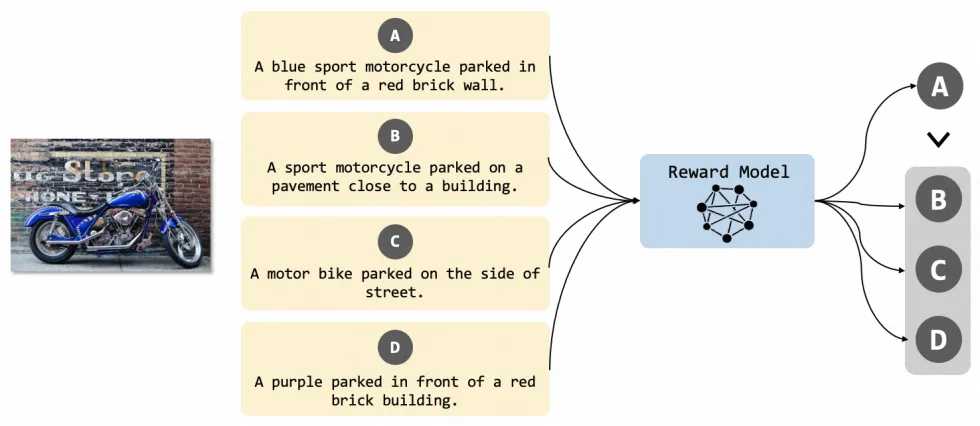

Step3. 高质量数据清洗

-

算法收益

-

Reward Model 清洗的数据质量更好,相比全量数据训练,清洗的高质量数据下游任务有很大提升;Reward Model 效果也优于 OpenAI CLIP 等知名开源模型

-

技术报告:Filter & Align: Leveraging Human Knowledge to Curate Image-Text Data

▐ 2. 音视频多模态的联合预训练

-

任务背景

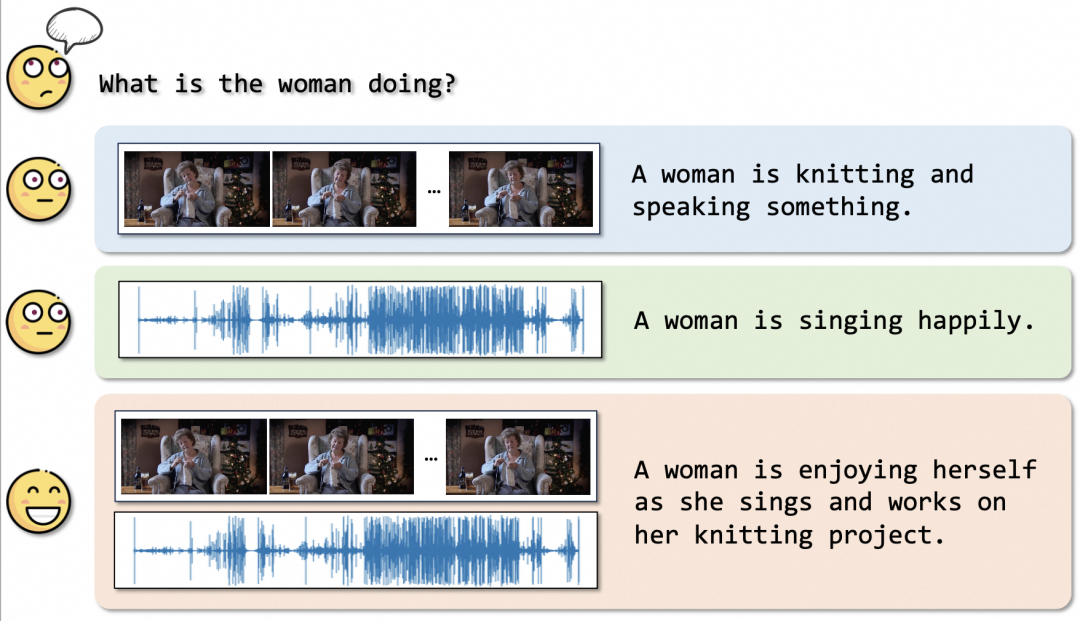

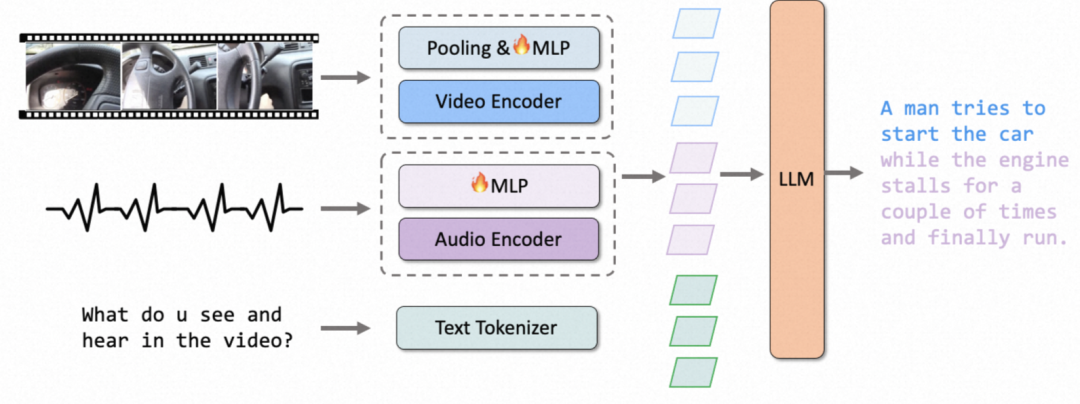

视频本质上是多模态的,包含了听觉和视觉信息。这种多模态性不仅是视频的固有特征,也是人类感知和与视觉媒体互动的基本方面。例如,在电影的上下文中,同时接触视觉信息和听觉线索显著丰富了观影体验,提高了理解力和享受度。受到这种内在的人类体验的启发,赋能多模态模型同时理解视觉和音频的能力,可以在视频理解上带来了显著的提升。

结合音视频理解的典型 case

-

解决路径

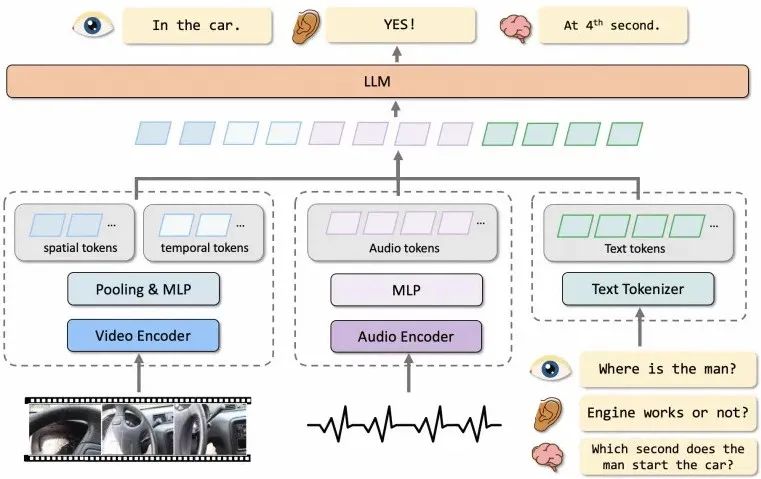

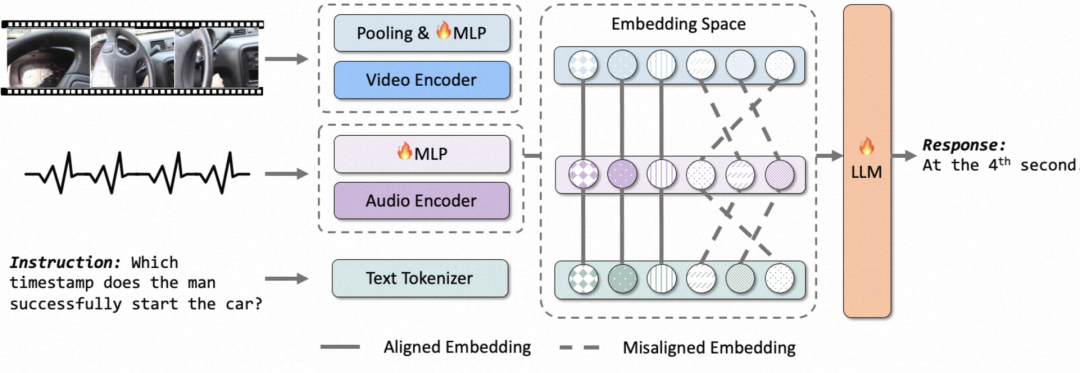

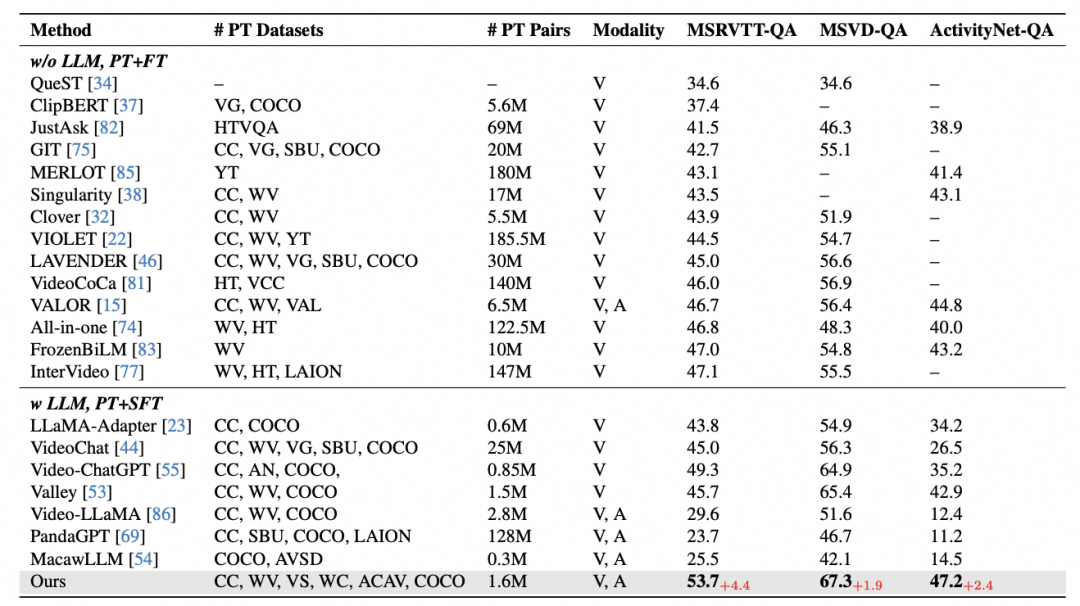

我们提出了一个音视频 MLLM 架构,协同对齐视觉和音频信号,以实现充分的视频理解,包括两个关键点,我们提出一种模态增强方法。促进视频中视觉和音频信号的充分对齐。同时我们提出一个高质量音视频指令数据生成方案,自动化将视觉 / 音频 - 文本对构造为包括多轮对话和复杂推理的细致指令数据。

-

算法设计

Overview:整体大图

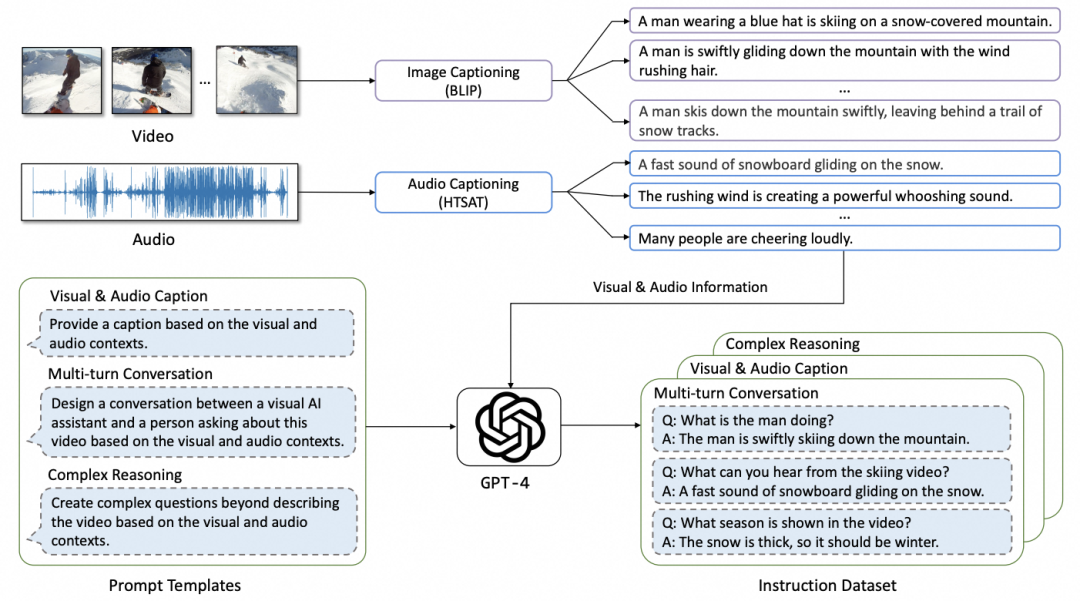

Step1. 指令数据构造

当前,音频和视频信息融合领域的指令数据尚显不足。为解决这一问题,我们利用开源模型,针对视频帧和音频信号生成密集的字幕(caption)。基于这些字幕,我们结合 GPT-4,生成音视频对齐的问答对(QA 对),其中包括多轮对话、复杂推理和视频描述等内容。

Step2. 音视频模态对齐

基于第一部分的多模态 reward 模型,对生成的数据进行筛选,得到高相关性的百万级视频和图文评论数据,用于通用音视频的模态对齐

Step3. 指令跟随强化

使用音视频指令数据和偏好数据,一阶段 SFT 提升指令跟随能力,二阶段 RLHF 对齐用户偏好

-

算法收益

-

所提出的方案在视频 QA: MSR-VTT-QA R1@60.4,ActivityNet-QA R1@50.6, 音视频 QA: MUSIC-AVQA R1@47.9, 超过 Video-LLaMA 和 Video-LLaVA,达到 SOTA。

-

技术报告:Audio-Visual LLM for Video Understanding

▐ 3. 多模态专家模型的细粒度蒸馏

-

任务背景

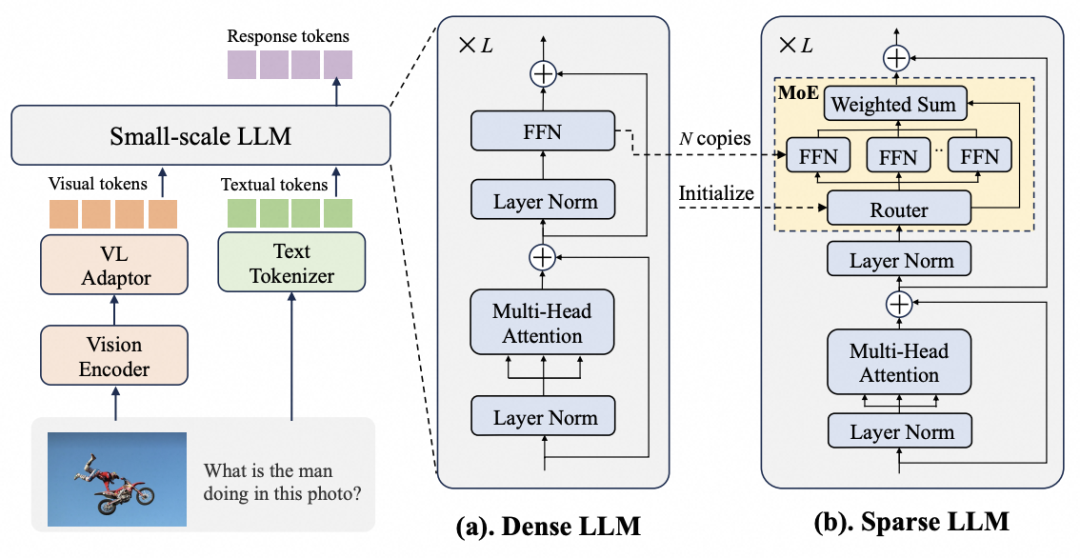

随着业务的精细化运营需求,要求模型能够针对不同内容,精准控制风格、字数等关键要素,这要求模型具备强大的多维度、细粒度理解和生成能力。此外,MLLM 的推理成本相比传统小模型显著增大,如何在大流量场景下平衡性能和效果,也是一个亟需解决的问题。

-

解决路径

我们的解决方案是,结合多专家机制 (MOE),让每个专家负责不同的关键要素,同时结合知识蒸馏技术,以先模仿再超越的范式,将大模型的能力迁移到 MOE 小模型中,提升 MOE 小模型的复杂理解和幻觉消除能力。

-

算法设计

Overview: 整体大图

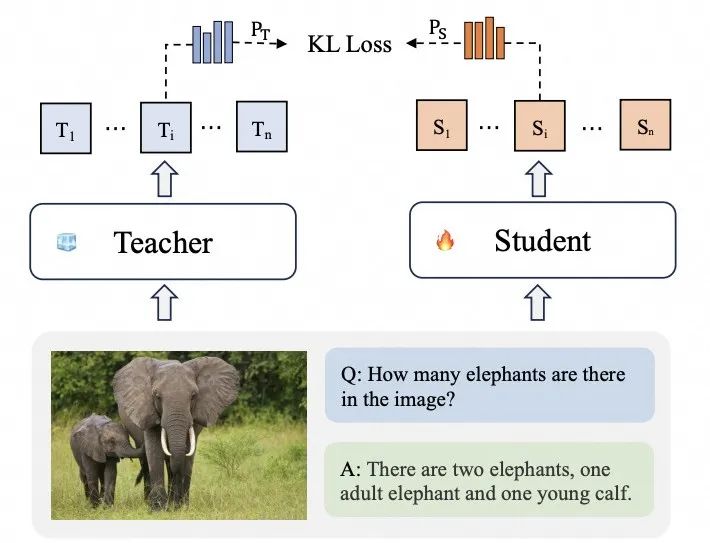

Step1. 模仿蒸馏

模仿蒸馏阶段, MOE 小模型先学会大模型里的复杂知识,这里面包含两个阶段:通用知识和复杂知识,我们提出 general-to-specialized,引导 MOE 小模型逐渐学习。

模仿蒸馏

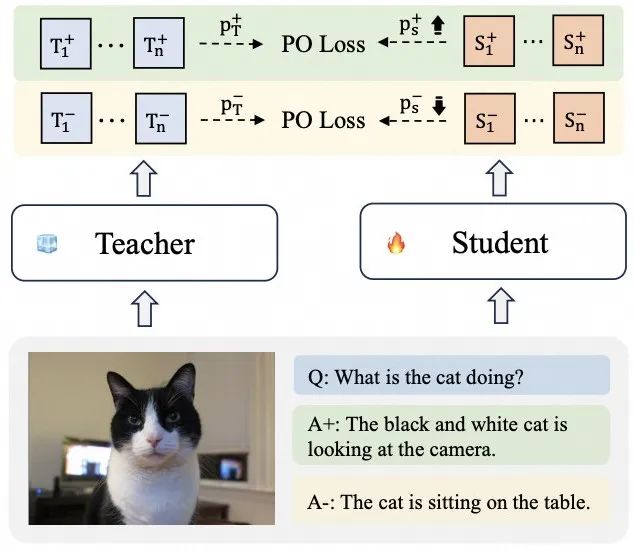

Step2. 偏好蒸馏

MOE 小模型存在很严重的幻觉认知,我们以大模型提供的关于何为 “好” 样本和 “坏” 样本的知识,为 MOE 小模型建立了基础参考,提升其判断能力,使其在减少幻觉方面的能力大大提升。

-

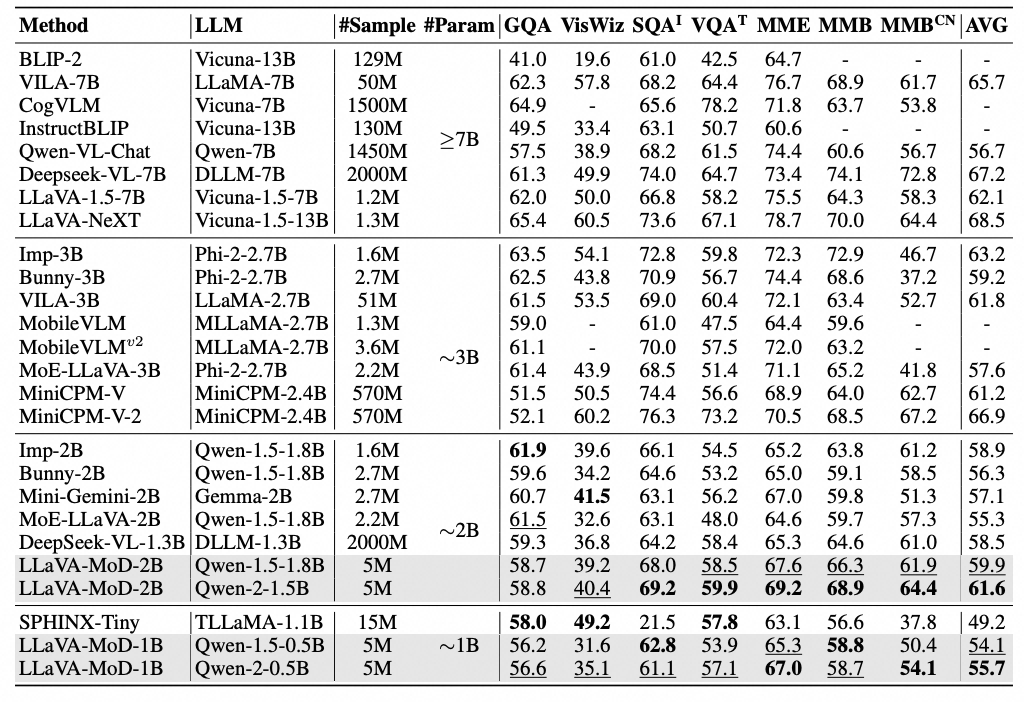

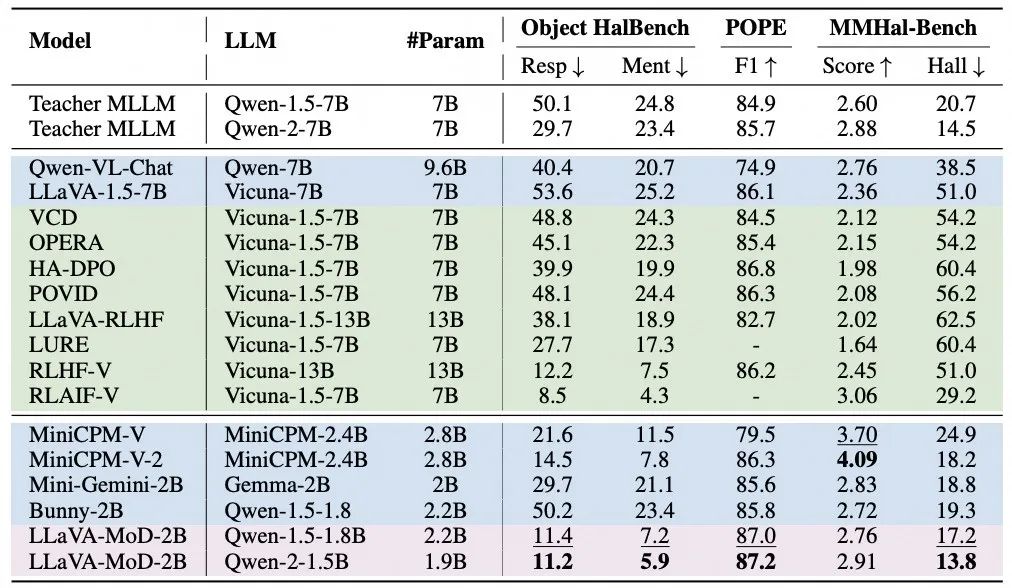

算法收益

-

提出的 MOE 小模型,在复杂理解能力和幻觉消除能力上,都表现优秀。相比同尺寸小模型 MiniCPM-V,DeepSeeK-VL,我们的方案只使用了 1% 不到的数据,性能相比有优势。

复杂理解能力

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)