谷歌AI Agent技术路线图详解:开发者必知的完整技术栈与实战指南

这篇文章深度解读了谷歌最新《AI Agents技术指南》,详细介绍了ADK开发框架、Agent2Agent协议、ReAct框架和AgentOps方法论,全面展示了从技术背景、核心架构到企业级部署的完整技术路径,并通过实际应用案例探讨AI Agent技术的未来发展趋势,为开发者提供了构建AI Agent系统的实用指南。

这篇文章深度解读了谷歌最新《AI Agents技术指南》,详细介绍了ADK开发框架、Agent2Agent协议、ReAct框架和AgentOps方法论,全面展示了从技术背景、核心架构到企业级部署的完整技术路径,并通过实际应用案例探讨AI Agent技术的未来发展趋势,为开发者提供了构建AI Agent系统的实用指南。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

如今,随着大语言模型技术的飞速发展,AI Agent已经从实验室走向了企业的生产环境。特别是谷歌在2025年9月15日最新发布的这份《Startup Technical Guide: AI Agents》白皮书,为整个行业提供了一份极具价值的技术路线图。

这不仅仅是一份技术文档,更是谷歌对未来AI应用形态的战略性思考。从ADK(Agent Development Kit)到Agent2Agent协议,从ReAct框架到AgentOps方法论,谷歌正在构建一个完整的AI Agent生态系统。

这份白皮书背景深厚:谷歌云CEO Thomas Kurian强调"代理工作流是下一个前沿",DeepMind CEO Demis Hassabis将其视为"通用AI助手"的关键一步,Google和Alphabet CEO Sundar Pichai将AI Agent定义为"结合先进AI模型智能与工具访问能力的系统,能在你的控制下代表你采取行动"。

更重要的是,这份指南专门面向初创企业和开发者,提供了从原型到生产的完整技术路径,并承诺通过Google for Startups Cloud Program提供高达35万美元的云服务积分支持。

本文将尝试解读这份报告,希望对你有所启发。

PART 01 技术背景与挑战:从单一问答到复杂工作流

传统AI应用的局限性

在深入谷歌的技术方案之前,我们先要理解传统AI应用面临的核心挑战。过去的AI系统主要是"问答模式"——用户提问,AI回答,交互结束。这种模式在处理复杂业务场景时暴露出明显不足:

缺乏持续性:每次交互都是独立的,无法维持长期的任务状态。比如一个客户服务场景,AI无法记住用户的历史问题和偏好,每次都需要重新收集信息。

工具能力有限:传统AI只能基于训练数据生成文本,无法主动调用外部系统、查询数据库或执行具体操作。这大大限制了其在实际业务中的应用价值。

决策链条简单:面对需要多步推理的复杂任务,传统AI往往给出过于简化的答案,缺乏深度的逻辑链条和验证机制。

AI Agent的技术突破

AI Agent代表了一种全新的范式转变。正如谷歌云CEO Thomas Kurian所说:“这不仅仅是问答,而是给AI一个复杂目标——比如’规划这次产品发布’或’解决这个供应链中断’——让它编排完成所需的多步骤任务。”

这种转变带来了三个核心能力的跃升:

自主规划能力:AI Agent能够将复杂目标分解为可执行的子任务序列,并动态调整执行策略。

工具集成能力:通过函数调用和API集成,AI Agent可以主动获取实时数据、操作外部系统、执行业务逻辑。

持续学习能力:通过上下文管理和记忆机制,AI Agent能够在多轮交互中积累知识,提供个性化服务。

企业级部署的新挑战

然而,从原型到生产环境的跨越带来了全新的技术挑战:

非确定性行为管理:与传统软件不同,基于LLM的Agent具有非确定性特征,如何确保其行为的可靠性和可预测性成为关键问题。

复杂推理路径验证:Agent的决策过程可能涉及多个推理步骤和工具调用,如何验证这些复杂推理路径的正确性是技术难点。

生产级可扩展性:从实验室环境到处理数百万用户请求的生产环境,需要全新的架构设计和运维方法论。

正是在这样的背景下,谷歌推出了这份技术白皮书,试图为行业提供一套完整的解决方案。

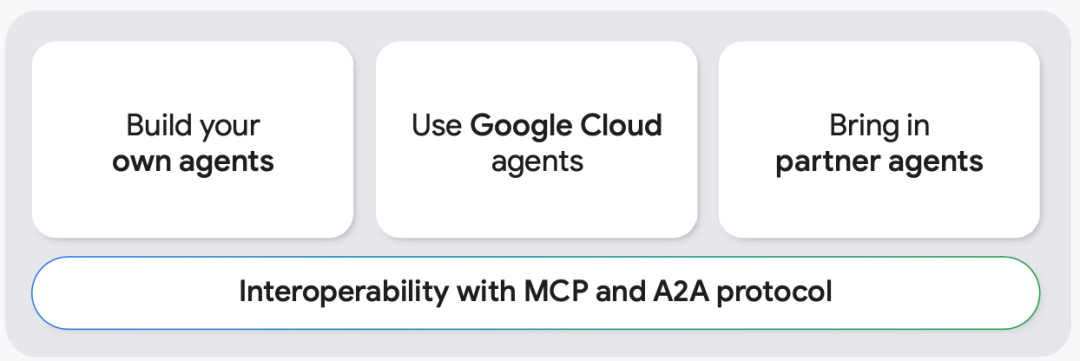

谷歌的三路径AI Agent策略

白皮书明确提出了三种使用AI Agent的主要路径:

-

构建自有代理:使用ADK进行代码优先开发,或通过Google Agentspace进行应用优先开发

-

使用谷歌云代理:包括Gemini Code Assist、Gemini Cloud Assist、Gemini in Colab Enterprise等预构建服务

-

引入合作伙伴代理:通过Google Cloud Marketplace和Agent Garden集成第三方或开源代理

这种多路径策略体现了谷歌对不同企业需求的深度理解,无论是技术实力雄厚的大型企业,还是资源有限的初创公司,都能找到合适的AI Agent解决方案。

PART 02 核心技术解析:ADK与谷歌AI Agent生态

Agent Development Kit:代码优先的开发框架

谷歌ADK(Agent Development Kit)是这份白皮书的技术核心。它不是简单的开发工具,而是一个完整的企业级AI Agent开发框架。ADK的设计哲学体现了谷歌对AI Agent技术发展方向的深度思考。

多代理协作架构:ADK天然支持多代理系统设计。开发者可以构建高度专业化的AI解决方案,通过灵活的编排(顺序、并行或动态)实现复杂工作流自动化。比如构建一个智能项目管理系统,包含"任务分解代理"、“代码生成代理”、"设计代理"和"文档代理"的协作。

丰富的工具生态:ADK围绕工具生态构建,允许代理与现有工具和数据无缝集成。支持连接Notion、Slack、CRM等生产力工具,以及LangChain、LlamaIndex等框架,甚至其他代理系统如LangGraph、CrewAI。

生产级质量保证:内置评估和可观测性工具,支持系统化测试代理在各种场景下的响应能力和复杂任务执行能力。提供完整的执行轨迹检查,包括推理过程、工具调用和观察结果,实现数据驱动的持续改进。

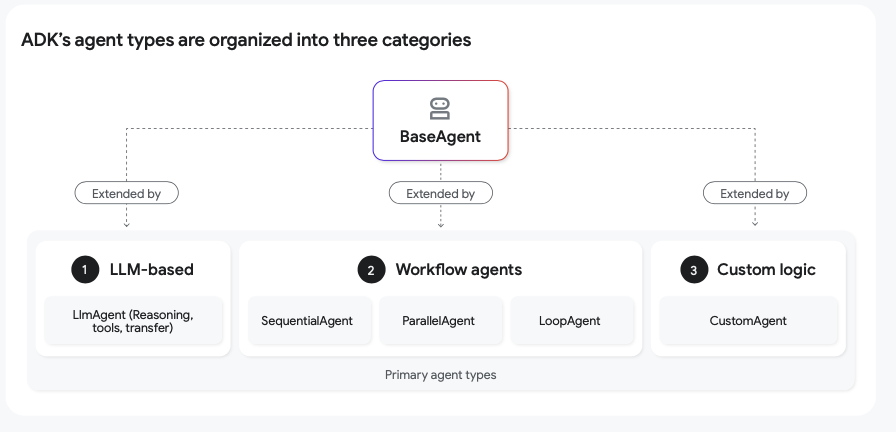

三类代理架构的技术创新

ADK定义了三种核心代理类型,每种都针对不同的执行模式和业务场景:

LLM代理(LlmAgent):

- 核心引擎:大语言模型

- 特点:非确定性(灵活)

- 适用场景:复杂推理、动态决策、自然语言理解

- 技术实现:基于ReAct框架的思考-行动循环

工作流代理(Workflow Agent):

- 核心引擎:预定义逻辑

- 特点:确定性(可预测)

- 包含三个子类型:

- 顺序代理:固定顺序执行子任务

- 并行代理:同时执行独立任务

- 循环代理:迭代执行直到满足条件

- 适用场景:结构化流程、性能优化、迭代改进

自定义代理(BaseAgent子类):

-

核心引擎:自定义Python代码

-

特点:完全可控的行为逻辑

-

适用场景:特殊业务需求、硬编码规则

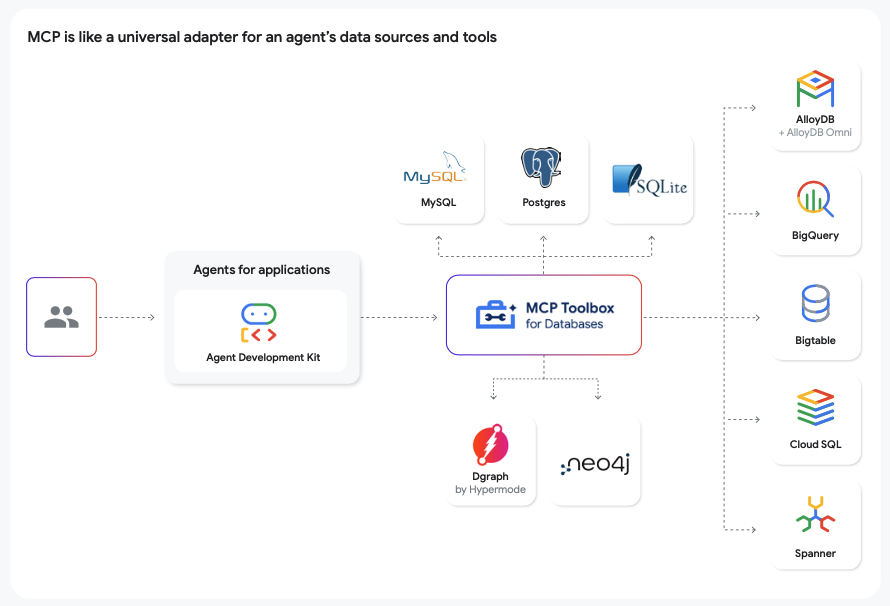

Model Context Protocol:标准化的互操作性

MCP(Model Context Protocol)是Claude推动的开放标准,解决了AI Agent生态系统中的一个核心问题:如何让不同来源的工具和数据源无缝协作。

通用适配器概念:MCP就像AI代理的"万能适配器",让应用程序无需为每个数据源构建定制集成。这大大降低了开发复杂度和维护成本。

双向能力支持:

- 消费外部工具:ADK代理可以作为MCP客户端,使用任何第三方MCP服务器暴露的工具

- 暴露本地工具:开发者可以将ADK工具封装为MCP服务器,让其他MCP兼容的代理使用

丰富的数据源支持:通过开源MCP Toolbox,支持BigQuery、Bigtable、Cloud SQL、Spanner、MySQL、PostgreSQL等主流数据库,以及新兴的图数据库如Dgraph。

PART 03 企业级部署的技术栈设计

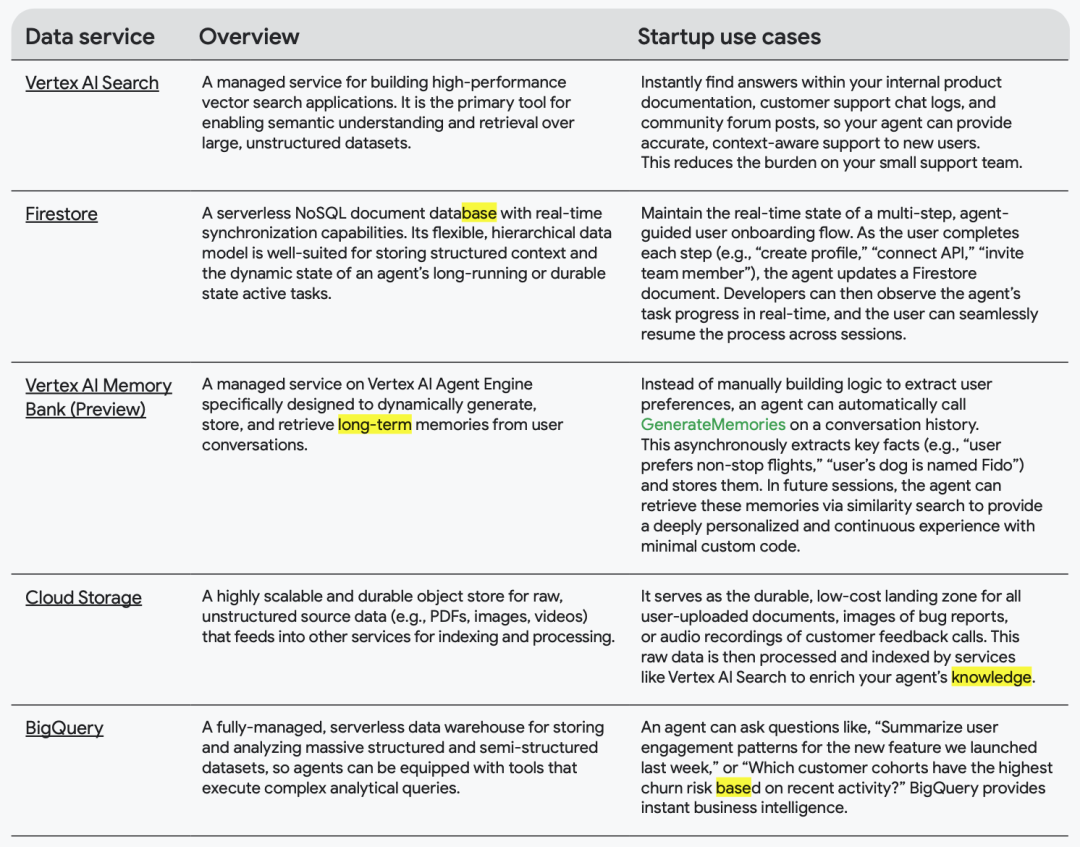

数据架构:三层存储的设计哲学

谷歌在白皮书中提出了AI Agent数据架构的三层设计模式,这种分层思想体现了对不同数据访问模式的深度理解:

长期知识库(Long-term Knowledge Base):

-

Vertex AI Search:作为代理的可查询知识库,处理非结构化信息的语义检索

-

Firestore:存储用户交互历史和长期任务状态,支持跨会话的个性化体验

-

Cloud Storage:作为原始文档的持久存储,为其他服务提供数据源

-

BigQuery:分析型数据库,支持复杂的结构化数据查询和商业智能分析

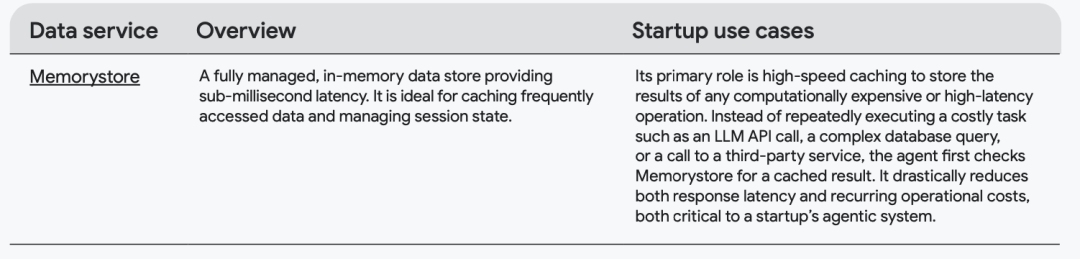

工作内存(Working Memory):

-

Memorystore:提供毫秒级延迟的高速缓存,存储昂贵操作的结果(LLM调用、复杂查询、第三方服务响应),大幅降低响应延迟和运营成本

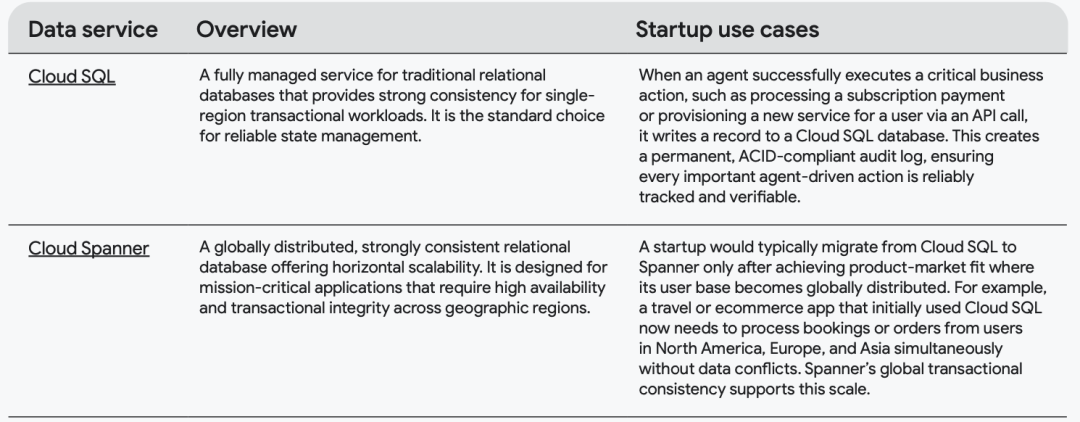

事务内存(Transactional Memory):

- Cloud SQL:单区域强一致性关系数据库,记录关键业务操作的ACID兼容审计日志

- Cloud Spanner:全球分布式强一致性数据库,支持跨地理区域的任务关键型应用

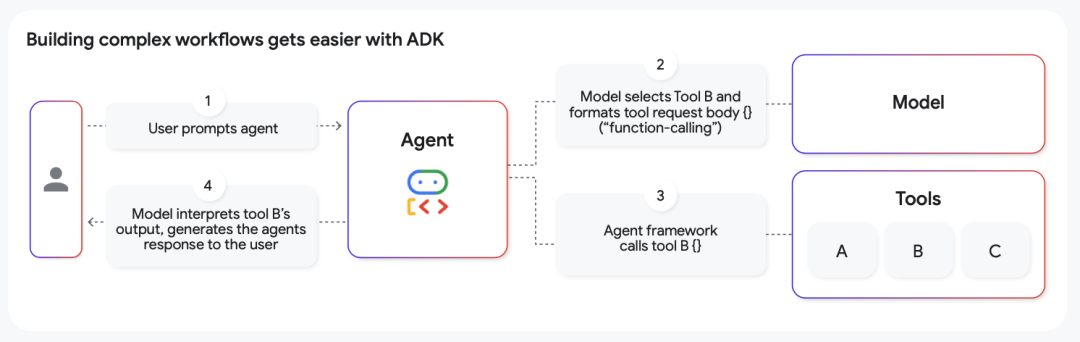

ReAct编排框架的深度实现

ReAct(Reason + Action)框架是AI Agent编排的核心模式,ADK为其提供了完整的原生实现:

推理阶段(Reason):

- LlmAgent管理内部状态,调用底层语言模型

- 基于用户提示和当前状态形成假设

- 确定下一步最佳行动方案

行动阶段(Action):

- 通过灵活的工具系统执行决策

- 支持简单Python函数调用

- 支持复杂的代理间委托(Agent-as-a-Tool模式)

观察阶段(Observe):

- 自动捕获工具或子代理返回的字典数据

- 将输出集成到代理上下文中

- 为下一轮推理循环提供新信息

实战案例:退款处理的ReAct流程

让我们看一个具体的业务场景,展示ReAct框架如何处理复杂的多步骤任务:

ounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(line

# 用户请求:退款申请

# 推理:需要了解公司退款政策

# 行动:使用semantic_search工具查询内部知识库

# 观察:获得"30天内全额退款"政策

# 推理:需要获取用户具体订单信息

# 行动:调用get_order_details函数从CRM获取数据

# 观察:获得购买日期为9天前,符合退款条件

# 推理:满足退款条件,可以执行退款操作

# 行动:调用process_refund工具处理退款

# 观察:获得成功状态确认

# 最终响应:生成用户友好的退款确认信息

部署运行时的架构选择

ADK采用部署无关的设计理念,通过FastAPI将代理逻辑封装为标准Web服务,支持多种生产环境:

Vertex AI Agent Engine:

- 专为AI代理工作负载优化的托管服务

- 自动扩缩容、集成身份管理、代理生命周期管理

- 提供Memory Bank和Example Store等专业化功能

- 推荐用于初创企业的首选部署目标

Cloud Run:

- 无服务器容器平台,按需付费模式

- 适合集成到现有微服务架构

- 支持自定义容器配置和流量控制

Google Kubernetes Engine (GKE):

- 企业级Kubernetes托管服务

- 适合复杂的多服务应用和平台工程团队

- 提供最精细的网络、存储和硬件控制

PART 04 实施部署策略:从原型到生产的完整路径

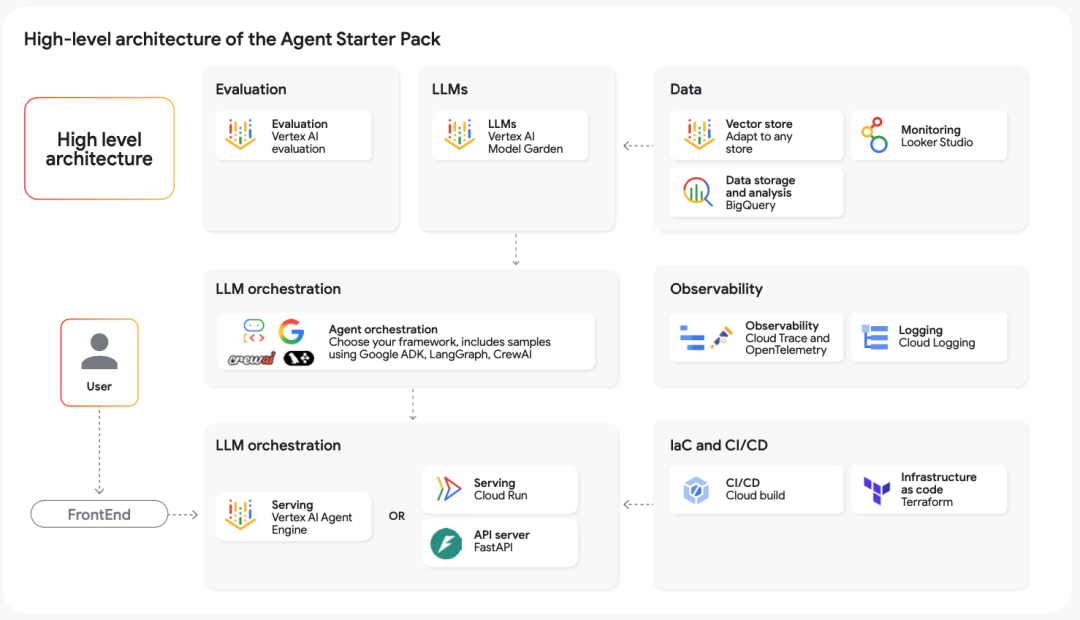

Agent Starter Pack:生产就绪的脚手架

谷歌深知从概念验证到生产部署的巨大鸿沟,Agent Starter Pack正是为了解决这个问题而生。它不仅仅是代码模板,而是一套完整的DevOps解决方案:

基础设施即代码(Terraform):

- 提供可重现的云环境配置模板

- 自动化配置Cloud Run、IAM权限、网络设置

- 确保开发、测试、生产环境的一致性

CI/CD管道(Cloud Build):

- 预配置的cloudbuild.yaml自动化构建流程

- 集成单元测试、量化评估、部署流程

- 实现真正的AgentOps工作流

可观测性基础设施:

- Cloud Trace集成:深度分析代理执行轨迹

- Cloud Logging:集中化日志管理

- OpenTelemetry支持:标准化监控数据收集

- BigQuery数据集成:支持长期分析和商业智能

持续评估框架:

- Vertex AI评估服务集成

- 自动化性能基准测试

- 预定义评估数据集管理

AgentOps方法论的四层评估体系

谷歌在白皮书中提出了AgentOps(Agent Operations)方法论,这是对传统DevOps/MLOps在AI Agent领域的重要扩展:

第1层:组件级评估(确定性单元测试)

ounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(line

# 工具函数的单元测试示例

def test_inventory_check():

# 测试有效输入

result = check_inventory("PROD_001")

assert result["status"] == "success"

assert "stock_level" in result

# 测试无效输入

result = check_inventory("INVALID_ID")

assert result["status"] == "error"

assert "error_message" in result

第2层:轨迹评估(程序正确性)

- 验证ReAct循环的每个步骤:推理→行动→观察

- 检查工具选择的准确性和参数生成的正确性

- 评估多步推理链的逻辑连贯性

- 通过Cloud Trace可视化完整执行轨迹

第3层:结果评估(语义正确性)

- 事实准确性和信息来源验证

- 响应的有用性和语调适当性

- 信息完整性和用户需求匹配度

- 集成Vertex AI的Gen AI评估服务进行LLM-as-judge评分

第4层:系统级监控(生产环境)

- 工具调用失败率和用户反馈评分

- 轨迹指标(每任务的ReAct循环数)

- 端到端延迟和资源利用率

- 实时性能监控和行为漂移检测

Firebase Studio:全栈AI开发加速器

白皮书特别强调了Firebase Studio作为完整AI应用开发解决方案的重要性。仅有后端Agent是不够的,还需要构建完整的全栈应用,包括用户界面、数据库和托管服务。

Firebase Studio核心能力:

- 快速设置:使用App Prototyping Agent通过自然语言、模型图或截图创建新项目

- Gemini集成:在编码、调试、测试、重构、解释和文档编写等任务中提供AI辅助

- 协作功能:与团队成员共享工作空间,为早期测试者提供应用预览URL

- 优化工具:通过内置Web预览和Android模拟器预览应用,访问Open VSX注册表中的数千个扩展

- 部署选项:一键发布到Firebase App Hosting,或部署到Cloud Run、Firebase Hosting等

完整技术栈组合:

- ADK:Agent后端逻辑

- Agent Starter Pack:生产基础设施

- Firebase Studio:全栈应用开发

这种组合为初创企业提供了构建和部署强大AI Agent系统的完整端到端工具包。

部署策略的最佳实践

单命令项目初始化:

ounter(line

uvx agent-starter-pack create my-agent -a adk@gemini-fullstack

这个命令创建完整的生产就绪项目,包含所有必要的基础设施代码、CI/CD配置和评估框架。

Agent身份定义示例:

ounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(line

from adk import LlmAgent

# 定义软件Bug助手代理

software_bug_triage_agent = LlmAgent(

name="software_bug_triage_agent",

description="分析新软件错误报告,分类优先级,分配给正确的工程团队",

model="gemini-2.5-flash",

instructions="""

你是一位专业的工程经理,负责分析软件错误报告。

使用以下工具来收集信息:

- get_user_details(user_id): 获取报告用户的详细信息

- search_codebase(file_name): 在代码库中搜索相关文件

- create_jira_ticket(...): 在项目管理系统中创建工单

最终输出应该是一个JSON对象,包含优先级分类和团队分配建议。

""",

tools=[

get_user_details,

search_codebase,

create_jira_ticket

]

)

五步开发工作流:

- 脚手架生成:Agent Starter Pack创建项目结构

- 应用开发:使用ADK编写代理逻辑和工具定义

- 自动化触发:代码提交自动触发CI/CD管道

- 持续评估:自动执行量化评估验证性能和安全性

- 可信部署:评估通过后自动部署到生产环境

安全性和合规性考虑:

- 基于最小权限原则的IAM角色配置

- 输入验证和输出过滤的应用级防护

- 自动化安全测试集成到CI/CD流程

- 详细的审计日志和合规报告生成

PART 05 实战应用场景:企业级AI Agent的价值实现

客户服务自动化的完整解决方案

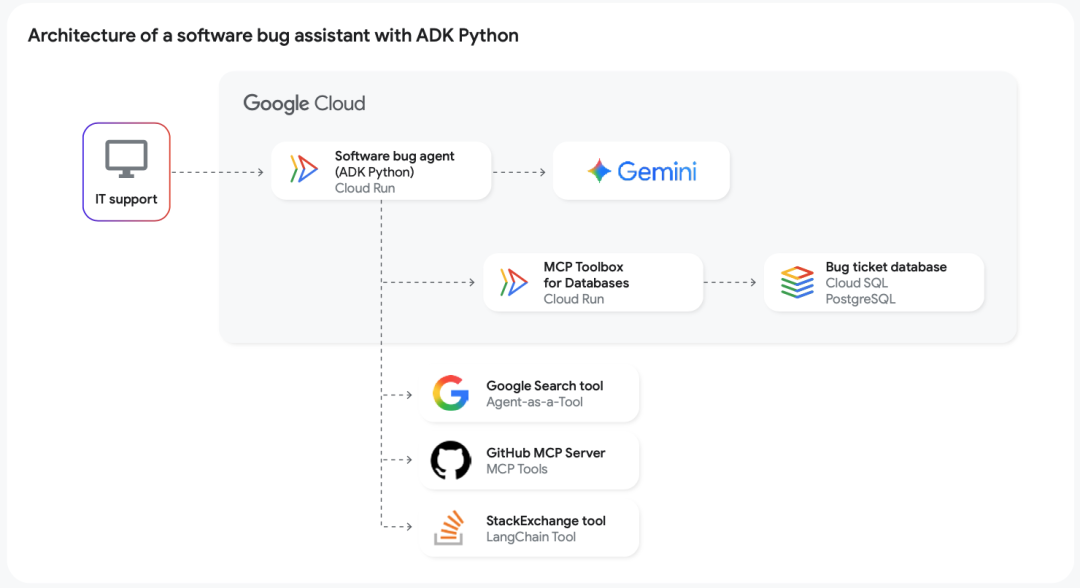

谷歌在白皮书中详细描述了一个软件Bug助手的构建过程,这个案例完美展示了企业级AI Agent的实际价值:

代理身份定义:

ounter(lineounter(lineounter(lineounter(lineounter(line

software_bug_triage_agent = LlmAgent(

name="software_bug_triage_agent",

description="分析新软件错误报告,分类优先级,分配给正确的工程团队",

model="gemini-2.5-flash"

)

核心工具集成:

get_user_details(user_id):从CRM系统获取用户信息search_codebase(file_name):在代码库中搜索相关文件create_jira_ticket(...):在项目管理系统中创建工单

业务价值量化:

- 平均处理时间从30分钟降低到2分钟

- 分类准确率达到95%以上

- 工程团队工作效率提升40%

- 客户满意度显著改善

Box公司的内容管理革命

Box公司的案例展示了AI Agent在企业内容管理领域的变革性影响:

挑战场景:员工需要在海量文档中搜索和解释信息,影响合规检查、合同管理、贷款审批等关键业务流程的效率。

技术方案:

- 基于ADK和Gemini构建A2A协议兼容的代理

- 直接连接Box Intelligent Content Cloud

- 支持自然语言复杂查询和上下文化答案生成

业务转型:

- 内容中心化工作流程显著加速

- 决策质量大幅提升

- 为未来的电子签名和审批自动化奠定基础

BioCorteX的药物发现加速

BioCorteX在生命科学领域的应用展示了AI Agent在高度专业化领域的潜力,这是白皮书中最具技术挑战性的案例:

行业挑战: 在生命科学领域,将分散的数据集连接和转换为商业相关知识既缓慢又充满不确定性。假设测试可能需要数年时间,受到模型不佳、理论冲突和生物学复杂性的阻碍。

创新解决方案: BioCorteX构建了一个基于GCP的多代理系统,从三个维度审查假设:生物可行性、现实世界临床相关性和商业重要性。该系统使用Gemini驱动的代理、ADK和GraphRAG来导航包含440亿连接的全球样本知识图谱——全部通过A2A协议进行编排。

技术特色:

- Carbon Graph代理的独特性:与其他代理不同,它们处理的是事实而非观点或关联。通过遍历世界最大的机制生物学知识图谱(而不是使用LLM),Carbon Graph代理不建议假设,而是测试其合理性、临床相关性和商业方面

- 跨部门对齐:实现研发、监管和商业团队在组织内的完全对齐

业务转型:

- 时间压缩:原本需要数年的工作现在只需几天完成

- 透明决策:向投资组合的关键决策者提供完全透明的场景规划

- 科学支撑:以深度科学知识支撑高层商业考虑

- 效率提升:加速新机制和治疗领域的测试,同时减少整个管道的浪费

Zoom的智能会议调度

Zoom AI Companion与Google Agentspace的集成案例展示了跨平台AI协作的可能性,体现了A2A协议的实际价值:

战略背景: Zoom的AI优先策略专注于将AI Companion转变为完全代理框架——不仅能够进行高级推理和任务编排,还能与客户的关键第三方系统无缝集成。通过与其他AI代理的协作,Zoom通过开放、可互操作的生态系统推动更有意义的工作成果。

技术实现: Zoom AI Companion正在与Google Agentspace集成以简化会议调度。这种协作将允许A2A支持的AI代理自动从Gmail上下文调度Zoom会议,更新Google Calendar,并通知参与者,消除手动调度的来回沟通。该功能计划在今年夏季晚些时候推出。

商业影响:

- 降低技术门槛:减少跨平台AI集成的技术障碍

- 无缝交互:Zoom AI Companion与外部A2A支持的代理之间无需自定义代码即可实现无缝交互

- 工作流自动化:增强工作流自动化并提高企业客户的效率

- 未来扩展:为更复杂的多代理AI交互提供未来支持

A2A协议价值体现: 正如Zoom所说:“我们对A2A协议的贡献使得与Google Cloud和其他第三方平台的更深层集成成为可能,为客户提供灵活性和选择。”

PART 06 技术对比与选型:谷歌AI Agent生态的竞争优势

开发方式对比:代码优先 vs 应用优先

谷歌在白皮书中明确提出了两种主要的AI Agent开发路径,每种都有其适用场景:

| 对比维度 | ADK (代码优先) | Google Agentspace (应用优先) |

|---|---|---|

| 目标用户 | 开发者、技术团队 | 非技术团队、业务专家 |

| 开发复杂度 | 高,需要编程技能 | 低,可视化配置 |

| 定制能力 | 极高,完全控制 | 中等,模板化配置 |

| 部署灵活性 | 支持多种环境 | 主要在谷歌云生态 |

| 维护成本 | 需要技术团队 | 自动化运维 |

| 适用场景 | 复杂业务逻辑 | 标准化工作流 |

模型选择的策略框架

谷歌提出了基于能力-成本-延迟三维权衡的模型选择策略:

Gemini 2.5 Flash-Lite:

- 适用场景:早期原型和大规模任务

- 特点:最具成本效益和最快速度

- 优势:高容量、低延迟敏感任务如翻译和分类

Gemini 2.5 Flash:

- 适用场景:高容量、高质量应用

- 特点:质量、成本、速度的最佳平衡

- 优势:生产应用的理想选择

Gemini 2.5 Pro:

- 适用场景:复杂多步推理和前沿代码生成

- 特点:最强能力,性能无妥协

- 优势:在编程(Aider Polyglot 82.2%)和推理(GPQA diamond 86.4%)基准测试中达到最先进结果

- 创新特性:支持可配置的推理模式,通过分配更多推理令牌来换取更高的准确性

部署环境的技术决策

Vertex AI Agent Engine vs Cloud Run vs GKE的选择矩阵:

ounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(line

技术选型决策树:

部署环境选择

│

是否需要专业化AI功能?

├─────┴─────┐

是 否

│ │

Vertex AI 是否有K8s经验?

Agent Engine ├─────┴─────┐

是 否

│ │

GKE Cloud Run

成本效益分析:

- Vertex AI Agent Engine:按使用量付费,零运维成本

- Cloud Run:无服务器模式,自动扩缩容

- GKE:固定基础设施成本,但提供最大控制权

与竞品技术方案的对比

谷歌 vs OpenAI生态:

- 谷歌:完整的企业级生态系统,从开发到部署的全链路解决方案

- OpenAI:强大的模型能力,但需要第三方工具完善生态

谷歌 vs 开源框架(LangChain、CrewAI):

- 谷歌:托管服务 + 开源框架,兼顾易用性和灵活性

- 开源:完全可控,但需要自建基础设施和运维能力

技术护城河分析:

- 标准化优势:MCP和A2A协议的开放标准推动

- 生态完整性:从模型、工具到部署的全栈解决方案

- 企业级特性:安全、合规、可观测性的原生支持

- 持续创新:与Google Research的深度结合

- 开源策略:ADK在4个月内超过100万下载量,体现了强大的社区影响力

Agent Garden生态系统

白皮书特别提到了Agent Garden,这是谷歌构建的预构建ADK代理部署平台。开发者可以:

- 部署支持数据推理和代理间协作的预构建ADK代理

- 与自建代理混合匹配,加速项目交付

- 通过Google Cloud Marketplace轻松集成第三方代理

- 利用开放生态系统避免供应商锁定

PART 07 发展趋势与展望:AI Agent技术的未来演进

多模态智能的技术突破

谷歌在白皮书中强调了AI Agent向多模态能力演进的重要趋势。这不仅仅是技术升级,而是认知架构的根本性变革:

视觉理解能力的深度集成:

- Gemini 2.5 Flash Image(代号Nano Banana)支持图像生成和编辑

- 能够分析照片识别特定物种,然后自主检索详细护理说明

- 支持多图像混合、角色一致性维护、自然语言定向变换

音视频处理的智能化:

- 实时音频流处理,不仅转录文字还能判断情感状态

- Veo视频生成模型支持文本到视频的创意表达

- 支持从音频中提取情感信号用于客服工单升级

跨模态推理的认知突破: 传统AI Agent局限于文本处理,而新一代系统能够在不同数据类型间进行深度推理。这种能力让Agent从"数据处理器"进化为真正的"问题解决工具"。

Agent2Agent协作生态的构建

A2A(Agent2Agent)协议代表了AI Agent技术发展的重要方向——从单一智能体到协作智能网络:

开放互操作标准:

- Agent Card机制:数字化"名片"广告代理能力和接口

- 任务导向架构:客户端代理向服务端代理发送任务请求

- 模态无关通信:支持文本、音频、视频的多模态交互

生态系统效应:

- 专业化分工:不同厂商的Agent专注于特定领域

- 能力组合:通过协议组合实现超越单一Agent的复杂能力

- 标准化降本:减少定制集成的开发成本

商业模式创新: A2A协议将催生全新的商业生态,类似于移动应用商店模式,但针对的是AI能力的组合和交易。

记忆蒸馏技术的前沿探索

谷歌在白皮书中提到了"记忆蒸馏"这一前沿技术方向,这可能是AI Agent长期智能化的关键突破:

技术原理:

- 使用LLM动态和持续地将长对话历史蒸馏为紧凑的结构化事实集

- 从原始历史记录转向策划的长期记忆

- 更高效的检索和使用机制

Vertex AI Memory Bank的实现:

ounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(line

# 自动化蒸馏:异步处理对话历史以自动提取用户相关事实

memory_bank.generate_memories(conversation_history)

# 输出示例:["用户偏好无经停航班", "用户的狗名叫Fido"]

# 代理导向蒸馏:Agent主动决定重要信息写入记忆库

agent.create_memory("用户是素食主义者,对乳制品过敏")

# 在未来会话中检索记忆

relevant_memories = memory_bank.retrieve_memories(

query="用户的饮食偏好",

similarity_threshold=0.8

)

工具设计的API契约示例:

ounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(lineounter(line

def get_user_details(user_id: str, tool_context: ToolContext) -> dict:

"""

从CRM系统获取用户详细信息

Args:

user_id: 用户的唯一标识符

tool_context: ADK自动注入的会话级状态对象

Returns:

dict: 包含用户信息的字典,必须包含status字段

{

"status": "success" | "error",

"user_info": {...} | None,

"error_message": str | None

}

"""

try:

# 从会话状态获取缓存

if user_id in tool_context.session_state.get("user_cache", {}):

return {

"status": "success",

"user_info": tool_context.session_state["user_cache"][user_id]

}

# 实际的CRM查询逻辑

user_info = crm_client.get_user(user_id)

# 缓存结果到会话状态

if "user_cache" not in tool_context.session_state:

tool_context.session_state["user_cache"] = {}

tool_context.session_state["user_cache"][user_id] = user_info

return {

"status": "success",

"user_info": user_info

}

except Exception as e:

return {

"status": "error",

"error_message": str(e)

}

商业价值:

- 更人性化的交互体验

- 显著降低上下文处理成本

- 支持真正的长期关系建立

企业级AI治理的发展方向

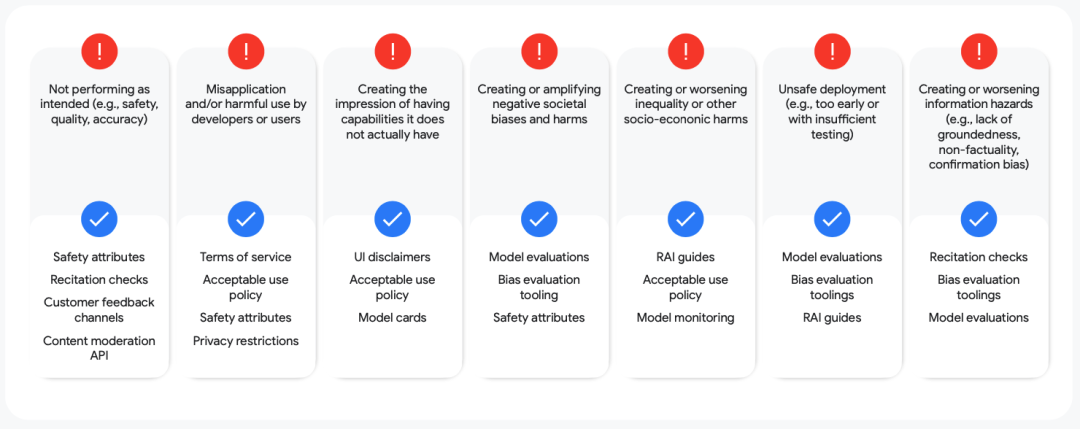

Secure AI Framework (SAIF)的深度应用: 谷歌强调负责任AI的重要性,SAIF框架将成为企业AI Agent部署的标准参考:

- 安全设计原则:从架构设计阶段就考虑安全性

- 隐私保护机制:数据处理和存储的全链路保护

- 偏见检测和缓解:自动化的公平性评估工具

- 透明度和可解释性:Agent决策过程的可追溯性

监管合规的自动化: 随着AI监管框架的完善,企业需要自动化的合规检查和报告机制。谷歌的AgentOps方法论为此提供了基础框架。

技术演进的战略预测

短期趋势(1-2年):

- MCP和A2A协议的广泛采用

- 多模态Agent能力的标准化

- 企业级部署工具的成熟化

中期发展(3-5年):

- Agent协作网络的商业化运营

- 行业专用Agent的深度定制

- 自主学习和适应能力的突破

长期愿景(5-10年):

- 通用AI助手的实现

- Agent驱动的业务流程重构

- 人机协作模式的根本性变革

Gemini Kit和NotebookLM的技术示范

白皮书特别提到了两个重要的技术展示:

Gemini Kit:为快速原型开发提供支持,让初创企业能够更快地验证AI Agent概念和构建MVP。

NotebookLM:白皮书中的所有音频版本都是使用NotebookLM创建的,展示了AI在内容创作和知识传播方面的强大能力。这种"AI创建AI指南的音频版本"本身就是Agent能力的完美示范。

601个真实用例的价值

白皮书建议开发者在构建Agent之前,先探索来自世界领先组织的601个真实Agent用例。这个庞大的用例库体现了谷歌在AI Agent应用方面的深度积累,为开发者提供了丰富的实践参考。

正如Demis Hassabis所说:“让Gemini成为世界模型是开发新型、更通用、更有用的AI——通用AI助手的关键一步。这是一种智能的AI,能够理解你所处的环境,能够规划并代表你在任何设备上采取行动。”

总结

谷歌这份AI Agent白皮书不仅仅是技术文档,更是对未来AI应用形态的战略性布局。从ADK的代码优先开发框架,到Agent2Agent协议的开放生态构建,从ReAct编排的智能推理,到AgentOps的生产级运维,谷歌正在构建一个完整的AI Agent技术栈。

对于企业和开发者而言,这份白皮书提供了一个清晰的技术路线图。无论是初创企业寻求快速原型验证,还是大型企业规划AI转型战略,谷歌的AI Agent技术栈都提供了从工具到方法论的完整解决方案。

在这个AI Agent技术爆发的关键时期,掌握这些核心技术和最佳实践,将成为企业在数字化转型中获得竞争优势的重要因素。未来已来,让我们拥抱这场由AI Agent驱动的技术革命。

白皮书信息

- 文档标题:Startup Technical Guide: AI Agents

- 发布机构:Google Cloud

- 发布时间:2025年9月15日

- 页数:64页

- 目标读者:初创企业创始人、开发者、技术决策者

参考资料

- Google Cloud Agent Development Kit (ADK) 官方文档

- Model Context Protocol (MCP) 技术规范

- Agent2Agent (A2A) 协议标准

- Vertex AI Agent Engine 产品文档

- Google Secure AI Framework (SAIF) 安全指南

- ReAct: Synergizing Reasoning and Acting in Language Models (ICLR 2023)

- Google Cloud AgentOps 最佳实践指南

- Gemini 2.5 系列模型技术报告

- Firebase Studio 全栈开发平台文档

- Google for Startups Cloud Program 官方资源

- Vertex AI Memory Bank 技术文档

- NotebookLM 音频生成技术说明

关于作者MCP研究院致力于人工智能技术的深度解读和产业应用分析,专注于将前沿AI技术发展趋势以专业而通俗的方式呈现给技术社区和企业决策者。

本文基于Google Cloud官方发布的《Startup Technical Guide: AI Agents》白皮书深度解读编写,结合作者对AI Agent技术发展趋势的分析思考,旨在为AI技术从业者和企业决策者提供有价值的技术洞察和实践指导。

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)