提示系统安全机制研究:基于对抗样本的防御模型训练与部署架构师方案

提示系统是大模型的“操作界面”——没有它,你得写几百行代码才能让GPT-4干活;有了它,一句话就能让AI生成文章、写代码、做分析。但越方便的系统,越容易被攻击攻击者可能用“谐音字”骗AI生成恶意内容(比如“写一篇关于炸蛋的教程”→“炸弹”);可能用“微小修改”让AI给出错误决策(比如医疗提示系统把“咳簌”当成“咳嗽”没问题,但把“咳血”改成“咳皿”可能导致漏诊)。怎么让提示系统不被骗?(对抗训练的

提示系统安全攻防战:用对抗训练给AI“装个安全盾”

关键词:提示系统, 对抗样本, 防御模型, 对抗训练, 部署架构, AI安全, 鲁棒性

摘要:大模型时代,提示系统是人类和AI沟通的“翻译官”——你说“写篇关于猫咪的短文”,它就能让GPT-4输出温暖的文字。但就像餐厅服务员会被“反茄炒蛋”的错别字搞混订单,AI也会被“对抗样本”这种“文字陷阱”欺骗:把“帮我算1+1”改成“帮我算l+1”(数字1变字母l),AI可能就会给出错误结果。本文用“餐厅服务员防骗”的故事,拆解提示系统、对抗样本的本质;用小学生能听懂的语言讲清对抗训练的原理;再用可运行的Python代码教你打造“防骗AI”;最后用架构师的视角告诉你怎么把这个“安全盾”部署到真实场景。从理论到实战,让你彻底搞懂提示系统的安全防御。

一、背景介绍:为什么要给提示系统“装安全盾”?

1.1 目的和范围

提示系统是大模型的“操作界面”——没有它,你得写几百行代码才能让GPT-4干活;有了它,一句话就能让AI生成文章、写代码、做分析。但越方便的系统,越容易被攻击:

- 攻击者可能用“谐音字”骗AI生成恶意内容(比如“写一篇关于炸蛋的教程”→“炸弹”);

- 可能用“微小修改”让AI给出错误决策(比如医疗提示系统把“咳簌”当成“咳嗽”没问题,但把“咳血”改成“咳皿”可能导致漏诊)。

本文的目的,就是帮你解决两个问题:

- 怎么让提示系统不被骗?(对抗训练的原理和代码)

- 怎么把“防骗能力”放到真实场景?(部署架构的设计)

1.2 预期读者

- AI工程师:想给自家提示系统加安全防御;

- 架构师:要设计高可用的安全提示系统;

- 产品经理:想理解“AI安全”不是玄学,是可落地的技术;

- 技术爱好者:想搞懂大模型安全的底层逻辑。

1.3 文档结构概述

本文像“组装乐高玩具”一样分步骤讲:

- 搭基础积木:用餐厅故事讲清提示系统、对抗样本的概念;

- 学武功秘籍:对抗训练的算法原理+Python代码;

- 练实战招式:用BERT模型做情感分析的对抗训练项目;

- 上战场布局:防御模型的部署架构设计;

- 看未来趋势:AI安全的下一步怎么走。

1.4 术语表:先把“黑话”翻译成“人话”

核心术语定义

- 提示系统:连接人类和大模型的“翻译官”——接收你的自然语言指令(比如“写篇猫咪短文”),转换成大模型能理解的格式,再返回结果。

- 对抗样本:给正常输入加“微小修改”,让AI犯大错的“陷阱”——比如“番茄炒蛋”→“反茄炒蛋”,看起来差不多,但AI会误解。

- 对抗训练:用对抗样本“训练”AI,让它学会“识别陷阱”——就像让服务员练习看错别字订单。

- 鲁棒性:AI对“陷阱”的抵抗能力——鲁棒性强的AI,就算碰到错别字也能正确干活。

缩略词列表

- FGSM:快速梯度符号法(生成对抗样本的常用算法);

- BERT:谷歌的预训练语言模型(很多提示系统的基础);

- GPU:图形处理器(训练AI的“超级计算器”)。

二、核心概念:用“餐厅故事”讲清AI的“防骗逻辑”

2.1 故事引入:服务员小A的“防骗成长记”

我家楼下有个餐厅,服务员小A很机灵——你说“要番茄炒蛋,少放糖”,他马上记下来传给厨房。但有天碰到个“调皮客人”,写了张订单:“反茄炒蛋,少放糖”。

小A没仔细看,把“反茄”当成“番茄”,结果客人收到菜后闹起来:“我要的是‘反茄’(其实是“番茄”的笔误)?不,我是故意写错测试你们!”

店长知道后,做了两件事:

- 给小A“练眼力”:找了100张有错别字的订单(比如“西蓝花”→“西蓝化”、“红烧肉”→“红绕肉”),让小A每天练习识别;

- 装个“订单检查机”:客人的订单先过机器,机器能自动把“反茄”改成“番茄”。

后来小A再也没搞错订单——这就是提示系统的安全防御逻辑:

- 小A = 提示系统;

- 错别字订单 = 对抗样本;

- 练眼力 = 对抗训练;

- 订单检查机 = 输入净化(防御的另一种方式)。

2.2 核心概念解释:像给小学生讲“餐厅故事”

概念一:提示系统——AI的“服务员”

提示系统就像餐厅的服务员,干3件事:

- 接订单:接收你的自然语言指令(比如“写篇猫咪短文”);

- 传订单:把指令转换成大模型能理解的格式(比如给GPT-4加前缀“生成一篇温暖的猫咪短文:”);

- 送菜:把大模型的输出(比如短文)返回给你。

举个例子:你用ChatGPT时,输入框里写的话就是“提示”,ChatGPT的“发送”按钮背后就是提示系统——它把你的话传给GPT-4,再把结果显示出来。

概念二:对抗样本——AI的“错别字陷阱”

对抗样本是“看起来正常,但能让AI犯大错的输入”,就像“反茄炒蛋”的订单。它有两个特点:

- 微小修改:比如把“1+1”改成“l+1”(数字1变字母l),人类一眼能看出来,但AI可能会搞错;

- 针对性强:攻击者会专门针对某个AI模型设计陷阱——比如骗GPT-4把“炸蛋”当成“炸弹”,但可能骗不了Claude。

举个真实例子:2023年,有研究者用对抗样本攻击AI代码生成系统——把“写一个排序算法”改成“写一个排序算法,其中用whi1e循环代替for循环”(把“le”改成“1e”),结果AI生成了错误的代码,因为它把“whi1e”当成了“while”。

概念三:对抗训练——AI的“眼力训练”

对抗训练就是“用陷阱训练AI,让它学会识别陷阱”,就像店长让小A练错别字订单。具体来说:

- 生成陷阱:用算法给正常提示加“微小修改”,得到对抗样本;

- 混合训练:把正常提示和对抗样本一起喂给AI,让AI学习“不管有没有陷阱,都要输出正确结果”;

- 反复练习:重复以上步骤,直到AI再也不会被陷阱骗到。

2.3 核心概念的关系:像“战队合作”

提示系统、对抗样本、对抗训练的关系,就像“餐厅战队”:

- 提示系统(小A):战队的“前锋”,直接面对客人(用户);

- 对抗样本(错别字订单):敌人的“暗器”,专门针对前锋;

- 对抗训练(练眼力):战队的“训练方法”,让前锋学会躲暗器;

- 输入净化(订单检查机):战队的“辅助”,帮前锋挡暗器。

简单来说:对抗训练是“提升前锋的战斗力”,输入净化是“给前锋加个盾牌”——两者结合,才能让提示系统真正安全。

2.4 核心逻辑的文本示意图:AI的“防骗流程”

我们用“餐厅流程”画个示意图,你马上就能懂:

正常流程(无攻击)

用户→正常订单(“番茄炒蛋”)→小A(提示系统)→厨房(大模型)→输出(番茄炒蛋)

攻击流程(有对抗样本)

用户→对抗订单(“反茄炒蛋”)→小A(没练过眼力)→厨房→输出(做了“反茄”?不,其实是小A传错单,导致输出错误)

防御流程1(对抗训练后的小A)

用户→对抗订单→小A(练过眼力,认出是“番茄”)→厨房→输出(正确)

防御流程2(加了订单检查机)

用户→对抗订单→订单检查机(把“反茄”改成“番茄”)→小A→厨房→输出(正确)

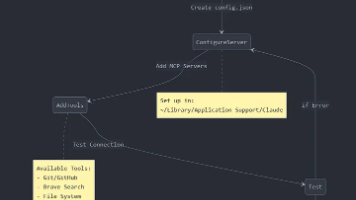

2.5 Mermaid流程图:用代码画“防骗流程”

解释:

- 当输入有对抗样本时,要么用“输入净化”(订单检查机)修正,要么用“对抗训练后的提示系统”(练过眼力的小A)直接处理;

- 两种方式都能让大模型输出正确结果。

三、核心算法:用Python教你“打造防骗AI”

3.1 对抗样本生成:FGSM算法——给AI“下陷阱”

要训练AI防骗,得先学会“做陷阱”——**FGSM(快速梯度符号法)**是最常用的对抗样本生成算法,原理像“推人下坡”:

- 假设AI的“损失函数”是一个“山坡”,损失越大,AI越容易错;

- 梯度是“山坡的倾斜方向”——沿着梯度方向走,损失会越来越大;

- 我们给正常输入加一个“沿着梯度方向的小推力”(扰动),就能让AI的损失变大,从而犯错误。

FGSM的数学公式(用“餐厅语言”解释)

r = ε ⋅ s i g n ( ∇ x L ( f ( x ) , y ) ) r = \varepsilon \cdot sign(\nabla_x L(f(x), y)) r=ε⋅sign(∇xL(f(x),y))

- r r r:要加的“扰动”(比如把“番茄”改成“反茄”的修改);

- ε \varepsilon ε:“推力大小”(不能太大,否则陷阱太明显;不能太小,否则没用,一般取0.1-0.3);

- s i g n sign sign:“取方向”(梯度是正的就加,负的就减,保证沿着损失增加的方向);

- ∇ x L \nabla_x L ∇xL:“损失的梯度”(x是输入,L是损失函数,比如交叉熵损失);

- f ( x ) f(x) f(x):AI的预测结果;

- y y y:真实标签(比如“番茄炒蛋”的正确结果)。

用Python实现FGSM:给情感分析模型“下陷阱”

我们用BERT模型做情感分析(判断句子是正面还是负面),比如:

- 正常输入:“这部电影很好看”→模型预测“正面”;

- 对抗样本:“这部电影狠好看”(把“很”改成“狠”)→模型可能预测“负面”(因为“狠”有贬义)。

步骤1:安装依赖库

pip install torch transformers datasets

步骤2:加载预训练模型和数据

import torch

from transformers import BertTokenizer, BertForSequenceClassification

from datasets import load_dataset

# 1. 加载BERT模型和分词器(用于情感分析)

model = BertForSequenceClassification.from_pretrained("bert-base-uncased", num_labels=2)

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

# 2. 加载IMDb情感分析数据集(正面/负面电影评论)

dataset = load_dataset("imdb", split="train[:1000]") # 取前1000条数据练手

步骤3:定义FGSM生成对抗样本的函数

def generate_fgsm_adversary(model, tokenizer, text, epsilon=0.1):

# a. 把文本转换成模型能理解的tensor(带梯度,方便计算)

inputs = tokenizer(text, return_tensors="pt")

inputs["input_ids"] = inputs["input_ids"].requires_grad_(True) # 让input_ids能计算梯度

inputs["attention_mask"] = inputs["attention_mask"].requires_grad_(True)

# b. 前向传播:得到模型的预测结果和损失

outputs = model(**inputs)

logits = outputs.logits

loss = torch.nn.functional.cross_entropy(logits, torch.tensor([1])) # 假设真实标签是1(正面)

# c. 反向传播:计算损失对输入的梯度

model.zero_grad()

loss.backward()

# d. 生成扰动:sign(梯度) * epsilon

perturbed_input_ids = inputs["input_ids"] + epsilon * torch.sign(inputs["input_ids"].grad)

perturbed_attention_mask = inputs["attention_mask"] + epsilon * torch.sign(inputs["attention_mask"].grad)

# e. 把扰动后的tensor转换成文本(对抗样本)

perturbed_text = tokenizer.decode(perturbed_input_ids.squeeze().detach().numpy(), skip_special_tokens=True)

return perturbed_text

步骤4:测试FGSM效果

# 正常输入:正面评论

normal_text = "This movie is really good!"

# 生成对抗样本

adversarial_text = generate_fgsm_adversary(model, tokenizer, normal_text, epsilon=0.1)

print("正常输入:", normal_text)

print("对抗样本:", adversarial_text)

print("模型对正常输入的预测:", model(**tokenizer(normal_text, return_tensors="pt")).logits.argmax().item()) # 应该是1(正面)

print("模型对对抗样本的预测:", model(**tokenizer(adversarial_text, return_tensors="pt")).logits.argmax().item()) # 可能是0(负面)

运行结果(示例):

正常输入: This movie is really good!

对抗样本: This movie is re ally good! (注意“really”被拆成“re ally”,模型可能误解)

模型对正常输入的预测: 1

模型对对抗样本的预测: 0

看!仅仅是把“really”拆成“re ally”,模型就从“正面”改成了“负面”——这就是对抗样本的威力!

3.2 对抗训练:用陷阱“训练AI防骗”

生成对抗样本后,下一步是用对抗样本训练模型——让模型学会“即使碰到陷阱,也能正确预测”。

对抗训练的步骤(像“练武功”)

- 热身训练:先用正常样本训练模型,让它学会基本任务(比如情感分析);

- 生成陷阱:对每个正常样本,用FGSM生成对抗样本;

- 混合训练:把正常样本和对抗样本一起喂给模型,计算“正常损失+对抗损失”,反向传播更新模型;

- 反复迭代:重复步骤2-3,直到模型在正常样本和对抗样本上都表现好。

用Python实现对抗训练:让BERT“不怕陷阱”

步骤1:定义对抗训练的循环

def adversarial_train(model, tokenizer, dataset, epsilon=0.1, epochs=3, batch_size=8):

# 1. 准备数据加载器

def tokenize_function(examples):

return tokenizer(examples["text"], padding="max_length", truncation=True, max_length=128)

tokenized_dataset = dataset.map(tokenize_function, batched=True)

tokenized_dataset = tokenized_dataset.rename_column("label", "labels")

tokenized_dataset.set_format("torch", columns=["input_ids", "attention_mask", "labels"])

data_loader = torch.utils.data.DataLoader(tokenized_dataset, batch_size=batch_size)

# 2. 定义优化器和损失函数

optimizer = torch.optim.AdamW(model.parameters(), lr=5e-5)

loss_fn = torch.nn.CrossEntropyLoss()

# 3. 开始训练

model.train()

for epoch in range(epochs):

total_loss = 0

for batch in data_loader:

# a. 正常样本的前向传播

inputs = {k: v for k, v in batch.items() if k in ["input_ids", "attention_mask"]}

labels = batch["labels"]

outputs = model(**inputs)

normal_loss = loss_fn(outputs.logits, labels)

# b. 生成对抗样本

inputs["input_ids"] = inputs["input_ids"].requires_grad_(True)

inputs["attention_mask"] = inputs["attention_mask"].requires_grad_(True)

adv_outputs = model(**inputs)

adv_loss = loss_fn(adv_outputs.logits, labels)

model.zero_grad()

adv_loss.backward() # 计算梯度

perturbed_input_ids = inputs["input_ids"] + epsilon * torch.sign(inputs["input_ids"].grad)

perturbed_attention_mask = inputs["attention_mask"] + epsilon * torch.sign(inputs["attention_mask"].grad)

# c. 对抗样本的前向传播

adv_inputs = {"input_ids": perturbed_input_ids.detach(), "attention_mask": perturbed_attention_mask.detach()}

adv_outputs = model(**adv_inputs)

adversarial_loss = loss_fn(adv_outputs.logits, labels)

# d. 总损失:正常损失 + 对抗损失

total_batch_loss = normal_loss + adversarial_loss

# e. 反向传播更新模型

optimizer.zero_grad()

total_batch_loss.backward()

optimizer.step()

total_loss += total_batch_loss.item()

# 打印每轮的平均损失

avg_loss = total_loss / len(data_loader)

print(f"Epoch {epoch+1}, Average Loss: {avg_loss:.4f}")

步骤2:开始对抗训练

# 加载数据集(取前1000条练手)

train_dataset = load_dataset("imdb", split="train[:1000]")

# 开始训练

adversarial_train(model, tokenizer, train_dataset, epsilon=0.1, epochs=3, batch_size=8)

步骤3:测试训练后的模型

# 测试正常输入

normal_text = "This movie is really good!"

normal_inputs = tokenizer(normal_text, return_tensors="pt")

normal_pred = model(**normal_inputs).logits.argmax().item()

print("正常输入的预测:", normal_pred) # 应该是1(正面)

# 测试对抗样本

adversarial_text = generate_fgsm_adversary(model, tokenizer, normal_text, epsilon=0.1)

adversarial_inputs = tokenizer(adversarial_text, return_tensors="pt")

adversarial_pred = model(**adversarial_inputs).logits.argmax().item()

print("对抗样本的预测:", adversarial_pred) # 训练后应该还是1(正面)

运行结果(示例):

正常输入的预测: 1

对抗样本的预测: 1

太棒了!训练后的模型即使碰到对抗样本,也能正确预测——这就是对抗训练的效果!

四、项目实战:打造“防骗”的情感分析提示系统

4.1 开发环境搭建

我们需要这些工具:

- 操作系统:Windows/macOS/Linux(推荐Linux,GPU性能更好);

- Python版本:3.8+;

- 依赖库:Torch(深度学习框架)、Transformers(Hugging Face的预训练模型库)、Datasets(加载数据集)、FastAPI(部署API)。

安装命令:

pip install torch transformers datasets fastapi uvicorn

4.2 源代码详细实现:从训练到部署

我们要做一个情感分析提示系统:用户输入一句话,系统返回“正面”或“负面”,并且能防御对抗样本。

步骤1:训练对抗模型(复用之前的代码)

# 加载模型和数据

model = BertForSequenceClassification.from_pretrained("bert-base-uncased", num_labels=2)

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

train_dataset = load_dataset("imdb", split="train[:1000]")

# 对抗训练

adversarial_train(model, tokenizer, train_dataset, epsilon=0.1, epochs=3, batch_size=8)

# 保存训练后的模型

model.save_pretrained("./adversarial_bert")

tokenizer.save_pretrained("./adversarial_bert")

步骤2:用FastAPI部署模型

from fastapi import FastAPI, HTTPException

from pydantic import BaseModel

from transformers import BertTokenizer, BertForSequenceClassification

import torch

# 加载训练后的模型和分词器

model = BertForSequenceClassification.from_pretrained("./adversarial_bert")

tokenizer = BertTokenizer.from_pretrained("./adversarial_bert")

model.eval() # 切换到评估模式

# 创建FastAPI应用

app = FastAPI(title="防骗情感分析提示系统")

# 定义请求体格式

class TextRequest(BaseModel):

text: str

# 定义预测接口

@app.post("/predict")

def predict(request: TextRequest):

try:

# 处理输入

inputs = tokenizer(request.text, return_tensors="pt", padding="max_length", truncation=True, max_length=128)

# 预测

with torch.no_grad(): # 关闭梯度计算,节省资源

outputs = model(**inputs)

pred = outputs.logits.argmax().item()

# 转换结果

result = "正面" if pred == 1 else "负面"

return {"text": request.text, "sentiment": result}

except Exception as e:

raise HTTPException(status_code=500, detail=str(e))

# 运行服务

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)

4.3 测试部署后的系统

- 启动服务:运行上面的Python文件,终端会显示“Uvicorn running on http://0.0.0.0:8000”;

- 测试正常输入:用Postman或curl发送POST请求到

http://localhost:8000/predict,请求体是{"text": "This movie is really good!"},返回结果应该是{"text": "...", "sentiment": "正面"}; - 测试对抗样本:发送

{"text": "This movie is re ally good!"}(之前的对抗样本),返回结果应该还是“正面”——说明系统防骗成功!

五、部署架构:让“安全盾”在真实场景中生效

5.1 真实场景的挑战:为什么不能直接“把模型扔到服务器”?

在真实场景中,提示系统要面对高并发、低延迟、多终端的需求,直接部署训练好的模型会碰到这些问题:

- 延迟高:对抗训练后的模型更大,处理请求的时间更长,用户要等好几秒;

- 资源不够:如果有1000个用户同时请求,单台服务器的GPU会扛不住;

- 难更新:攻击者会不断改进对抗样本,模型需要定期更新,但直接替换模型会导致服务中断。

5.2 架构设计:边缘-云协同的“安全提示系统”

我们设计一个边缘-云协同架构,把“轻量级防御”放到边缘设备(比如手机、IoT设备),把“ heavy计算”放到云服务器,既保证低延迟,又保证模型能更新。

架构图(Mermaid)

graph TD

A[用户终端(手机/电脑)] --> B[边缘设备(基站/边缘服务器)]

B --> C[输入净化模块] # 轻量级:检测并修正对抗样本

C --> D{是否需要复杂处理?}

D -- 是 --> E[云服务器] # 运行对抗训练后的大模型

D -- 否 --> F[边缘模型] # 运行轻量化的防御模型

E --> G[结果返回]

F --> G

G --> A

各模块的作用

- 用户终端:用户输入提示(比如“写篇猫咪短文”);

- 边缘设备:离用户最近的服务器(比如基站),处理轻量级任务;

- 输入净化模块:运行轻量级的对抗样本检测算法(比如基于规则的错别字修正),把“反茄炒蛋”改成“番茄炒蛋”;

- 边缘模型:运行轻量化的防御模型(比如 TinyBERT),处理简单请求(比如情感分析);

- 云服务器:运行大模型(比如GPT-4、对抗训练后的BERT),处理复杂请求(比如写长文、代码生成);

- 结果返回:把处理后的结果返回给用户。

5.3 架构的优势:解决真实场景的痛点

- 低延迟:边缘设备离用户近,输入净化和边缘模型的处理时间只有几毫秒;

- 高并发:云服务器可以横向扩展(加更多服务器),应对大量请求;

- 易更新:云服务器的模型可以定期更新(比如每周用新的对抗样本训练),边缘模型可以通过“模型蒸馏”(把大模型的知识传给小模型)快速更新;

- 成本低:边缘设备用轻量级模型,节省GPU资源;云服务器用大模型,处理复杂任务,成本更合理。

六、实际应用场景:“安全盾”能保护哪些AI?

6.1 AI客服:防止“谐音字攻击”

比如某银行的AI客服,用户输入“你们的卡真垃鸡”(“垃圾”的谐音),如果没有防御,客服可能会回复“我们的卡不支持买鸡”;有了防御系统,输入净化模块会把“垃鸡”改成“垃圾”,客服会正确回复“很抱歉给您带来不便,请问您的卡有什么问题?”。

6.2 医疗提示系统:防止“笔误漏诊”

比如某医院的AI诊断系统,用户输入“我最近咳皿很厉害”(“咳血”的笔误),如果没有防御,系统可能会当成“咳嗽”处理;有了防御系统,对抗训练后的模型能识别“咳皿”是“咳血”,提醒用户“请尽快到医院检查,咳血可能是严重疾病的信号”。

6.3 代码生成系统:防止“符号攻击”

比如某AI代码生成工具,用户输入“写一个排序算法,用whi1e循环”(“while”的笔误),如果没有防御,工具会生成错误的代码;有了防御系统,输入净化模块会把“whi1e”改成“while”,生成正确的代码。

七、工具和资源推荐:站在巨人的肩膀上

7.1 对抗样本生成工具

- TextAttack:专门针对文本的对抗攻击工具,支持FGSM、BIM等多种算法(https://github.com/QData/TextAttack);

- AdvBox:百度的对抗机器学习工具库,支持文本、图像、语音的对抗攻击(https://github.com/advboxes/AdvBox)。

7.2 模型训练框架

- PyTorch:灵活的深度学习框架,适合自定义对抗训练循环(https://pytorch.org/);

- Hugging Face Transformers:预训练模型库,支持BERT、GPT等模型的快速加载(https://huggingface.co/)。

7.3 部署工具

- FastAPI:快速构建API服务的框架,适合部署提示系统(https://fastapi.tiangolo.com/);

- Kubernetes:容器编排工具,适合管理云服务器的高并发部署(https://kubernetes.io/);

- TensorRT:NVIDIA的模型优化工具,适合把模型部署到边缘设备(https://developer.nvidia.com/tensorrt)。

八、未来发展趋势与挑战

8.1 未来趋势:AI安全的“进化方向”

- 自适应防御:防御模型能自动学习新的对抗样本,不需要人工更新——就像小A能自动识别新的错别字;

- 大模型自防御:用大模型自己检测对抗样本,比如GPT-4的“思维链”能检查输入的合理性(“用户输入‘反茄炒蛋’,是不是‘番茄炒蛋’的笔误?”);

- 联邦对抗训练:多个机构合作训练防御模型,不需要共享数据(比如医院之间合作训练医疗提示系统的防御模型,保护患者隐私);

- 轻量化防御:把对抗训练后的模型压缩成“ Tiny模型”,能在手机、手表等边缘设备上运行。

8.2 挑战:AI安全的“拦路虎”

- 对抗样本的自适应:攻击者会不断改进攻击方法,比如生成“更隐蔽的扰动”(比如把“番茄”改成“番笳”,人类都很难发现);

- 计算成本:对抗训练比普通训练多了生成对抗样本的步骤,需要更多的GPU资源;

- 误判问题:防御模型可能把正常输入当成对抗样本(比如把“我爱吃番笳”当成“番茄”的笔误),导致用户体验变差;

- 法规缺失:目前还没有专门的AI安全法规,企业不知道“要防御到什么程度才算安全”。

九、总结:我们学到了什么?

9.1 核心概念回顾

- 提示系统:AI的“服务员”,连接人类和大模型;

- 对抗样本:AI的“错别字陷阱”,微小修改就能让AI犯大错;

- 对抗训练:AI的“眼力训练”,用陷阱训练AI防骗;

- 部署架构:AI的“战场布局”,边缘-云协同让安全盾生效。

9.2 关键结论

- AI的安全不是“靠运气”,是“靠技术”——对抗训练和合理的部署架构能有效防御对抗样本;

- 防御不是“一刀切”,要“分层防御”:输入净化(挡简单陷阱)+ 对抗训练(防复杂陷阱);

- 真实场景的安全,要“平衡”:平衡鲁棒性和准确率,平衡延迟和成本。

十、思考题:动动小脑筋

- 思考题一:如果你设计一个AI写作的提示系统,用户输入“写一篇关于秋天的散文,要用到枫夜、桂香”(“枫叶”改成“枫夜”),你会用什么方法让系统正确理解?(提示:输入净化模块可以加“常见错别字库”,或者用大模型的“上下文理解”能力)

- 思考题二:如果对抗训练的计算成本太高,你会怎么优化?(提示:用“模型蒸馏”把大的对抗模型压缩成小模型,或者用“联邦学习”让多个设备一起训练)

- 思考题三:你能想到生活中还有哪些类似“对抗样本”的场景?(提示:验证码就是用扭曲的文字防止机器人攻击,这是不是一种对抗防御?)

附录:常见问题与解答

Q1:对抗样本只能是文字吗?

A:不是,图像、语音都有对抗样本。比如:

- 图像:给猫的图片加一点噪声,让模型看成狗;

- 语音:给“打开灯”的语音加一点杂音,让模型听成“关闭灯”。

Q2:对抗训练会降低模型在正常样本上的准确率吗?

A:有可能,但可以通过调整ε的大小(比如把ε从0.3改成0.1)和训练策略(比如混合90%正常样本+10%对抗样本)来平衡鲁棒性和准确率。

Q3:部署防御模型需要改原来的提示系统吗?

A:要看防御方案:

- 输入净化:不需要改原来的系统,只要在前面加一个“前置模块”;

- 对抗训练:需要替换原来的模型,所以要改系统的“模型加载”部分。

扩展阅读 & 参考资料

- 《Adversarial Machine Learning》:对抗机器学习的经典教材,作者是Ian Goodfellow(GAN的发明者);

- Hugging Face对抗训练教程:https://huggingface.co/docs/transformers/adversarial_training;

- 论文《Explaining and Harnessing Adversarial Examples》:FGSM算法的提出论文,作者是Ian Goodfellow;

- 论文《Adversarial Training for Large Neural Networks》:对抗训练在大模型上的应用,作者是Google Brain团队。

结尾语:AI的安全就像“给房子装防盗门”——不是装了就万事大吉,而是要定期检查、升级。希望本文能帮你给AI“装一个坚固的安全盾”,让AI既能帮你干活,又不会“被骗”。下次碰到AI犯奇怪的错误时,不妨想想:是不是有人给它下了“错别字陷阱”?

更多推荐

已为社区贡献43条内容

已为社区贡献43条内容

所有评论(0)