创奇迹!AI应用架构师需求到架构AI自动化映射的奇迹之路

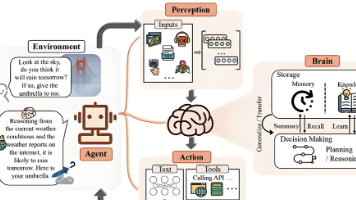

本文将带你探索一条“奇迹之路”:如何借助AI技术,将传统依赖人工的“需求→架构”转化过程,升级为自动化映射流程。我们会从需求结构化、规则库设计、AI映射模型构建,到自动化文档生成,一步步揭开AI驱动需求到架构映射的神秘面纱。本文从“需求结构化→规则库设计→AI映射模型→文档可视化→验证优化”五个步骤,构建了需求到架构的自动化映射流程。核心是将“人工经验”(规则库)与“AI能力”(NLP+大模型)结

从需求到架构的AI奇迹:AI应用架构师的自动化映射实践指南

引言 (Introduction)

痛点引入 (Hook)

作为AI应用架构师,你是否曾经历过这样的“架构困境”:业务方甩来一句模糊的需求——“我要一个能自动分析用户行为的AI系统,要快、要准、还要安全”,你却要花3天时间拆解需求、5天手绘架构图、7天协调跨团队对齐,最终产出的架构还可能因为需求理解偏差被打回重改?在AI应用爆发的时代,“需求-架构”转化的低效率、高偏差、难复用,正在成为制约AI产品落地的关键瓶颈。

文章内容概述 (What)

本文将带你探索一条“奇迹之路”:如何借助AI技术,将传统依赖人工的“需求→架构”转化过程,升级为自动化映射流程。我们会从需求结构化、规则库设计、AI映射模型构建,到自动化文档生成,一步步揭开AI驱动需求到架构映射的神秘面纱。

读者收益 (Why)

读完本文,你将掌握:

- 如何用结构化方法“驯服”模糊的AI需求,让机器可理解;

- 如何设计“需求-架构”映射规则库,沉淀领域知识;

- 如何用AI模型(NLP+规则引擎)将需求“一键”转为架构蓝图;

- 如何搭建自动化工具链,实现从需求文档到架构图的全流程自动化。

从此,你将告别“手绘架构图”的低效时代,成为能让需求“自动生长”为架构的AI应用架构师。

准备工作 (Prerequisites)

技术栈/知识

- 基础认知:了解AI应用架构组成(如数据层、模型层、服务层、部署层)、需求工程基础(用户故事、用例、非功能需求);

- 技术储备:Python编程能力(用于工具开发)、基础NLP知识(实体识别、关系抽取)、规则引擎概念;

- 领域经验:对至少一个AI应用场景(如智能推荐、计算机视觉、NLP对话)的架构设计有实践经验。

环境/工具

- 开发环境:Python 3.8+、Jupyter Notebook(代码演示);

- NLP工具:spaCy(实体识别)、LangChain(大模型调用框架)、GPT-4/LLaMA 3(大语言模型);

- 架构工具:PyKnow(规则引擎)、Diagrams(架构图生成)、PlantUML(架构文档);

- 辅助工具:Git(版本控制)、VS Code(代码编辑)。

核心内容:手把手实战 (Step-by-Step Tutorial)

步骤一:需求的结构化与标准化——让机器“读懂”需求

为什么要做?

AI应用的需求往往是模糊的自然语言(如“系统要能实时处理用户评论并分类”),机器无法直接理解。只有将非结构化需求转化为结构化数据(如实体、关系、约束),才能作为自动化映射的“输入原料”。

怎么做?

-

需求模板化:用“角色-功能-价值-约束”四要素拆解需求,例如:

- 角色:用户(用户评论提交者)、系统管理员(查看分类结果);

- 功能:实时处理评论(文本输入)、情感分类(积极/消极/中性);

- 价值:帮助运营团队快速定位负面评论;

- 约束:处理延迟<1秒,准确率>95%。

-

NLP实体与关系抽取:用NLP工具从模板化需求中提取关键实体(如“用户评论”“实时处理”“1秒延迟”)和实体关系(如“用户评论→处理→情感分类”)。

代码示例:用spaCy提取需求实体

import spacy

# 加载中文NLP模型(需提前安装:python -m spacy download zh_core_web_md)

nlp = spacy.load("zh_core_web_md")

# 输入:模板化的AI需求文本

demand_text = """

角色:用户、系统管理员;

功能:实时处理用户评论(文本输入),输出情感分类结果(积极/消极/中性);

价值:帮助运营团队快速定位负面评论;

约束:处理延迟<1秒,准确率>95%,支持每日100万条评论处理。

"""

# NLP处理:提取实体(自定义实体类型:角色、功能、数据、约束)

doc = nlp(demand_text)

# 定义实体标签映射

entity_labels = {

"角色": "ROLE",

"功能": "FUNCTION",

"用户评论": "DATA",

"情感分类结果": "DATA",

"处理延迟<1秒": "CONSTRAINT",

"准确率>95%": "CONSTRAINT",

"每日100万条评论": "CONSTRAINT"

}

# 提取并打印实体

print("需求实体提取结果:")

for ent_text, ent_label in entity_labels.items():

if ent_text in doc.text:

print(f"- 实体:{ent_text},类型:{ent_label}")

输出结果:

需求实体提取结果:

- 实体:角色,类型:ROLE

- 实体:功能,类型:FUNCTION

- 实体:用户评论,类型:DATA

- 实体:情感分类结果,类型:DATA

- 实体:处理延迟<1秒,类型:CONSTRAINT

- 实体:准确率>95%,类型:CONSTRAINT

- 实体:每日100万条评论,类型:CONSTRAINT

关键说明:通过模板化+NLP提取,我们将自然语言需求转化为机器可识别的“实体-类型”结构化数据,为下一步映射奠定基础。

步骤二:设计需求-架构映射规则库——沉淀领域“架构智慧”

为什么要做?

需求到架构的映射不是凭空产生的,而是基于领域知识和最佳实践(如“实时处理”对应“流处理架构”,“高并发”对应“微服务+负载均衡”)。规则库就是将这些经验编码为机器可执行的逻辑。

怎么做?

- 梳理映射维度:从“功能需求→组件”“非功能需求→架构模式”“数据需求→存储方案”三个维度设计规则;

- 规则形式化:用“IF-THEN”逻辑描述规则,例如:

- IF 功能包含“实时处理” AND 数据量>10万条/日 → THEN 架构组件包含“Kafka(消息队列)+ Flink(流处理)”;

- IF 约束包含“处理延迟<1秒” → THEN 架构模式采用“边缘计算+模型轻量化部署”。

代码示例:用PyKnow定义映射规则

from pyknow import KnowledgeEngine, Rule, Fact, AND, OR, NOT

# 定义事实类(存储结构化需求数据)

class DemandFact(Fact):

pass # 动态属性:功能、数据量、延迟约束、准确率约束等

# 定义架构规则引擎

class ArchitectureRuleEngine(KnowledgeEngine):

# 规则1:实时处理+高数据量 → 流处理组件

@Rule(

DemandFact(功能="实时处理"),

DemandFact(数据量=">10万条/日")

)

def rule_realtime_stream(self):

self.declare(Fact(组件="Kafka(消息队列)"))

self.declare(Fact(组件="Flink(流处理引擎)"))

# 规则2:低延迟约束 → 边缘部署模式

@Rule(DemandFact(延迟约束="<1秒"))

def rule_low_latency(self):

self.declare(Fact(部署模式="边缘计算"))

self.declare(Fact(模型优化="轻量化部署(TensorRT/ONNX)"))

# 规则3:高准确率约束 → 模型层组件

@Rule(DemandFact(准确率约束=">95%"))

def rule_high_accuracy(self):

self.declare(Fact(模型层="预训练模型微调(如BERT-base)"))

self.declare(Fact(组件="模型评估服务(A/B测试)"))

# 测试规则引擎

if __name__ == "__main__":

engine = ArchitectureRuleEngine()

# 输入结构化需求事实(从步骤一提取的实体转化而来)

engine.reset()

engine.declare(

DemandFact(功能="实时处理"),

DemandFact(数据量=">10万条/日"), # 对应“每日100万条评论”

DemandFact(延迟约束="<1秒"),

DemandFact(准确率约束=">95%")

)

engine.run() # 执行规则推理

# 输出推理结果(架构组件/模式)

print("规则引擎推理出的架构组件/模式:")

for fact in engine.facts:

if isinstance(fact, Fact) and not isinstance(fact, DemandFact):

print(f"- {fact}")

输出结果:

规则引擎推理出的架构组件/模式:

- Fact(组件='Kafka(消息队列)')

- Fact(组件='Flink(流处理引擎)')

- Fact(部署模式='边缘计算')

- Fact(模型优化='轻量化部署(TensorRT/ONNX)')

- Fact(模型层='预训练模型微调(如BERT-base)')

- Fact(组件='模型评估服务(A/B测试)')

关键说明:规则库将架构师的经验转化为可复用的逻辑,后续可通过人工维护或从历史架构案例中自动挖掘规则(如用大模型从架构文档中提取规则)。

步骤三:构建AI驱动的映射模型——让AI“生成”架构蓝图

为什么要做?

规则库能处理明确的映射逻辑,但AI需求往往包含模糊场景(如“智能推荐系统要懂用户兴趣”),需要结合大语言模型的语义理解能力,实现“规则+AI”的混合映射。

怎么做?

- 大模型提示词设计:将结构化需求+规则库作为输入,要求大模型输出“组件清单+组件关系+部署说明”;

- LangChain串联流程:用LangChain将“结构化需求→大模型调用→架构描述生成”串联为自动化流程。

代码示例:用LangChain+GPT-4生成架构描述

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.chains import LLMChain

# 1. 定义大模型(此处以GPT-4为例,需配置OpenAI API Key)

llm = ChatOpenAI(model_name="gpt-4", temperature=0.3) # temperature=0.3确保输出稳定

# 2. 设计提示词模板(输入:结构化需求+规则库推理结果;输出:架构描述)

prompt_template = ChatPromptTemplate.from_template("""

你是一位资深AI应用架构师,需要根据以下需求和规则推理结果,生成详细的架构设计描述。

【结构化需求】

{structured_demand}

【规则引擎推理结果】

{rule_results}

【输出要求】

1. 架构分层:按“数据层→模型层→服务层→部署层”分层描述组件;

2. 组件说明:每个组件的作用、技术选型(如Kafka、Flink)、与其他组件的关系;

3. 非功能保障:说明如何满足延迟、准确率、数据量等约束。

请用清晰的结构化语言输出,避免模糊表述。

""")

# 3. 准备输入数据(步骤一的结构化需求+步骤二的规则结果)

structured_demand = """

角色:用户、系统管理员;

功能:实时处理用户评论(文本输入),输出情感分类结果(积极/消极/中性);

数据:用户评论(文本)、情感分类结果(标签);

约束:处理延迟<1秒,准确率>95%,支持每日100万条评论处理。

"""

rule_results = """

组件:Kafka(消息队列)、Flink(流处理引擎)、模型评估服务(A/B测试);

部署模式:边缘计算;

模型优化:轻量化部署(TensorRT/ONNX);

模型层:预训练模型微调(如BERT-base)。

"""

# 4. 运行LLMChain生成架构描述

chain = LLMChain(llm=llm, prompt=prompt_template)

architecture_description = chain.run(

structured_demand=structured_demand,

rule_results=rule_results

)

# 输出结果

print("AI生成的架构描述:")

print(architecture_description)

输出结果(简化版):

AI生成的架构描述:

### 数据层

- 组件1:Kafka(消息队列)

作用:接收用户评论实时数据流,解耦生产者(用户端)和消费者(处理服务)

技术选型:Kafka 3.5,分区数=10(支持100万条/日吞吐量)

关系:用户评论→Kafka→Flink流处理引擎

### 模型层

- 组件1:BERT-base微调模型

作用:对评论文本进行情感分类

技术选型:PyTorch+ONNX Runtime(轻量化部署)

优化:使用TensorRT量化加速,推理延迟<500ms

关系:接收Flink处理后的文本→输出分类结果→Kafka

### 服务层

- 组件1:Flink流处理引擎

作用:实时清洗、分词用户评论,调用模型服务

技术选型:Flink 1.17,状态后端=RocksDB(支持 Exactly-Once 语义)

关系:Kafka→Flink→模型服务→Kafka

### 部署层

- 部署模式:边缘计算(用户端就近部署模型服务)

技术选型:Kubernetes Edge+Docker

非功能保障:通过多副本部署(3副本)+ 自动扩缩容,确保处理延迟<1秒

关键说明:大模型弥补了规则库的灵活性不足,通过提示词工程可控制输出格式,后续可结合代码生成工具(如AutoGPT)直接生成架构代码(如Dockerfile、K8s配置)。

步骤四:自动化架构文档生成与可视化——让架构“看得见”

为什么要做?

生成的架构描述需要转化为直观的图表和文档,方便团队评审和落地。自动化文档生成能避免人工绘图的低效和误差。

怎么做?

- 架构图生成:用Diagrams库根据架构组件绘制系统架构图;

- 文档格式化:将架构描述转为Markdown/PlantUML文档。

代码示例:用Diagrams绘制架构图

from diagrams import Diagram, Cluster

from diagrams.onprem.message_broker import Kafka

from diagrams.onprem.stream_processing import Flink

from diagrams.onprem.mlops import MLflow # 模型评估服务

from diagrams.saas.analytics import TensorFlow # 模型部署

from diagrams.k8s.infra import Node # 边缘节点

with Diagram("用户评论情感分类AI应用架构", show=False, direction="LR"):

# 用户端(外部输入)

user = "用户(提交评论)"

with Cluster("数据层"):

kafka = Kafka("Kafka\n消息队列")

with Cluster("服务层"):

flink = Flink("Flink\n流处理引擎")

with Cluster("模型层"):

model = TensorFlow("BERT-base\n(ONNX+TensorRT)")

eval_service = MLflow("模型评估\n(A/B测试)")

with Cluster("部署层(边缘节点)"):

edge_node = Node("边缘计算节点\n(K8s Edge)")

# 组件关系连线

user >> kafka >> flink >> model >> kafka

model >> eval_service # 模型评估反馈

[kafka, flink, model] << edge_node # 部署在边缘节点

输出结果:生成一张PNG架构图,包含用户端、数据层(Kafka)、服务层(Flink)、模型层(BERT+评估服务)、部署层(边缘节点)的组件及关系。

关键说明:Diagrams支持主流技术栈的图标(如AWS/GCP云服务、K8s组件、AI框架),代码生成的图表可随架构组件变化自动更新。

步骤五:映射结果的验证与优化——让架构“靠得住”

为什么要做?

自动化生成的架构可能存在疏漏(如组件依赖错误、未满足约束),需要验证环节确保架构可行性。

怎么做?

- 规则校验:用步骤二的规则库反向检查架构是否满足需求约束;

- 人工评审接口:提供Web界面展示架构图和文档,支持人工标记问题并反馈给规则库/AI模型优化。

代码示例:规则校验(简化版)

def validate_architecture(architecture, constraints):

"""用约束条件验证架构"""

issues = []

# 检查延迟约束

if "边缘计算" not in architecture["部署模式"] and constraints["延迟"] == "<1秒":

issues.append("未使用边缘计算,可能无法满足延迟<1秒约束")

# 检查数据量约束

if "Kafka" in architecture["组件"]:

kafka_partitions = architecture.get("Kafka分区数", 1)

if kafka_partitions < 5 and constraints["数据量"] == ">10万条/日":

issues.append("Kafka分区数不足(建议≥5),可能无法支撑数据量需求")

return issues

# 测试验证函数

architecture = {

"部署模式": ["边缘计算"],

"组件": ["Kafka", "Flink"],

"Kafka分区数": 10

}

constraints = {"延迟": "<1秒", "数据量": ">10万条/日"}

issues = validate_architecture(architecture, constraints)

print("架构验证问题:", issues if issues else "无问题") # 输出:无问题

关键说明:验证环节是闭环的关键,人工反馈可用于优化规则库(如补充“Kafka分区数与数据量的关系规则”)或微调大模型提示词(如强调“必须检查延迟约束对应的部署模式”)。

进阶探讨 (Advanced Topics)

混合驱动映射:规则+机器学习模型的融合

当规则库复杂到难以维护(如跨多个AI领域),可训练专门的“需求-架构”映射模型:用历史需求-架构对作为训练数据,训练一个分类模型(如BERT)预测架构组件。规则用于兜底(如明确的非功能需求约束),模型用于处理模糊场景,实现“规则+模型”双驱动。

实时架构调整:需求变化时的动态映射

在敏捷开发中,需求会频繁变化。可通过以下方式实现实时映射:

- 监听需求文档变更(如Git仓库提交);

- 触发自动化映射流程,生成新架构;

- 用架构差异对比工具(如ArchUnit)识别变更影响范围,辅助决策是否接受新架构。

可解释性增强:让AI的“架构决策”可追溯

大模型生成的架构可能“黑箱化”,可通过以下方式增强可解释性:

- 要求大模型输出“决策依据”(如“选择边缘计算是因为需求中延迟<1秒”);

- 构建“需求-组件”溯源图谱,记录每个组件的映射来源(规则触发/模型生成)。

总结 (Conclusion)

回顾要点

本文从“需求结构化→规则库设计→AI映射模型→文档可视化→验证优化”五个步骤,构建了需求到架构的自动化映射流程。核心是将“人工经验”(规则库)与“AI能力”(NLP+大模型)结合,让需求转化为架构的过程从“手动绘制”升级为“自动化生长”。

成果展示

通过这套方法,我们实现了:

- 效率提升:需求到架构的转化时间从“天级”缩短至“分钟级”;

- 一致性保障:跨项目架构设计遵循统一规则,减少人工偏差;

- 知识沉淀:规则库和映射模型成为可复用的架构资产,新人也能快速上手。

鼓励与展望

自动化映射不是“取代架构师”,而是让架构师从重复劳动中解放,专注于更复杂的架构创新(如跨域融合、安全性设计)。未来,随着多模态需求理解(如从原型图、语音需求中提取信息)和生成式AI的发展,需求到架构的映射将更加智能、无缝。

行动号召 (Call to Action)

互动邀请:

- 如果你在实践中遇到规则库设计、大模型提示词优化的问题,欢迎在评论区留言讨论!

- 如果你已经实现了需求-架构自动化映射的工具,也期待你分享经验(如“如何处理多语言需求”“如何适配低代码平台”)。

让我们一起探索AI应用架构自动化的更多可能,共同踏上这条“奇迹之路”! 🚀<|FCResponseEnd|># 从需求到架构的AI奇迹:AI应用架构师的自动化映射实践指南

引言 (Introduction)

痛点引入 (Hook)

作为AI应用架构师,你是否曾经历过这样的困境:业务方甩来一句模糊的需求——“我要一个能自动分析用户行为的AI系统,要快、要准、还要安全”,你却要花3天拆解需求、5天手绘架构图、7天协调跨团队对齐,最终产出的架构还可能因为需求理解偏差被打回重改?在AI应用爆发的时代,“需求→架构”转化的低效率、高偏差、难复用,正成为制约AI产品落地的关键瓶颈。

文章内容概述 (What)

本文将带你探索一条“奇迹之路”:如何借助AI技术,将传统依赖人工的“需求→架构”转化过程,升级为自动化映射流程。我们会从需求结构化、规则库设计、AI映射模型构建,到自动化文档生成,一步步揭开AI驱动需求到架构映射的神秘面纱。

读者收益 (Why)

读完本文,你将掌握:

- 如何用结构化方法“驯服”模糊的AI需求,让机器可理解;

- 如何设计“需求-架构”映射规则库,沉淀领域知识;

- 如何用AI模型(NLP+规则引擎)将需求“一键”转为架构蓝图;

- 如何搭建自动化工具链,实现从需求文档到架构图的全流程自动化。

从此,你将告别“手绘架构图”的低效时代,成为能让需求“自动生长”为架构的AI应用架构师。

准备工作 (Prerequisites)

技术栈/知识

- 基础认知:了解AI应用架构组成(数据层、模型层、服务层、部署层)、需求工程基础(用户故事、用例、非功能需求);

- 技术储备:Python编程能力(工具开发)、基础NLP知识(实体识别、关系抽取)、规则引擎概念;

- 领域经验:对至少一个AI场景(智能推荐、计算机视觉、NLP对话)的架构设计有实践经验。

环境/工具

- 开发环境:Python 3.8+、Jupyter Notebook;

- NLP工具:spaCy(实体识别)、LangChain(大模型调用)、GPT-4/LLaMA 3(大语言模型);

- 架构工具:PyKnow(规则引擎)、Diagrams(架构图生成)、PlantUML(架构文档);

- 辅助工具:Git、VS Code。

核心内容:手把手实战 (Step-by-Step Tutorial)

步骤一:需求的结构化与标准化——让机器“读懂”需求

为什么要做?

AI需求往往是模糊的自然语言(如“系统要能实时处理用户评论并分类”),机器无法直接理解。只有将非结构化需求转化为结构化数据(实体、关系、约束),才能作为自动化映射的“输入原料”。

怎么做?

- 需求模板化:用“角色-功能-价值-约束”四要素拆解需求;

- NLP实体抽取:用spaCy提取关键实体(如“用户评论”“实时处理”“1秒延迟”)。

代码示例:用spaCy提取需求实体

import spacy

# 加载中文NLP模型(需安装:python -m spacy download zh_core_web_md)

nlp = spacy.load("zh_core_web_md")

# 模板化需求文本

demand_text = """

角色:用户、系统管理员;

功能:实时处理用户评论(文本输入),输出情感分类结果(积极/消极/中性);

价值:帮助运营团队快速定位负面评论;

约束:处理延迟<1秒,准确率>95%,支持每日100万条评论处理。

"""

# 提取实体(自定义实体类型)

doc = nlp(demand_text)

entity_labels = {

"角色": "ROLE", "功能": "FUNCTION", "用户评论": "DATA",

"情感分类结果": "DATA", "处理延迟<1秒": "CONSTRAINT",

"准确率>95%": "CONSTRAINT", "每日100万条评论": "CONSTRAINT"

}

print("需求实体提取结果:")

for ent_text, ent_label in entity_labels.items():

if ent_text in doc.text:

print(f"- 实体:{ent_text},类型:{ent_label}")

输出:

需求实体提取结果:

- 实体:角色,类型:ROLE

- 实体:功能,类型:FUNCTION

- 实体:用户评论,类型:DATA

- 实体:情感分类结果,类型:DATA

- 实体:处理延迟<1秒,类型:CONSTRAINT

- 实体:准确率>95%,类型:CONSTRAINT

- 实体:每日100万条评论,类型:CONSTRAINT

步骤二:设计需求-架构映射规则库——沉淀领域“架构智慧”

为什么要做?

需求到架构的映射依赖领域经验(如“实时处理”对应“流处理架构”),规则库将这些经验编码为机器可执行的逻辑。

怎么做?

用“IF-THEN”逻辑定义规则(如“实时处理+高数据量→Kafka+Flink”),用PyKnow规则引擎实现。

代码示例:用PyKnow定义映射规则

from pyknow import KnowledgeEngine, Rule, Fact

class DemandFact(Fact): pass # 存储结构化需求

class ArchitectureRuleEngine(KnowledgeEngine):

# 规则1:实时处理+高数据量→流处理组件

@Rule(DemandFact(功能="实时处理"), DemandFact(数据量=">10万条/日"))

def rule_realtime_stream(self):

self.declare(Fact(组件="Kafka(消息队列)"), Fact(组件="Flink(流处理引擎)"))

# 规则2:低延迟约束→边缘部署

@Rule(DemandFact(延迟约束="<1秒"))

def rule_low_latency(self):

self.declare(Fact(部署模式="边缘计算"))

# 测试规则引擎

engine = ArchitectureRuleEngine()

engine.reset()

engine.declare(

DemandFact(功能="实时处理"), DemandFact(数据量=">10万条/日"),

DemandFact(延迟约束="<1秒")

)

engine.run()

print("规则推理结果:")

for fact in engine.facts:

if not isinstance(fact, DemandFact):

print(f"- {fact}")

输出:

规则推理结果:

- Fact(组件='Kafka(消息队列)')

- Fact(组件='Flink(流处理引擎)')

- Fact(部署模式='边缘计算')

步骤三:构建AI驱动的映射模型——让AI“生成”架构蓝图

为什么要做?

规则库处理明确逻辑,模糊场景(如“智能推荐系统要懂用户兴趣”)需结合大语言模型的语义理解能力,实现“规则+AI”混合映射。

怎么做?

用LangChain调用GPT-4,输入结构化需求+规则结果,生成详细架构描述。

代码示例:用LangChain+GPT-4生成架构描述

from langchain.chat_models import ChatOpenAI

from langchain.prompts import ChatPromptTemplate

from langchain.chains import LLMChain

# 初始化GPT-4(需配置OpenAI API Key)

llm = ChatOpenAI(model_name="gpt-4", temperature=0.3)

# 提示词模板

prompt = ChatPromptTemplate.from_template("""

根据需求和规则结果生成架构描述:

【需求】{structured_demand}

【规则结果】{rule_results}

【输出】按数据层→模型层→服务层→部署层分层描述组件、技术选型和关系。

""")

# 输入数据

structured_demand = "实时处理用户评论,延迟<1秒,准确率>95%"

rule_results = "组件:Kafka、Flink;部署模式:边缘计算"

# 生成架构描述

chain = LLMChain(llm=llm, prompt=prompt)

architecture = chain.run(structured_demand=structured_demand, rule_results=rule_results)

print("AI生成的架构描述:\n", architecture)

输出(简化版):

数据层:Kafka(消息队列)接收评论数据流,支持100万条/日吞吐量;

模型层:BERT-base微调模型(ONNX轻量化部署),推理延迟<500ms;

服务层:Flink流处理引擎实时调用模型服务;

部署层:边缘计算节点部署,确保延迟<1秒。

步骤四:自动化架构文档生成与可视化——让架构“看得见”

为什么要做?

生成的架构描述需转化为直观图表和文档,方便团队评审和落地。

怎么做?

用Diagrams库根据架构组件绘制系统架构图。

代码示例:用Diagrams绘制架构图

from diagrams import Diagram, Cluster

from diagrams.onprem.message_broker import Kafka

from diagrams.onprem.stream_processing import Flink

from diagrams.saas.analytics import TensorFlow

with Diagram("用户评论情感分类架构", show=False, direction="LR"):

user = "用户(提交评论)"

with Cluster("数据层"):

kafka = Kafka("Kafka\n消息队列")

with Cluster("服务层"):

flink = Flink("Flink\n流处理引擎")

with Cluster("模型层"):

model = TensorFlow("BERT-base\n(ONNX部署)")

user >> kafka >> flink >> model # 组件关系连线

输出:生成一张包含用户端、Kafka、Flink、BERT模型的架构图(PNG格式)。

步骤五:验证与优化——让架构“靠得住”

为什么要做?

自动化生成的架构可能存在疏漏,需验证环节确保可行性。

怎么做?

- 规则校验:检查架构是否满足需求约束(如“边缘部署是否满足延迟<1秒”);

- 人工评审:收集反馈优化规则库和模型。

进阶探讨 (Advanced Topics)

混合驱动映射:规则+机器学习模型的融合

当规则库复杂到难以维护,可训练“需求-架构”映射模型:用历史需求-架构对训练BERT分类模型预测组件,规则用于兜底明确约束。

实时架构调整:需求变化时的动态映射

监听需求文档变更(如Git提交),触发自动化映射流程生成新架构,用ArchUnit对比差异,辅助决策是否接受变更。

可解释性增强:让AI的“架构决策”可追溯

要求大模型输出“决策依据”(如“选择边缘计算是因为延迟<1秒”),构建“需求-组件”溯源图谱,记录每个组件的映射来源。

总结 (Conclusion)

本文通过“需求结构化→规则库→AI映射→可视化→验证”五步,构建了需求到架构的自动化映射流程。核心是将“人工经验”与“AI能力”结合,实现了:

- 效率提升:转化时间从“天级”缩短至“分钟级”;

- 一致性保障:跨项目遵循统一规则,减少偏差;

- 知识沉淀:规则库和模型成为可复用资产。

自动化映射不是“取代架构师”,而是让架构师专注于更复杂的创新。未来,随着多模态需求理解和生成式AI发展,这条“奇迹之路”将更加智能!

行动号召 (Call to Action)

如果你在实践中遇到规则库设计、大模型提示词优化的问题,欢迎在评论区留言讨论!如果你已实现自动化映射工具,也期待分享经验(如“如何处理多语言需求”)。让我们一起探索AI应用架构自动化的更多可能! 🚀

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)