一文梳理大模型面试准备策略,希望大伙都能上岸!

各大厂在校招中对大模型岗位候选人的要求可以概括为“基础知识扎实+项目经验深入”,尤其看重候选人将技术应用于实际业务场景的能力。以下是针对大模型岗位校招的全面解析和准备建议。

一、业务部门核心考察维度

大模型面试官一般会从从两个维度评估候选人:基础知识掌握程度和项目实践经验质量。这两个维度缺一不可,尤其是对于没有工作经验的校招生而言,仅靠理论知识很难在激烈竞争中脱颖而出。

当前大模型领域存在基座方向和应用方向的分化,各有特点:

-

基座方向:技术门槛高,薪资和发展空间大,但竞争激烈,适合技术实力强的候选人。

-

应用方向:岗位容量大,入门相对容易,但技术壁垒较低,需谨慎选择C端助手类项目。

大模型基座方向要求很高,坑位也比较少,对于有实力的候选人,优先考虑基座方向;对于简历背景一般的同学,可从应用方向入手,逐步向基座方向转型。

大模型应用方向更强调技术的实用性和业务落地能力。企业招聘目的是解决实际业务问题,因此特别关注候选人能否将大模型技术应用到具体场景中。同时,工程能力是将大模型技术落地的关键,候选人需熟悉PyTorch、TensorFlow等框架,掌握多机多卡训练、模型蒸馏等实用技能。

二、基础知识要求 (必须项)

2.1 大模型架构与训练

-

Transformer进阶:深入理解Multi-head Attention机制、GQA(Grouped Query Attention)优化原理、位置编码(RoPE/SinuPos)设计、LayerNorm与RMSNorm差异,等等。

-

主流模型对比:深入了解LLaMA、Qwen、百川等主流模型的架构特点、架构差异、适用场景以及性能差异。

-

对齐技术栈:RLHF(人类反馈强化学习)的奖励模型设计、DPO(直接偏好优化)的数学推导、KTO(KL散度优化)的实践要点。

2.2 微调与工程实践

-

LoRA技术深度:参数高效微调原理、LoRA秩选择策略、混合精度训练中的显存优化技巧。

-

训练问题排查:过拟合检测(KL散度监控)、Batch Size计算(基于显存/梯度累积)、学习率调度策略(Cosine Annealing vs Warmup)。

-

加速框架原理:vLLM的PagedAttention显存优化、LLama.cpp的量化部署方案、TGI(Text Generation Interface)的流式推理实现。

-

编程技术与框架:熟练掌握Python(必备)和C++(加分),精通PyTorch、TensorFlow以及Hugging Face Transformers、DeepSpeed、Megatron-LM等工具库。

2.3 领域知识储备

-

Prompt工程:Few-shot模板设计、思维链(CoT)拆解、拒绝采样(Rejection Sampling)策略。

-

评估体系:Perplexity、BLEU、ROUGE指标的局限性,人工评估Checklist设计(如安全性、事实一致性)。

三、热门研究方向 (加分项)

当前大模型领域的热门研究方向主要集中在以下几个方面,掌握这些方向可以显著提升竞争力:

3.1 检索增强生成(RAG)

RAG通过结合外部知识库解决模型幻觉和知识时效性问题,是当前企业应用最广泛的技术之一。重点包括动态检索策略、知识更新机制和多源信息融合技术。

-

动态检索策略:基于语义向量的混合检索(ColBERTv2)、上下文感知的检索增强(In-Context RAG)

-

领域适配:医疗知识库的Schema构建、法律文本的实体链接优化

3.2 大模型智能体(Agent)

Agent研究旨在让模型具备自主决策和复杂任务处理能力,是未来AI应用的重要方向。涉及多任务学习、工具调用、长程规划等关键技术。

-

多工具调用:LangChain框架的Tool Calling实现、ReAct范式的工作流设计

-

长程规划:基于蒙特卡洛树搜索(MCTS)的决策优化、自我反思(Self-Reflection)机制

3.3 多模态大模型

文本、图像、视频等多模态融合处理技术需求旺盛,尤其在智能客服、内容创作、医疗诊断等领域有广泛应用前景。

-

跨模态对齐:CLIP架构的对比学习优化、Flamingo模型的多模态交互机制。

-

行业解决方案:工业质检中的CV-NLP联合训练、医疗影像的多模态诊断系统。

3.4 高效训练与推理

包括模型压缩、量化、蒸馏等技术,旨在降低大模型部署和运行成本,是企业降本增效的关键。

-

MoE架构实践:Google Switch Transformer的专家路由策略、稀疏激活场景下的负载均衡。

-

轻量化部署:模型蒸馏(Distillation)的教师-学生架构设计、量化感知训练(QAT)流程。

四、项目经历打造策略

4.1 项目选择与深度挖掘

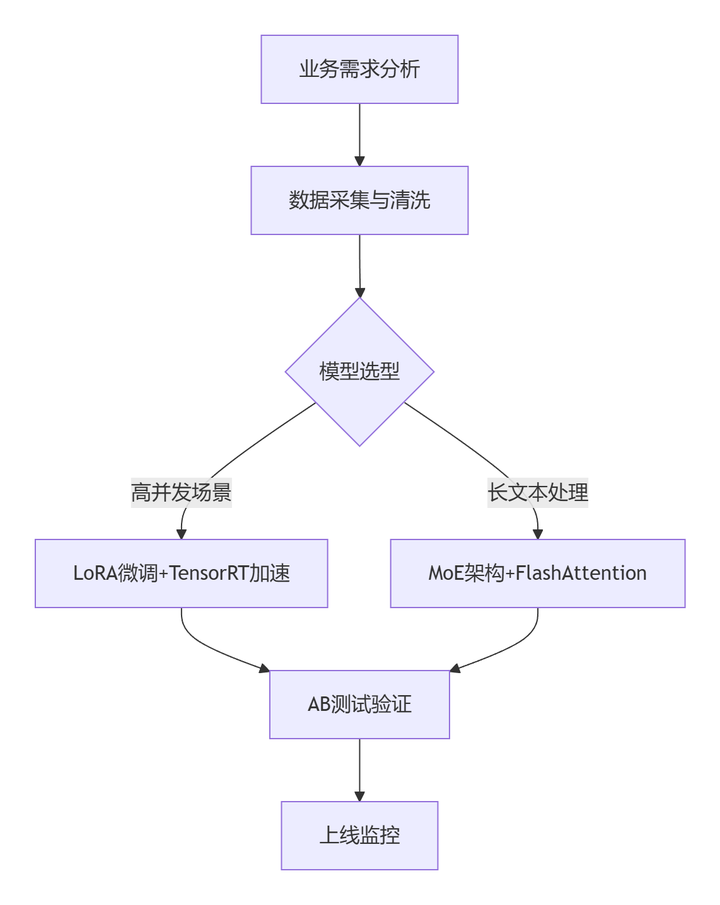

项目经历是大模型校招的必备要素,仅靠Prompt工程的项目已不具备竞争力,必须包含模型微调或训练经历。选择项目时应避免“流水账”式描述,重点突出以下要素:

-

业务背景清晰阐述:明确说明项目要解决的业务问题、目标及价值,用简单易懂的例子说明。

-

实现路径简明扼要:概述技术方案和实现流程,避免过度细节。

-

业务难点深度剖析:这是展现技术洞察力的关键,需详细说明项目中遇到的具体挑战和思考过程。

-

解决方案迭代展示:呈现不同方案的比较和优化过程,体现实战能力和解决问题的思路。

4.2 数据能力凸显

数据处理能力是大模型项目中的差异化竞争力,可以从以下方面展示:

-

数据筛选:展现在去重、均匀化采样(考虑产品分布、问题难易度、正负样本分布等)方面的能力,可结合embedding聚类等高级技术。

-

数据生成:掌握使用大模型自动化生成高质量数据的方法,了解角色扮演、社区扮演等前沿技术。

-

数据检索构建:熟悉GraphRAG等高级检索技术,在项目中合理应用。

项目经历不必追求数量,一到两个深入的项目远比多个浅尝辄止的项目更有价值。难点准备也不需面面俱到,集中精力深入准备一两个核心难点即可。

五、简历优化与面试准备

5.1 简历撰写技巧

-

量化成果:对项目成果进行量化展示,如性能提升百分比、成本降低幅度等,让面试官一目了然看到亮点。

-

❌ "使用LoRA微调模型"

-

✅ "通过LoRA微调+动态掩码,在客服场景实现意图识别准确率92%(+7.3%)"

-

业务匹配:突出与目标岗位相关的项目经历,如智能客服、推荐系统等,提高业务匹配度。

-

技术关键词:合理嵌入大模型相关技术术语,展现专业能力,但避免过度堆砌。

5.2 面试策略

-

基础扎实:保持每天刷LeetCode题目、阅读论文的习惯,夯实算法和理论基础。

-

难点引导:提前准备项目中的难点和解决方案,主动引导面试官朝向自己熟悉的方向深入讨论。

-

业务思维:展现对业务场景的理解能力,而不仅仅是技术实现,这是区别于普通候选人的关键。

六、学习路径与资源

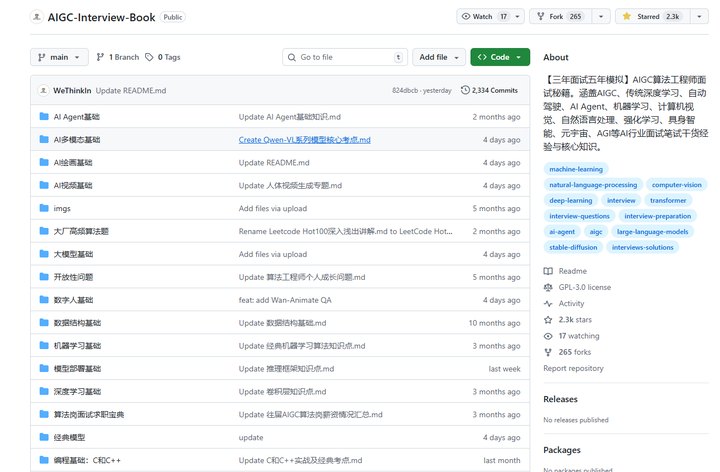

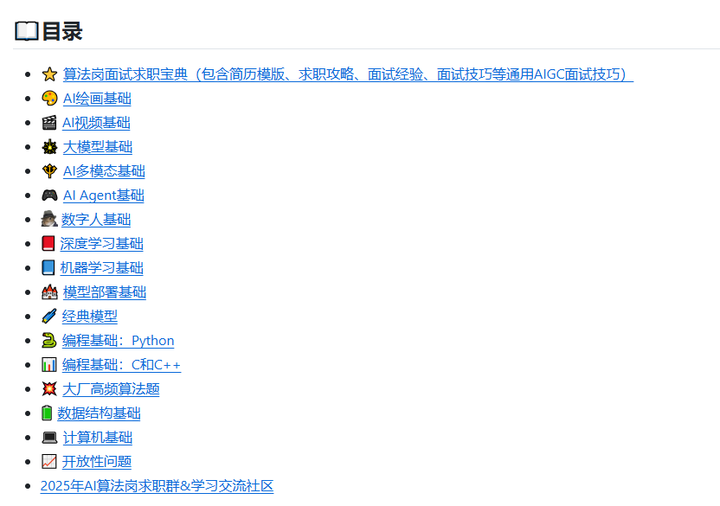

可以参考github开源项目《【三年面试五年模拟】AIGC算法岗/开发岗的面试求职秘籍》:

https://github.com/WeThinkIn/AIGC-Interview-Book![]() https://github.com/WeThinkIn/AIGC-Interview-Book

https://github.com/WeThinkIn/AIGC-Interview-Book

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)