(58页PPT)大语言模型MOSS研发进展某著名企业(附下载方式)

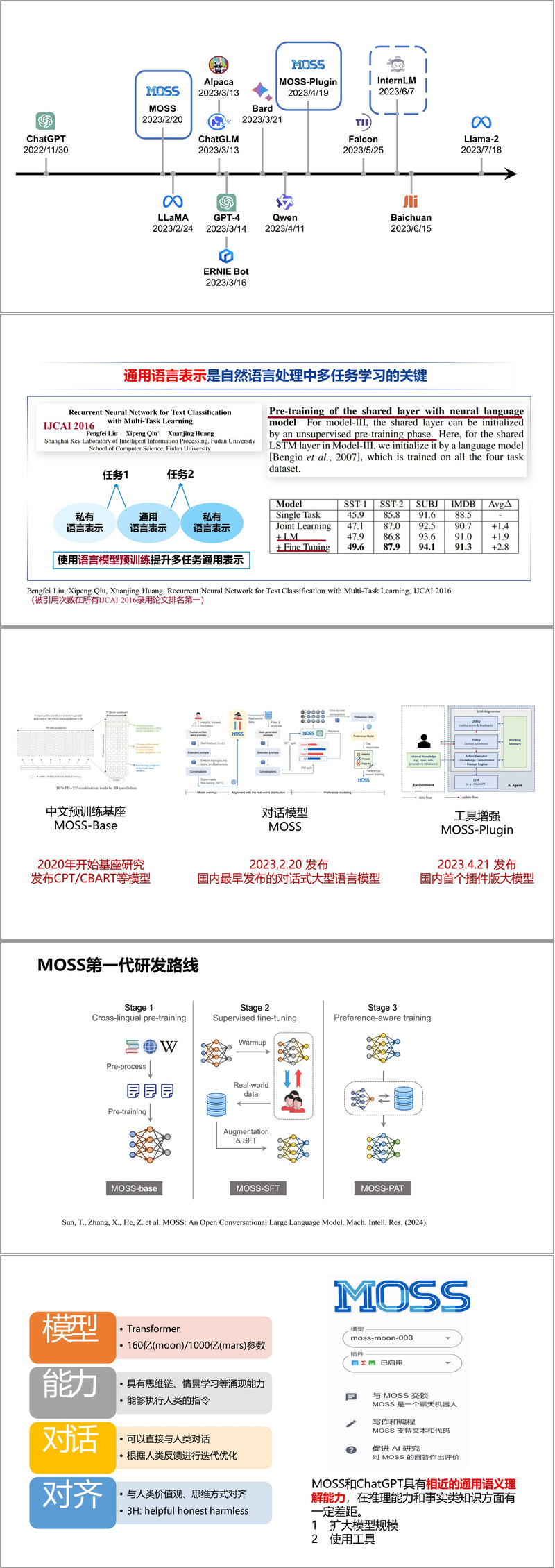

2023年2月,MOSS团队发布了国内首个对话式大型语言模型,标志着其在生成式AI领域的领先地位。同年4月,团队进一步推出插件增强版MOSS-Plugin,支持计算器、搜索引擎、文生图等工具调用,显著提升了模型的实用性。某著名企业MOSS团队在2024年6月发布的《大语言模型MOSS研发进展》报告中,详细阐述了其在大模型技术上的突破与创新。MOSS团队的目标不仅是技术突破,更希望让大模型成为“现代

篇幅所限,本文只提供部分资料内容,完整资料请看下面链接

(58页PPT)大语言模型MOSS研发进展某著名企业.pptx_无线网络游戏设计与实现资源-CSDN下载

资料解读:(58页PPT)大语言模型MOSS研发进展某著名企业

详细资料请看本解读文章的最后内容

近年来,大语言模型(LLM)的快速发展正在重塑人工智能领域的格局。某著名企业MOSS团队在2024年6月发布的《大语言模型MOSS研发进展》报告中,详细阐述了其在大模型技术上的突破与创新。本文将对该报告的核心内容进行深度解读,涵盖MOSS的技术路线、关键能力、训练框架以及未来发展方向。

MOSS的技术演进与核心能力

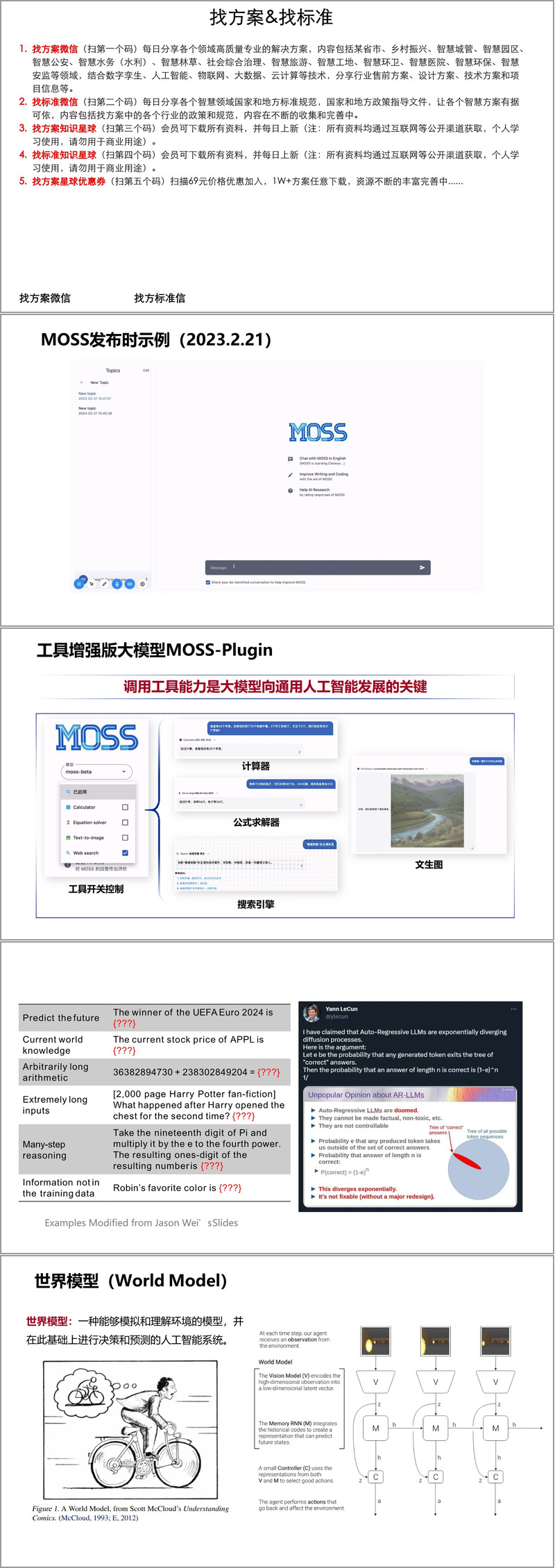

MOSS的研发始于2020年,团队早期专注于中文预训练基座模型(如CPT/CBART)的研究。2023年2月,MOSS团队发布了国内首个对话式大型语言模型,标志着其在生成式AI领域的领先地位。同年4月,团队进一步推出插件增强版MOSS-Plugin,支持计算器、搜索引擎、文生图等工具调用,显著提升了模型的实用性。

报告指出,MOSS 2在能力上实现了显著深化,具备以下核心特性:

- 语言理解与生成能力:MOSS在通用语义理解上接近ChatGPT,但在推理和事实类知识上仍有差距。

- 工具增强:通过插件系统,MOSS可调用外部工具,如代码执行、公式求解等,向通用人工智能(AGI)迈进。

- 人类对齐:采用“3H”原则(Helpful, Honest, Harmless),确保模型输出符合人类价值观。

- 角色扮演与个性化交互:MOSS能模拟特定角色(如《原神》中的可莉),提供生动、个性化的对话体验。

高效训练框架:CoLLiE

训练大规模语言模型面临高昂的算力成本,MOSS团队开发的CoLLiE(高效分布式训练框架)成为关键技术突破。该框架于2023年5月启动,同年12月被EMNLP System Demonstrations收录,并在2024年进一步优化,支持多轮对话训练。

CoLLiE的核心创新包括:

- LOMO优化算法:将梯度计算与参数更新融合,大幅降低显存占用,使得在8张3090 GPU上全参数微调650亿模型成为可能。

- 稀疏注意力机制:通过全局与局部窗口融合的架构,减少计算成本,默认设置下提速70%。

- 数据混合法则:通过小规模实验预测最佳数据配比,优化预训练与后训练效率,避免灾难性遗忘。

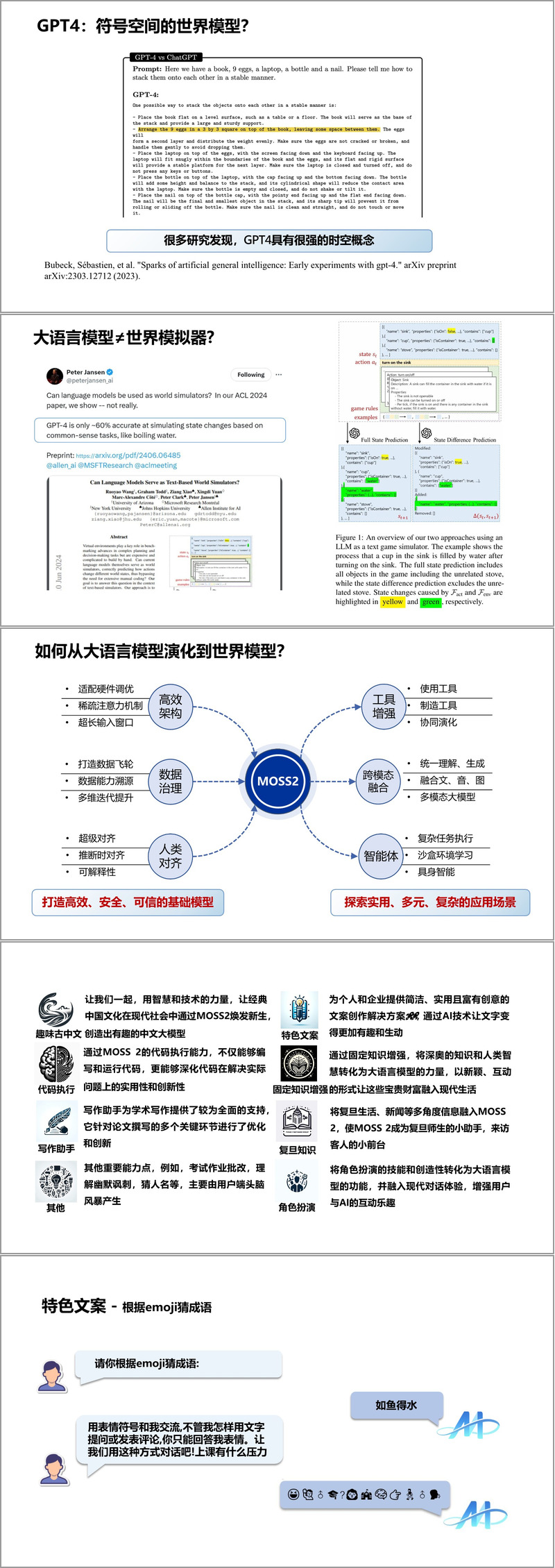

从语言模型到世界模型

报告探讨了大语言模型如何向世界模型(World Model)演进。世界模型能够模拟环境并基于此进行预测与决策,而GPT-4等模型已展现出一定的时空概念理解能力。MOSS团队提出,未来需通过跨模态融合(如图像、语音、视频)和智能体技术,使模型不仅能处理文本,还能理解并生成多模态内容。

在跨模态领域,团队介绍了SpeechGPT和AnyGPT的进展:

- SpeechGPT:将语音离散化为Token,使大模型具备语音理解和生成能力,支持跨模态对话与指令跟随。

- AnyGPT:支持任意模态组合输入输出,如图像+文本生成语音,或视频+语音生成文本,为多模态交互提供新范式。

应用场景与特色功能

MOSS 2在多个垂直领域展现了强大的应用潜力:

- 复旦知识助手:集成校园信息(如图书馆开放时间、ecard使用指南),成为师生及访客的智能前台。

- 写作与创意生成:支持学术论文辅助、小红书风格文案生成,甚至能根据Emoji猜成语(如“🐟💧”对应“如鱼得水”)。

- 儿童教育:通过固定知识增强技术,生成适合5岁儿童的多样性主题绘本,如《小熊宝宝的奇妙之旅》。

未来方向:高效、安全、可信的AGI

报告最后强调,MOSS的未来发展将围绕以下目标:

- 适配硬件调优:优化稀疏注意力机制与超长上下文窗口。

- 数据治理:通过事实记忆容量法则减少模型幻觉。

- 智能体集成:探索复杂环境下的自主决策能力。

MOSS团队的目标不仅是技术突破,更希望让大模型成为“现代经典文化的传播者”,例如通过AI生成趣味古中文,或为企业和个人提供创意文案解决方案。

接下来请您阅读下面的详细资料吧

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)