深度解析:DeepSeek的崛起与真相

在科技的浪潮中,人工智能(AI)一直是备受瞩目的焦点。近期,DeepSeek的出现如同一颗璀璨的新星,引发了全球范围内的广泛关注和热议。然而,在这股热潮中,也存在着诸多误读和误解。今天,就让我们拨开迷雾,深入探究DeepSeek的真实面貌,以及它背后那些被忽视的创新与价值。

深度解析:DeepSeek的崛起与真相

在科技的浪潮中,人工智能(AI)一直是备受瞩目的焦点。近期,DeepSeek的出现如同一颗璀璨的新星,引发了全球范围内的广泛关注和热议。然而,在这股热潮中,也存在着诸多误读和误解。今天,就让我们拨开迷雾,深入探究DeepSeek的真实面貌,以及它背后那些被忽视的创新与价值。

一、DeepSeek的崛起:是偶然还是必然?

(一)“神秘力量”背后的真相

DeepSeek,这家成立于2023年的年轻大模型公司,以其惊人的崛起速度和独特的技术路径,成为了众多媒体和公众眼中的“神秘力量”。它的母公司幻方量化,主业为量化投资,这让很多人感到不解:为何中国领先的AI公司会出自一家私募?难道真的是“乱拳打死老师傅”?

然而,事实并非如此。早在2017年底,幻方量化就已经将AI模型计算应用于几乎所有的量化策略。当时,AI领域正处于深度学习浪潮的高峰期,幻方量化紧跟前沿,其深度学习训练平台“萤火二号”在2019年已经搭载了约1万张英伟达A100显卡。这1万卡是自训大模型的算力门槛,尽管不能等同于DeepSeek的资源,但足以说明幻方量化在大模型领域早已布局,比许多互联网大厂更早拿到了入场券。

(二)“小力出奇迹”的真相

DeepSeek-V3模型的训练成本约为558万美元,不到OpenAI GPT-4模型的十分之一,但性能却已接近。这一事实被许多人解读为DeepSeek颠覆了AI行业信奉的“规模定律”。然而,真相并非如此简单。

DeepSeek在V3模型技术报告中明确指出,这558万美元的成本并不包括与架构、算法或数据相关的前期研究和消融实验的成本。多位AI行业专家和从业者表示,DeepSeek并没有改变行业规律,而是采用了“更聪明”的算法和架构,从而节约资源、提高效率。这种创新的算法和架构,才是DeepSeek能够在有限的资源下取得优异性能的关键。

(三)“英伟达护城河消失”的真相

DeepSeek在论文中提到,采用定制的PTX(并行线程执行)语言编程,能够更好地释放底层硬件的性能。这被一些人解读为DeepSeek“绕开英伟达CUDA运算平台”。然而,PTX语言实际上是由英伟达开发的,属于CUDA生态的一部分。DeepSeek的做法虽然能够激发硬件的性能,但如果更换目标任务,则需要重写程序,工作量非常大。

(四)“老外被打服了”的真相

1月31日,一夜之间,英伟达、微软、亚马逊等海外AI巨头都接入了DeepSeek。这引发了“中国AI反超美国”“OpenAI的时代结束了”“AI算力需求就此消失”等论断。然而,这些论断大多是误读。实际上,这些企业只是将DeepSeek的模型部署在自家的云服务上。用户按需付费给云服务厂商,获得更稳定的体验及更高效的工具,这是一种双赢的合作模式。

二、DeepSeek的技术创新与开源精神

(一)推理范式的创新

当用户使用DeepSeek的App或者网页版时,点击“深度思考(R1)”按钮,就会展现DeepSeek-R1模型完整的思考过程。这种全新的体验让用户仿佛看到了一个“人”在思考——一边头脑风暴,一边在草稿纸上速记。例如,当用户问:

“A大学和清华大学哪个更好?”

DeepSeek第一次回答:“清华大学。”

用户追问:“我是A大学生,请重新回答。”

DeepSeek回答:“A大学好。”

这组对话引发了“AI竟然懂人情世故”的惊叹。

然而,推理范式并非DeepSeek首创。OpenAI的o1模型才是推理范式的开创者。但与DeepSeek-R1模型不同,OpenAIo1模型既不开源,也不公布技术细节,收费非常高,因此难以让全球用户感受到深度思考带来的震撼。清华大学长聘副教授、面壁智能首席科学家刘知远认为,DeepSeek-R1模型的成功,与OpenAI的错误决策有很大关系。

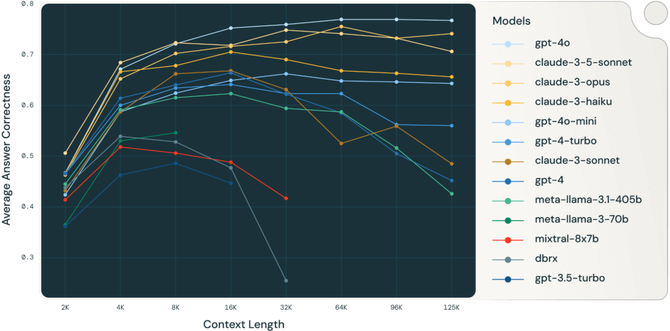

从技术上来说,当前大模型的常规范式有两种:预训练模型与推理模型。更为大众熟知的OpenAI GPT系列以及DeepSeek-V3模型都属于预训练模型。而OpenAIo1与DeepSeek-R1则属于推理模型,这是一种新的范式,即模型会自己通过思维链逐步分解复杂问题,一步步反思,再得到相对准确并且富有洞察力的结果。从事AI研究数十年的郭成凯认为,推理范式是一条相对容易“弯道超车”的赛道。推理作为一种新范式,迭代快,更容易实现小计算量下的显著提升。前提是有强大的预训练模型,通过强化学习可以深度挖掘出大规模预训练模型的潜力,逼近推理范式下大模型能力的天花板。

(二)开源精神的践行

一直以来,DeepSeek被广泛讨论的焦点是其“低成本”。从2024年5月DeepSeek-V2模型发布以来,这家公司就被调侃为“AI届拼多多”。《自然》杂志发文称,Meta训练其最新人工智能模型Llama3.1405B耗资超过6000万美元,而DeepSeek-V3训练只花了不到十分之一。这表明,高效利用资源比单纯的计算规模更重要。

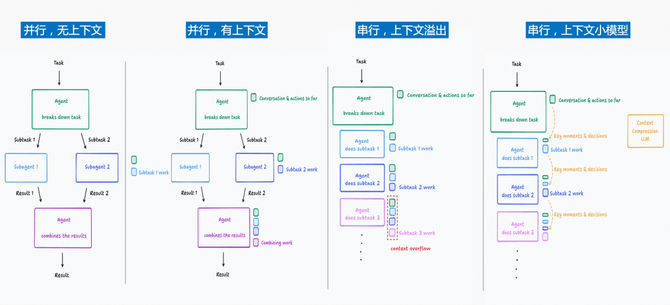

然而,在成本之外,DeepSeek的独特技术路径、算法创新及开源的诚意,才是让AI行业人士更加振奋的原因。郭成凯介绍,当前的许多方法依赖大模型经典训练方式,如监督微调(SFT)等,这需要大量标注数据。DeepSeek提出了一种新方法,即通过大规模强化学习(RL)方法提升推理能力,相当于开辟了新的研究方向。此外,多头潜在注意力(MLA)是DeepSeek大幅降低推理成本的关键创新,大幅降低了推理成本。

清华大学教授、清程极智首席科学家翟季冬认为,DeepSeek最让他印象深刻的是混合专家架构(MoE)的创新,每一层有256个路由专家、1个共享专家。之前的研究有Auxiliary Loss(辅助损失)的算法,会使梯度发生扰动,影响模型收敛。DeepSeek提出LossFree方式,既能让模型有效收敛,同时还能实现负载均衡。翟季冬强调:“DeepSeek团队比较敢于创新。我觉得不完全追随国外的策略、有自己的思考,非常重要。”

更让AI从业者兴奋的是,DeepSeek“诚意满满”的开源,为已经略有颓势的开源社区注入了一剂“强心针”。在此之前,开源社区最有力的支柱是Meta的4000亿参数模型Llama3。但不少开发者体验后仍觉得,Llama3与闭源的GPT-4等模型相距至少一代,“几乎让人失去信心”。然而,DeepSeek的开源做了3件事,重新给了开发者以信心:

- **直接开源了671B的模型**,并发布了多个流行架构下的蒸馏模型,相当于“好老师教出更多好学生”。

- **发布的论文及技术报告包含大量技术细节**。V3模型和R1模型的论文分别长达50页和150页,被称为开源社区里“最详细的技术报告”。这意味着拥有相似资源的个人

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)