提示工程容灾备份策略的应急预案:架构师教你写专业的应急响应文档(模板)

目的:规范提示工程容灾备份的应急响应流程,确保在发生故障时快速恢复服务,最小化业务影响。范围:适用于所有基于大模型的AI服务中的提示工程环节,包括提示模板、动态提示、生成结果日志等资产的容灾备份。适用人员指挥组(架构师、项目经理):负责整体指挥与决策;技术组(开发工程师、DevOps工程师):负责故障排查与服务恢复;沟通组(产品经理、客服):负责内部与外部沟通;恢复组(测试工程师、数据工程师):负

提示工程容灾备份策略与应急响应文档编写指南:架构师的实战模板

一、引言:为什么提示工程需要容灾备份?

在AI驱动的业务场景中,提示工程是连接用户需求与大模型能力的核心桥梁。无论是电商AI客服的个性化回复、医疗辅助诊断的提示引导,还是代码生成工具的指令设计,提示模板、动态生成逻辑、用户反馈数据等资产直接决定了AI服务的质量与稳定性。

然而,随着AI应用的规模化,提示工程面临的风险也日益凸显:

- 服务中断:提示生成服务宕机,导致大模型无法接收有效指令,业务完全停滞;

- 数据丢失:提示模板被误删、生成结果日志损坏,无法追溯AI决策过程;

- 合规风险:用户隐私数据(如动态提示中的用户输入)泄露,违反GDPR、CCPA等法规;

- 依赖故障:大模型API服务商(如OpenAI)中断,导致提示无法正常调用。

这些风险一旦发生,可能给企业带来巨大的经济损失(如电商平台订单流失)、品牌声誉损害(如医疗AI诊断错误)甚至法律责任。因此,建立完善的提示工程容灾备份策略与应急响应机制,是AI项目架构设计中不可忽视的一环。

二、核心概念:提示工程容灾的底层逻辑

在设计容灾备份策略前,需明确两个关键概念:提示工程资产分类与容灾目标(RTO/RPO)。

1. 提示工程资产分类

提示工程的核心资产可分为四类,每类资产的容灾优先级与备份策略不同:

| 资产类型 | 定义 | 示例 | 容灾优先级 |

|---|---|---|---|

| 提示模板 | 固定或半固定的指令框架,用于引导大模型生成符合业务需求的结果。 | 电商客服:"用户投诉快递延迟,需道歉并提供补偿方案,补偿金额不超过订单金额的5%" |

高 |

| 动态提示 | 结合用户实时数据(如历史对话、订单信息)生成的个性化指令。 | 金融推荐:"用户最近3个月购买了基金A和股票B,推荐风险等级为中低的理财产品" |

中 |

| 生成结果日志 | 大模型根据提示生成的结果记录,包含用户请求、提示内容、模型输出。 | {"user_query": "快递延迟", "prompt": "...", "model_output": "抱歉,我们将为您补偿10元优惠券"} |

高 |

| 用户反馈数据 | 用户对AI输出的评价(如“有用”/“无用”),用于优化提示效果。 | {"prompt_id": "123", "user_rating": 5, "comment": "补偿方案很满意"} |

中 |

2. 容灾目标:RTO与RPO

容灾备份的核心目标是最小化业务中断时间(RTO)与数据丢失量(RPO)。

- RTO(Recovery Time Objective,恢复时间目标):故障发生后,服务恢复正常的最长允许时间。例如,核心提示模板的RTO应≤10分钟,确保业务不会长时间停滞。

- RPO(Recovery Point Objective,恢复点目标):故障发生后,数据丢失的最长允许时间(即最后一次备份到故障发生的时间间隔)。例如,生成结果日志的RPO应≤5分钟,确保不会丢失关键的用户交互数据。

示例:不同资产的RTO/RPO设定

| 资产类型 | RTO目标 | RPO目标 | 备份策略 |

|---|---|---|---|

| 提示模板 | ≤10分钟 | ≤1分钟 | 全量+增量备份(每天全量,每小时增量) |

| 动态提示 | ≤30分钟 | ≤5分钟 | 增量备份(每5分钟一次) |

| 生成结果日志 | ≤20分钟 | ≤5分钟 | 实时同步(分布式日志系统) |

| 用户反馈数据 | ≤60分钟 | ≤10分钟 | 批量备份(每10分钟一次) |

三、提示工程容灾备份策略设计:从数据到链路的全链路防护

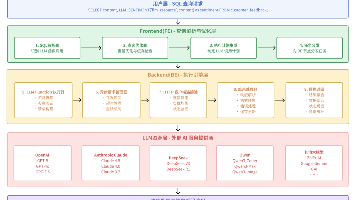

容灾备份策略需覆盖数据层(资产备份)、链路层(流程冗余)、架构层(多活部署)三个维度,形成“备份-冗余-恢复”的闭环。

1. 数据层:资产备份策略

数据是提示工程的核心,备份策略需解决“备份什么”“怎么备份”“备份到哪里”三个问题。

(1)备份类型选择

- 全量备份:复制整个资产目录(如提示模板文件夹),适用于变化较少的资产(如提示模板)。优点是恢复速度快,缺点是占用存储空间大。

- 增量备份:仅复制自上次备份以来变化的数据(如新增的动态提示),适用于变化频繁的资产(如生成结果日志)。优点是存储空间小,缺点是恢复时需要全量备份+所有增量备份,流程复杂。

- 差异备份:复制自上次全量备份以来变化的数据,介于全量与增量之间,适用于中等变化频率的资产(如用户反馈数据)。

(2)备份存储方案

- 本地存储:用于快速恢复(如服务器本地磁盘),优点是访问速度快,缺点是无法抵御本地故障(如服务器宕机)。

- 异地存储:用于容灾(如AWS S3、阿里云OSS、MinIO分布式存储),优点是能抵御区域故障(如地震、火灾),缺点是恢复速度较慢。

最佳实践:采用“本地+异地”双备份架构,例如:

- 提示模板:每天全量备份到本地磁盘,每小时增量备份到异地OSS;

- 生成结果日志:通过ELK Stack实时同步到分布式日志系统(本地),并定期同步到异地S3。

(3)备份验证

备份的有效性需要定期验证,避免“备份了但无法恢复”的情况。验证方法包括:

- 定期恢复测试:每月从异地备份恢复提示模板,检查是否完整;

- 校验和验证:对备份文件计算MD5或SHA-256哈希值,确保传输过程中未损坏;

- 自动化验证脚本:编写脚本定期检查备份文件的存在性与完整性(示例代码见下文“项目实战”部分)。

2. 链路层:流程冗余设计

提示工程的流程链路通常为:用户请求→提示生成服务→大模型API→结果返回→日志存储。每个环节都需要冗余设计,避免单点故障。

(1)提示生成服务冗余

- 多实例部署:通过Kubernetes、Docker Compose等工具部署多个提示生成服务实例,通过负载均衡(如Nginx、Istio)分配流量。例如,部署3个实例,当1个实例宕机时,剩余2个实例可继续处理请求。

- 自动扩容:通过监控系统(如Prometheus)监测服务的CPU、内存使用情况,当负载超过阈值时,自动增加实例数量(如Kubernetes的HPA:Horizontal Pod Autoscaler)。

(2)大模型API冗余

- 多服务商对接:同时对接多个大模型API(如OpenAI、Anthropic、Google PaLM),通过熔断机制(如Sentinel、Hystrix)实现故障切换。例如,当OpenAI API中断时,自动切换到Anthropic API,确保提示能正常调用。

- API密钥管理:将多服务商的API密钥存储在安全的配置中心(如Apollo、Nacos),避免硬编码到代码中,便于快速切换。

(3)日志存储冗余

- 分布式日志系统:使用ELK Stack(Elasticsearch、Logstash、Kibana)或Grafana Loki存储生成结果日志,实现多节点冗余。例如,Elasticsearch集群的分片与副本机制,确保日志数据不会因单个节点故障而丢失。

3. 架构层:多活部署架构

对于高可用的AI服务(如电商客服、医疗诊断),需采用多区域多活架构,将提示工程链路部署在多个地理区域(如北京、上海、深圳),当一个区域故障时,流量自动切换到其他区域。

(1)多活架构设计

多活架构的核心是流量路由与数据同步:

- 流量路由:通过DNS负载均衡(如阿里云DNS、Cloudflare)将用户请求分配到最近的区域;当某区域故障时,DNS自动将流量切换到其他区域。

- 数据同步:提示模板、用户反馈数据等需要在多个区域之间同步(如使用Redis Cluster、MySQL主从复制),确保各区域的资产一致。

(2)多活架构示意图(Mermaid)

四、应急响应文档编写:架构师的实战模板

应急响应文档是容灾备份策略的落地载体,需明确谁来做“做什么”“怎么做”,确保在故障发生时快速响应。以下是一份专业的应急响应文档模板,涵盖核心内容与示例。

1. 文档概述

目的:规范提示工程容灾备份的应急响应流程,确保在发生故障时快速恢复服务,最小化业务影响。

范围:适用于所有基于大模型的AI服务中的提示工程环节,包括提示模板、动态提示、生成结果日志等资产的容灾备份。

适用人员:

- 指挥组(架构师、项目经理):负责整体指挥与决策;

- 技术组(开发工程师、DevOps工程师):负责故障排查与服务恢复;

- 沟通组(产品经理、客服):负责内部与外部沟通;

- 恢复组(测试工程师、数据工程师):负责记录与验证。

2. 术语定义

| 术语 | 定义 |

|---|---|

| 提示资产 | 提示模板、动态提示、生成结果日志、用户反馈数据的统称。 |

| RTO | 故障发生后,服务恢复正常的最长允许时间。 |

| RPO | 故障发生后,数据丢失的最长允许时间。 |

| 容灾链路 | 提示工程的流程链路:用户请求→提示生成服务→大模型API→结果返回→日志存储。 |

3. 应急组织架构

| 角色 | 职责 |

|---|---|

| 指挥组 | 1. 评估故障影响,决策启动预案;2. 调配资源,协调各团队;3. 批准复盘报告。 |

| 技术组 | 1. 排查故障原因;2. 实施恢复措施;3. 提交技术分析报告。 |

| 沟通组 | 1. 通知内部团队(产品、研发、客服);2. 向用户发布故障公告;3. 收集用户反馈。 |

| 恢复组 | 1. 记录故障信息(时间、原因、处理过程);2. 验证服务恢复状态;3. 参与复盘会。 |

4. 应急场景分类与触发条件

| 场景类型 | 触发条件 | 影响程度 |

|---|---|---|

| 提示服务中断 | 监控系统报警提示生成服务宕机(实例数量≤0),且RTO超过10分钟。 | 高 |

| 提示数据泄露 | 发现提示模板或生成结果日志被未授权访问(如异常IP访问日志存储)。 | 高 |

| 生成结果异常 | 10分钟内用户反馈AI回复不符合预期的数量超过100条(如“回复与问题无关”)。 | 中 |

| 大模型API故障 | 大模型API调用失败率超过50%(如OpenAI API返回503错误),持续时间超过5分钟。 | 高 |

5. 应急响应流程(时序图)

6. 具体场景应急预案(示例:提示服务中断)

场景名称:提示服务中断

触发条件:监控系统报警提示生成服务宕机(实例数量≤0),且RTO超过10分钟。

处理步骤:

| 步骤 | 操作内容 | 责任人员 | 工具/文档 |

|---|---|---|---|

| 1 | 登录监控系统(Prometheus),查看提示服务的实例状态、资源使用情况(内存、CPU)。 | 技术组 | Prometheus、Grafana |

| 2 | 如果是实例宕机,执行kubectl scale deployment prompt-service --replicas=3启动备用实例;如果是资源不足,执行kubectl edit deployment prompt-service调整内存配额。 |

技术组 | Kubernetes CLI |

| 3 | 调用测试接口(如/api/generate-prompt),传入测试数据,验证提示生成是否符合预期。 |

技术组 | Postman、curl |

| 4 | 向指挥组报告故障已修复,包括恢复时间、原因、影响范围(如“15分钟内1200个用户请求失败”)。 | 技术组 | 故障报告模板 |

| 5 | 沟通组通过APP弹窗、短信等方式告知用户服务恢复,同时通知内部团队(产品、客服)。 | 沟通组 | 故障通知模板 |

| 6 | 恢复组记录故障信息:故障开始时间、结束时间、原因、处理过程、影响范围。 | 恢复组 | 故障记录模板 |

| 7 | 复盘会分析根因(如内存泄漏),提出改进措施(如优化代码、增加内存),更新应急响应文档。 | 指挥组 | 复盘报告模板 |

7. 恢复验证流程

| 验证项 | 验证方法 | 责任人员 | 验收标准 |

|---|---|---|---|

| 提示生成服务 | 调用测试接口,传入测试数据,检查返回的提示是否符合预期(如“快递延迟”的提示是否包含道歉与补偿方案)。 | 技术组 | 提示内容正确,响应时间≤2秒 |

| 大模型API调用 | 检查大模型API的调用日志(如OpenAI的completions接口),确认返回状态码为200。 |

技术组 | 调用成功率≥99% |

| 生成结果日志 | 检查ELK日志系统,确认生成结果包含用户请求、提示内容、模型输出(如{"user_query": "快递延迟", "prompt": "...", "model_output": "..."})。 |

恢复组 | 日志完整,无缺失 |

| 用户反馈 | 查看客服系统,确认1小时内无新的用户反馈异常(如“AI回复错误”)。 | 沟通组 | 用户反馈异常率≤1% |

8. 复盘与改进

- 复盘会时间:故障恢复后24小时内。

- 复盘内容:

- 故障原因(如内存泄漏、API中断);

- 处理过程中的问题(如恢复时间超过RTO、沟通不及时);

- 改进措施(如优化代码、增加冗余、调整监控阈值)。

- 输出文档:《故障复盘报告》,包含以下内容:

# 故障复盘报告(提示服务中断) ## 1. 故障基本信息 - 故障时间:2024-05-10 14:00-14:15(持续15分钟) - 故障类型:提示服务中断 - 影响范围:1200个用户请求失败,订单流失约5万元 ## 2. 故障原因分析 - 直接原因:提示生成服务实例因内存溢出宕机(实例内存配置为2GB,实际使用达到2.5GB)。 - 根本原因:提示生成代码中存在内存泄漏(循环引用未释放),导致内存占用逐渐增加。 ## 3. 处理过程 - 14:00:监控系统报警(提示服务实例数量=0)。 - 14:05:技术组登录Kubernetes,发现实例宕机,启动备用实例(`kubectl scale --replicas=3`)。 - 14:10:验证提示生成服务正常(调用测试接口返回正确结果)。 - 14:15:沟通组发布服务恢复通知。 ## 4. 改进措施 - 短期(1天内):将提示服务实例内存从2GB增加到4GB,避免再次宕机。 - 中期(3天内):优化提示生成代码,修复内存泄漏(使用Python的`gc`模块检测循环引用)。 - 长期(1周内):增加内存监控报警阈值(当内存使用超过80%时触发报警),提前预警。 ## 5. 责任到人 - 代码优化:张三(开发工程师),完成时间:2024-05-13。 - 内存调整:李四(DevOps工程师),完成时间:2024-05-11。 - 监控调整:王五(SRE工程师),完成时间:2024-05-12。

五、项目实战:提示工程容灾备份代码示例

1. 提示模板备份脚本(Python)

以下脚本实现了提示模板的全量+增量备份,支持本地与异地存储(以阿里云OSS为例)。

import os

import shutil

import hashlib

from datetime import datetime

from aliyunsdkcore.client import AcsClient

from aliyunsdkoss.request.v20190517 import PutObjectRequest

# 配置参数

PROMPT_DIR = "/path/to/prompt/templates" # 提示模板目录

LOCAL_BACKUP_DIR = "/path/to/local/backup" # 本地备份目录

OSS_BUCKET = "my-prompt-backup" # OSS bucket名称

OSS_ENDPOINT = "oss-cn-beijing.aliyuncs.com" # OSS endpoint

ACCESS_KEY_ID = "your-access-key-id" # 阿里云AccessKey ID

ACCESS_KEY_SECRET = "your-access-key-secret" # 阿里云AccessKey Secret

# 初始化OSS客户端

client = AcsClient(ACCESS_KEY_ID, ACCESS_KEY_SECRET, OSS_ENDPOINT)

def calculate_md5(file_path):

"""计算文件的MD5哈希值,用于验证备份完整性"""

md5 = hashlib.md5()

with open(file_path, "rb") as f:

for chunk in iter(lambda: f.read(4096), b""):

md5.update(chunk)

return md5.hexdigest()

def backup_full():

"""全量备份:每天执行一次"""

# 生成备份文件名(全量+日期)

backup_filename = f"prompt_full_{datetime.now().strftime('%Y%m%d')}.zip"

local_backup_path = os.path.join(LOCAL_BACKUP_DIR, backup_filename)

# 压缩提示模板目录

shutil.make_archive(local_backup_path.replace(".zip", ""), "zip", PROMPT_DIR)

# 上传到OSS

with open(local_backup_path, "rb") as f:

request = PutObjectRequest.PutObjectRequest()

request.set_BucketName(OSS_BUCKET)

request.set_ObjectName(backup_filename)

request.set_FileContent(f)

response = client.do_action_with_exception(request)

# 验证备份完整性(本地与OSS的MD5是否一致)

local_md5 = calculate_md5(local_backup_path)

oss_md5 = response.headers.get("ETag").strip('"')

if local_md5 != oss_md5:

raise Exception(f"全量备份失败:MD5校验不通过(本地:{local_md5},OSS:{oss_md5})")

print(f"全量备份完成:{local_backup_path} → OSS:{OSS_BUCKET}/{backup_filename}")

def backup_incremental():

"""增量备份:每小时执行一次"""

# 获取上次全量备份的时间(假设全量备份文件名格式为prompt_full_20240510.zip)

full_backups = [f for f in os.listdir(LOCAL_BACKUP_DIR) if f.startswith("prompt_full_")]

if not full_backups:

raise Exception("未找到全量备份文件,无法执行增量备份")

last_full_backup = max(full_backups, key=lambda x: datetime.strptime(x.split("_")[-1].replace(".zip", ""), "%Y%m%d"))

last_full_time = datetime.strptime(last_full_backup.split("_")[-1].replace(".zip", ""), "%Y%m%d")

# 收集自上次全量备份以来变化的文件(修改时间≥last_full_time)

incremental_files = []

for root, dirs, files in os.walk(PROMPT_DIR):

for file in files:

file_path = os.path.join(root, file)

modify_time = datetime.fromtimestamp(os.path.getmtime(file_path))

if modify_time >= last_full_time:

incremental_files.append(file_path)

if not incremental_files:

print("无增量文件需要备份")

return

# 生成增量备份文件名(增量+时间)

incremental_filename = f"prompt_incremental_{datetime.now().strftime('%Y%m%d%H%M%S')}.zip"

local_incremental_path = os.path.join(LOCAL_BACKUP_DIR, incremental_filename)

# 压缩增量文件

with shutil.ZipFile(local_incremental_path, "w") as zipf:

for file in incremental_files:

arcname = os.path.relpath(file, PROMPT_DIR) # 保持目录结构

zipf.write(file, arcname)

# 上传到OSS

with open(local_incremental_path, "rb") as f:

request = PutObjectRequest.PutObjectRequest()

request.set_BucketName(OSS_BUCKET)

request.set_ObjectName(incremental_filename)

request.set_FileContent(f)

client.do_action_with_exception(request)

print(f"增量备份完成:{local_incremental_path} → OSS:{OSS_BUCKET}/{incremental_filename}(包含{len(incremental_files)}个文件)")

if __name__ == "__main__":

# 可通过定时任务(如cron)执行:每天0点执行全量备份,每小时执行增量备份

# 例如:0 0 * * * python backup.py full

# 0 * * * * python backup.py incremental

import sys

if len(sys.argv) != 2:

print("用法:python backup.py [full|incremental]")

sys.exit(1)

if sys.argv[1] == "full":

backup_full()

elif sys.argv[1] == "incremental":

backup_incremental()

else:

print("无效的参数:必须是full或incremental")

sys.exit(1)

2. 提示生成服务冗余部署(Docker Compose)

以下示例使用Docker Compose部署3个提示生成服务实例,并通过Nginx负载均衡,实现链路冗余。

(1)docker-compose.yml

version: '3.8'

services:

# 提示生成服务(3个实例)

prompt-service:

image: my-prompt-service:v1.0.0 # 自定义的提示生成服务镜像

container_name: prompt-service

ports:

- "8000" # 不映射到主机端口,由Nginx转发

environment:

- MODEL_API_KEYS=openai:sk-xxx,anthropic:sk-xxx,google:palm-xxx # 多模型API密钥

- LOG_DIR=/var/log/prompt-service

volumes:

- ./logs:/var/log/prompt-service

deploy:

replicas: 3 # 3个实例,实现冗余

restart_policy:

condition: on-failure # 故障时自动重启

# Nginx负载均衡

nginx:

image: nginx:latest

container_name: nginx

ports:

- "80:80" # 映射到主机80端口,接收用户请求

volumes:

- ./nginx.conf:/etc/nginx/nginx.conf # 挂载Nginx配置文件

depends_on:

- prompt-service # 依赖提示生成服务

(2)nginx.conf

events {

worker_connections 1024;

}

http {

# upstream定义:指向3个提示生成服务实例

upstream prompt_servers {

server prompt-service:8000; # Docker Compose自动解析服务名称

server prompt-service:8000;

server prompt-service:8000;

}

server {

listen 80;

server_name localhost;

location / {

proxy_pass http://prompt_servers; # 转发到upstream

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

}

(3)启动服务

执行以下命令启动服务:

docker-compose up -d

启动后,Nginx会将用户请求(http://localhost:80)均衡分配到3个提示生成服务实例,实现链路冗余。

六、工具与资源推荐

1. 备份与存储工具

- 本地备份:

rsync(Linux)、robocopy(Windows); - 异地存储:AWS S3、阿里云OSS、MinIO(开源分布式存储);

- 备份验证:

md5sum(Linux)、CertUtil(Windows)、Python的hashlib模块。

2. 监控与报警工具

- 系统监控:Prometheus( metrics 收集)、Grafana(可视化);

- 日志监控:ELK Stack(Elasticsearch、Logstash、Kibana)、Grafana Loki(轻量级日志存储);

- 报警工具:Alertmanager(Prometheus配套)、Zabbix(综合监控)、钉钉/飞书机器人(通知)。

3. 服务冗余与负载均衡工具

- 容器编排:Kubernetes(生产环境)、Docker Compose(开发环境);

- 负载均衡:Nginx(七层负载均衡)、HAProxy(四层负载均衡)、Istio(服务网格,支持流量治理);

- 熔断与降级:Sentinel(阿里开源)、Hystrix(Netflix开源,已停止维护)、Resilience4j(替代Hystrix)。

4. 大模型API管理工具

- 多服务商对接:LangChain(支持OpenAI、Anthropic、Google PaLM等)、LlamaIndex(数据驱动的提示工程);

- API密钥管理:Apollo(阿里开源配置中心)、Nacos(阿里开源服务发现与配置中心)、HashiCorp Vault( secrets 管理)。

七、未来趋势与挑战

1. 未来趋势

- AI原生容灾:利用大模型自动生成应急响应流程(如根据故障类型推荐处理步骤)、预测故障(如通过历史数据预测提示服务宕机风险);

- 联邦学习与提示工程:通过联邦学习实现多区域提示模型的联合训练,避免单点故障(如某区域的提示模型故障时,可切换到其他区域的模型);

- 合规驱动的容灾:随着AI法规(如欧盟AI法案)的完善,容灾备份需满足数据本地化、加密存储、访问审计等要求(如提示模板中的用户数据需加密备份)。

2. 挑战

- 成本问题:多活架构、异地备份等容灾策略会增加 infrastructure 成本(如服务器、存储、带宽);

- 复杂性问题:容灾策略的设计与维护需要跨团队协作(开发、DevOps、SRE),复杂度较高;

- 动态性问题:提示工程资产(如动态提示)的变化频繁,需要实时备份与同步,对系统性能要求较高。

八、总结

提示工程容灾备份策略与应急响应文档是AI项目稳定运行的重要保障。通过数据层的备份策略、链路层的冗余设计、架构层的多活部署,可以有效抵御服务中断、数据丢失等风险;通过专业的应急响应文档,可以确保在故障发生时快速响应,最小化业务影响。

作为架构师,需根据业务场景(如电商、医疗、金融)的不同,调整容灾目标(RTO/RPO)与策略(如多活架构的区域选择、大模型API的服务商选择);同时,需定期进行容灾演练(如模拟提示服务中断、大模型API故障),验证策略的有效性,不断优化应急响应流程。

最后,提醒大家:容灾备份不是“事后补救”,而是“事前预防”。只有在项目初期就将容灾备份纳入架构设计,才能在风险来临时从容应对,确保AI服务的持续稳定运行。

附录:应急响应文档模板下载

点击下载(虚构链接,可替换为实际文件地址)

参考资料

- 《Site Reliability Engineering》(Google SRE团队著作);

- 《Cloud Native Patterns》(云原生架构设计);

- 阿里云OSS文档:https://help.aliyun.com/product/31815.html;

- Kubernetes文档:https://kubernetes.io/zh-cn/docs/。

更多推荐

已为社区贡献38条内容

已为社区贡献38条内容

所有评论(0)